Apple prawie zakończył swoją przygodę z Intelem. W portfolio zostały już tylko 2 komputery

Wielka sprzętowa i programowa unifikacja urządzeń Apple’a postępuje w imponującym tempie. Niemal wszystkie urządzenia, od iPhone’a SE, poprzez iPada Air, po Mac Studio korzystają z tej samej rodziny układów. Przy czym najważniejszy w tym wszystkim jest właśnie iPhone.

Apple już niemal kończy swoją przygodę z Intelem i procesorami o architekturze x86. Ten głośny medialnie rozwód, póki co, zdaje się być niezwykle mądrą strategią. Układy Apple Silicon okazały się wyjątkowo udane, zapewniając wysoką wydajność przy fantastycznej wręcz sprawności. W ofercie pozostaną jeszcze przez pewien czas Mac Mini z x86 i Mac Pro z x86. Ich dni wydają się jednak policzone, szczególnie w kontekście premiery Maca Studio.

Czytaj też:

Wielu uważa, że strategia ta podyktowana jest niemocą Intela w kwestii usprawniania sprawności jego układów. Układy Apple Silicon sprawiają, że pobierające znacznie większą ilość energii układy Intel Core i Intel Xeon by osiągnąć zbliżoną wydajność prezentują się wręcz żałośnie. Inni wspominają, że projektowanie pod jednym dachem układów scalonych i oprogramowania układowego zapewnia Apple’owi unikalne korzyści i możliwość tworzenia jeszcze atrakcyjniejszych produktów.

To prawdziwe, ale też dość powierzchowne obserwacje, które sprzyjają wizerunkowi, jaki Apple budował przez lata.

Naiwną jest wiara, że Apple Silicon na wieki wieków utrzyma swoje atuty nad konkurencją. Historia konsumenckich i korporacyjnych układów scalonych jasno dowodzi, że w tej branży nie ma pewniaków. Jeszcze nie tak dawno temu powszechną była opinia, że choć Intel przegrał rynek układów scalonych dla urządzeń ultramobilnych, tak na rynku PC jest nie do ruszenia. Jego najpoważniejszy rywal, AMD, był już postrzegany jako trup w agonii. Nawet Terry Myerson, ówczesny szef Windowsa, określił tę firmę jako spływającą do ścieku. Po czym pojawiły się układy AMD Ryzen, które okazały się szybsze, sprawniejsze i tańsze od Core’ów - co wpłynęło na ich fantastyczną sprzedaż.

Takich przypadków w historii jest znacznie więcej. Przez lata na rynku konsumenckich procesorów graficznych dominowała firma 3dfx, będąc na niej absolutnie nie do ruszenia. Dziś 3dfx przestał istnieć, bo po kilku latach technologicznej dominacji i spoczywania na laurach dał się podgryźć przez Nvidię. AMD wcześniej też zdołał podgryźć Intela, i to niejednokrotnie.

Naiwną jest również wiara, że współpraca między różnymi pionami w firmie Apple jest w jakiś sposób ściślejsza od współpracy partnerskiej między dostawcami sprzętu i oprogramowania. Microsoft i Intel współpracują na całkiem zbliżonym poziomie co Apple Silicon i pion systemów operacyjnych Apple’a. Windows 11 był projektowany, między innymi, z myślą o układach Intel Alder Lake. A układy Alder Lake były projektowane z myślą o Windows 11. W coraz większej liczbie układów Ryzen znajduje się koprocesor Microsoft Proton, zapewniający dodatkową sprzętową warstwę ochrony.

Apple Silicon to świetne procesory, ale równie dobrze może się okazać, że przyszłe propozycje od Intela, AMD czy jeszcze innej firmy okażą się jeszcze lepsze i że będą na Linuksie bądź Windowsie osiągać lepsze rezultaty niż produkty Apple’a. Mądrość w przejściu komputerów Mac na układy Apple Silicon wynika z zupełnie czego innego. By to zrozumieć, należy przypomnieć sobie jak rynek elektroniki użytkowej ewoluował przez ostatnie dwie dekady.

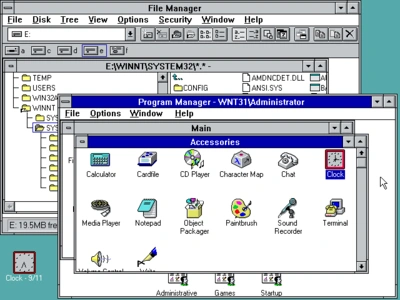

Rok 1990 to początek ery Wintela. Która miała nie skończyć się nigdy.

W pierwszym roku ostatniej dekady XX wieku na rynek trafiło 20 mln komputerów osobistych. Od tego czasu, z zabawnie stałym rytmem, każdego roku ów rynek rósł o około 15 proc. Rok w rok sprzedaż rosła, aż do 2011 roku, kiedy to na rynek trafiło 365 mln pecetów. Niemal wszystkie pracowały pod kontrolą układów Intela i systemu Windows. Mówiło się o duopolu tych dwóch firm i nie bez przyczyny.

Dominacja ta przetrwała nawet koszmar pierwszego Windowsa. System, który dziś nazywamy Windowsem wcześniej nazywał się Windows NT i był rozwijany równolegle, gdy w Microsofcie zdano sobie sprawę, że Windows jest bez przyszłości z uwagi na fatalną jakość jego kodu źródłowego. Przetrwała również pierwsze lata Windowsa XP, gdy się okazało, że ów system jest kompletnie nieprzygotowany na powszechną dostępność Internetu i nowe płynące z niego cyberzagrożenia.

Dominacja ta utrzymywała się częściowo z uwagi na fakt, że konkurencja nie miała nic sensownego do zaoferowania. Nie było oprogramowania biurowego zdolnego do realnego konkurowania z dostępnego głównie na Windowsie pakietu Microsoft Office. Nie było gier wideo na inne PC niż te z MS-DOS, a potem z Windowsem. To jednak nie urządzenia mobilne jako pierwsze wstrząsnęły monopolem Wintela. Zrobił to pewien fiński programista i... rynek serwerów.

W 1991 r. Linus Torvalds opublikował pierwszą wersję systemu Linux.

Microsoft przez długie lata swojej dominacji na rynku PC niemal kompletnie zignorował rynek serwerów. Po części z uwagi na fakt, że nie miał żadnego produktu jakkolwiek nadającego się do ich obsługi. Microsoft Windows był systemem jakości koszmarnej, który nie realizował nawet tak oczywistej sprawy, jak kontrola dostępu do cyfrowych zasobów. To właśnie dlatego w końcu ruszyły prace nad Windowsem NT. By móc klientom korporacyjnym zaoferować jakąkolwiek alternatywę do różnych odmian systemu Unix.

Problemem unixowych systemów był jednak fakt, że były koszmarnie drogie w utrzymaniu i skomplikowane. Linus Torvalds, zainspirowany uproszczoną wersją Unixa stworzoną do celów edukacyjnych (mowa o Minix) zdecydował, że pewną wartością może być jego otwartoźródłowa odmiana, która mogłaby działać nawet na domowym pececie zwykłego kowalskiego. Linux nigdy nie podbił rynku komputerów osobistych. Stanowił jednak niezwykle cenne narzędzie edukacyjne dla całego pokolenia młodych programistów, którzy chcieli uczyć się administrowania i developerki na Unixa.

Systemy oparte o Linuxa nie miały zbyt wiele do zaoferowania zwykłym konsumentom.

Jego otwartość, darmowość i modułowość sprawiły jednak, że nie tylko nie miał on żadnej konkurencji ze strony Microsoftu (i to dosłownie), to na dodatek zaczął trafiać do środowisk korporacyjnych, zastępując wysłużone i kosztowne Unixy. Gdy pojawiły się Windows NT i Windows Server było już za późno, by powstrzymać tę eksplozję popularności. Microsoft próbował nawet pozwać firmy zajmujące się rozwojem i administracją Linuxa za rzekomą kradzież patentów, ale i ta strategia nie odniosła sukcesu. Windows utrzymywał swoją dominację w środowiskach domowych i biurowych. Wszędzie indziej programiści i administratorzy preferowali systemy unixowe. Głównie Linuxa, ale też i BSD czy inne unixopodobne rozwiązania.

Elastyczność Linuxa i jego bratnich systemów, w połączeniu z popularnością w relatywnie niszowym środowisku entuzjastów sprawiły, że stawał się on niemal domyślnym oprogramowaniem dla każdego urządzenia elektroniki użytkowej, które nie jest komputerem osobistym. Gdzie nie było Wintela, tam najczęściej było coś unixopodobnego. W tym w pierwszych iPodach, które bazowały na energooszczędnych układach ARM i systemie BSD i które odniosły gigantyczny sukces rynkowy. A później w iPhone’ach, których popularność na rynku stała się bezprecedensowa.

Rok 2008. Apple wprowadza na rynek iPoda z funkcją dzwonienia. To iPhone, z bazującym na BSD systemie iPhoneOS.

iPhone był urządzeniem nie tylko bardzo modnym, ale też bardzo udanym i znakomicie przemyślanym. Entuzjaści elektroniki co prawda przez długi czas krytykowali je za wiele braków i mieli w swojej krytyce sporo racji. Ta jednak była bez większego znaczenia. iPhone urzekał prostotą obsługi, urodą i integracją z niezwykle popularnym iTunesem, który był wcześniej fundamentem sukcesu iPoda. Dziesiątki milionów telefonów Apple’a trafiały do kolejnych klientów. A to nie jedyna rewolucja na rynku IT.

Na rynku korporacyjnym również zaczynała się wielka rewolucja. Amazon zdecydował się zbudować pierwszą wielką chmurę publiczną, czyli Amazon Web Services. Jej fundamentem były, a jakże, rozwiązania otwartoźródłowe, głównie Linux. Odpowiedź na AWS, czyli microsoftowy Windows Azure, słówko Windows używała głównie do celów marketingowych. Pierwotnie chmura Microsoftu, tak jak chmura Amazonu, zarządzana była przez systemy linuxowe.

Rynek nie znosi próżni, więc i iPhone doczekał się rywala. Google stworzył system operacyjny Android na bazie Linuxa i zaoferował go firmom chcącym konkurować z Apple’em na rynku telefonów komórkowych. O dominacji Wintela mowy być nie mogło.

Intel przespał rewolucję iPhone’a i nie miał żadnego układu w ofercie, jaki dałoby się wykorzystać w energooszczędnych, ultramobilnych urządzeniach. Utrzymał jednak dominację jako dostawca procesorów do serwerów i PC. Microsoft nie odniósł aż takiej porażki co Intel w ramach swojej działki, ale trudno mówić o spektakularnym sukcesie - Windows Server cieszył się dużym wzięciem, ale rozwiązania linuxopodobne wygrywały. Windows dominował tylko na PC. A więc na urządzeniu, które stawało się coraz mniej i mniej potrzebne.

Wiele osób dość mylnie intepretuje pojęcie era post-PC za rzekome odejście komputerów osobistych do lamusa. To wierutna bzdura i PC nigdy nie przestały być ważne, są nadal podstawowym narzędziem pracy. Jednak od czasu iPhone’a PC niemal całkowicie stracił swój walor rozrywkowy, nie licząc gier wideo. Surfowanie po Internecie, czytanie porannej prasy, rozmowy na Gadu-Gadu, Facebooku i portalach randkowych, oglądanie śmiesznych kotków w animowanych GIF-ach - kiedyś do tego celu uruchamiało si komputer osobisty. Od czasu iPhone’a wcale a wcale. iPhone’a z układem ARM (bo Intel nie miał stosownych układów) i systemem unixopodobnym (bo społeczność programistów uczyła się fachu na Linuksie).

Apple Mac to (był) taki sam PC, jak Dell z Windowsem. A przecież to bez sensu.

Nie dający się z niczym porównać sukces iPhone’a nie dotyczył komputerów Mac. W czasach dominacji wintela te były na marginesie. Coś drgnęło w momencie, gdy do firmy Apple wrócił Steve Jobs i te zaczęły znów cieszyć się stale rosnącym zainteresowaniem. Trudno je jednak porównywać z sukcesem iPhone’a. Telefon (czy raczej, jak to kiedyś określano, smartfon) Apple’a w takim samym stopniu negował potrzebę posiadania PC z Windowsem, co PC z systemem Apple OS X. Wszystko, co najciekawsze, działo się na iPhoneOS (później iOS).

Nie ma sensu porównywać liczby gier i aplikacji budowanych na iPhone’a z tymi budowanymi na Maca (i PC z Windows). To dwa różne światy, gdzie iPhone to platforma do zarabiania gigantycznych pieniędzy na grach i aplikacjach, a Mac to nisza. Tym niemniej nikt nie rozumiał ery post-PC tak dobrze, jak jej inicjator - a więc Apple. Komputery osobiste były, są i będą niezbędne do poważniejszej pracy. Pozbywanie się ich nie ma najmniejszego sensu, nawet jeśli w ujęciu przychodów stanowią ułamek tego, co zapewnia iPhone i powiązane bezpośrednio z nim produkty i usługi.

Komputery Apple Mac wykorzystywały układy x86 i bazujący na BSD system OS X. Telefony Apple iPhone wykorzystywały układy ARM i bazujący na BSD system iOS. Wysokopoziomowo, z punktu widzenia podstaw programowania, to za sprawą unixowości bardzo zbliżone urządzenia, różniące się od siebie tylko sposobem interakcji użytkownika z oprogramowaniem. Niskopoziomowo to dwa różne światy.

Apple przez lata zmuszony był rozwijać dwa zupełnie różne projekty informatyczne. Kompilatory, środowiska programistyczne czy systemy operacyjne przeznaczone na układy scalone o zupełnie innej charakterystyce. To... nieekonomiczne. Z perspektywy czasu wręcz można się dziwić czemu Apple tak długo czekał z pozbyciem się układów x86 z komputerów Mac. Wiarygodną wydaje się teoria, że wcześniej nie miał wyjścia.

Pewnym mitem jest rzekoma wyższość architektury ARM nad x86. Obie mają swoje unikalne atuty i obie, przynajmniej teoretycznie, mogą mieć przed sobą świetlaną przyszłość. Długoletnie przywiązanie Apple’a do pecetowych układów Intela prawdopodobnie wynikało z faktu, że przez te długie lata ani sam Apple, ani żaden zewnętrzny partner, nie były w stanie zaprojektować układu ARM nadającego się do użytku w urządzeniu klasy PC. Teorię tę uwiarygadniają wysiłki konkurencji. Apple nie jest jedynym, ani nawet pierwszym mainstreamowym producentem PC z ARM. Uprzedził go Microsoft, a laptopy z układami ARM i Windowsem 10 zostały wprowadzone do sprzedaży znacznie szybciej niż zrobił to Apple. Tyle że obecne w nich układy Snapdragon oferowały szybkość przetwarzania danych na poziomie naćpanej dżdżownicy pełzającej pod górę. I niewiele się od tego czasu zmieniło.

Apple Silicon M nie są superszybkie i supersprawne z uwagi na wybraną architekturę, a z uwagi na fakt, że są to świetnie zaprojektowane układy, co wynika z inwestowania przez lata ogromnych zasobów finansowych w rozwój i badania nad układami scalonymi. Nie tylko na potrzeby komputerów Mac, ale też (a może i przede wszystkim) na potrzeby iPhone’ów i iPadów. Energooszczędnych urządzeń, od których oczekuje się błyskawicznego przetwarzania danych z sieci komórkowej czy obróbki w czasie rzeczywistym wideo w Ultra HD z wbudowanego weń aparatu fotograficznego.

Przejście komputerów Mac na Apple Silicon to zatem przede wszystkim pragmatyzm.

Znika bowiem potrzeba tworzenia dwóch zupełnie odmiennych rozwiązań niskopoziomowych na wszystkich szczeblach. Kompilatory kodu programistycznego nie będą już musiały być optymalizowane pod dwie zupełnie inne architektury układów do przetwarzania danych. Kernele systemów operacyjnych nie będą już musiały być projektowane na zupełnie inny sposób. Inżynieria oprogramowania staje się dużo łatwiejsza, w tym kolejkowanie zadań systemu operacyjnego, przechodzenie przez różne stany energetyczne i tak dalej.

Ujednolicenie oferty to również znaczne uproszczenie logistyczne. W dopuszczalnym zaokrągleniu każdego miesiąca produkowanych jest 25 mln układów Apple SIlicon dla urządzeń iPhone i iPad. Dużo efektywniej jest zlecić podwykonawcy budowę kolejnych 500 tys. w podobnym procesie technologicznym niż takie wymagające całkowitej jego zmiany. To czy podwykonawcą jest TSMC (Apple Silicon) czy Intel (Intel Core) też ma znaczenie, choć dużo mniejsze.

Czy Qualcomm, Intel, AMD bądź jeszcze kto inny wprowadzi na rynek układ, który zawstydzi Apple Silicon? O to na razie należy pytać wróżów, ale jest to wysoce prawdopodobne. Ma to jednak znaczenie drugorzędne. Przejście na ARM i Apple Silicon to jednak jedna z najlepszych rzeczy, jakie mogły się przytrafić linii komputerów Mac. Choć nie tyle z uwagi na korzyści dla ich użytkowników, a raczej - wręcz przede wszystkim - dla samego Apple’a i twórców oprogramowania na jego sprzęt. To czysty pragmatyzm, w najlepszym możliwym wydaniu.