Dlaczego granie na PC to rosnące problemy? I dlaczego wzorem gier na PC są te od PlayStation? Wzywam ku normalności

Na rynku gier PC trwa technologiczny kryzys, na czym cierpią gracze. Bałagan ze standardami, agresywne zabezpieczenia DRM i wysokie ceny podzespołów działają wyraźnie demotywująco na znaczą część studiów deweloperskich. Tym bardziej należy wyróżnić wydawnictwo, które jeszcze nie tak dawno temu od świata gier na PC w zasadzie się odcinało.

PC zawsze były najdroższą i najmniej przyjazną platformą do grania. Starsi czytelnicy Spider’s Web prawdopodobnie mają inne skojarzenia, to jednak może wynikać ze specyfiki polskiego rynku. W Polsce prawo bardzo długo nie regulowało spraw związanych z licencją na oprogramowanie. Sporo czasu też minęło, zanim Polacy zrozumieli istotę tego prawa, zamiast je omijać - a więc że płacenie twórcom za ich pracę leży w długoterminowym interesie konsumenckim.

Czytaj też:

Długo więc uznawano, że inwestycja w gry komputerowe kończy się na sprzęcie. Same gry kopiowało się od znajomych lub kupowało za bezcen od piratów na bazarach. Polaków nie za bardzo interesowały konsole Nintendo i Segi, bo piractwo na nich było zbyt trudne, a gry zbyt drogie. PC miał darmowe gry i choć sam był istotnie droższy od konsoli - tak oferował znacznie lepszą grafikę. Zwłaszcza od generacji procesorów 386 i 486, które studio id Software ostatecznie ujarzmiło, replikując nie tylko płynną grafikę 2D z konsol, jak i generując na nich nieosiągalną dla konsol w tej płynności i jakości grafikę 3D.

Na tak zwanym zachodzie, gdzie piractwo nie było zjawiskiem mainstreamowym, sytuacja od zawsze wyglądała zgoła odmiennie. Konsole do gier to sprzęt dla większości typowych graczy. Znacznie droższy PC w konfiguracji pod gry 3D zapewniał doświadczenie premium. Hiperrealistyczną (w porównaniu do konsol) grafikę 3D oraz bardziej ambitne gry, jak strategie czy symulatory lotu, do których proste gamepady nie wystarczały.

Takie staus quo utrzymywało się bez większych zakłóceń do trzeciej generacji PlayStation i drugiej Xboxa. Same konsole tanie już nie były (choć i tak tańsze od gamingowego PC), ale oferowały technologie i doświadczenia wówczas trudne do odtworzenia na PC. Podział rynku przestał być już taki oczywisty. A jak jest dziś?

Supernowoczesne i drogie PC kontra tanie konsole do gier.

Akurat w tym konkretnym momencie znajdujemy się w dziwnych czasach, tuż po globalnej pandemii i w trakcie koszmarnej wojny w Ukrainie, na dodatek przy bezprecedensowym popycie na elektronikę. Ceny konsol do gier i sprzętu do grania są sztucznie zawyżone, a dostępność tych towarów bywa ograniczona. Jednak nawet dziś cena mainstreamowej konsoli do gier (Xbox Series S) to niespełna 1400 zł.

Tymczasem w rekomendowanej cenie Xboxa Series S nie da się kupić nawet samej porządnej karty graficznej do gamingowego PC i wcale nie mówię tu o najnowszych modelach kart grafiki. Taki, dajmy na to, GeForce RTX 2060 Super sprzed dwóch generacji, kosztuje z kolei dziś nieznacznie mniej, co całe konsole Sony i Microsoftu z półki premium w postaci PS5 i Xbox Series X (czyli ok. 2300 zł), chociaż komputer z tą kartą na pokładzie zapewnia co najwyżej podobną wydajność w kwestii rasteryzacji grafiki 3D.

Tyle że sprzęt PC do grania to nie tylko karta grafiki. To również procesor, RAM, pamięć masowa, płyta główna, zasilanie. PC w kwestii zakupu sprzętu wychodzi znacznie drożej. W teorii jest jednak dużo bardziej zaawansowany.

Wyżej wspomniano kartę GeForce RTX 2000. Tymczasem świat PC jest już na etapie kart RTX 4000. W kwestii wydajności graficznej, PC z zaprezentowanymi właśnie kartami Nvidii to odpowiednik, na oko, PlayStation 7. Oczywiście z dużym przymrużeniem oka i z mocnym uproszczeniem. Jest to jednak technologia znacząco przewyższająca cokolwiek, co konsole są w stanie zaoferować. PC brutalną siłą swojej mocy obliczeniowej powinny rozprawiać się z nawet najbardziej zaawansowaną grą. Tymczasem... bywa z tym bardzo różnie.

Nie brakuje gier, które na niekoniecznie najnowocześniejszym sprzęcie rozwijają skrzydła, zapewniając zabawę w ponad 100 Hz przy wysokiej rozdzielczości i braku jakichkolwiek problemów. Z drugiej jednak strony przybywa tytułów, w tym wysokobudżetowych od znanych wydawnictw, które działają źle nawet na najlepszym sprzęcie. Które się tną i wieszają nawet na Core i9 12. generacji z RTX 3080. Przyczyn tego kryzysu jest kilka.

Wydawcy gier na PC nadal boją się piractwa. Gra zamiast przeliczać piksele, traktuje gracza jak potencjalnego złodzieja.

PC z Windows to otwarte systemy informatyczne. To oznacza, że użytkownik ma dostęp do wszystkich plików, jakie są ładowane do pamięci komputera. A więc również do folderu z grą czy jej nośnika instalacyjnego. To nie jest możliwe na konsolach. Taki dostęp znacząco ułatwia skopiowanie gry i w efekcie piractwa. Sposobów na walkę z piratami jest kilka.

Niektórzy wydawcy gier, jak chociażby nasz rodzimy CD Projekt, liczą na dobrą wolę swoich klientów. Że ci, zadowoleni z wydawanych gier, sami będą chętnie płacić za kolejne wirtualne przygody. Patrząc po wpływach finansowych z Wiedźmina czy Cyberpunka 2077, to podejście wydaje się sprawdzać. Choć zapewne nie w każdym przypadku.

Inni wiążą swoje gry z usługami online. Projektują gry od początku pomyślane o zabawie w trybie multiplayer, lub też w jakiś inny sposób tworzą konieczność łączenia się z serwerem wydawnictwa. Gry online w zasadzie spiracić się nie da. Nie bez stawiania pirackich serwerów, co kosztuje pieniądze. Lub nie bez hackowania zabezpieczeń serwera wydawnictwa, co nawet jak będzie skuteczne, to lada moment może być wyłapane i udaremnione. To zabezpieczenie nie zadziała jednak w przypadku gier offline dla pojedynczego gracza.

Inni wreszcie stosują rozbudowane zabezpieczenia DRM, w wymyślny sposób pilnujące, by gra nie była uruchamiana bez licencji. Niestety, zabezpieczenia te działają niskopoziomowo i bardzo często wpływają na efektywność komunikacji gry ze sprzętem. Efekty bywają opłakane, jak w Resident Evil: Village. Hitowej grze, która z uwagi na agresywnie działające DRM działa niepłynnie nawet na najdroższych PC.

Unreal Engine otworzył wrota dla wielu nowych twórców gier. Być może zbyt wielu.

Czasy, gdy dla każdej gry budowana była wyspecjalizowana specjalnie dla niej technologia, odeszły już bezpowrotnie do przeszłości. Nie licząc prostych gier indie, budowa od zera atrakcyjnej dla nowoczesnego gracza gry 3D to projekt na wiele milionów złotych. Dlatego też ogromnym i nieustannie rosnącym powodzeniem cieszą się wynajmowane od innych studiów deweloperskich silniki gier. Czyli techniczne fundamenty gry, załatwiające znaczną część pracy deweloperskiej, jak chociażby metoda generowania grafiki.

Na rynku zaczyna dominować Unreal Engine od Epic Games. Studia deweloperskie Xboxa już niemal w całości przerzuciły się na tę technologię, utrzymując w zasadzie ze swoich już tylko ForzaTech (Forza) i Slipspace (Halo). Unreal Engine będzie też narzędziem deweloperskim polskiego studia CD Projekt Red. Z żalem warto pożegnać Red Engine z Cyberpunka, który od samego początku na PC wyglądał obłędnie.

Popularność Unreal Engine nie dziwi. Z jednej strony to jeden z najbardziej technologicznie zaawansowanych engine’ów na rynku, pozwalający nawet niedoświadczonemu studiu deweloperskiemu na stworzenie gry wizualnie przepięknej i nowoczesnej. Z drugiej ma niezwykle przyjazny model biznesowy, bardzo otwarty dla początkujących, a zarazem pozwalający Epic Games na zarobienie dużych pieniędzy na potencjalnych hitach zbudowanych na tym silniku. Jest jednak jeden problem. Odczuwają go, z uwagi na popularność Unreal Engine, niemal wszyscy gracze PC. Choć nie każdy ów problem potrafi nazwać.

Ten problem to shader compilation i występuje też w drugim co do popularności silniku Unity. Dokładne jego opisanie wymagałoby osobnego rozbudowanego artykułu, ale w pewnym uproszczeniu spróbujmy. Unreal Engine, w połączeniu z nowoczesnymi API graficznymi jak DirectX 12 czy Vulkan, bardzo nie lubi jakichkolwiek zmiennych czynników w architekturze urządzenia do grania.

Pewna część efektów graficznych w Unreal Engine wymaga wstępnego przekalkulowania na konkretnym systemie informatycznym (system operacyjny i sterowniki + sprzęt). W przypadku konsol do gier nie jest to najmniejszym problemem: każda konsola danej generacji jest identyczna. Nie ma dwóch różnych konsol PlayStation 5, z różnymi procesorami czy układami graficznymi. To oznacza, że twórca gry może zapewnić gotowe wyniki tych przeliczeń razem z grą. Na PC, gdzie nawet aktualizacja sterownika karty graficznej definiuje cały system na nowo, nie jest to możliwe.

Gry więc dokonują tych przeliczeń w locie, podczas zabawy. Jest to przy tym przeliczenie, którego trzeba dokonać raz (aż do wymiany podzespołu w PC lub aktualizacji sterownika), przez co dochodzi do kuriozalnej sytuacji, w którym dany poziom gry za pierwszym razem tnie się niemiłosiernie, a już przy drugim podejściu działa jak złoto. I to niezależnie od sprzętu, kompilacje niektórych shaderów są wyzwaniem nawet dla komputerów z najnowszymi i drogimi podzespołami. Gry mają szarpaną animację, niemal niezależnie od mocy obliczeniowej sprzętu gracza.

A tak w ogóle, to wszystko jest winą tych głupich producentów telewizorów.

Rynek telewizyjny dość szybko przeskoczył ze standardu Full HD (1080p) do standardu Ultra HD (4K). Popularyzację nowej generacji telewizorów prawdopodobnie ułatwił fakt, że produkcja chipsetów zdolnych do przetwarzania sygnału wideo w tej rozdzielczości nie okazała się szczególnie droższa. Niezależnie od powyższego, 4K na dziś jest już standardem. A Full HD kojarzone jest z niską półką cenową i doświadczeniami gorszej jakości, choć nadal wielu graczy używa takich monitorów.

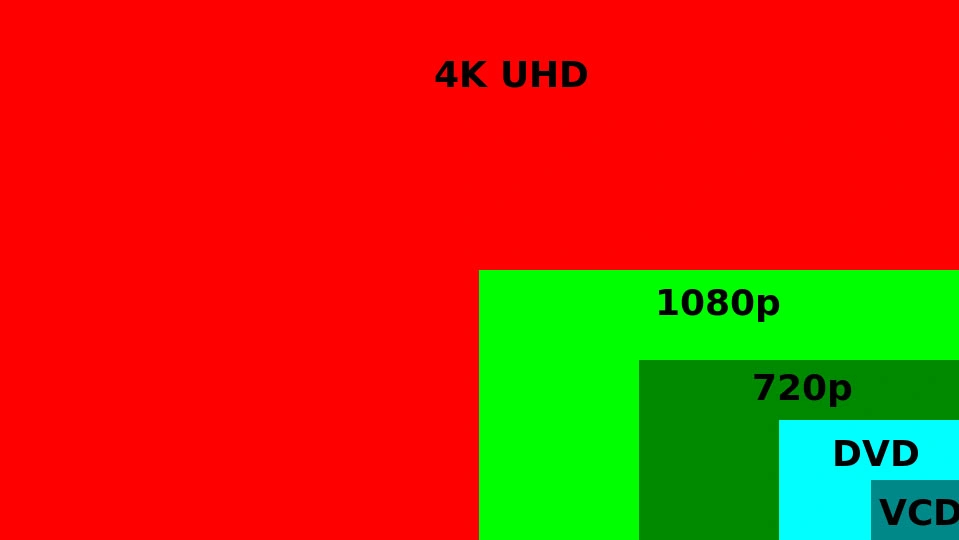

W przypadku rasteryzacji grafiki 3D, sytuacja ma się zupełnie inaczej. Procesor graficzny musi wygenerować na wyświetlaczu komputera scenę składającą się z niemal 8,3 mln pikseli (4K), zamiast, jak do tej pory, nieco ponad 2 mln pikseli (1080p). To ogromny skok, największy do tej pory. Zresztą, każdy przyszły będzie jeszcze większy, a każdy przeszły był mniejszym skokiem. Wynika to z prostych prawideł geometrii i proporcji. Dla przypomnienia:

- 720p (HD) to 0,92 mln pikseli

- 480p (SVGA) to 0,3 mln pikseli

Oznacza to więc, że znacząco zwiększyło się zapotrzebowanie na moc obliczeniową, a ta jest kierowana przede wszystkim na proces rasteryzacji pikseli - zamiast na inne, potencjalnie ciekawsze dla tego co się dzieje na ekranie zadania. Presja na generowanie wysokiej rozdzielczości jest jednak wysoka i mimo wszystko zrozumiała.

Konsole do gier obchodzą ten problem niespecjalnie się nim przejmując. Co prawda ich producenci często i głośno krzyczą o 4K, czasem nawet zdarza im się coś bąknąć i o 8K - ale w rzeczywistości mało która gra dobija do standardu Ultra HD. Twórcy gier na konsole stosują rozmaite algorytmy rekonstrukcji obrazu z niższej do wyższej rozdzielczości. Innymi słowy, gra jest renderowana ze znacznie mniejszą liczbą pikseli, po czym jakiś algorytm wypełnia brakujące dane, symulując dokładność 4K. Tego rodzaju sztuczki są na konsolach dużo łatwiejsze niż na PC - ponownie, za sprawą przewidywalności konsol. PC mają jednak coś w teorii lepszego.

Wszyscy trzej wiodący dostawcy kart graficznych na PC opracowali własne technologie rekonstrukcji obrazu, dopasowane do specyfiki otwartej architektury tych maszyn. Są to rozwiązania wykorzystujące zaawansowaną sztuczną inteligencję i za ich sprawą możliwe jest renderowanie gry w, dajmy na to, 1080p lub 1440p przy bardzo nieznacznym spadku jakości obrazu w porównaniu do rozdzielczości 4K. W zamian za kilkumilisekundowe opóźnienie w sterowaniu (input lag) zwalniana jest moc obliczeniowa karty graficznej. Gracze w teorii powinni więc cieszyć się znacznie piękniejszą grafiką. Ale i tu pojawia się pewien problem.

- Producent kart Intel Arc zapewnia mechanizm XeSS. Działa on najwydajniej na układach Arc, znacznie gorzej na układach konkurencji. Jest oceniany jako mniej sprawny od DLSS, choć sprawniejszy od FSR (na kartach Arc).

- Producent kart AMD Radeon zapewnia mechanizm FSR. Działa on na wszystkich układach graficznych. Jest dobrze oceniany, ale najniżej z trzech rozwiązań.

- Producent kart Nvidia GeForce zapewnia mechanizm DLSS. Działa on wyłącznie na układach GeForce RTX, a DLSS 3.x wyłącznie na układach GeForce RTX 4000. Jest uważany za najlepszy i najbardziej zaawansowany.

Twórca gry na PC ma więc różne technologie do wyboru. Nie ma jednego najlepszego, na każdym cierpi jakaś grupa graczy. Implementacja każdego to dodatkowe koszty. Często więc podejmowane są decyzje o skupieniu się na jednej z technologii. Niejednokrotnie pomaga w tym umowa partnerska z jednym z producentem kart graficznych. Nie brakuje w efekcie gier obsługujących tylko DLSS. Albo tylko FSR. Jedni gracze mają przyjemną zabawę, inni muszą kombinować.

Tworzenie gier na PC stało się dziwne i trudne, nie ulega to żadnej wątpliwości. Pod koniec dnia trudno jednak uznać sytuację za normalną, gdy legalnie nabywa i droga gra działa źle nawet na bardzo dobrym sprzęcie i nikogo to właściwie już nie dziwi. Nie w kontekście wielomilionowych zysków gamingowych wydawnictw, które w tym układzie trudno uznać za poszkodowane.

Czy nie da się inaczej? Ależ da. Tylko trochę słabo, że za wzór gier na PC należy stawiać porty z PlayStation.

Osoba postronna, która z PC gamingiem ma kontakt sporadyczny, po lekturze tego tekstu mogłaby dojść do wniosku, że na PC dzieje się jakaś katastrofa i w ogóle nie można się na tej platformie bawić. To oczywiście nieprawda, bo i nie brakuje gier bardzo dobrze dopasowanych. Jest w tym jednak pewna ironia losu, że najwięcej uwagi jakości gier na PC poświęcają studia należące do PlayStation. A więc wydawnictwa, które jeszcze niedawno z rynkiem PC nie miało niemal nic wspólnego.

Dla przykładu, pierwotnie napisana na konsole PlayStation gra Marvel’s Spider-Man, która na Steam (PC) trafiła w połowie bieżącego roku. Już na premierę gra była w świetnym stanie i żaden z zarzutów postawionych powyżej jej nie dotyczył. Gra od początku obsługiwała zarówno DLSS 2.x, jak i FSR.

Teraz na rynku debiutują karty graficzne Intela, a do pobrania jest już aktualizacja Spider-Mana z dodanym XeSS. Kto ma jaki sprzęt? Nieważne, bo o wszystkich trzeba zadbać. Gracze z monitorami 32:9 i 21:9? Wyszła stosowna łatka. Zapowiedziana jest też obsługa DLSS 3.0. Na dodatek wymagania sprzętowe gry cały czas są zmniejszane. Dla przykładu, ostatnia aktualizacja znacząco ograniczyła zużycie VRAM.

Spider-Man nie jest tu jedynym takim przypadkiem. Poprzedni hit z konsol PlayStaton, God of War, który trafił na początku bieżącego roku na Steama, również zadebiutował w znakomitej formie. Gra wygląda zauważalnie lepiej niż na konsolach, działa lepiej, jest dobrze zoptymalizowana pod szereg podzespołów i również doczekała się porządnej opieki po premierze. Jak tylko AMD wydało przełomową wersję 2.0 swojego rozwiązania FSR, jego obsługa niemal niezwłocznie została dodana do gry.

Może problemem jest zbyt niski próg wejścia do branży gier wideo - Unreal Engine dla małych twórców jest za darmo, więc ci nie zgłębiają technik programistycznych, skupiając się na warstwie koncepcyjnej i artystycznej gry. A może owym problemem jest wysoki próg wejścia dla poważnych gier, gdzie samo tworzenie treści to wydatek wielu milionów złotych.

Jest to jednak z punktu widzenia graczy nieistotne.

Bo skoro nawet PlayStation, które jest bardziej zainteresowane promowaniem konsol PlayStation 5 niż swoich gier na PC, jest w stanie na rynku PC zadebiutować z produktem dobrej jakości, to oznacza to, że jednak to nie platforma PC jest problemem. Jest co najwyżej, jeśli już, większym wyzwaniem dla programistów.

Tym prawdziwym problemem są niekompetentne studia lub, co prawdopodobnie dużo częstsze, nierealne deadline’y wyznaczone przez nadzorujące ich pracę wydawnictwa. Siłą rzeczy więc tymże problemem jest przedkładanie przez wydawnictwa optymalizacji zysków nad zapewnieniem płacącym klientom produktu wysokiej jakości.

Podzielenie losu Atari wielkim wydawcom gier nie grozi. Na ich szczęście w morzu bylejakości pecetowi gracze mogą znaleźć wiele perełek. No i są jeszcze konsole. Warto jednak rozważyć przemyślenie pewnych nawyków zakupowych związanych z grami na PC. Zamiast rezerwować grę w przedsprzedaży, lepiej poczekać na recenzje w mediach i opinie samych graczy. Sprawdzać dokładnie, czy to świetna gra na PC - czy też świetna, ale tylko na konsolach, bo na PC jej jakość jest trudna do przyjęcia. I omijać takie tytuły szerokim łukiem.

Nic tak dobrze nie dyscyplinuje producenta dóbr jak brak popytu na owe dobra. Gry z PlayStation lepsze technicznie niż na PlayStation 5 - a przede wszystkim lepsze technicznie niż znaczna część innych gier na PC - powinny wielu osobom otworzyć na to oczy.