Jak wypadł nowy Gemini na iPhone’y? Zrobiłem sprawdzian sztucznej inteligencji

Google gra na nosie Tima Cooka i udostępnił SI gadające po polsku na iPhone’ach przed premierą Apple Intelligence w naszym kraju. Sprawdziłem, jak działa nowa apka Gemini w praktyce.

Sztuczna inteligencja to słowo-wytrych, którego używają teraz wszystkie tuzy świata nowych technologii. Każdy nowy sprzęt albo usługa muszą wykorzystywać w jakiś sposób AI. Do tego wyścigu dołączył również Apple, który jak na razie przygotował Apple Intelligence wyłącznie na amerykański rynek (dopiero od kwietnia usługa będzie dostępna na iPhone’ach i iPadach w naszym kraju).

Problem w tym, dla Apple’a, iż firma nie istnieje w próżni i powstali już asystenci głosowi wykorzystujący generatywne SI i modele językowe, które komunikują się w naszym języku i możemy z nich korzystać. Jednym z nich jest Gemini od Google’a, który dostał właśnie swoją aplikację na iOS. Można już pobierać nową apkę z App Store’a.

Czytaj inne nasze teksty poświęcone AI:

AI na iPhone’y - jaki jest Gemini od Google’a?

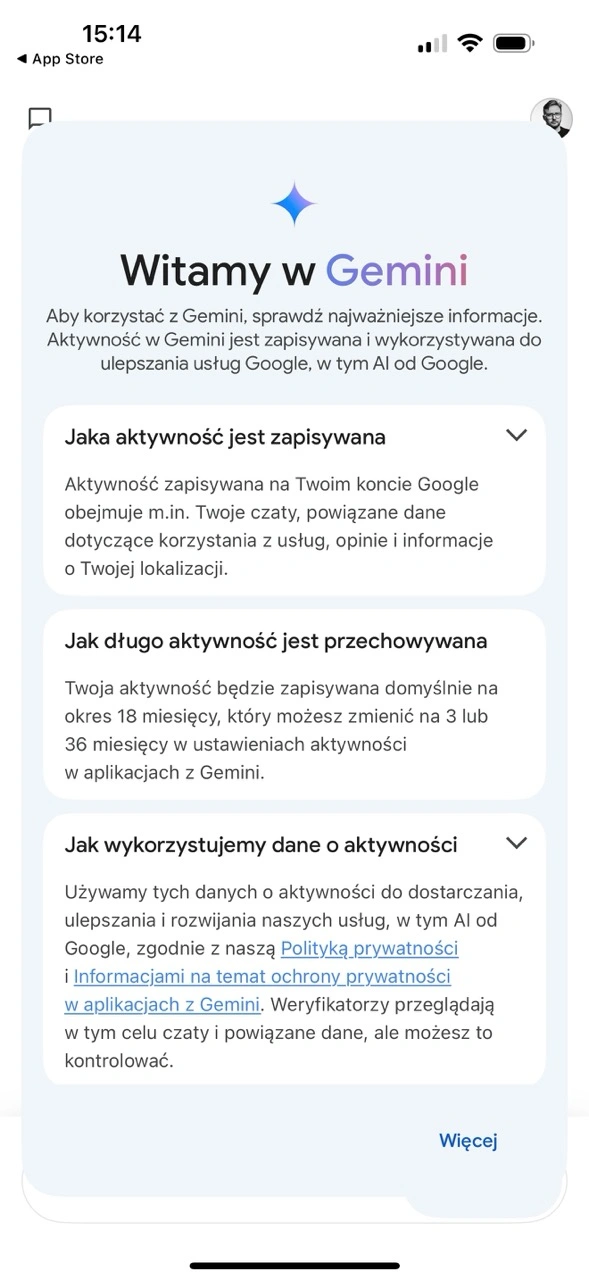

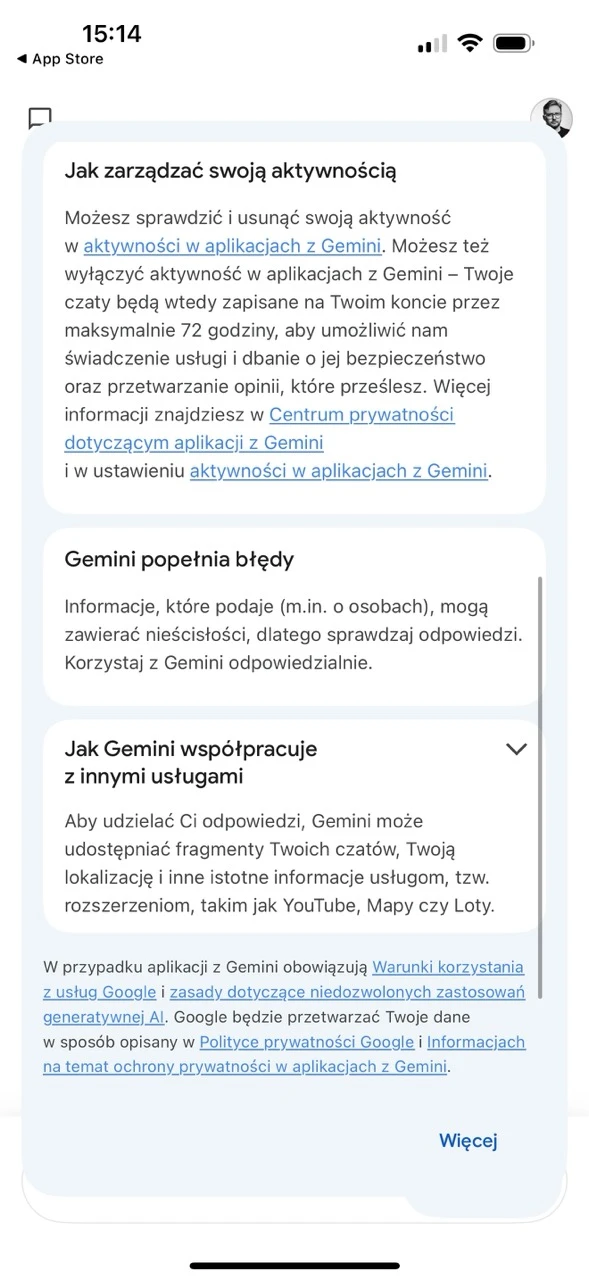

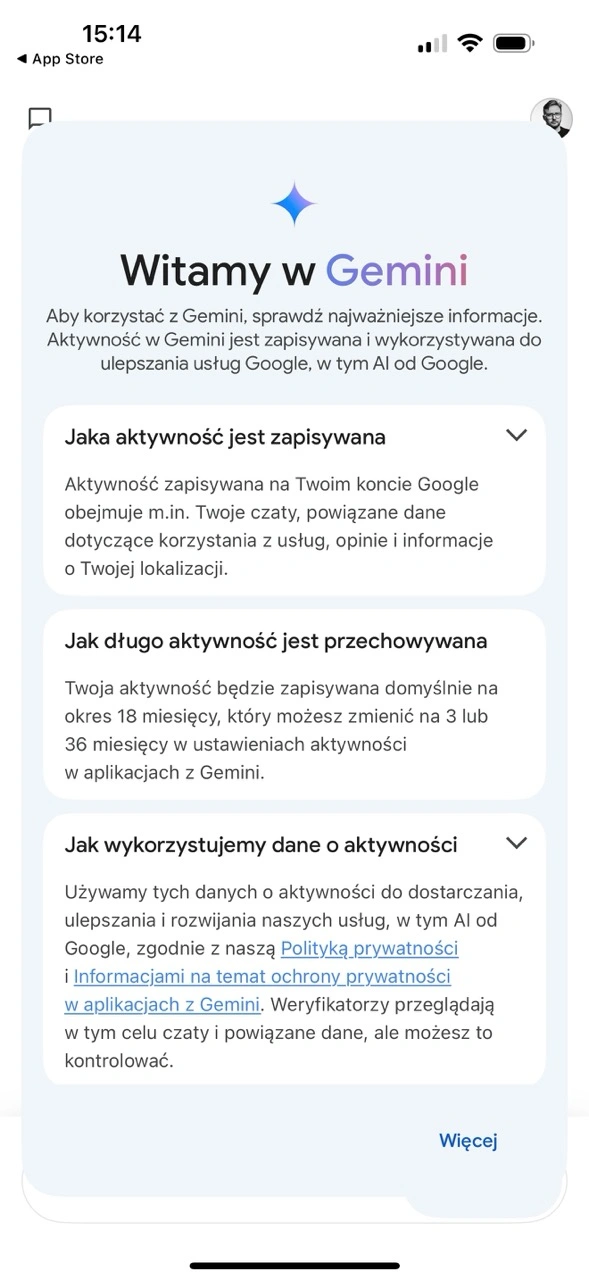

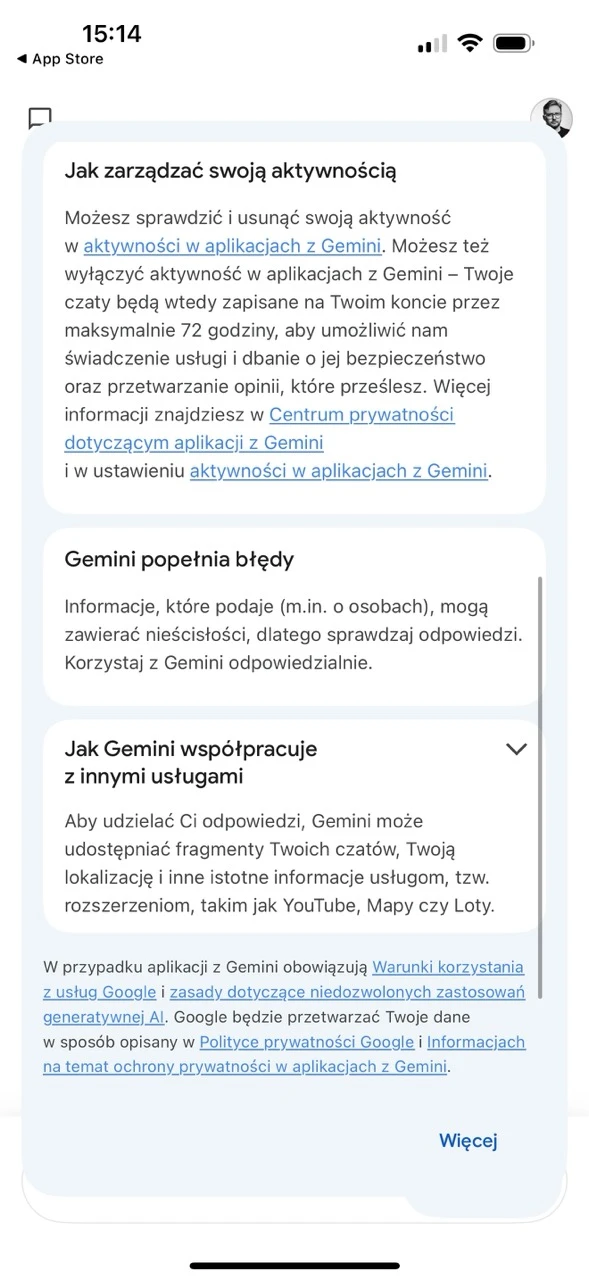

Nowa apka jest prosta, ładna i przyjemnie się z niej korzysta. To typowy chatbot, który uruchamia się po zalogowaniu na nasze prywatne konto Google (służbowe są nieobsługiwane). Na start dostajemy monity informujące o tym, że chaty będą przechowywane na serwerach przez 18 miesięcy (da się ten okres zmienić), a do tego weryfikatorzy mogą mieć do nich dostęp (co można wyłączyć).

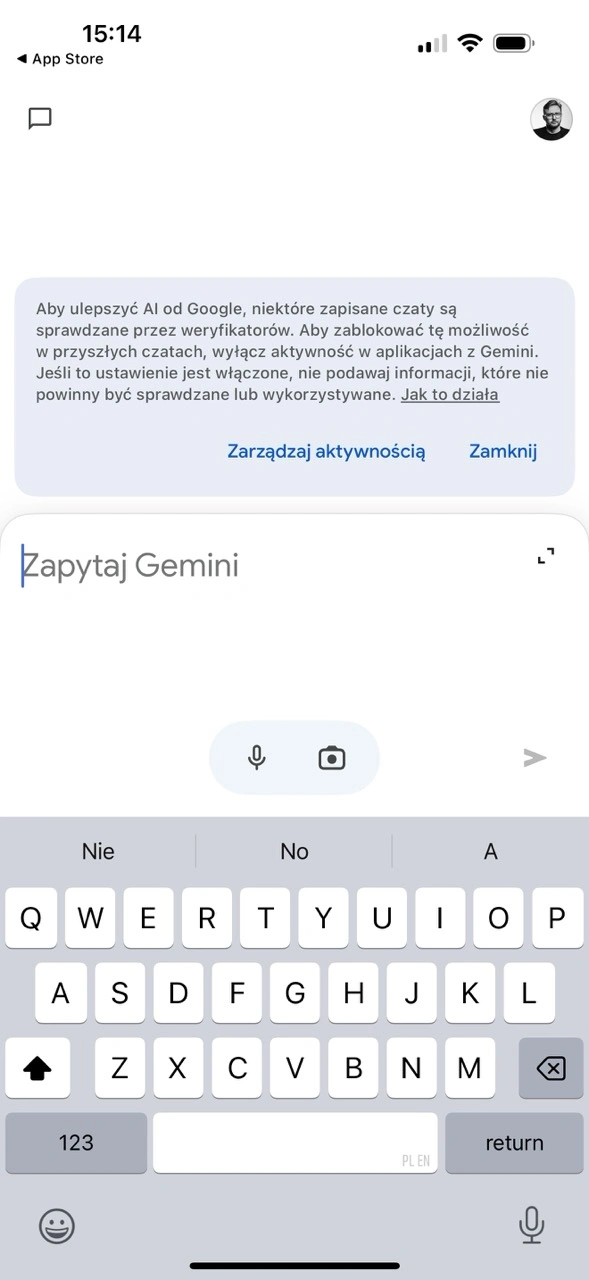

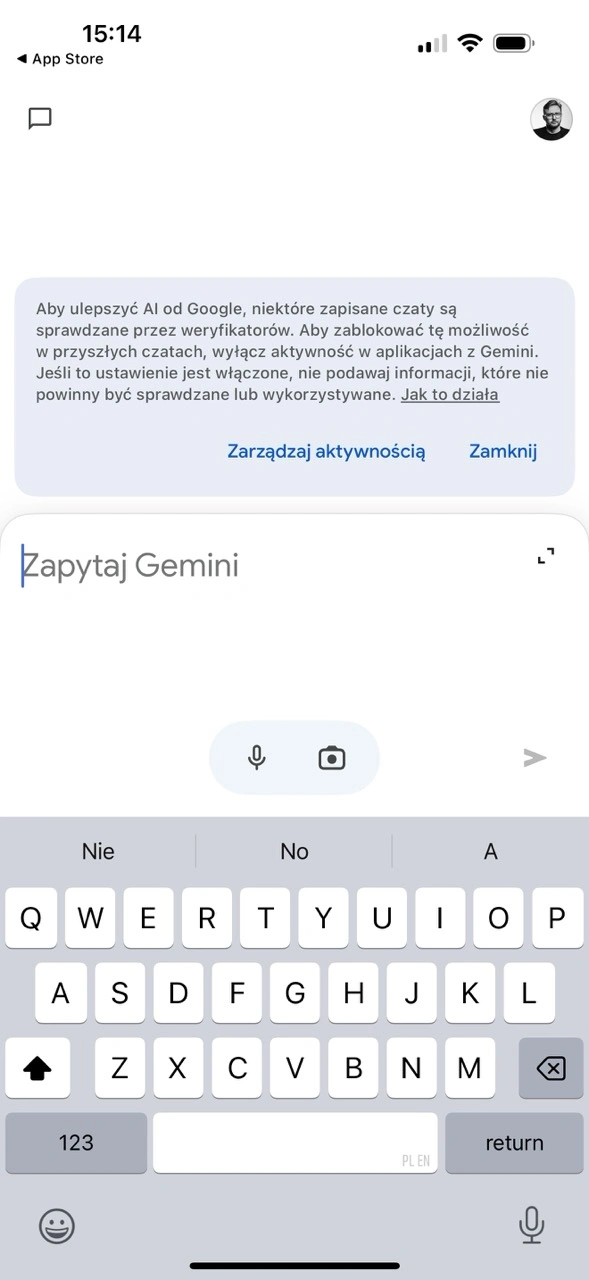

Jeśli nie klikniemy od razu „przejdź dalej”, to możemy doscrollować się też do ostrzeżenia, iż Gemini może podawać nieprawdziwe informacje, czyli halucynować - to zresztą standard u asystentów opartych o Duże Modele Językowe (ang. Large Language Models, w skrócie LLM). Jak już potwierdzimy, iż zgadzamy się na warunki, możemy rozpocząć pogawędkę z serwerem. Interfejs jest dość… ascetyczny.

Na dole mamy pole wprowadzania tekstu z przyciskami do dyktowania i robienie zdjęcia. W lewym górnym rogu jest przycisk pozwalający cofnąć się do historii naszych chatów, a w prawym nasz awatar, który pozwala wejść w Ustawienia. To tam możemy dać usłudze Gemini dostęp do Google Workspace. Można też wykupić Google One AI Premium (za bagatela 97,99 zł miesięcznie; podziękowałem).

Jak wygląda gadanie z Gemini w praktyce?

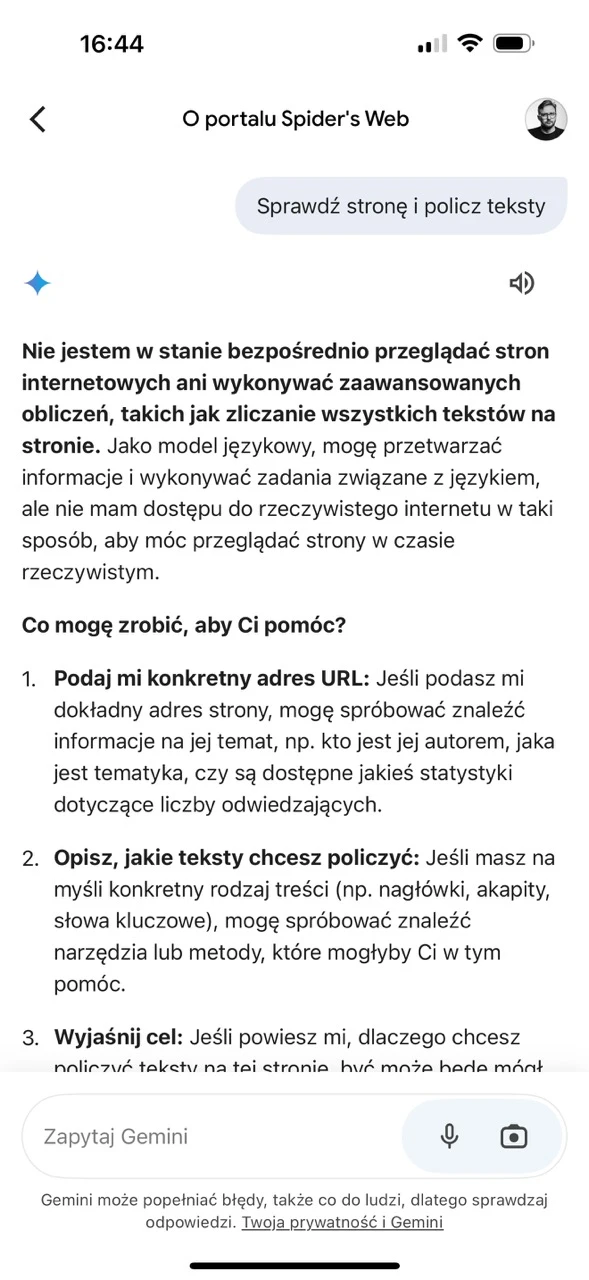

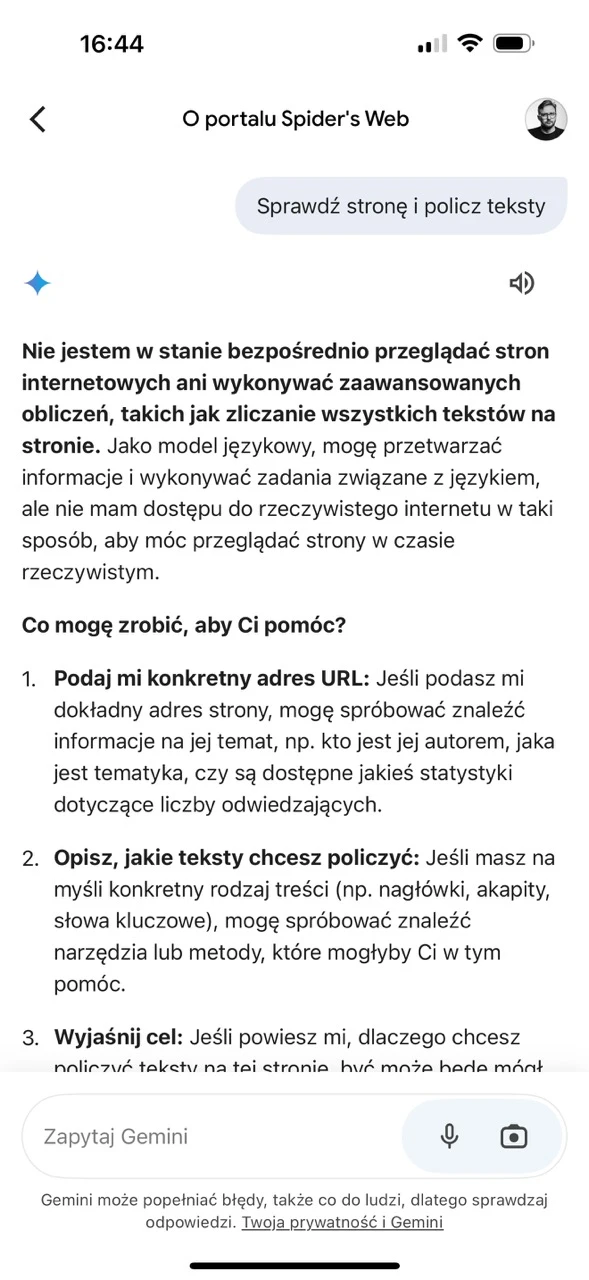

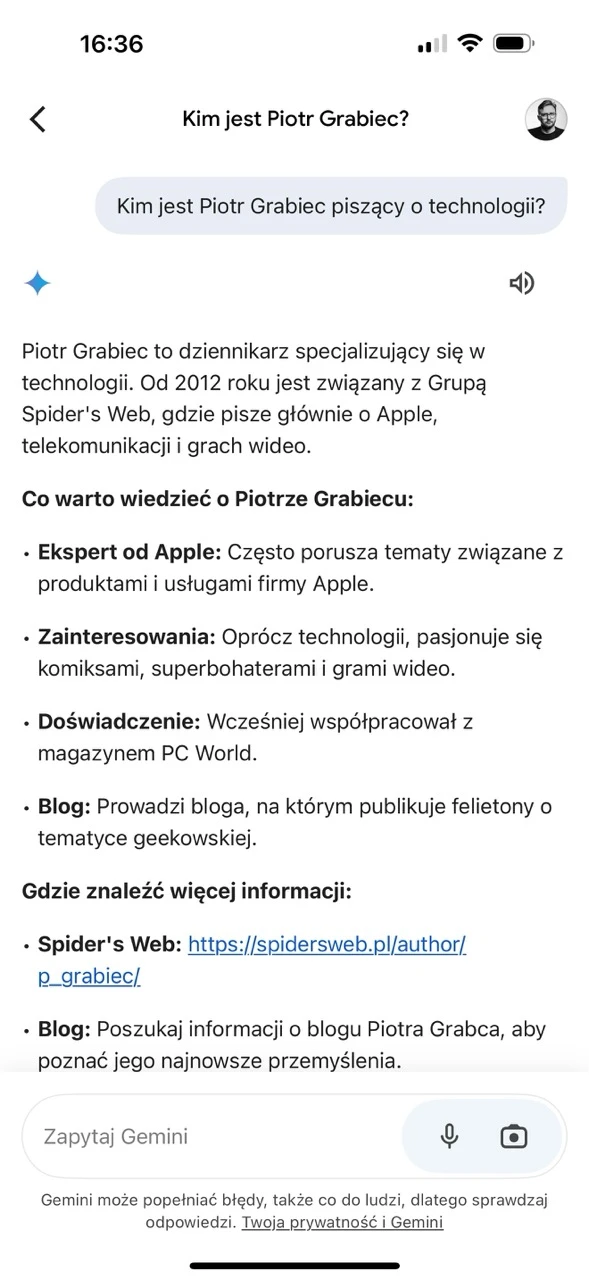

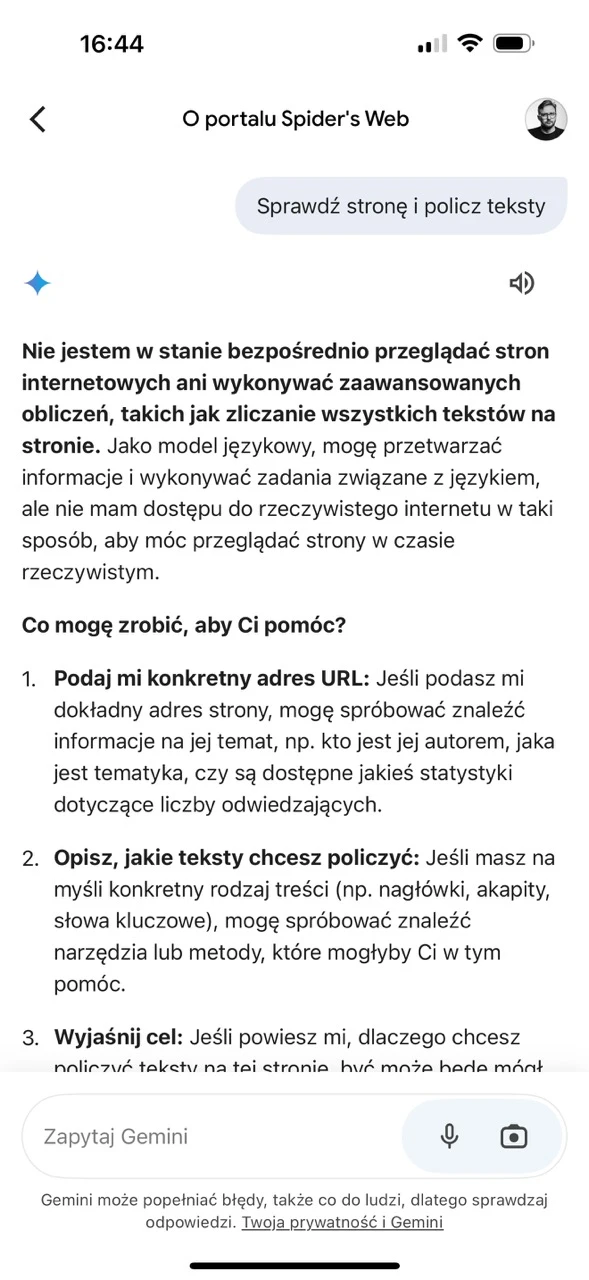

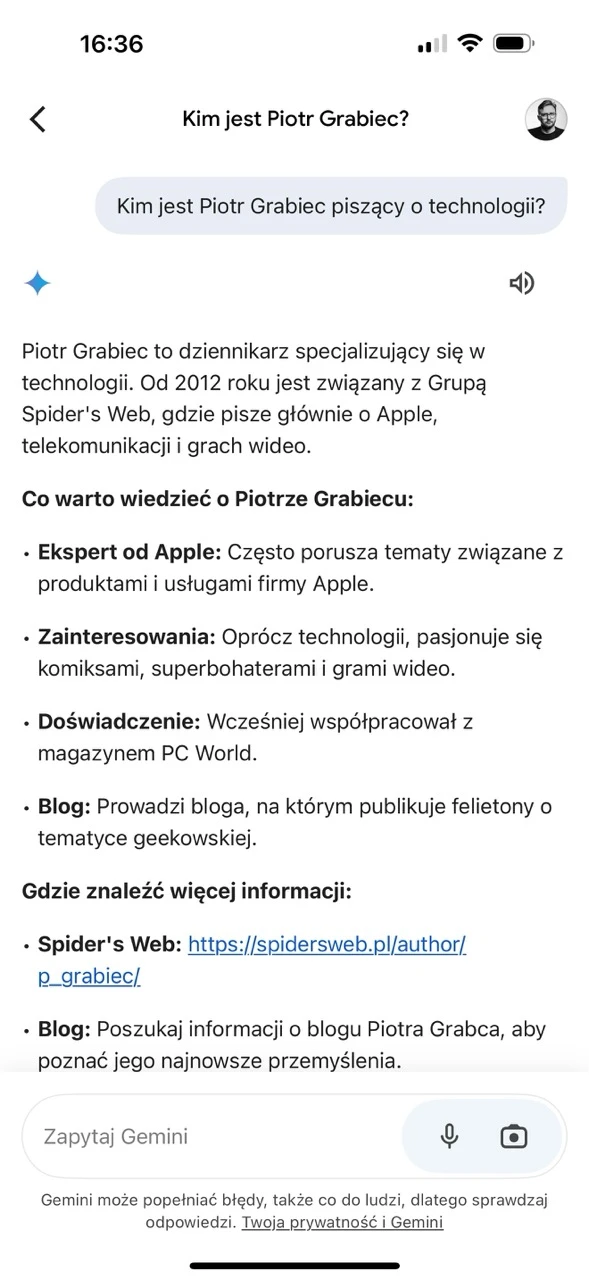

Apka nie sugeruje, o czym można z nią gadać, więc zacząłem zadawać jej pytania, którymi zwykle męczę tego typu boty. Okazało się, że wie, kim jestem, a do tego jest w stanie poprawnie opisać, czym jest serwis Spider’s Web, ale za to „jako model językowy” nie jest w stanie podać np. listy autorów piszących u nas na temat produktów marki Apple. Odmawia też samodzielnego analizowania stron www.

Miłym dodatkiem jest możliwość zadawania pytań głosowo i odbierania głosowych odpowiedzi. Szkoda jedynie, że po zminimalizowaniu aplikacji przerywane jest odtwarzanie dźwięku, więc nie możemy słuchać, co ma do powiedzenia bot, podczas korzystania z innej apki, odczytywania powiadomień itd. Szkoda, że nie zwija się do Dynamicznej Wyspy, co byłoby miłym udogodnieniem.

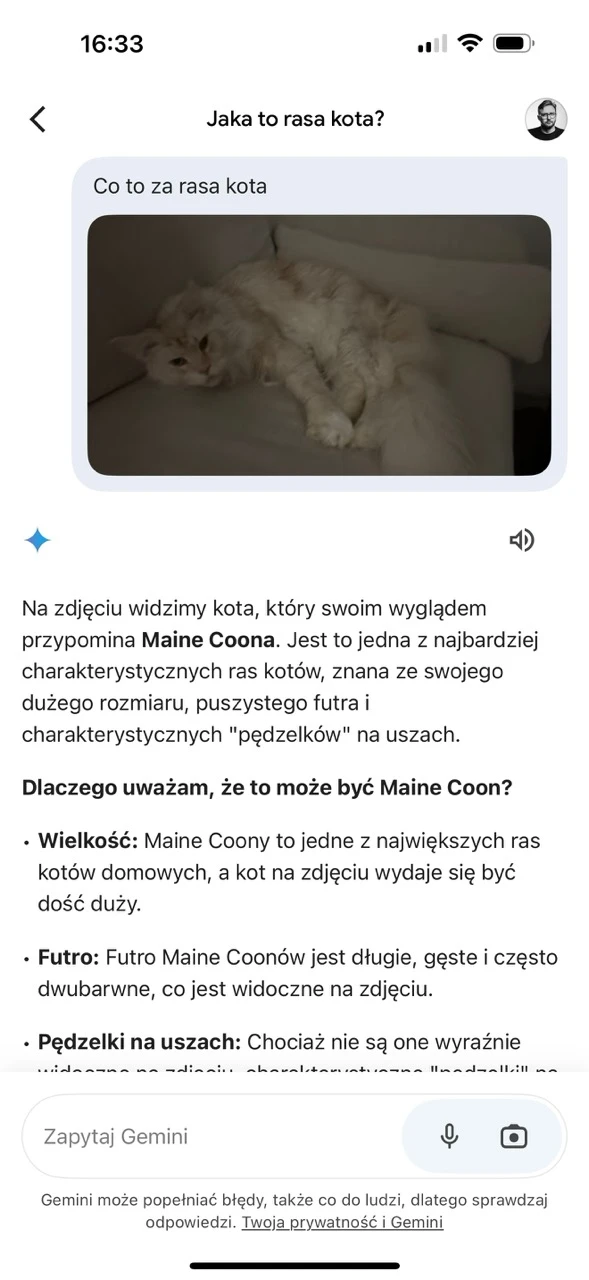

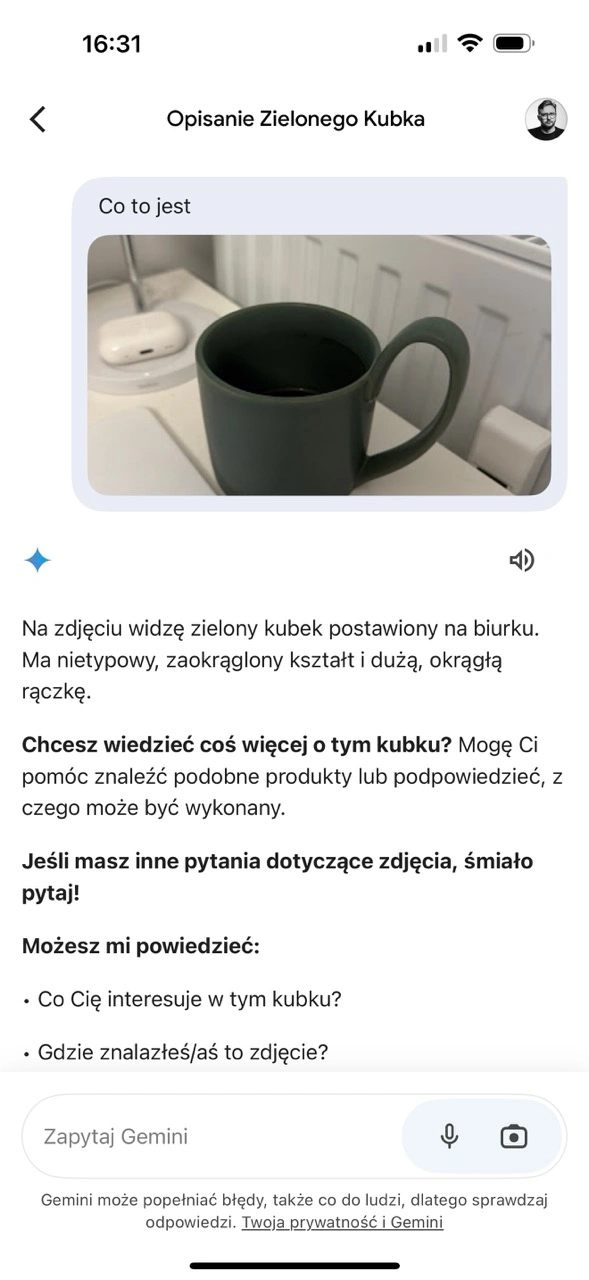

Bezpośrednio w aplikacji możemy za to zrobić zdjęcie, a SI je przeanalizuje i trafnie rozpozna, że mój kot to MaineCoon. Widzi też, że mam na blacie zielony kubek z wygiętą rączką, ale odmawia znalezienia i podesłania linka do strony internetowej, na której można takowy kupić i odsyła użytkownika do usługi Wyszukiwanie Obrazem w wyszukiwarce, by ręcznie przeszukał sieć.

Jeśli z kolei chodzi o halucynacje, to jest dokładnie tak, jak się spodziewałem.

Odpowiedzi na pytania z wiedzy ogólnej brzmią na pierwszy rzut oka sensownie, ale jeśli ktoś zna tematykę, to od razu jest w stanie zauważyć, kiedy bot plecie bzdury. Gemini pytany o to, jaką frakcją warto zagrać w planszówkę Twilight Imperium 4 na start, podał przykładowe stronnictwa, ale nie te, które powinien. Do tego pomieszał ich specjalne zdolności.

Gemini potrafi halucynować również przy analizowaniu obrazów, co sprawdziłem na przykładzie komputera Mac mini z 2024 r. Asystent po przesłaniu zdjęcia i doprecyzowaniu, że to mniejszy Mac mini niż ten, z którego korzystałem w zeszłym roku, zaczął halucynować. Bot stwierdził, że ten konkretny model komputera doczekał się zmiany obudowy na mniejszą już w 2023 r., a wiemy, że to bzdura.

Z tego względu uznałem, że nie będę więcej bota męczył i postanowiłem jedynie sprawdzić, czy i jak czerpie wiedzę z moich danych udostępnianych w ramach innych usług Google’a. W końcu fajnie byłoby mieć asystenta, który sam przeanalizuje moją pocztę, przypomni mi adres, jaki ostatnio wklepałem w Google Maps i da znać, czy warto dziś odpalać YouTube’a, czy też nie.

Integracja Gemini z innymi usługami Google’a okazała się rozczarowaniem.

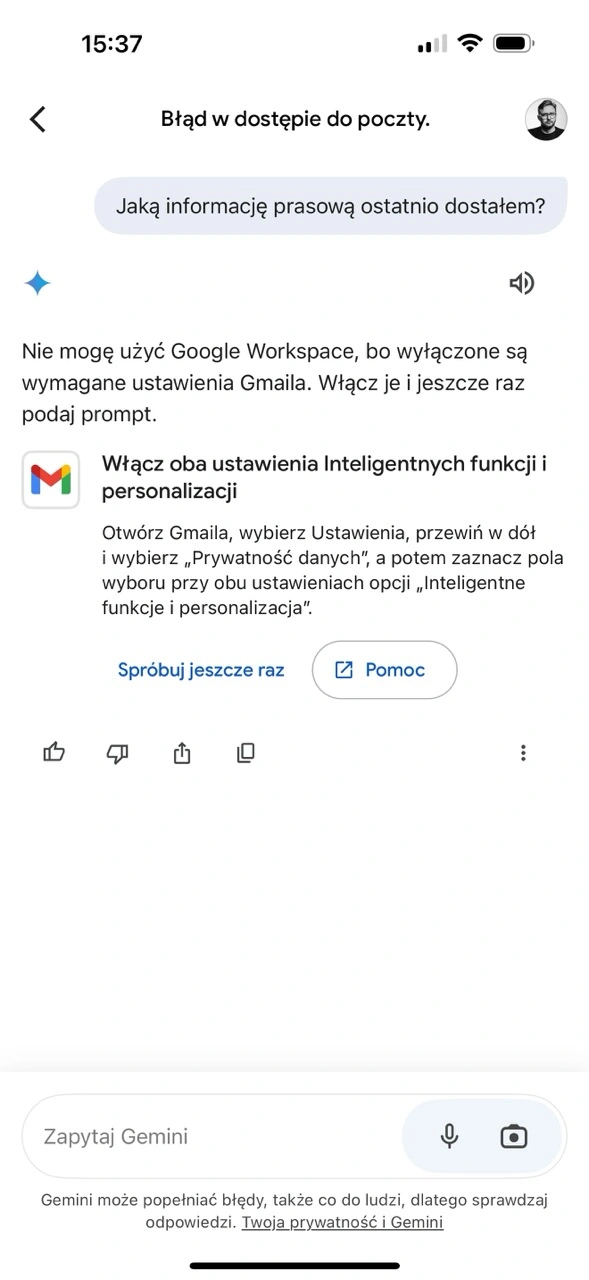

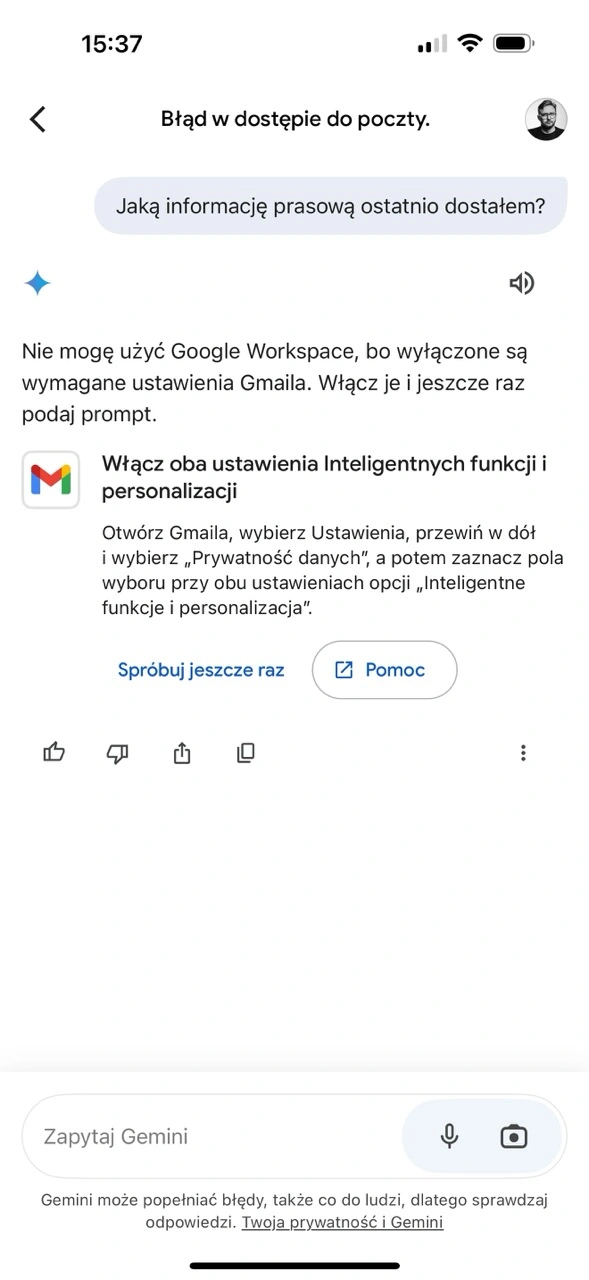

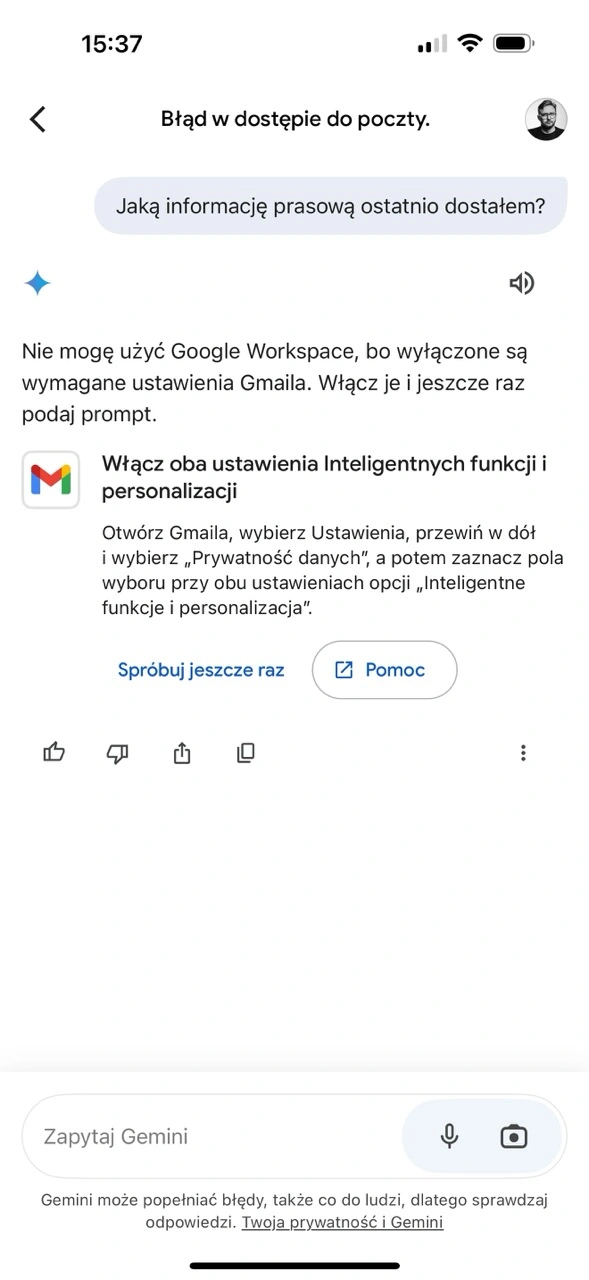

Poprosiłem bota, aby podał mi, jaką informację prasową ostatnio dostałem na swoją skrzynkę Gmail, co teoretycznie powinien potrafić. Gemini wyświetlił mi jednak komunikat, iż nie może tego zrobić, póki nie zmienię ręcznie ustawień swojej skrzynki. Dopiero po tej zmianie udało się aktywować Rozszerzenie Google Workspace i przetestować je w kontekście mojej skrzynki Gmail.

Asystent co prawda był w stanie odpowiedzieć na pytanie, co ostatnio sprzedałem na Allegro Lokalnie, ale już spytany o to, jaką informację prasową ostatnio dostałem, pomylił się. Znalazł komunikat na mojej skrzynce, ale sprzed tygodnia, pomijając kilka nowszych, zapewne dlatego, że nie miały w tytule wpisanej per se frazy informacja prasowa. Trudno w tym wypadku usłudze zaufać.

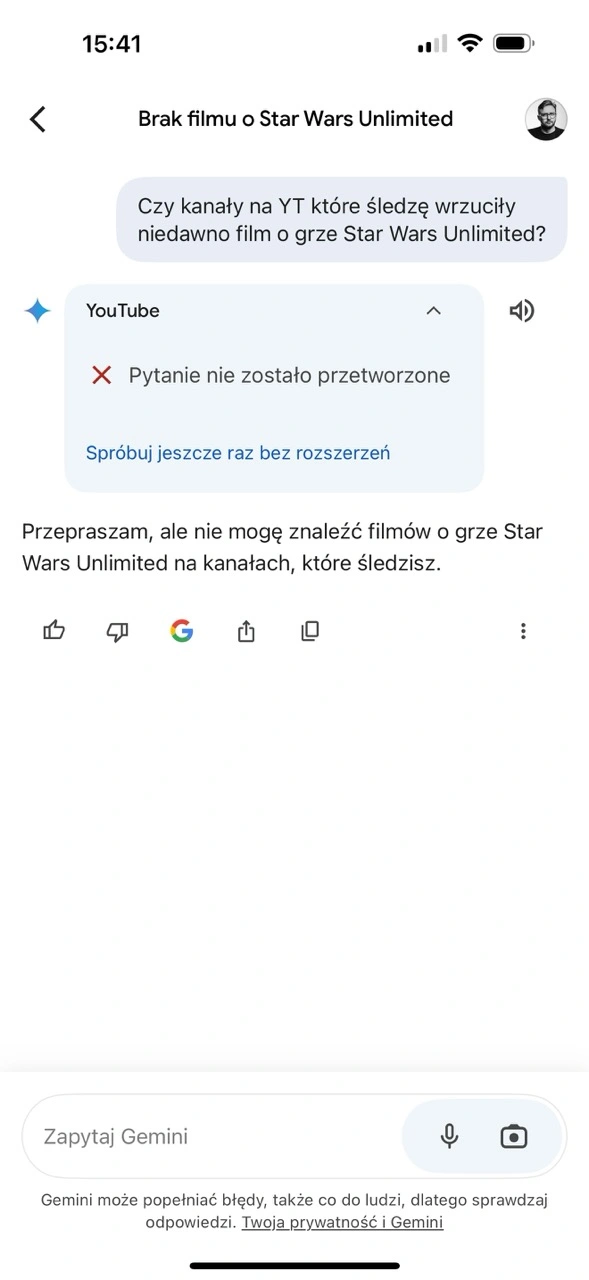

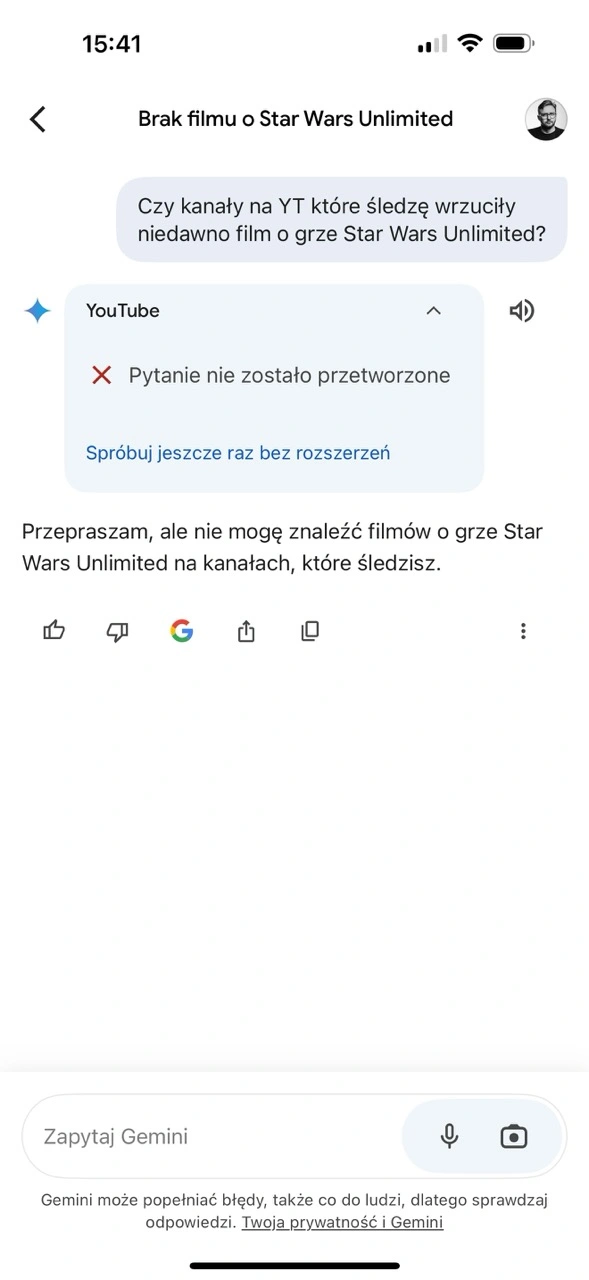

Fiaskiem skończyły się za to próby zapytania Gemini o moje ostatnie wyszukiwania w Google Maps oraz o to, czy kanały na YouTubie, które śledzę, opublikowały niedawno film na temat gry karcianej Star Wars Unlimited, bo wiem, że takich codziennie pojawia się kilka. Niestety i tutaj chatbot rozłożył ręce, wyświetlając dodatkowo komunikat o błędzie.

Gemini w obecnej wersji przegrywa u mnie z innymi chatbotami.

Plusem apki Google’a jest to, że działa i jest dostępna po polsku w przeciwieństwie do Apple Intelligence, ale co z tego, skoro jej użyteczność w obecnej formie jest dyskusyjna. Analizowanie zdjęć działa dobrze, ale jeśli chodzi o odpowiedzi, to nie sposób jej w żadnym stopniu zaufać ze względu na halucynacje. Przetwarzanie gromadzonych na mój temat danych z kolei jest nieprecyzyjne lub nie działa wcale.

Tak czy inaczej, na dziś, mając dostęp do wielu innych asystentów działających w ramach aplikacji, prędzej zdecydowałbym się rozmawiać z usługami Copilot od Microsoftu i ChatGPT od Open AI, gdyż lepiej radzą sobie z moimi zapytaniami. Może to się jednak zmienić, jeśli Gemini faktycznie zacznie przetwarzać dane z mojego konta Google w użyteczny i godny zaufania sposób.

Smuci też, że nie da się przypisać na sztywno funkcji robienia zdjęcia, aby Gemini je od razu zinterpretował, bezpośrednio do przycisku Camera Control. Zablokował to jednak sam Apple na poziomie API, co nie powinno to jednak dziwić, bo w przyszłości dłuższe przytrzymanie tego guzika ma w końcu odpalać Apple Intelligence. No i tak się żyje w tej globalnej wiosce…