Z wyszukiwarką Google będziesz gadał jak z człowiekiem. To zmieni wszystko

Wczorajsza demonstracja modelu GPT-4o od OpenAI i Microsoftu znowu zapewniła tym firmom technologiczną przewagę, która właściwie to trwała jeden dzień. Model Gemini od Google’a i wykorzystujące go usługi rozwija się w niezwykłym tempie. Jego logiczne rozumowanie coraz bardziej przypomina to ludzkie.

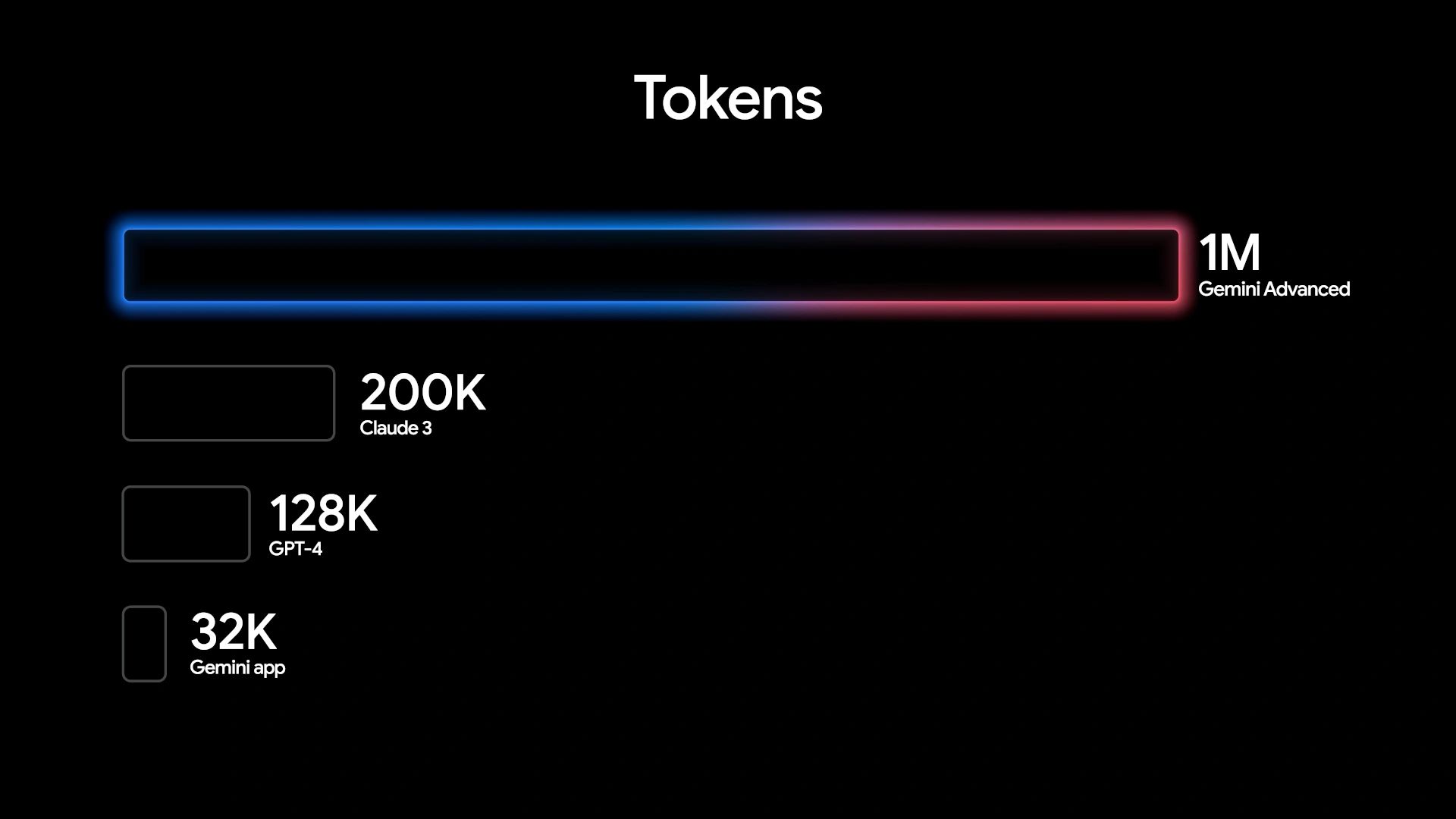

Gemini 1.5 Flash to pierwsza z zapowiedzianych przed chwilą na konferencji I/O 2024 nowości. To model SI który jest, jak nazwa sugeruje, znacznie lżejszy od Gemini 1.5 Pro, ale podobnie jak jego większy brat obsługuje polecenia o długości nawet miliona tokenów (lub 2 mln przez deweloperskie API na Google Cloud).

Ów model ma duże możliwości wnioskowania multimodalnego na podstawie ogromnych ilości informacji i zapewnia imponującą jakość jak na swój rozmiar. 1.5 Flash doskonale sprawdzać się ma w podsumowaniach, aplikacjach do czatowania, podpisach do obrazów i filmów, wyodrębnianiu danych z długich dokumentów i tabel i nie tylko. Został on przeszkolony za pośrednictwem modelu 1.5 Pro przez proces zwany destylacją, podczas którego najważniejsza wiedza i umiejętności z większego modelu są przenoszone do mniejszego, bardziej wydajnego.

Czytaj też:

Gemini 1.5 Pro staje się jeszcze sprawniejszy. A Gemini Nano postrzega świat coraz większą liczbą zmysłów

Model Pro również został istotnie ulepszony. Oprócz rozszerzenia okna kontekstowego do dwóch milionów tokenów, ulepszono generowanie kodu, logiczne rozumowanie i planowanie, wielowątkową konwersację oraz zrozumienie dźwięku i obrazu poprzez ulepszenia danych i algorytmów. Najnowsza wersja 1.5 Pro osiąga znaczne postępy w publicznych testach porównawczych w kilku dziedzinach, takich jak rozumowanie i kodowanie, a także najnowocześniejszą wydajność w wielu testach rozumienia obrazów i wideo, w tym MMMU, AI2D, MathVista, ChartQA, DocVQA, InfographicVQA i EgoSchema.

Wersja 1.5 Pro, jak zapewnia Google, może teraz wykonywać coraz bardziej złożone i dopracowane instrukcje, w tym odgrywanie ról i zachowywanie danych stylów wypowiedzi. Google dodał też obsługę dźwięku w API Gemini i Google AI Studio, dzięki czemu wersja 1.5 Pro może teraz analizować obraz i dźwięk w przypadku filmów przesyłanych w Google AI Studio.

Google doda też możliwość przesyłania plików za pośrednictwem Dysku Google lub bezpośrednio z urządzenia, bezpośrednio do Gemini Advanced. Będzie można szybko uzyskać odpowiedzi i spostrzeżenia dotyczące dokumentów, na przykład sprawdzając szczegóły dotyczące zwierząt w umowie najmu mieszkania lub porównując kluczowe argumenty z wielu długich artykułów naukowych. Wkrótce Gemini Advanced będzie działać jako analityk danych, odkrywając spostrzeżenia i tworząc niestandardowe wizualizacje i wykresy na podstawie przesłanych plików danych, takich jak arkusze kalkulacyjne. Zwiększona też zostanie integracja z usługami Google, w tym z YouTube’em czy z Mapami.

Ulepszeń doczekał się też działający offline Gemini Nano, który obecny jest chociażby w nowych urządzeniach Pixel. Co niezwykle istotne i użyteczne, zyskał obsługę multimodalności, co oznacza, że potrafi już nie tylko przetwarzać tekst, ale też obraz, dźwięk i mowę.

Projekt Astra, czyli piękna wizja przyszłości. Trudno w nią uwierzyć, patrząc po niespełnionych obietnicach w związku z Asystentem Google

Demonstrację modeli SI podczas I/O zakończył pokaz asystenta przyszłej generacji, którą Google nazywa póki co Project Astra. Pokaz bardzo przypominał ten niedawny, związany z GPT-4o. Tyle że Astra jest jeszcze w powijakach. To asystent głosowy, który potrafi na żywo rejestrować obraz, dźwięk i inne sygnały i w czasie rzeczywistym na nie reagować. Taki Asystent Google nowej generacji, tyle że do obsługi i zrozumienia poleceń użytkownika używa Dużego Modelu Językowego i systemów SI do rozpoznawania mowy i wideo. W efekcie wywiera iluzję jakby to była prawdziwie inteligena istota - świadomy komputer, rodem z filmów science-fiction.

Project Astra ma za sprawą swojej niezwykle sprawnej (w kontekście czasu przetwarzania danych i skuteczności) metodzie przetwarzania informacji doskonale rozumieć kontekst sytuacji, w jakiej się znajduje, a co za tym idzie również kontekst pytania i polecenia. Wygląda to bardzo imponująco, ale zapewne niektórzy nadal pamiętają pokaz Asystenta Google na jednej ze wcześniejszych I/O, który sam w imieniu użytkownika rezerwował wizytę u fryzjera. Na razie Astra to raczej koncepcja niż produkt.

Na szczęście nie trzeba wzdychać do Astry, by być pod wrażeniem. Microsoftowi i OpenAI wyrósł sensowny rywal. To Google i jego Gemini. Nie możemy się doczekać możliwości jego przetestowania. Zwłaszcza że pozwoli już niebawem tworzyć Gems - czyli modele trenowane na konkretnym, wskazanym przez użytkownika zbiorze danych, co powinno ukrócić halucynacje. Ciekawe tylko czy język polski nie będzie jakimś problemem…