Zaraz wyjdzie najszybsza karta graficzna, więc jej nie polecam

Nie mam żadnej wątpliwości. Układy graficzne RTX 4000 w kategorii surowej mocy obliczeniowej i możliwości technicznych znowu będą najlepsze na rynku. Mam jednak coraz więcej wątpliwości czy właśnie tego rynek potrzebuje i sami gracze. Gdybym dziś miał wracać do grania na PC, prawdopodobnie wybrałbym system od AMD. Prawdopodobnie kosztem rozdzielczości i płynności. Pozwólcie, że wytłumaczę dlaczego.

Z punktu widzenia rynku konsumenckiego, AMD prowadzi dwie poważne batalie. W pierwszej odnosi spektakularne sukcesy: na rynku procesorów PC w ostatnich latach to desktopowe i laptopowe układy Ryzen zdają się być wzorem do naśladowania, co zresztą widać w ich wynikach sprzedaży. Kolejne generacje układów Intel Core, choć bardzo konkurencyjne, są też w kontekście wysiłków (i cen!) AMD rozczarowujące. O Qualcommie nie wspominam, szkoda czasu na kopanie leżącego.

Czytaj też:

Dużo gorzej sprawy się mają na rynku kart graficznych. W ostatnich latach układom AMD Radeon było bardzo trudno przebić się przez dominację GeForce RTX. Początkowo przedstawiciele AMD tłumaczyli to brudną polityką rywala, mającą polegać na sponsorowaniu prac studiów deweloperskich, które w zamian optymalizować miały swoje produkcje pod dostępne tylko w GeForce’ach rozwiązania techniczne. Te zarzuty, nawet jeśli zasadne, to jednak tylko jedna strona medalu. Prawda jest taka, że AMD wpadło w konsolową pułapkę, a także zaspało trend na rozwój sztucznej inteligencji.

Sojusz z PlayStation i Xboxem zapewnił AMD wpływ na cały rynek gier. Ale też związał mu ręce

Karty AMD Radeon cieszą się, w najlepszym razie, umiarkowaną popularnością wśród graczy entuzjastów. To jednak nie oznacza, że zawarta w nich technologia to rynkowa egzotyka. Gdy Sony i Microsoft szukały partnera sprzętowego do zbudowania następców PlayStation 3 i Xboxa 360 szukały firmy, która zapewni chipy nie tylko mające wprowadzić format HD już jako oczywisty standard do gier wideo, ale też nieodległe w swojej architekturze chipom stosowanym w świecie PC, a także takim, które zużywają relatywnie niewielką ilość energii i emitują względnie niewiele ciepła.

Kulisy powstawania Xboxa One i PlayStation 4 nie są jeszcze dokładnie znane, jednak z dobrych źródeł wiemy, że ostatni z wyżej wskazanych wymogów skierował uwagę Sony i Microsoftu w stronę AMD. Ów wymóg był ważny: dochodzące z rynku sygnały sugerowały, że konsole do gier mogą wyjść z mody na rzecz gier na tablety i telefony, więc obu firmom zależało na zbudowaniu cichego urządzenia, które nie naraża klientów na zbędne koszty. Intel i Nvidia nie miały nic sensownego wówczas do zaoferowania. AMD, z jego AMD Jaguar i doświadczeniem w budowaniu APU, było ponoć nie tylko dobrym, ale też jedynym i oczywistym wyborem.

To postawiło Nvidię w interesującej sytuacji. Z jednej strony nic to nie zmienia na rynku kart graficznych na PC. Z drugiej jednak większość gier powstaje zarówno na konsole, jak i na PC - by wydatek na ich produkcję szybciej się zwrócił. Niezależnie od tego, ile wysiłku ta włoży w autorskie technologie GeForce i współpracę z deweloperami, twórcy gier i tak będą musieli optymalizować swoje twory pod technologie AMD w Xboksie i PlayStation.

AMD zostało wykorzystane nie tylko do odświeżenia konsol ubiegłej generacji (PS4 Pro, Xbox One X), ale też ponownie budowało z Sony i Microsoftem konsole generacji bieżącej (Xbox Series X|S, PlayStation 5). To umocniło pozycję firmy jako mającej wpływ na rozwój całej branży, ale też kosztowało ją nieco wyrzeczeń.

Według nieoficjalnych spekulacji główną przyczyną wyboru mniej wydajnych technologii do akcelerowania grafiki ze śledzeniem promieni (ray tracing) w układach graficznych AMD RDNA2 wynika z konieczności zachowania odpowiedniego dla konsol rozmiaru układu scalonego i z odpowiednią charakterystyką cieplną, na czym cierpią karty graficzne dla PC. GeForce RTX nie musi się skalować do niewielkiego pudełeczka, jakim jest konsola - więc ma całe dedykowane bloki obliczeniowe do śledzenia promieni, osiągając w grach z ray tracing zazwyczaj znacznie lepsze wyniki od układów AMD Radeon.

Miliardy Nvidii w rozwój sztucznej inteligencji. Ospałość AMD głównym powodem niższej popularności kart Radeon?

Po co sztuczna inteligencja kartom graficznym? Nvidia postanowiła szybciej znaleźć odpowiedź na to pytanie, a AMD zwlekało. Przez lata lider rynku kart graficznych prowadził długie i kosztowne badania - co ewidentnie popłaciło. Rezultaty dotyczą wielu zastosowań dla profesjonalistów i naukowców, ale i gracze czerpią z tego korzyści. Chodzi o niesamowitą technologię rekonstrukcji obrazu, jaką jest DLSS.

Zaszyte w DLSS algorytmy są w stanie niemal bezbłędnie dorysowywać brakujące piksele w ruchomym obrazie, przy znikomym (około 2 ms input laga) koszcie. Oznacza to, że układ graficzny może wewnętrznie renderować grę w rozdzielczości, na przykład, 1440p, a końcowy obraz i tak będzie w jakości 4K.

Zapewnia to olbrzymie oszczędności w mocy obliczeniowej, które procesor graficzny może wykorzystać do innych, dodatkowych celów - jak dodatkowe elementy graficzne, czy po prostu generowanie większej liczby klatek na sekundę. Efekt DLSS dodatkowo kumuluje się z pracą modułów akcelerujących ray tracing. DLSS ma właściwie tylko dwie wady. Nie działa automatycznie, twórcy gry muszą zaimplementować jego obsługę. No i nie działa na układach innych niż GeForce RTX. Zapewnia jednak graczom ogromne korzyści, których u AMD próżno było przez długi czas szukać.

Spodziewam się przewagi surowej mocy obliczeniowej GeForce’ów. Tym razem postawiłbym jednak na AMD Radeon. Wyraźnie odrobili pracę domową

Jestem niemal pewien (choć to muszą zweryfikować testy), że w batalii na surową moc obliczeniową i jakość obrazu to karty Nvidii znów zapewnią najlepsze rezultaty. Tym razem jednak warto rozważyć ukryty koszt tej przewagi. Zarówno bezpośredni (karty GeForce są zazwyczaj najdroższe), jak i pośredni. W tym drugim mam na myśli to, że według wiarygodnych (i nieoficjalnych) informacji, układy RTX 4000 będą bardzo prądożerne. A przecież najbliższe lata upłyną pod znakiem starannego zarządzania zużyciem energii w domu z uwagi na rosnące jej ceny.

AMD nie tylko umocniło swoją pozycję na rynku gier wideo, to na dodatek nadrobił wiele zaległości. Na dziś wysokobudżetowa gra wideo budowana jest na platformy:

- Xbox One

- Xbox One X

- Xbox Series S

- Xbox Series X

- PlayStation 4

- PlayStation 4 Pro

- PlayStation 5

- AMD Radeon

- Nvidia GeForce

- Nintendo Switch

Kursywa oznacza platformy z technologiami AMD, brak kursywy platformy z technologiami Nvidii. Nawet jeśli uprościć powyższą listę i usunąć z niej podział na warianty S/X i Pro, to i tak przewaga kontroli w zakresie AMD jest znacząca. Przy założeniu, że AMD pilnować będzie jakości sterowników kart graficznych na PC, wybór Radeona powinien teoretycznie gwarantować, że każda wysokobudżetowa gra będzie na owym Radeonie działać co najmniej przyzwoicie. Bo i tak była optymalizowana pod chipy AMD w konsolach Xbox i PlayStation w wielu wariantach i generacjach.

To jednak niewystarczający argument, jeżeli mimo powyższego GeForce i tak będzie gwarantował wyższą wydajność za sprawą magii DLSS. Chipy AMD do dziś nie zawierają bloków sprzętowych akcelerujących przeliczenia związane ze sztuczną inteligencją i zdaje się, że w przewidywalnej przyszłości to się nie zmieni. Niedawno jednak twórcy Radeona zaprezentowali swoje własne rozwiązanie. Algorytm FSR 2.0, który rzeczonych bloków nie potrzebuje - choć umie z nich korzystać.

Tak, FSR 2.0 jest multiplatformowy. Działa na konsolach Xbox i kartach Radeon, może jednak też działać na GeForce’ach i kartach Intela. AMD świadomie chce oferować FSR 2.0 jako standard, bo strategia z nim związana prawdopodobnie nie ma na celu zwiększenia sprzedaży kart Radeon - a zmniejszenie atrakcyjności technologii DLSS. Według testów porównawczych ekspertów z Digital Foundry, FSR 2.0 jest nieco gorszy od DLSS 2.x zarówno w tym ile oszczędności na wydajności zapewnia, jak i w oferowanej jakości obrazu. Są to jednak różnice marginalne.

W zamian twórca gier ma do wyboru: DLSS tylko dla GeForce’ów, czy też nieznacznie gorszy FSR 2.0, ale za to dla wszystkich graczy (poza PlayStation, z jakiegoś dziwnego powodu). Można śmiało zakładać dużą popularność alternatywy od AMD. Zwłaszcza że rozwój FSR nie stoi w miejscu, będzie z czasem oferował coraz to lepsze i lepsze rezultaty.

Czytaj też: Co to jest DLSS i FSR? Tłumaczymy na jakiej karcie działa

No i jest jeszcze jedno. Byłoby nieistotne, gdyby ludzkość nie była tak głupia. Chodzi o prąd

Inwestycja w Radeona oznacza inwestycję w kartę będącą niemalże nieoficjalnym standardem, pod który optymalizowane są gry. Dopłacanie dużych kwot do nieco wyższej płynności w grach (bo jednak należy się spodziewać, że to Nvidia będzie miała najszybsze układy) może być przez wielu postrzegane jako future proofing. Czyli zainwestowanie w coś lepszego, by mieć następnie spokój z zakupami na długie lata. Mając na uwadze rosnące ceny energii, ten pogląd być może trzeba będzie zrewidować.

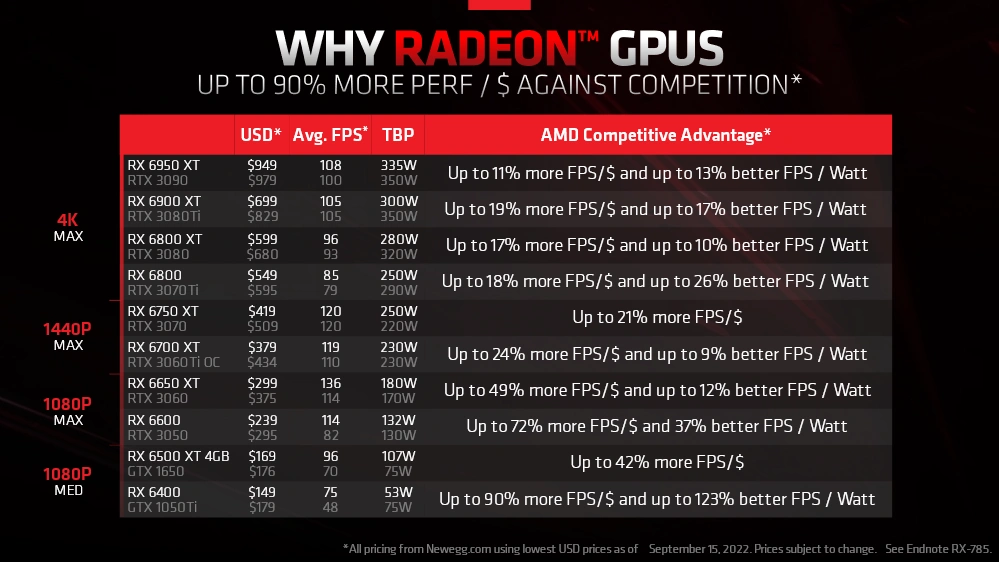

Podobno karty RTX 4000 będą wyjątkowo łapczywie pobierać prąd do realizacji związanych z grami przeliczeń. Tymczasem Radeony zaczynają zamieniać swoją słabość (mam na myśli wspomniane wyżej konsekwencje konsolowego rodowodu) w atut. Firma dziś rozesłała informacje prasowe do mediów, by się z tym przypomnieć i ów atut podkreślić.

Akcja PR-owa całkiem udana, bo stanowiła inspirację do niniejszego tekstu. Trudno jednak nie odmawiać słuszności tej nowej optyki. Sprawność energetyczna Radeonów jest bowiem tym, co ostatecznie może przeważyć szalę i stanowić ostateczny czynnik decydujący o zainwestowaniu w Radeona zamiast w GeForce’a.

Wyższa sprawność energetyczna przekłada się na niższy hałas, mniejsze temperatury oraz mniejsze potrzeby w zakresie stosowania dużych i rozbudowanych systemów chłodzenia. Przede wszystkim to jednak niższe rachunki za prąd. I to zauważalnie niższe, biorąc pod uwagę prądożerność gamingowego PC i rosnące w górę ceny energii. A ma być tylko lepiej.

Doświadczenie w budowaniu chipów dla Xboxa i PlayStation ma znaleźć odzwierciedlenie nie tylko w układach AMD z rodziny RDNA 2, ale też mającej ją zastąpić RDNA 3. Konstrukcja chipletowa, 5-nanometrowy proces technologiczny i AMD Infinity Cache nowej generacji to ponoć 50-procentowa poprawa sprawności względem RDNA 2.

Przez długi czas Radeony znajdowały się w dziwnym miejscu na rynku. Oferowały lepsze wyniki w surowej rasteryzacji obrazu niż konkurencja, ale mając na uwadze śledzenie promieni i DLSS stanowiły niemalże biedaalternatywę. Propozycję dla tych, którzy nie mogą sobie pozwolić na GeForce’a. Ta optyka zdaje się już nieaktualna. A testy porównawcze kart graficznych dawno się nie zapowiadały na tak ekscytujące.