Monitor gamingowy i telewizor do gier. Jaki panel, jakie proporcje? Ekspert odpowiada na ważne pytania

Wybór właściwego monitora lub telewizora do gier to nie jest łatwa sprawa. Jaki rodzaj panelu? Jaka rozdzielczość? Jakie proporcje? Płaski czy zakrzywiony? Który standard HDR? Aby nieco pomóc osobom rozglądającym się za nowym ekranem postanowiliśmy porozmawiać z ekspertem obrazu.

Wybór nowego wyświetlacza do gier często stanowi wyzwanie już na etapie wyboru samego panelu. TN, LCD, Mini LED, OLED czy QLED? Pytania zdają się wyłącznie mnożyć. Lepszy monitor czy telewizor? Postawić na 4K czy QHD albo FHD wystarczy? Wybrać płaski ekran czy zakrzywiony? Jaka częstotliwość odświeżania będzie wystarczająca? Jakie porty powinny znajdować się w obudowie? Na jaki standard HDR postawić? Jakie proporcje są optymalne? Jaka przekątna będzie najlepsza?

To wszystko tematy, które typowemu konsumentowi, który nie trzyma ręki na technologicznym pulsie, mogą spędzać sen z powiek. Dlatego postanowiliśmy zadań je ekspertowi. Moim rozmówcą jest Krzysztof Kunicki, który od siedmiu lat zajmuje się kategorią display i gamingiem w Samsung Electronics Polska, gdzie piastuje stanowisko Senior Product Marketing Managera.

Do grania na konsoli lepszy jest telewizor czy monitor? Po czym poznać, że TV jest za duży?

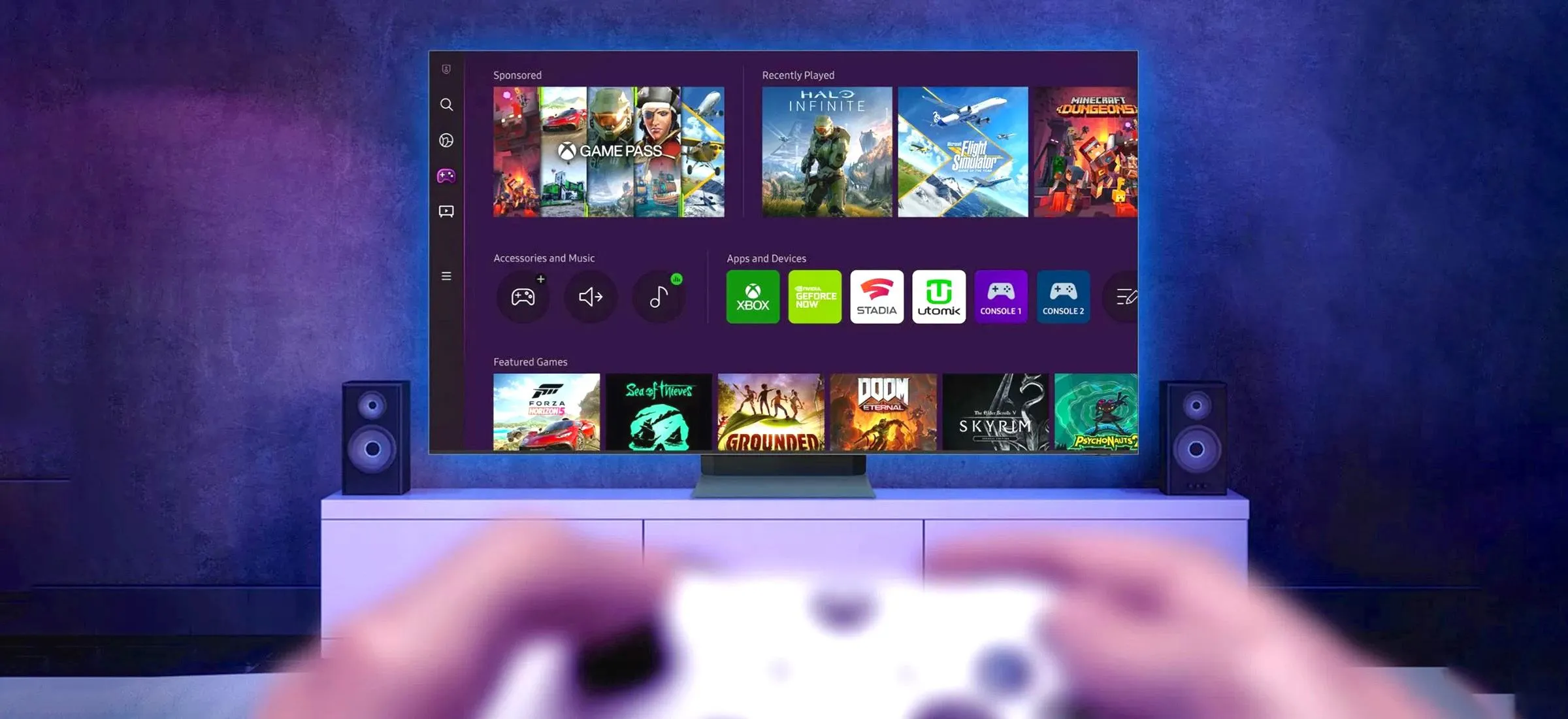

Szymon Radzewicz, Spider's Web: Kupiłem PS5 albo Xboksa Series. Co będzie lepszym wyświetlaczem dla takiej konsoli? Monitor czy telewizor?

Krzysztof Kunicki, Samsung Electronic Polska: Przez wiele lat uważano, że podstawowym i najlepszym wyświetlaczem dla konsoli jest telewizor. Tak to było pozycjonowane. To jednak tylko część prawdy. Coraz więcej graczy ceni sobie siedzenie w gamingowym fotelu, na wprost ekranu. Wtedy monitor spisuje się najlepiej. Podejście typu: jak konsola, to tylko telewizor, to zdecydowanie mit.

Podstawowa kwestia to gabaryty. Wszystko zależy od tego, w jakim miejscu będziemy korzystać z takiego sprzętu. Jeżeli mamy do dyspozycji małe pomieszczenie, można pomyśleć o monitorze. Jeśli jednak lubimy się wygodnie rozłożyć na kanapie z padem w dłoniach, a do tego mamy odpowiedni metraż, wtedy zazwyczaj lepiej spisze się telewizor.

Znam jednak ludzi preferujących granie na monitorze podłączonym do konsoli, mimo posiadania dużego metrażu. Wolą pozostawać skoncentrowani zamiast rozsiadać się na kanapie. To w dużej mierze kwestia gatunku samej gry. Lepiej im się gra w pierwszoosobowe strzelanki w fotelu, na wprost ekranu, niż połowicznie leżąc z herbatą w salonie.

No dobrze, ale jak właściwie stwierdzić, czy mamy odpowiedni metraż na telewizor? Kiedy pomieszczenie jest za małe? Albo telewizor za duży?

Jak najbardziej istnieje tabela optymalnych odległości od ekranu. W zależności od tego dystansu wiemy, czy powinien być to monitor czy może już telewizor. W praktyce oddalenie o 80 centymetrów względem 32-calowego monitora generuje podobny efekt dla użytkownika, jak oddalenie na dwa metry od 55-calowego telewizora.

Jeśli od sofy do ekranu dzieli nas półtora metra czy dwa metry lub więcej, wtedy telewizory 55, 65 czy 85 cali są w porządku. Jeśli z kolei mówimy o odległości do metra, wtedy monitor jest właściwy. Mając siedzisko na wprost takiego monitora, warto pomyśleć o zakrzywionym panelu.

Gdy odwiedzają mnie znajomi, uważają mój telewizor za „zbyt wielki”. Po czym to poznać?

Jestem wyznawcą teorii, że nie ma czegoś takiego jak zbyt duży telewizor. Jedyne, co realnie ogranicza konsumenta, to budżet. Każdy mój nowy telewizor był większy od poprzedniego i za każdym razem podczas planowania kolejnych zakupów spoglądałem na jeszcze większe modele. Wrażenie immersji na wielkim ekranie jest mocniejsze.

Dodajmy do tego zagięty panel dużego monitora, a immersja zostaje dodatkowo spotęgowana. Krzywizna oka bardzo dobrze współgra z krzywizną monitora.

Lepszy jest ekran płaski czy zakrzywiony? Co stało się z zakrzywionymi telewizorami? Lepsze jest 16:9 czy 16:10? Jak ma się do tego ultrawide?

Krzywy znaczy lepszy? Przynajmniej pod względem immersji?

Robiliśmy eksperymenty, wyświetlając ten sam obraz, z tej samej odległości, w tej samej grze, na 34-calowych monitorach 21:9 w rozdzielczości WQHD: jednym płaskim, drugim zagiętym. Ta sama osoba obserwująca obraz na monitorze zagiętym widziała więcej niż na monitorze płaskim, do tego bez poruszania głową. Zyskiwała podgląd na dłuższe boki mapy dla League of Legends, właśnie grając na zakrzywionym ekranie.

Czyli zakrzywione ekrany do grania, płaskie do pracowania i multimediów?

Nie, nie zgadzam się z taką tezą. W przypadku monitorów do 24 cali krzywizna w zasadzie nie generuje różnic. Od 27 cali efekt staje się odczuwalny, a od 32 cali jest istotny. Dlatego różnica na 34-calowym monitorze ultrawide o płaskim lub zakrzywionym wyświetlaczu jest gigantyczna. Płaska 34-ka absolutnie traci względem zakrzywionego odpowiednika.

Jeśli chodzi o samo granie: ludzie grający w FPS-y preferują płaskie monitory w proporcjach 16:9, ponieważ każda milisekunda ma znaczenie, a czas ruchu kursora jest ważniejszy od ekspozycji. Kiedy jednak gramy w symulatory, cRPG albo strategie, gdzie większa widoczność daje więcej możliwości i generuje lepszą oprawę, tutaj zdecydowanie zagięty utrawide spisze się najlepiej.

Im większy monitor do gier, tym lepszy? Jakie proporcje ekranu są preferowane w gamingu?

To w dużej mierze kwestia subiektywna, wynikająca z przyzwyczajenia. Przykładowo, są osoby grające w CS-a na 17-calowych płaskich monitorach w proporcjach 5:4. Uważają, że mając na wprost kwadratowy obraz, są na nim o wiele bardziej skupione i skoncentrowane. Łatwiej jest im wykonywać ruchy myszką niż na większym ekranie. To jednak profesjonaliści. Typowi gracze nie muszą i nie powinni iść w takie ekstrema.

W naszej firmie prowadziliśmy szerokie konsultacje, również z udziałem osób ze świata gamingu, o przewadze monitorów ultrawide nad klasycznymi lub odwrotnie. Zestawialiśmy szerokie ekrany 21:9 i klasyczne 16:9. Na przykładzie League of Legends okazało się, że każde rozwiązanie ma swoje plusy oraz minusy:

Ultrawide daje widok na większe pole gry. Jeśli tytuł wspiera proporcje 21:9, wyświetla się znacznie więcej treści, której nie widzisz na monitorze 16:9. Benefity węższego ekranu są inne, np. większa i wyraźniejsza minimapa. Jeśli ktoś z niej nieustannie korzysta, na ultrawide trudniej dostrzec drobne detale. Do tego szeroki ultrawide wymaga pracy głową, a podróż myszki z jednego krańca ekranu na drugi jest tam dłuższa.

Dla grania hobbistycznego, gdzie nie trzeba urywać milisekund na pracy kursorem, świetne będą monitory ultrawide, które potęgują immersję. Jeśli jednak ktoś stawia na e-sportową karierę, zapewne sięgnie po płaski panel 16:9.

Skoro krzywizna ma wyraźne zalety, dlaczego zakrzywione telewizory nigdy nie trafiły do łask?

Zakrzywione telewizory nie obroniły się dlatego że wymagały, by zawsze siedzieć bezpośrednio na wprost nich. Wtedy obraz jest wyraźny i właściwie wyświetlany. W przypadku zakrzywionego TV musielibyśmy mieć małą sofę na dwie, maksymalnie trzy osoby ustawioną idealnie na wprost, ograniczając w ten sposób widza. Już sama sofa w kształcie litery L powodowała wiele problemów. Odejście od kąta zerowego z każdym stopniem pogarsza czytelność obrazu, przez co takie telewizory traciły na uniwersalności.

W przypadku zakrzywionych monitorów ten problem nie występuje, bo z takich urządzeń zazwyczaj korzysta jedna, czasem dwie osoby usadowione za biurkiem, na wprost ekranu. Zakrzywione telewizory to jednak nisza.

A co sądzisz o modelach, które próbują pogodzić dwa światy, mogąc być jednocześnie płaskie lub zakrzywione?

Ciekawe rozwiązanie, bo inne. Natomiast szukając odpowiedzi na pytanie, na czyje potrzeby odpowiada taki produkt, trudno mi wskazać odpowiedź. Albo ktoś preferuje monitor płaski, albo zakrzywiony. Jaki scenariusz mógłby wymagać ode mnie, bym nagle musiał zmienić krzywiznę?

Powiedzieliśmy o klasycznych monitorach 16:9. A co z monitorami 16:10? Które są lepsze i dlaczego?

Uznaje się, że monitory 16:10 to monitory głównie biurowe, ponieważ mają o jedną dziesiątą od góry dołożonego obszaru roboczego. Kiedy powierzchnia robocza ma zasadnicze znaczenie, tam monitory 16:10 stają się praktyczne.

Jednak w przypadku monitorów gamingowych, gdzie większość zawartości produkowana jest w proporcjach 16:9, czasem kończy się to czarnymi pasami bądź sztucznie rozciągniętą treścią. Dlatego do pracy 16:10 jak najbardziej tak, z graniem jest już trochę gorzej.

Osobną, bardzo ciekawą kwestią jest cena. Koszt wytworzenia matrycy 16:10 jest nieproporcjonalnie większy w stosunku do tego, co się uzyskuje. Wynika to z procesu cięcia matryc, który jest dostosowany do 16:9, a 16:10 to proporcje niestandardowe. Pozostawiają więcej odpadów, za które producent również musi przecież zapłacić.

Większa rozdzielczość czy wyższa częstotliwość odświeżania w grach? Czy VRR przekłada się na klatki na sekundę?

Pytanie z gatunku niesprawiedliwych: wysoka rozdzielczość czy wysoki klatkaż? Co jest ważniejsze?

(śmieje się) Powtórzę się: zależy dla kogo. Osoba pracująca oglądając głównie statyczne obrazy powinna postawić na wysoką rozdzielczość. Powierzchnia robocza lubi wysoką rozdzielczość. Jednak nawet w pracy nie powinniśmy schodzić poniżej pewnych standardów, jak 75 Hz. Oczy się potem mocno męczą.

Natomiast odświeżanie ekranu, które niemalże bezpośrednio wiąże się z liczbą klatek, jest istotne, gdy mamy do czynienia z dynamicznymi obrazami. Na przykład grą wideo. Wysokie odświeżanie przekłada się po pierwsze na przyjemniejsze doświadczenie, po drugie na większą precyzję samego gracza.

Kiedy siadasz przy konsoli, wybierzesz natywne 4K/30 fps, dynamiczne 4K/60 fps czy FHD i 120 fps?

Do grania turniejowego zdecydowanie wybieram 120 fps. Jednak w spokojniejszej grze, która stawia na narrację, są tam dialogi, jest piękna grafika, mogą sobie spokojnie eksplorować i grać własnym tempem, to postawiłbym na dynamiczne 4K i 60 fps. Za to 30 klatek na sekundę to już jednak przesada (śmiech).

Będąc przy klatkach i konsolach: jaki wpływ na liczbę fps ma VRR (Variable Refresh Rate) i co to takiego?

VRR to stricte telewizorowa technologia, podczas gdy na monitorach nacisk położony jest na częstotliwości odświeżania oraz technologie wspomagające jak G-Sync oraz FreeSync. VRR na telewizorach działa w podobny sposób, zapobiegając rozdzieraniu obrazu. Są jednak istotne różnice. G-Sync oraz FreeSync to synchronizacja obrazu do pionowej krawędzi, dzięki czemu nie dochodzi do rozerwania. VRR też zapobiega rozrywaniu, ale przez dynamiczne dostosowanie odświeżania do tego, co aktualnie jest pokazywane na ekranie.

Formalnie VRR jest dostosowane do standardu HDMI 2.1, ale testy pokazują, że na HDMI 2.0 również da się korzystać z VRR. W mojej opinii to technologia głównie podbijana przez niektórych producentów, chociaż Microsoft miał ją na pokładzie Xboksa wcześniej. Kupując telewizor do gier, warto sprawdzić, czy ma VRR. Ale jeszcze bardziej warto postawić na odpowiednie kable.

Kabel kablowi nierówny. Dlaczego winowajcą problemów może być okablowanie i kiedy kabel jest zbyt tani

Chcesz powiedzieć, że kabel HDMI jest nierówny innemu kablowi HDMI?

Ależ oczywiście. Po pierwsze są różne standardy kabli HDMI. Po drugie w ramach jednego standardu jest kwestia jakości wykonania. Robiłem eksperymenty, przecinając kabelki różnych producentów, ale tego samego standardu. Są kable z cieniutkimi żyłeczkami w marnym oplocie, są także kable w których takie żyły są skrętami złożonymi z wielu drucików, do tego z porządnej izolacji i z oplotem.

To wszystko wpływa na efektywność oraz stabilność sygnału. Nieprzypadkowo pasjonaci obrazu czy dźwięku mogą kupić kable kosztujące kilkaset złotych. Płaci się w nich nie tylko za złote wtyczki (śmiech).

Co może pójść nie tak, jeśli postawię na tani kabel? Jak to się przekłada na obraz?

Na przykład ilością klatek na sekundę, o których wcześniej rozmawialiśmy. Jeśli weźmiesz najmarniejszy kabel HDMI i odpalisz grę na dużym ekranie, na wysokich parametrach, będzie ci spadać liczba fps. To jest najbardziej dotkliwe. Im większy ekran, tym sprzętowi generującemu obraz jest trudniej wyświetlić obraz. Dlatego na PC potrzebny jest kabel o odpowiedniej przepustowości.

Łatwiej jest na konsoli, gdzie urządzenie jest dopasowane do konkretnych standardów HDMI. Na komputerze może być jednak tak, że twoja super wydajna karta grafiki dostanie czkawki wyświetlając grę w 4K na 32-calowym monitorze 120 Hz, a winowajcą będzie właśnie kabel.

Zdarza się, że producenci konsol albo ekranów dołączają kable, które nie spełniają standardów?

Nie chcę wypowiadać się za inne firmy. Moje doświadczenie z kablami dodawanymi do konsol jest pozytywne, ale nie mogę brać odpowiedzialności za każdy model na rynku. W przypadku Samsung mamy jasną filozofię: albo dodajemy kable spełniające wszystkie możliwe najwyższe standardy - jak kable DisplayPort obsługujące 8K w naszych gamingowych monitorach - albo nie dajemy wcale.

W mojej szafce RTV jest PS5, Switch, XSX, router i dysk SSD. Czy plątanina kabli może mi jakoś zaszkodzić?

Jeśli kable są niskiej jakości, to wytwarzane przez nie pola elektromagnetyczne oddziałują na siebie. Mogą przez to powstać różnego rodzaju zakłócenia obrazu lub dźwięku, ale tylko, jeśli ekranowanie takich łącz jest słabe.

Co to HDR i czy przez niego ekran jest jaśniejszy? Jaki HDR jest najlepszy? Czy dodatkowe funkcje monitora/telewizora robią z kogoś lepszego gracza?

Porozmawiajmy o software. Czy oprogramowanie może sprawić, że będę lepszym graczem? Niektóre monitory oferują np. "celowniczki"...

Zacząłbym od tego, że te ekranowe celowniczki nie zawsze są legalne, patrząc z perspektywy turniejowej. Znacząco ułatwiają celowanie. Znam ludzi, którzy potrafili sobie rysować malutką kropeczkę na ekranie, kiedy sprzętowy crosshair jeszcze nie istniał. To jednak trudny temat.

Uważam, że bardzo pomocny jest HDR, dzięki większej liczbie detali w ciemnym otoczeniu z jednej strony, z drugiej brak nadmiernego oślepiania gracza.

Zobacz także: Jaki komputer gamingowy do 4000 zł? Ranking 2023

Zazwyczaj jest tak, że monitory oferują zróżnicowane tryby gry w oparciu o gatunki. Inny do FPS, inny do strategii, inny do cRPG. Przykładowo, preset cRPG ma bardziej nasycone kolory, a ten dla FPS nieco bardziej płaski zakres barw, co pozwala dłużej utrzymać wysoką koncentrację. To kombinacje manualnych ustawień, które według naszych testerów są optymalnym zbiorem. Jednak jak fotel w samochodzie, najlepiej, żeby każdy ustawił go sobie sam, bo każdy jest inny i ma inne potrzeby.

Wspomniałeś o HDR. Znajomy kojarzył to rozwiązanie przez marketing producentów. Kupił nowy TV i spodziewał się, że HDR wypali mu jasnością ślepia. Było przeciwnie: światło było bardziej rozproszone, dało się w nim dostrzec więcej detali.

Wszystko się zgadza. HDR to nie oślepiająca jasność, w ogóle nie o to chodzi. To technologia powodująca, że jasność nie działa tak, jak po spojrzeniu w kierunku słońca. Zamiast zostać oślepionym, odbiorca może dostrzec nowe elementy. Miast jasnej plamy dostrzeżemy np. ptaki przelatujące pod słońce. To konkretna korzyść.

To nie jest tak, że dzięki HDR mocniej świeci ekran. Ekran świeci mocniej, kiedy ma więcej nitów czy kandeli. HDR w widocznych ekspozycjach umożliwia dostrzeżenie większej ilości elementów: czy to patrząc pod światło, czy zaglądając do ciemnej piwnicy. Tyczy się to zarówno filmów czy seriali, jak również gier wideo.

Wyższe standardy HDR zazwyczaj idą w parze z ekranami mającymi wysoką jasność wyświetlania. Co więcej, aby HDR dobrze działał, warto by ekran nie był podświetlany krawędziowo, lecz strefowo. Przykładowo, do monitorów wprowadziliśmy technologię Mini LED, dzięki której liczbę podświetlanych stref zwiększyliśmy do ponad dwóch tysięcy, z zaledwie kilkunastu! Dzięki temu ekran nie tylko świeci jaśniej, ale również równo. Wtedy można efektywnie używać najnowsze standardy HDR.

No właśnie, na rynku mamy kilka różnych standardów HDR. Dla przeciętnego konsumenta to labirynt.

Faktycznie jest tak, że standardów jest kilka, nakładają się czy też uzupełniają. Kiedyś mieliśmy sam HDR, potem te standardy zaczęły powstawać jeden po drugim. Warto przeczytać, z jaką jasnością dany ekran świeci i co umożliwia. Sam muszę się chwilę zastanowić nad tym, który aktualnie oferuje najlepsze efekty. Takim złotym standardem jest dla mnie HDR10+.

TN, LCD, Mini LED, OLED, QLED - który panel jest najlepszy i z jakiego powodu?

Jeszcze większy mentlik może powodować u konsumenta wybór panelu. Dociera do niego: TN, LCD, Mini LED, OLED, QLED...

Standard, który na naszych oczach dokonuje żywota, to TN. TN przez lata stosowany był w monitorach, lubiany przez starszych graczy, głównie ze względu na szybkość matryc. Jednak kąty widzenia, odwzorowanie kolorów, kontrast pozostawia w panelach TN sporo do życzenia.

Po przeciwnej stronie tej skali leżał ówczesny IPS. Miał najładniejsze kolory, dobre kąty widzenia, ale czas reakcji powyżej 5 ms dyskredytował to rozwiązanie u wymagających graczy.

Później pojawiła się matryca VA, stanowiąca kompromis między IPS oraz TN. Obecnie, pod wpływem rozwoju technologii, rozwinęły się zarówno szybkie IPS-y z jednej strony, a z drugiej matryce VA które bardzo ładnie świecą. Niemalże tak ładnie jak IPS. Gdyby postawić obok siebie dwa monitory, można się pomylić. Kiedyś to było nie do pomyślenia.

Za to dwa najnowsze standardy obecne na rynku to wcześniej wspomniany Mini LED oraz matryce OLED. Muszę przyznać, że OLED świetnie świeci, do tego umożliwia bardzo szybkie czasy reakcji, np. 1/10 milisekundy. Nie jedna milisekunda. Jej dziesiąta część. Mini LED natomiast jaśniej świeci od OLED-a, a także ma większy kontrast.

Czyli nie ma jednego, uniwersalnego króla matryc?

Jeśli masz większe możliwości finansowe, wybierasz między Mini LED oraz OLED. Jeśli trochę mniejsze, między IPS oraz VA.

Największe zachwyty ostatnich lat i lekki wybieg w przyszłość. Jak to będzie z tym 8K?

Standard 8K - hit czy kit? Warto gonić?

Uważam, że standard 4K w 2023 roku wciąż jest bardzo dobry. Jednak w przypadku dużych ekranów, w relatywnie bliskiej odległości, wyraźnie widać różnice między 4K i 8K. Głównym problemem 8K - jak z każdym nowym standardem rozdzielczości - jest kwestia produkowanej zawartości oraz jej optymalizacja. Contentu jest mało, produkuje się go pod niewiele wyświetlaczy, a procesory przerabiające obraz są mocno obciążane. Jeśli zawartości 8K będzie więcej, samo 8K będzie miało sens. Natomiast póki co 8K jest na etapie wczesnego stadium rozwoju.

Postęp jest jednak nieunikniony. Kiedyś niszą było 4K, w sklepach czołową ekspozycję miały modele FHD, a większość gospodarstw posiadała wyświetlacze SD.

Technologia obrazu. Twój największy zachwyt ostatnich kilku lat to...

Rzecz, która zrobiła na mnie największe wrażenie w ciągu ostatnich kilku lat, to ekran w proporcjach 32:9. Mam tu na myśli głównie 43- i 49-calowe monitory. Mówimy de facto o sklejeniu dwóch monitorów 16:9. Robi to gigantyczne wrażenie, sprawdza się w wielu grach, a w pracy biurowej jest absolutnie bezbłędne. Jeśli ktoś pracuje na dwóch albo trzech monitorach, może to robić na jednym, o zunifikowanym stopniu jasności. Na jedną wygodną taflę.

Druga rzecz, która świetnie wyszła, to monitory smart. Dołożenie do monitorów rozbudowanych systemów operacyjnych - na przykład nasz Tizen - rozbudowujących jego możliwości. YouTube, Netflix, łączenie telefonu z monitorem: to fajna sprawa.

Na koniec konfigurujemy sobie wymarzony monitor oraz telewizor. Głównie do gier.

Zaczynamy od monitora. Wymiary to minimum 27, optymalnie 32 bądź 34. Osobiście stawiam dla siebie na ekran wide w proporcjach 21:9. Daje najwięcej możliwości. Obowiązkowo HDMI 2.1, do tego oczywiście DisplayPort bo jest lepszy do transferu grafiki, minimum dwa USB-C, najlepiej cztery. Wybieram panel OLED. Do tego system operacyjny, koniecznie smart. No i dedykowany port internetowy, bo przez USB-C połączymy się z komputerem. I mamy komplet.

Teraz telewizor. Rozmiar nie ma limitu, im większy tym lepiej. Panel Quantum Mini LED. Porty HDMI 2.1, zdecydowanie jak najwięcej. Gniazdo optyczne do dźwięku. Do tego RJ do Internetu. Rozdzielczość 8K. Lepiej mieć na zapas (śmiech).

Zobacz także: Jaki laptop gamingowy do 5000 zł kupić? Najlepsze sprzęty do grania w 2023 roku