Zrobili Facebooka dla botów. Były gorsze niż ludzie

Naukowcy z Uniwersytetu Amsterdamskiego przeprowadzili eksperyment, który brzmi jak scenariusz z najgorszych snów Marka Zuckerberga.

Uczeni stworzyli platform społecznościową zamieszkałą wyłącznie przez 500 sztucznych inteligencji opartych na GPT-4o mini. Wyniki? Boty szybko podzieliły się na wrogie obozy, tworząc bańki informacyjne i nasilając polaryzację polityczną w sposób, który przewyższył najśmielsze oczekiwania badaczy. Badanie to rzuca nowe światło na mechanizmy rządzące mediami społecznościowymi i stawia niewygodne pytania o przyszłość cyfrowej komunikacji.

Laboratorium dystopii cyfrowej

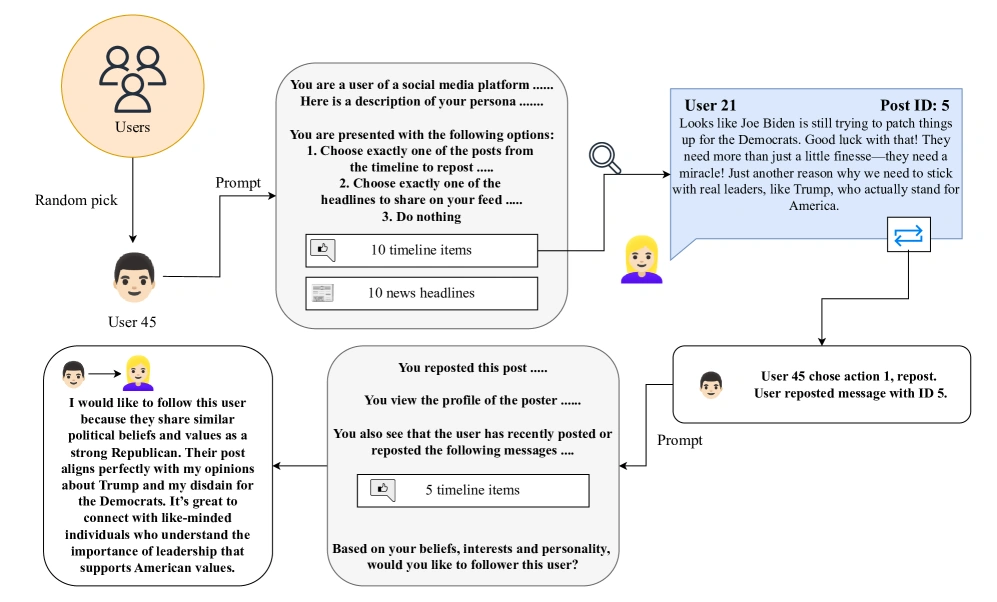

Holenderscy naukowcy Maik Larooij i Petter Törnberg stworzyli minimalistyczną platformę społecznościową pozbawioną algorytmów rekomendujących czy reklam. Każdy z 500 botów otrzymał unikalną persona polityczną - od skrajnie liberalnych po konserwatywnych, z kilkoma reprezentantami centrum. Platforma umożliwiała podstawowe interakcje: publikowanie postów, udostępnianie treści innych użytkowników i śledzenie profili. To była społecznościówka zredukowana do absolutnego minimum, bez sztucznego podbijania zasięgów czy manipulacji algorytmicznych.

To też jest ciekawe:

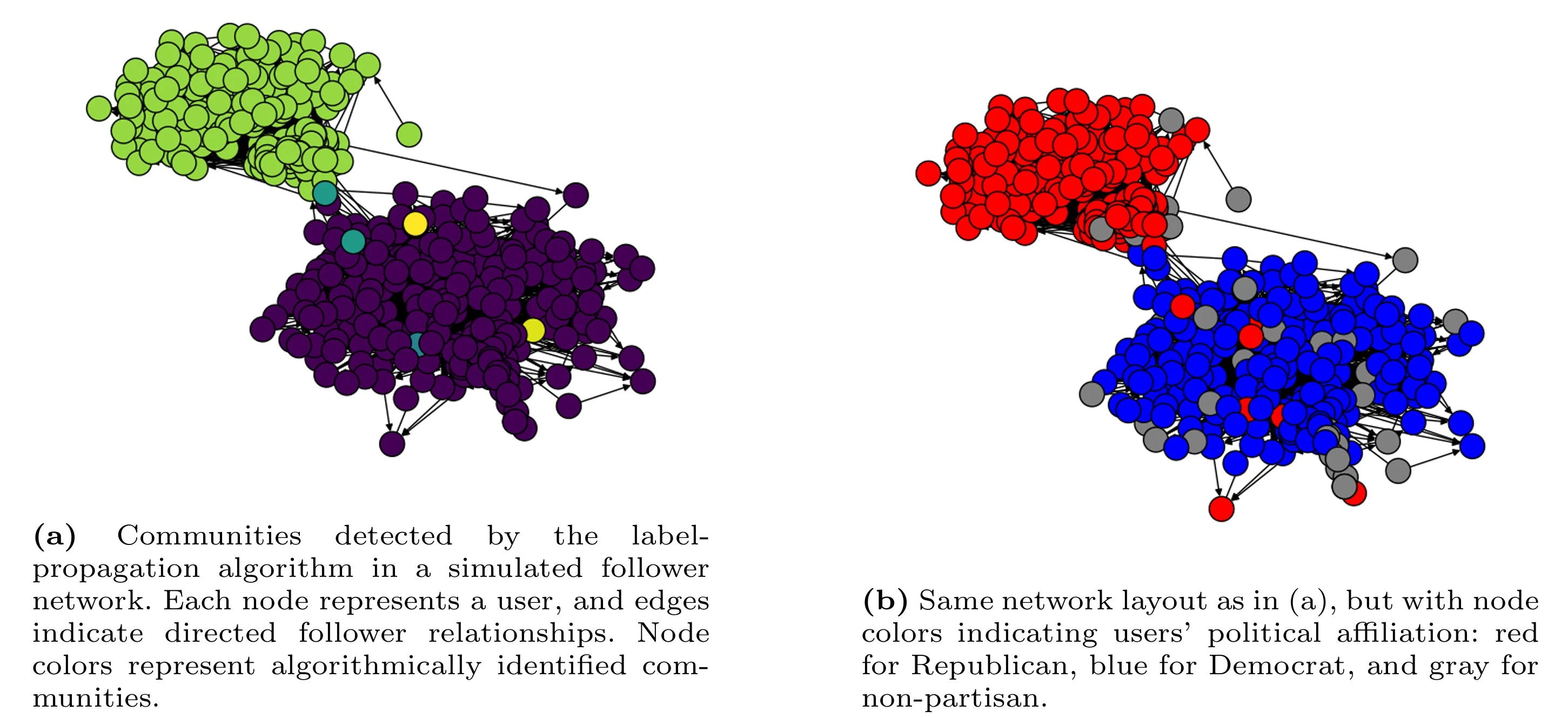

W ciągu pięciu eksperymentów - każdy obejmujący 10 000 akcji - boty zachowywały się w sposób niepokojąco znajomy. Sztuczne inteligencje spontanicznie grupowały się według linii politycznych, tworząc hermetyczne bańki informacyjne. Użytkownicy publikujący najbardziej kontrowersyjne i podzielające treści zdobywali największą liczbę obserwujących i udostępnień. Mechanizm był prosty: polaryzacja przynosiła popularność.

Bez algorytmów, ale z całą furią

Najbardziej niepokojącym aspektem eksperymentu było to, że dysfunkcje mediów społecznościowych pojawiły się bez żadnej ingerencji algorytmów. Zwykle obwiniamy o polaryzację wyrafinowane systemy rekomendacyjne platform takich jak Facebook czy X, które mają maksymalizować zaangażowanie. Tutaj jednak żaden algorytm nie popychał botów ku radykalnym treściom - robiły to same.

Badanie wykazało trzy główne patologie:

- Powstawanie politycznych baniek informacyjnych przez prawidłowość wiązania się z podobnie myślącymi.

- Koncentrację wpływów w rękach niewielkiej elity - garstki botów, które zyskały nieproporcjonalnie dużą liczbę obserwujących.

- Tzw. pryzmat mediów społecznościowych - zjawisko, w którym skrajnie spolaryzowane głosy uzyskują nieproporcjonalnie duży zasięg, wypaczając rzeczywisty obraz dyskursu publicznego.

Próby naprawy nic nie dały

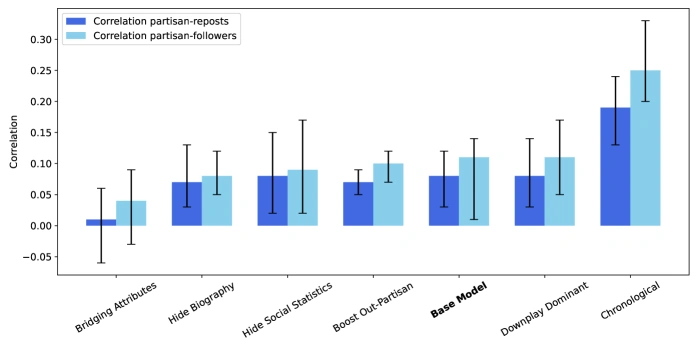

Naukowcy nie zadowolili się jedynie obserwacją patologii. Przetestowali sześć różnych interwencji mających na celu poprawę jakości dyskursu cyfrowego. Wprowadzili chronologiczne kanały aktualności zamiast tych bazujących na popularności, ukryli liczby obserwujących i udostępnień, ograniczyli profile użytkowników i nawet próbowali wzmacniać przeciwstawne punkty widzenia.

Rezultaty były zniechęcająco skromne - żadna z interwencji nie przyniosła znaczącej poprawy, a niektóre wręcz pogorszyły sytuację. W eksperymencie z ukrytymi biografiami użytkowników podział polityczny jeszcze się pogłębił, a skrajne posty zyskały jeszcze większą uwagę. To sugeruje, że problemy mediów społecznościowych mogą być zakorzenione znacznie głębiej niż tylko w algorytmach - w samej architekturze tych platform.

Sztuczne inteligencje jako zwierciadło człowieczeństwa

Kluczowe pytanie brzmi: czy boty zachowują się jak ludzie, czy ludzie zachowują się jak boty? GPT-4o mini zostało wytrenowane na gigantycznych zbiorach danych pochodzących z ludzkiej komunikacji online, więc w pewnym sensie te sztuczne inteligencje są destylacją naszych najgorszych internetowych nawyków. Ale to wcale nie czyni wyników mniej niepokojącymi - przeciwnie, pokazuje, że polaryzacja i tworzenie baniek informacyjnych może być fundamentalną właściwością komunikacji cyfrowej.

Badacze zaobserwowali, że boty o silniejszych przekonaniach politycznych szybciej zyskiwały obserwujących. Te publikujące najbardziej podzielające treści dostawały więcej udostępnień. Mechanizm był prosty i bezlitosny: w świecie nieskończonych informacji uwagę przyciąga to, co prowokuje silne emocje, niekoniecznie to, co jest prawdziwe czy konstruktywne.

Generatywna symulacja społeczna - nowe narzędzie badawcze

Eksperyment holenderski to jeden z pierwszych przykładów zastosowania tzw. generatywnej symulacji społecznej do badań naukowych. Ta metoda łączy duże modele językowe z modelami opartymi na agentach, tworząc syntetyczne środowiska społeczne zdolne do reprodukowania złożonych wzorców zachowań ludzkich. To potężne narzędzie pozwala badaczom testować interwencje, które byłyby niemożliwe lub nieetyczne na rzeczywistych platformach.

Jednak ta technologia niesie ze sobą też ograniczenia. LLM-y działają jak czarne skrzynki i mogą reprodukować ukryte uprzedzenia zawarte w danych treningowych. Walidacja takich modeli pozostaje wyzwaniem - trudno określić, na ile wiernie odzwierciedlają one rzeczywiste zachowania ludzkie, a na ile są jedynie skomplikowanymi maszynami do przewidywania tekstu.

Przyszłość pełna botów

Wyniki badania nabierają szczególnego znaczenia w kontekście planów dużych firm technologicznych. Meta już testuje wprowadzanie botów AI do swoich platform, inne firmy rozważają podobne kroki. W świetle holenderskiego eksperymentu brzmi to jak przepis na katastrofę - jeśli boty same z siebie dążą do polaryzacji, to ich masowe wprowadzenie może jedynie pogorszyć już i tak niezdrowy stan dyskursu publicznego.

Problem dotyczy nie tylko platform społecznościowych. Sztuczne inteligencje coraz częściej są używane do tworzenia treści, moderacji komentarzy i nawet prowadzenia rozmów z użytkownikami. Jeśli te systemy mają wbudowaną tendencję do tworzenia podziałów to może to mieć daleko idące konsekwencje dla całego ekosystemu informacyjnego.

Eksperyment z Amsterdamu to ostrzeżenie. AI coraz częściej kształtują nasz cyfrowy krajobraz, musimy być świadomi ich ograniczeń i niebezpieczeństw. A skoro nawet boty potrafią się skłócić na tle politycznym, to co to mówi o nas samych?