Nowe narzędzie powie ci, czy obrazek jest fejkiem. Pracę utrudnią mu ludzie

OpenAI po raz kolejny podchodzi do problemu stworzenia systemu, który poprawnie identyfikuje i pozwala rozróżniać twory sztucznej inteligencji od dzieł człowieka. Tym razem podejście ma aż dwa wymiary, bo oprócz klasyfikatora, OpenAI pochwaliło się przystąpieniem do komitetu C2PA.

Po półtora roku królowania sztucznej inteligencji w świecie technologii (i nie tylko), część osób nawet bez uprzednich instrukcji potrafi rozróżnić obraz wygenerowany przez generatywną AI od tworu ludzkiego. Zdradzają je choćby zbyt gładkie jak na fotografię linie, zbyt wiele okien w jednym budynku, więcej niż pięć palców, zdeformowane uszy czy krzywy tekst.

Jednak i my nie jesteśmy nieomylni, zwłaszcza wobec modeli, które z miesiąca na miesiąc stają się coraz lepsze i uczą się, jak wygląda rzeczywistość. Tu na pomoc przychodzi samo OpenAI.

OpenAI chce walczyć z fejkami zalewającymi internet

7 maja OpenAI poinformowało o staniu się członkiem komitetu C2PA - Koalicji na rzecz Poświadczenia i Autentyczności Treści. C2PA organ normalizujący, który opracowuje i nadzoruje standard certyfikacji treści cyfrowych C2PA. Jest to szeroko stosowany standard certyfikacji treści cyfrowych - przyjęty przez wiele podmiotów, w tym firmy programistyczne, producentów kamer i platformy internetowe. Głównym zastosowaniem technologii C2PA jest dokumentowanie i udowadnianie pochodzenia treści, np. poprzez zastosowanie technologii C2PA w aparatach - zdjęcia nimi wykonane będą zawierać niepodważalną informację o byciu wykonanymi przez konkretny model aparatu i informacje o jakichkolwiek manipulacjach związanych z obrazem. Członkami komitetu już dotychczas były koncerny takie jak Adobe, Intel, Microsoft, Sony czy Google.

Jak informuje OpenAI, jeszcze przed ogłoszeniem swojego członkostwa, firma zaczęła dodawać metadane C2PA w obrazach wygenerowanych przez DALL-E 3 - wygenerowanych zarówno przez ChatGPT, jak i OpenAI API. C2PA pojawi się także w modelu Sora, gdy ten zostanie oficjalnie oddany szerszemu gronu użytkowników.

Jednak strategia walki jest nadal dziurawa

Ludzie nadal mogą tworzyć wprowadzające w błąd treści bez tych metadanych (lub mogą je usunąć), ale nie mogą łatwo podrobić lub zmienić tych informacji, co czyni je ważnym narzędziem do budowania zaufania.

To jedynie pierwsza z dwóch nowości, które mają pozwolić na wykrywanie fejków. OpenAI ogłosiło udostępnienie klasyfikatora, dzięki któremu można sprawdzić, czy dany obraz został wygenerowany z użyciem DALL-E 3. Dostęp do klasyfikatora nie jest całkowicie otwarty i obecnie aplikować o dostęp do niego może jedynie "pierwsza grupa testerów": laboratoria badawcze i organizacje non-profit zajmujące się dziennikarstwem.

Naszym celem jest umożliwienie niezależnych badań, które ocenią skuteczność klasyfikatora, przeanalizują jego rzeczywiste zastosowanie, przedstawią istotne kwestie dotyczące takiego zastosowania i zbadają cechy treści generowanych przez sztuczną inteligencję.

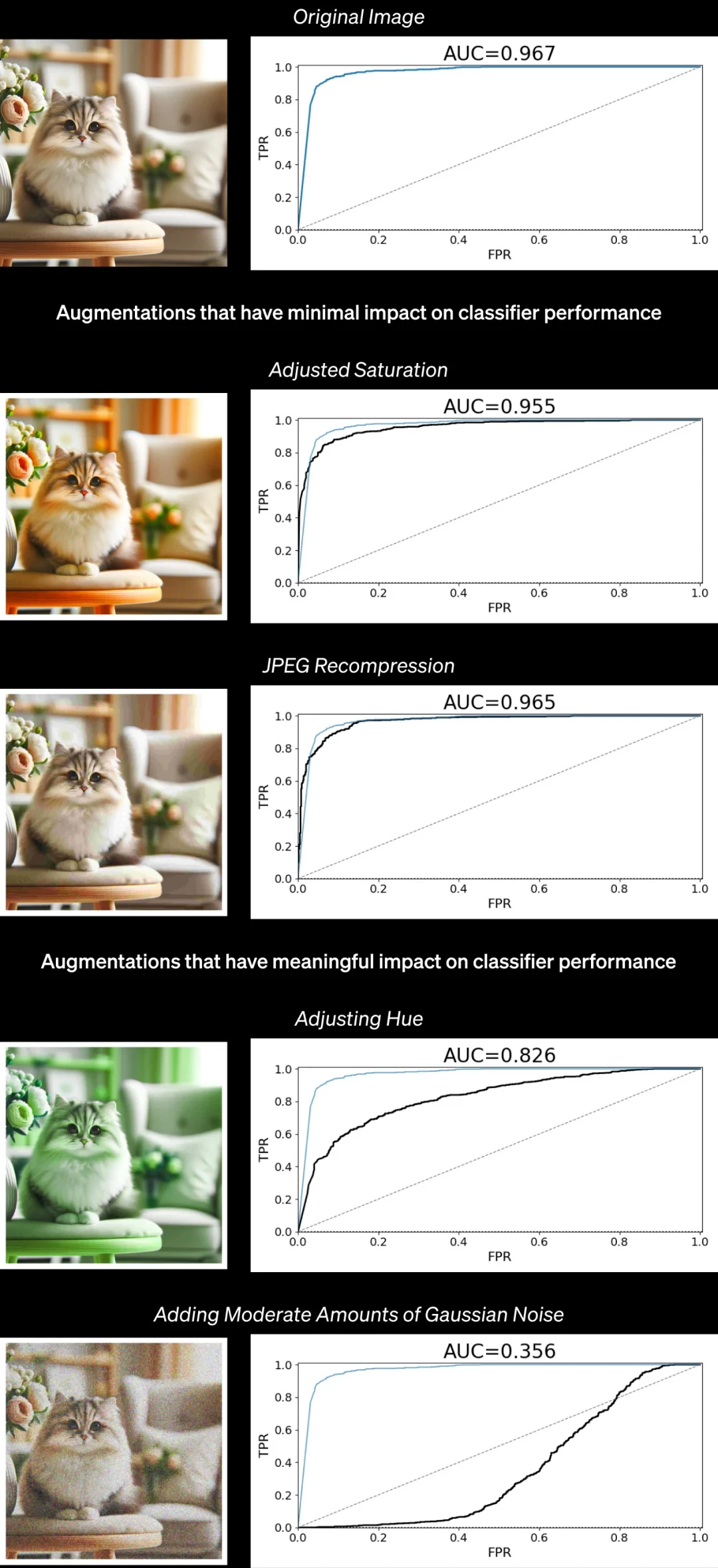

Jednocześnie OpenAI deklaruje aż 98 proc. skuteczność klasyfikatora w poprawnym identyfikowaniu tworów DALL-E 3, przy jednoczesnym błędnym oznaczaniu jedynie 0,5 proc. obrazów i zdjęć, które nie zostały wygenerowane przez sztuczną inteligencję.

Firma zastrzega jednak, że klasyfikator jest wrażliwy na ludzkie modyfikacje obrazu, które mogą przyczynić się do obniżenia skuteczności poprawnej oceny.

Klasyfikator radzi sobie z typowymi modyfikacjami, takimi jak kompresja, kadrowanie i zmiany nasycenia, przy minimalnym wpływie na jego wydajność. Inne modyfikacje mogą jednak obniżyć wydajność.

Więcej na temat OpenAI:

Zdjęcie główne: Domenico Fornas / Shutterstock