Jaka karta graficzna do AI? Ranking najlepszych grafik do sztucznej inteligencji

Jaka karta graficzna do sztucznej inteligencji? Oto ranking układów graficznych pokazujący ich wydajność w różnych modelach sieci neuronowych. Zobacz jak w obliczeniach związanych ze sztuczną inteligencją sprawdzają się konsumenckie i profesjonalne GPU, ale również CPU oraz NPU. Testujemy w benchmarkach Geekbench ML oraz UL Procyon - zarówno AI Computer Vision, jak i AI Image Generation (Stable Diffusion).

Uczenie maszynowe, deep learning i sieci neuronowe to ostatnio gorące tematy, które wymagają do obliczeń odpowiedniego sprzętu, a najlepiej kart graficznych. NVIDIA zarabia miliony na sprzedaży swoich kart specjalizowanych do obliczeń AI, ale i konsumenckie modele GeForce RTX dzięki rdzeniom Tensor również przodują w takich zastosowaniach.

Co się dzieje w obozie AMD? Specjalizowane układy AI są już dostępne w takich procesorach jak Ryzen 7040 czy też 8000G. Nowe Radeony 7000 mają również rdzenie odpowiedzialne za AI, ale wciąż nie wydobyto z nich ich pełnego potencjału. Czerwoni zaprezentowali również swój zaawansowany akcelerator generatywnego AI, czyli Instinct MI300X i gotowa jest również otwarta platforma programistyczna do AI, którą firma AMD udostępnia w ramach ekosystemu AMD ROCm. Niedawno AMD przejęła również eksperta w dziedzinie otwartego programowania AI, czyli firmę Nod.ai. Trzymamy kciuki za dogonienie konkurencji.

Z kolei Intel wprowadził na rynek pierwsze procesory z dedykowanym układem NPU - przedstawiciel Meteor Lake (Core Ultra) znalazł się już w naszym porównaniu.

Jaka karta do sztucznej inteligencji - NVIDIA GeForce kontra AMD Radeon

Ile karta graficzna do modeli neuronowych powinna mieć pamięci? Obliczenia AI często wymagają dużej ilości pamięci graficznej (VRAM) - przyjmuje się, że 16 GB VRAM to dobra ilość na start, chociaż to zależy od zastosowania (nie wszystkie zadania związane z AI są tak pamięciożerne, np. modele NLP), a i 24 GB może zapełnić bez specjalnego wysiłku. Stąd też pomysły, by wykorzystać do obliczeń AI nawet zintegrowane grafiki AMD Radeon, bowiem można przypisać do nich 16 GB pamięci graficznej (pod warunkiem, że pozwala na to płyta główna). Nie omieszkaliśmy tego sprawdzić i wyniki zintegrowanej grafiki Radeon Vega 8 w procesorze Ryzen 7 5700G (jak i iGPU w procesorach AMD Phoenix i Intel Meteor Lake) możecie sprawdzić na poniższych wykresach.

Oczywiście wykorzystanie zintegrowanej grafiki do obliczeń AI to w zasadzie na ten moment tylko ciekawostka - i ciężko zapewnić, że taka budżetowa konfiguracja będzie działać poprawne w różnych zastosowaniach dotyczących sztucznej inteligencji - ale zestawy pamięci 2 x 16 GB DDR4 (dzięki którym można przypisać 16 GB VRAM do zintegrowanej grafiki Radeon) można kupić za nieco ponad 250 zł.

Najlepsze karty graficzne do AI - ranking

W testach wykorzystaliśmy benchmarki AI Geekbench ML oraz dzieło twórców 3D Marka, a konkretnie UL Procyon. Wśród testów znajdują się tam dwa mierzące wydajność kart graficznych i procesorów w zastosowaniach związanych ze sztuczną inteligencją. Na ten moment w testach znalazły się:

- ASUS TUF GeForce RTX 4090 (24 GB)

- ASUS ROG STRIX GeForce RTX 4080 Super (16 GB)

- Gainward GeForce RTX 4070 i 4070 Super (12 GB)

- ASUS ProArt GeForce RTX 4060 Ti (16 GB)

- Gainward GeForce RTX 4060 Ti Ghost (8 GB)

- Palit GeForce RTX 4060 Dual (8 GB)

- AMD Radeon Pro W7900 (48 GB)

- AMD Radeon Pro W7800 (32 GB)

- AMD Radeon RX 7900 XTX (24 GB)

- Sapphire Radeon RX 7900 GRE (16 GB)

- Sapphire Radeon RX 7800 XT Nitro+ (16 GB)

- Sapphire Radeon RX 7700 XT Pulse (12 GB)

- AMD Radeon RX 7600 (8 GB)

- Sapphire Radeon RX 6600 Pulse (8 GB)

- zintegrowane grafiki AMD Radeon Vega 8, Radeon 760M i 780M

- zintegrowana grafika Intel Arc (Core Ultra 7 155) - laptop

- procesory AMD Ryzen 5 8600G, Ryzen 7 8700G, Ryzen 7 7800X3D, Ryzen 7 5800X3D i Ryzen 7 5700G

- procesor Intel Core Ultra 7 155 - laptop

- NPU wbudowane Intel Core Ultra 7 155 - laptop

Testy wydajnościowe kart graficznych w zastosowaniach AI

Wybór karty graficznej powinien być podyktowany nie tylko wydajnością, ale przede wszystkim pojemnością pamięci VRAM. Można nieśmiało założyć, że 16 GB to rozsądne minimum, chociaż oczywiście w niektórych zastosowaniach i mniejsza ilość może wystarczyć - wszystko zależy od tego do jakich zadań zaprzęgniecie kartę i nie ma tu prostej odpowiedzi ile VRAM będzie odpowiednią wartością.

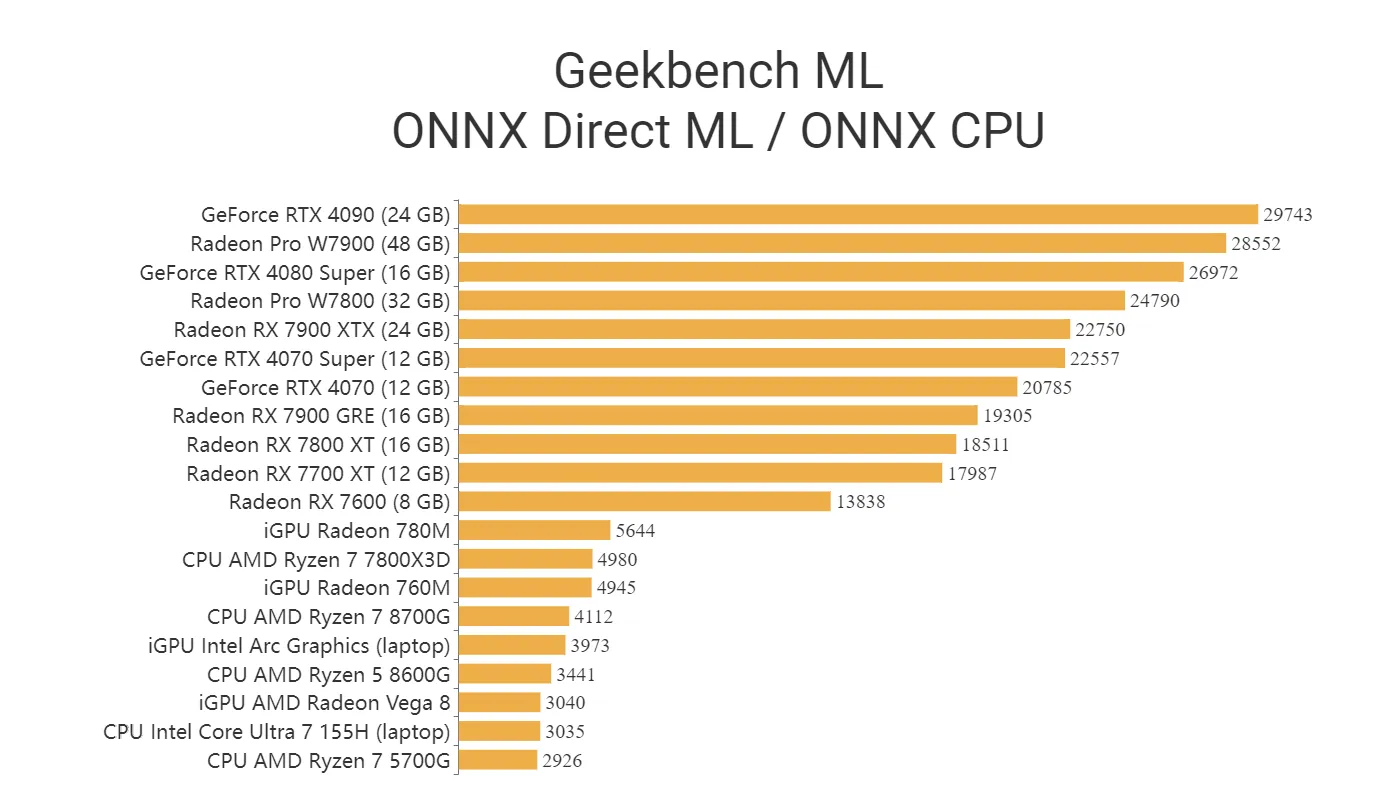

Testy wydajnościowe AI - Geekbench ML

Geekbench ML wykorzystuje testy uczenia maszynowego z zakresu rozpoznawania obrazu i przetwarzania języka. Oparte je na zadaniach używanych w rzeczywistych aplikacjach i z wykorzystaniem popularnych modeli AI. Benchmark Geekbench ML jest całkowicie darmowy.

Testy przeprowadzono w wykorzystaniem frameworka ONNX (Open Neural Network Exchange). W tym benchmarku karty Radeon odnotowują nieco gorsze wyniki od modeli GeForce - które są naprawdę mocnymi zawodnikami, jeśli chodzi o obliczenia związane z AI - ale nie ma jakichś dramatycznych różnic.

Wykorzystanie modeli Radeon Pro pozwala zbliżyć się do najwydajniejszych modeli GeForce RTX 4000 - no i są one wyposażone w naprawdę imponujące pojemności VRAM.

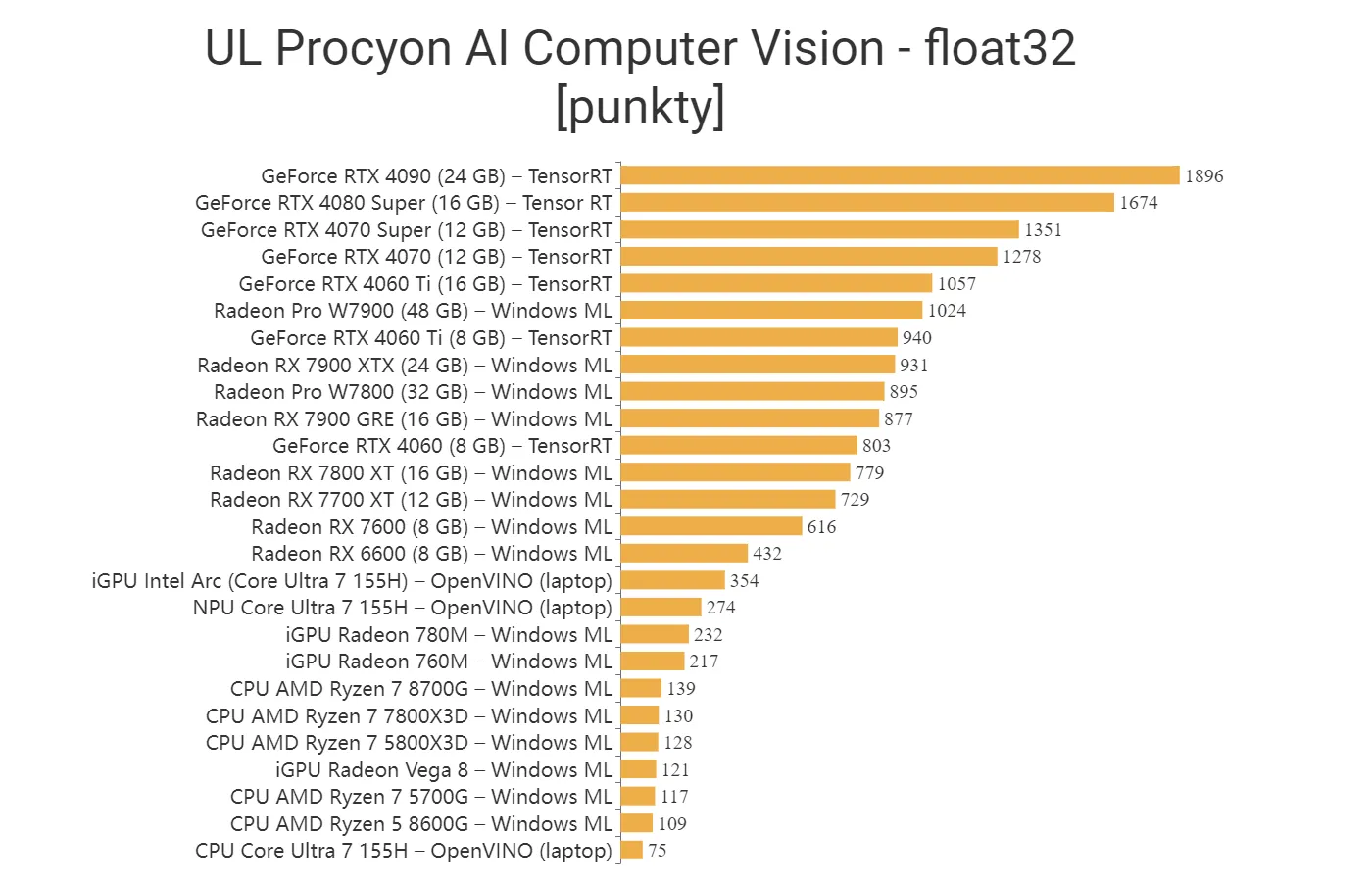

Testy wydajnościowe AI - UL Procyon AI Computer Vision (wcześniej AI Inference)

Sam benchmark Procyon AI Computer Vision (dawniej występował pod nazwą Inference) skonstruowany jest tak, żeby się uruchomić na praktycznie dowolnej karcie graficznej - nie zużywa dużo VRAM, więc daje nam pojęcie o możliwościach karty wyłącznie w kwestii wydajności.

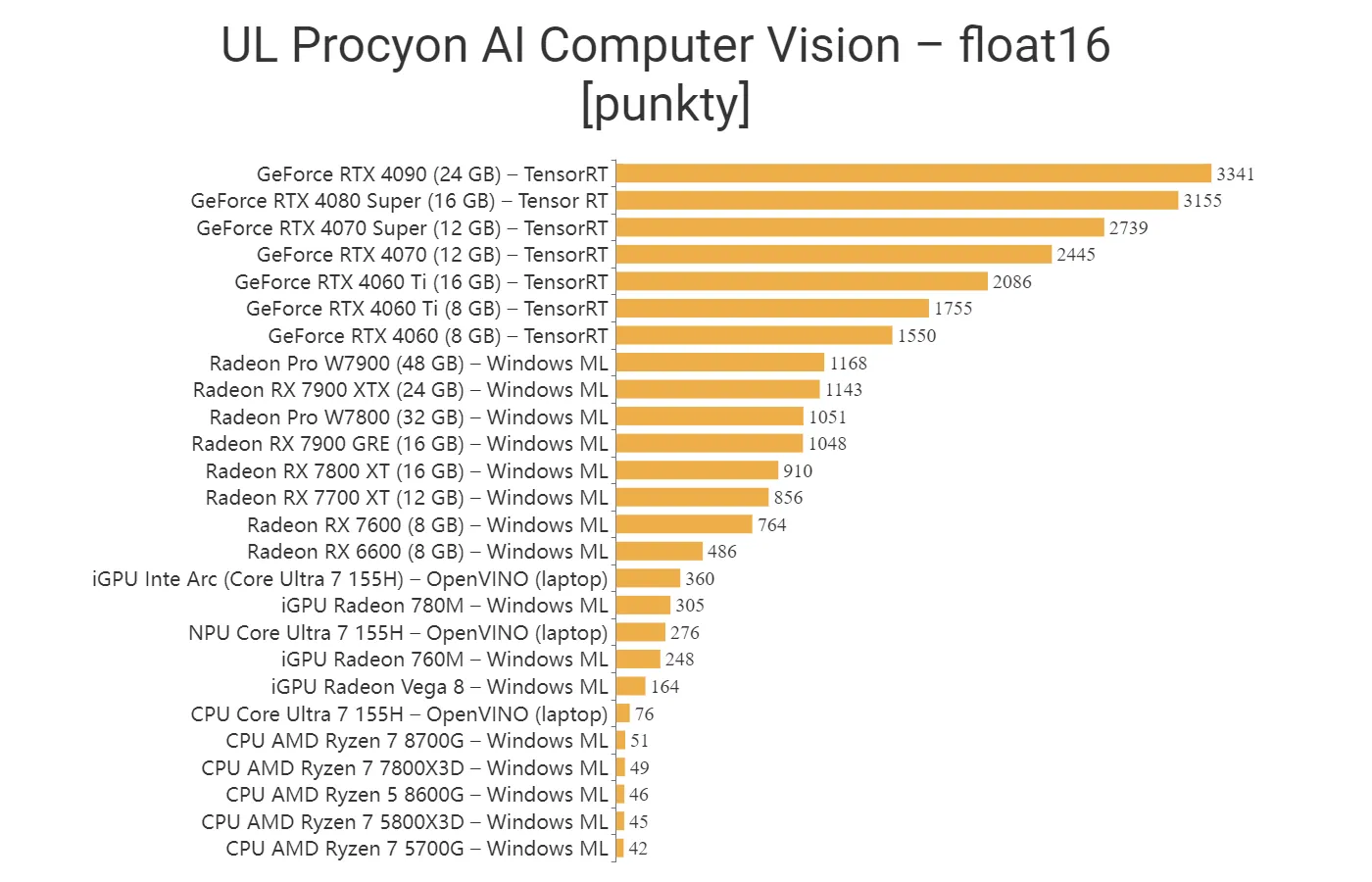

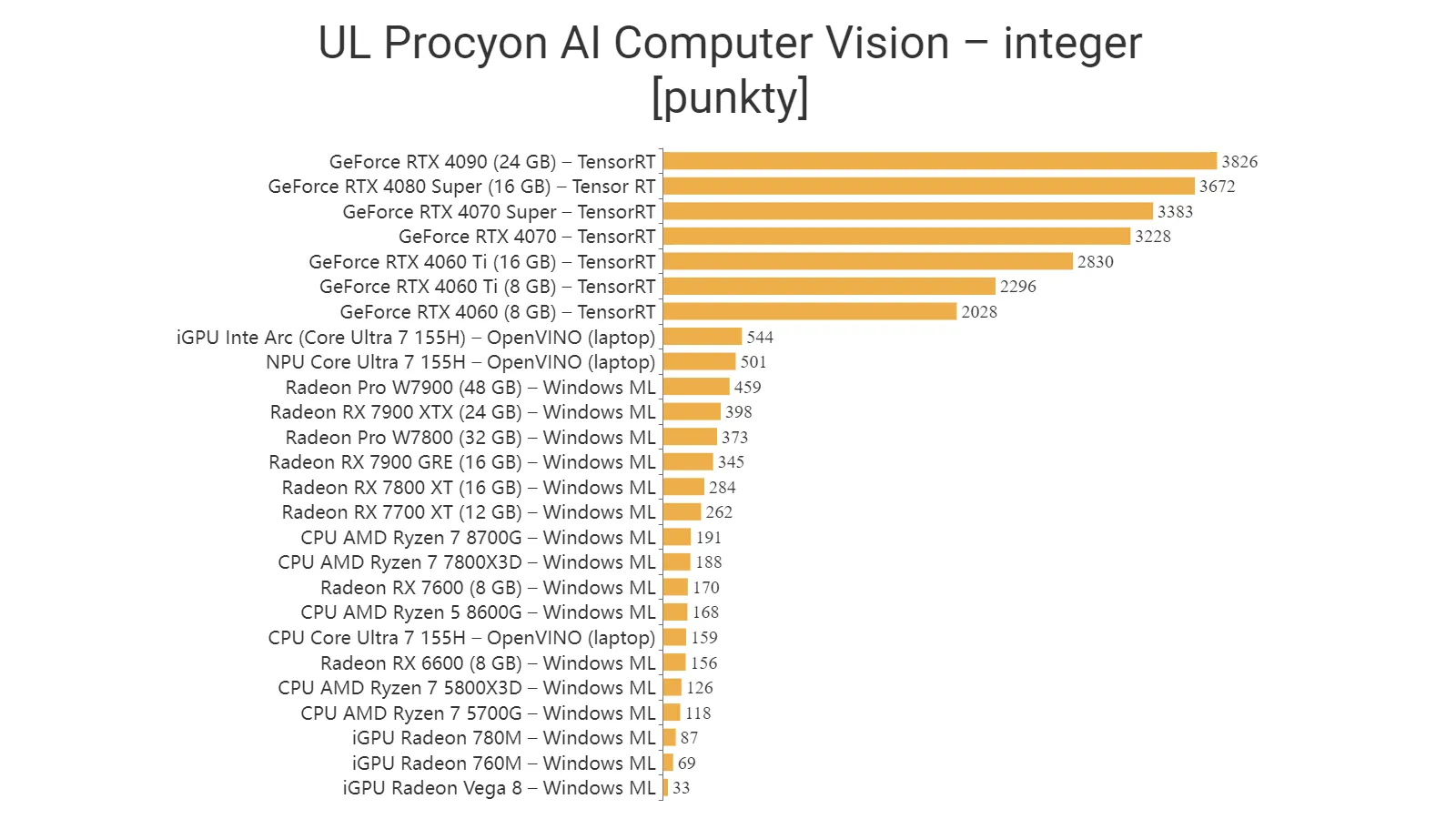

Benchmark UL Procyon potrafi wykorzystać zarówno Windows ML, rdzenie Tensor w kartach NVIDIA GeForce, specjalizowane układy Intela zgodne z OpenVINO (NPU - Neural Processing Unit), a nawet Qualcomm SNPE. Benchmark wykorzystuje następujące modele sieci neuronowych: MobileNet V3, Inception V4, YOLO V3, DeepLab V3, Real-ESRGAN i ResNet 50. Testy można przeprowadzać zarówno na liczbach zmiennoprzecinkowych (float 32 i 16), jak i całkowitych (integer).

Zobacz także: Stable Diffusion AI – jak zainstalować lokalnie i jak korzystać? Poradnik

W przypadku zestawienia ogólnego karty GeForce korzystają z najszybszego dostępnego rozwiązania, czyli Tensor RT. Do testów udało nam się włączyć procesor Intel Meteor Lake wyposażony w dedykowany układ NPU (do obliczeń AI). Sprawdziliśmy za pomocą OpenVINO wydajność zarówno CPU, zintegrowanej grafiki Intel Arc, jak i NPU.

GeForce RTX 4090 oczywiście rządzi w tym zestawieniu, ale jego zwycięstwo wcale nie jest takie miażdżące, jak można by się spodziewać - chociaż oczywiście 24 GB VRAM daje mu ogromną przewagę. Zgodnie z oczekiwaniami GeForce RTX 4060 Ti w wersji 16 GB VRAM jest przyzwoitą propozycją wejścia w świat AI dla osób zainteresowanych modelami sieci neuronowej - chociaż wciąż trudno nazwać cenę tych modeli jako atrakcyjną. W przypadku kart GeForce nie zaobserwowaliśmy żadnych różnic w wynikach przy użyciu sterowników GRD i SD.

Najwydajniejsze Radeony RX mają na pokładzie sporo pamięci VRAM (24 GB w modelu 7900 XTX i 20 w modelu 7900) i w porównaniu do topowych kart GeForce są dostępne w znacznie niższych cenach, ale jak na razie ich potencjał obliczeniowy w AI nie imponuje. Dopóki AMD nie włączy bardziej efektywnie do akcji rdzeni AI w tych kartach, to modele GeForce będą częściej wybierane do obliczeń przy użyciu sieci neuronowych.

Jako ciekawostkę warto zauważyć, że zintegrowana grafika Radeon Vega w teście float16 poradziła sobie prawie cztery razy lepiej od procesora - ale Radeon 780M musiał ulec Intel Arc, która pracowała pod kontrolą OpenVINO. Procesory Ryzen 8000G są wyposażone w NPU, ale na dziś dzień nie da się ich wykorzystać w testach Procyon. Nie ma większych różnic pomiędzy Ryzen 7 5700G, 5800X3D i 7800X3D (procesory te mają taką samą liczbę rdzeni) - większa pamięć cache nie daje żadnych korzyści w obliczeniach tego typu.

W testach wykorzystujących liczby całkowite karty GeForce mocno odjeżdżają - nawet Radeon RX 7900 XTX jest daleko. Czekamy aż AMD odkryje pełny potencjał rdzeni AI w kartach Radeon, a jak na razie karty GeForce osiągają tu znaczną przewagę.

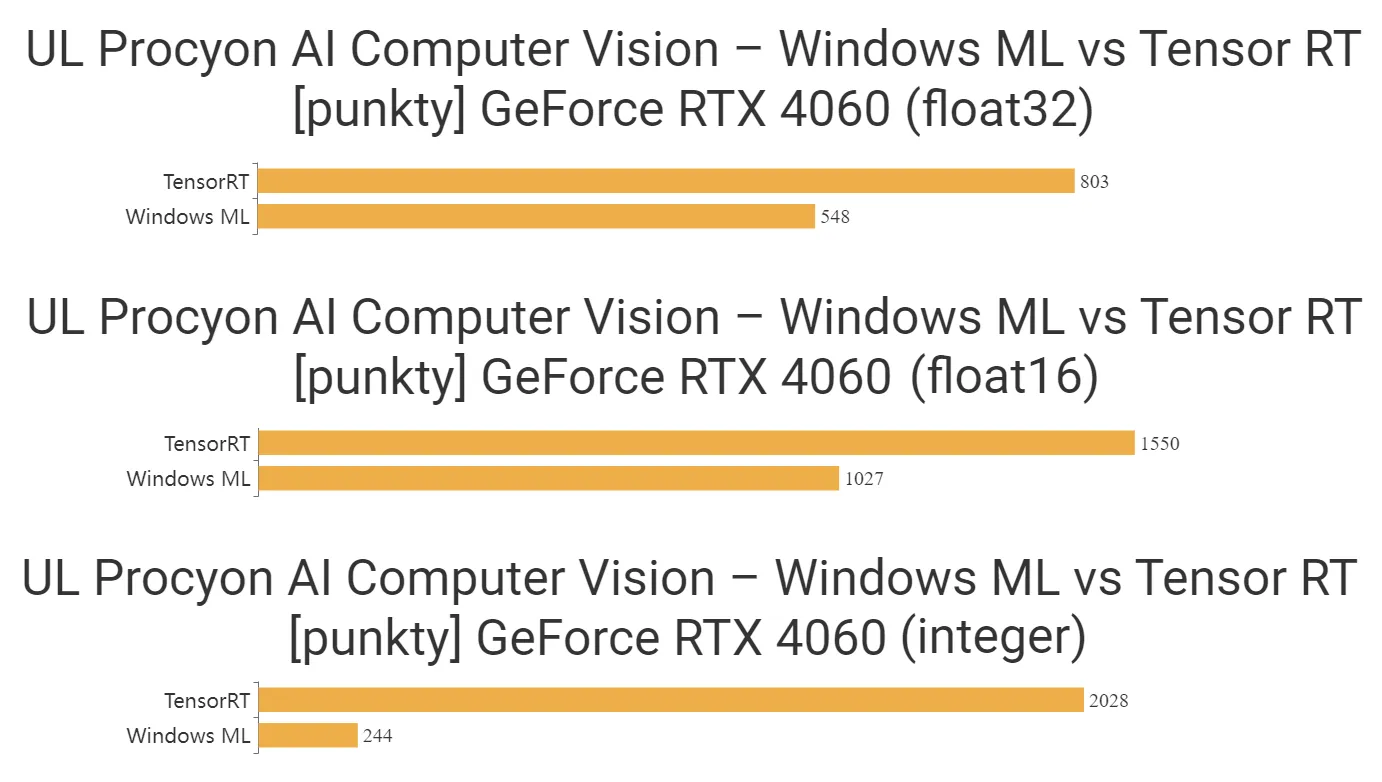

Oczywiście mając do dyspozycji kartę GeForce RTX z rdzeniami Tensor, nie ma sensu działać na oprogramowaniu, które ich nie wykorzystuje. W przypadku RTX 4060 wykonaliśmy jednak dodatkowe testy zarówno w Windows ML (Machine Learning), jak i Tensor RT, by sprawdzić jakiego przyśpieszenia możemy się spodziewać.

O ile testy za pomocą TensorRT przy liczbach zmiennoprzecinkowych dają po prostu spore przyśpieszenie w stosunku do Windows ML, to przy liczbach całkowitych jest one wręcz nieziemskie.

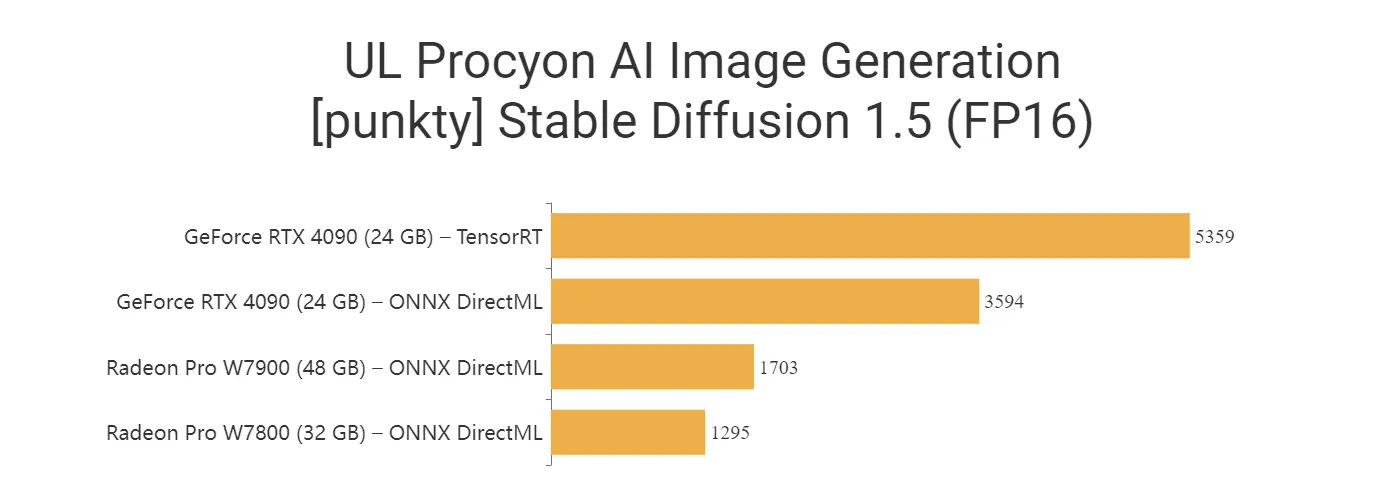

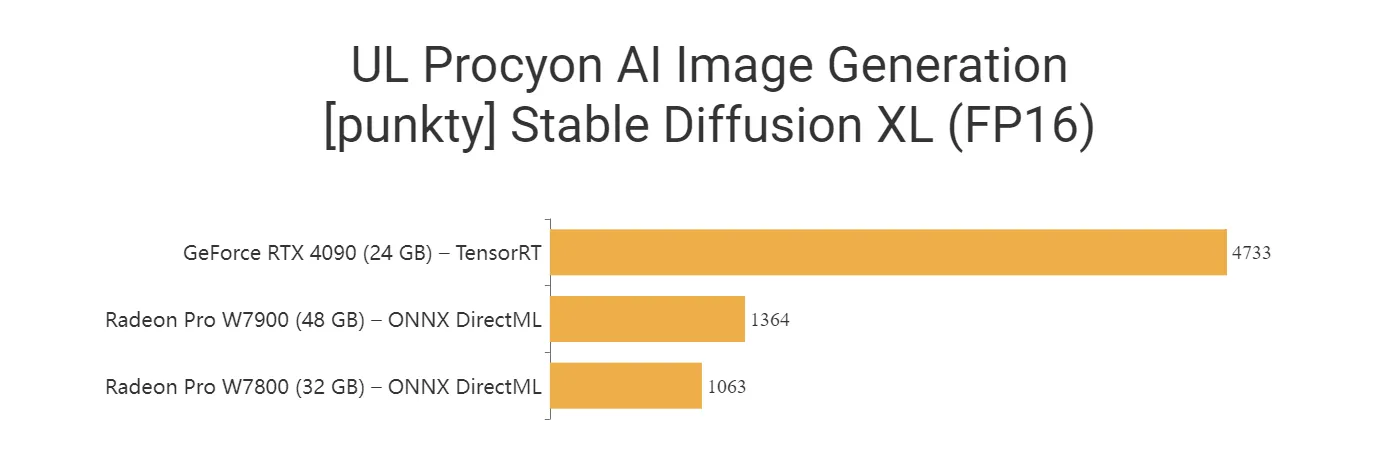

Testy wydajnościowe AI - UL Procyon AI Image Generation (Stable Diffusion)

W końcu doczekaliśmy się również testu wykorzystującego popularny model Stable Diffusion (zamiana tekstu na obraz). Dostępne są modele Stable Diffusion 1.5 (mniej wymagający) oraz Stable Diffusion XL (SDXL - bardziej wymagający).

Widać, że zastosowana tu implementacja solidnie premiuje karty GeForce (i to niezależnie od tego, czy wykorzystują rdzenie Tensor, czy pracują z użyciem ONNX), ale też trudno oczekiwać, aby twórcy benchmarka mogli brać pod uwagę kilka różnych dystrybucji (np. SHARK).

Porównanie wydajności kart graficznych i procesorów w uczeniu maszynowym

Geekbench ML i UL Procyon to pierwsze narzędzia, które umożliwiają szybkie (w przypadku pierwszego rozwiązania również darmowe) porównywanie osiągów kart graficznych, dedykowanych układów AI i procesorów CPU przy użyciu wielu różnych modeli sieci neuronowych. Wkrótce uzupełnimy tabele wyników o kolejne karty graficzne i procesory.

Czytaj też:

- Jak wyostrzyć zdjęcie? Na komputerze, telefonie, online, a najlepiej za pomocą AI

- Jak sprawdzić temperaturę karty graficznej gdy komputer grzeje się jak szalony?

- Karta graficzna do gier. Jaka karta gamingowa dla gracza?

- Najdroższa karta graficzna, czyli jaka? Zobacz ile kasy musiałbyś zebrać

- Najlepsza karta graficzna – ranking najnowszych układów graficznych 2024

- Karta graficzna do laptopa – ranking 2023. Jaką wybrać?