Microsoft bierze na siebie wszystkie pozwy za sztuczną inteligencję. "Nasza nie kradnie"

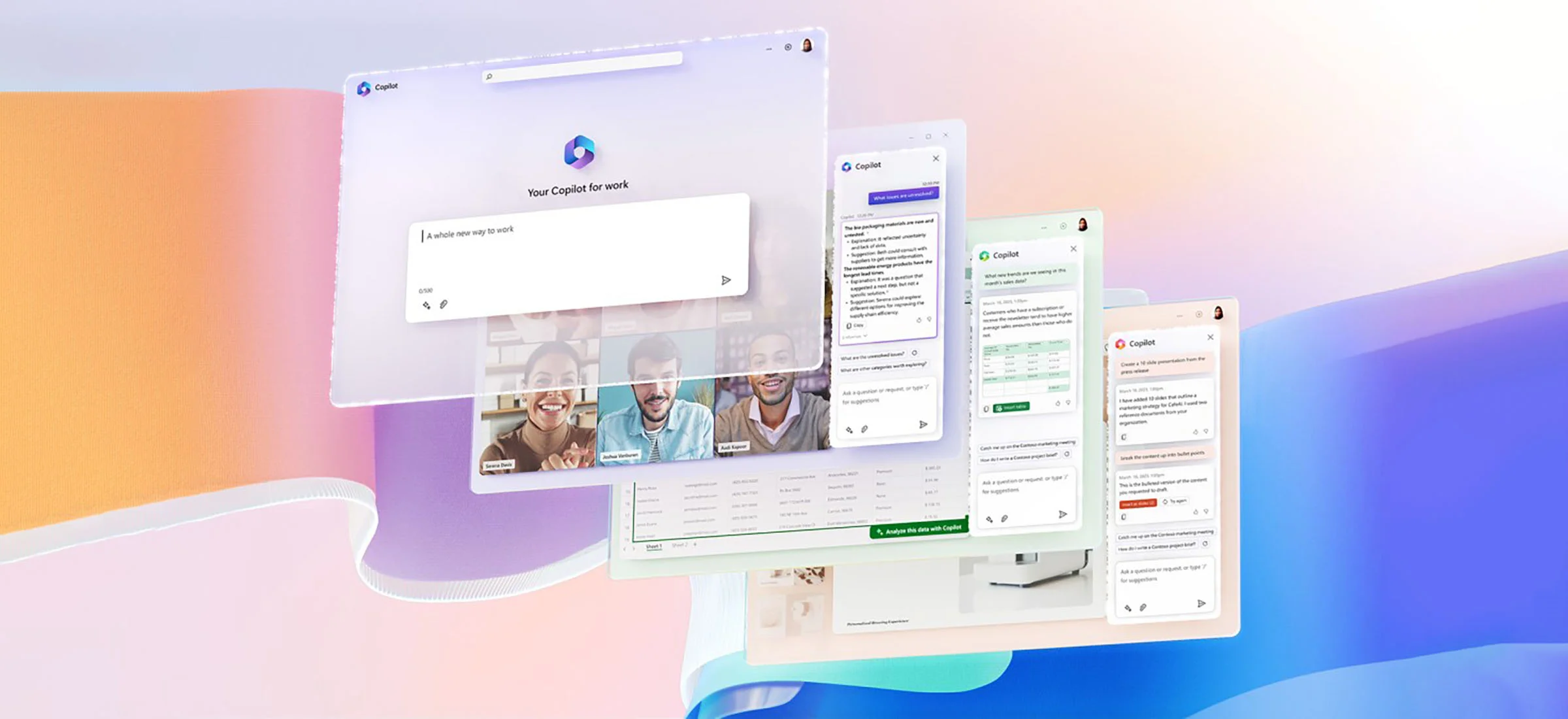

Już niedługo Microsoft 365 Copilot i Windows Copliot trafią do pierwszych klientów - zarówno indywidualnych, jak i firmowych. GAI Microsoftu właśnie zyskała kluczową przewagę nad konkurencją. Jest nią gwarancja bezpieczeństwa, w tym prawnego.

Przełom związany z upowszechnieniem się GAI (generatywnej sztucznej inteligencji) niesie za sobą wiele kontrowersji. Okazuje się bowiem, że podmioty prowadzące badania nad Dużymi Modelami Językowymi (LLM) - fundamentem działania GAI - mogły dopuścić się łamania etyki czy nawet prawa.

Chodzi o dane, jakie zostały wykorzystane do szkolenia tych mechanizmów, do których firmy takie, jak OpenAI, Google, Microsoft czy Meta mogły nie mieć praw.

To podwójny problem. Po pierwsze, jeżeli giganci IT faktycznie poszli na skróty i zaoszczędzili na badaniach, kradnąc cudze dane szkoleniowe, to samo to może oznaczać problemy prawne operatorów usług GAI i związane z tym zmiany w ich działaniu. Po drugie, GAI wyszkolona na nielegalnie pozyskanych danych teoretycznie może wygenerować treść chronioną prawnie, do której użytkownik GAI nie ma praw czy licencji.

Dla niektórych użytkowników indywidualnych te problemy są prawdopodobnie do zaakceptowania. Inaczej patrzą na to klienci firmowi, których działalność jest pilnie obserwowana, audytowana i nadzorowana przez rozmaite organy. Żadna poważna firma nie może generować danych i treści, do których nie ma praw. Dlatego żadna poważna firma nie będzie chciała wdrożyć mechanizmów GAI do swoich procesów informatycznych bez odpowiednich gwarancji. Takich, jakie właśnie zapewnił Microsoft.

Więcej o sztucznej inteligencji:

Microsoft 365 Copilot i Windows Copilot w pełni gotowe na pracę dla użytkownika indywidualnego, firmowego, rządowego czy posługującego się danymi wrażliwymi.

Microsoft rozesłał notę prasową do mediów, w której informuje o swoim nowym zobowiązaniu. Twierdzi w nim, że jego usługi GAI są wolne od jakichkolwiek spornych danych i daje na to pełną gwarancję. Na owej gwarancji jednak się nie kończy. By podkreślić bezpieczeństwo Copilotów, Microsoft zadeklarował, że każdy podmiot, który zostanie pozwany o naruszenie praw autorskich do danej treści w wyniku użycia GAI Microsoftu, może liczyć na bezpłatną pomoc działu prawnego Microsoftu i jego prawników. Firma też weźmie na siebie koszty sądowe, koszty obrony sądowej i zapewni wszelką inną potrzebną pomoc.

Od tego zobowiązania są wyjątki, na szczęście dość oczywiste. Oskarżony klient nie może wykorzystywać GAI Microsoftu do świadomego łamania praw autorskich. Jeżeli klient próbował coś ukraść przy pomocy Copilota i ów zamiar nie budzi żadnej wątpliwości, Microsoft nie udzieli pomocy takiej osobie. Podobnie jeśli w środowisku firmowym wyłączone zostaną stosowne filtry bezpieczeństwa (domyślnie włączone).

Dlaczego ochrona prawna Microsoftu jest tak ważna? Konkurencja ma problem.

Niektóre dane używane do szkolenia Dużych Modeli Językowych (LLM) mogą być objęte prawami autorskimi lub licencjami, które ograniczają ich wykorzystanie do celów komercyjnych lub badawczych. Na przykład, niektóre modele SI korzystają z artykułów naukowych, książek, wiadomości lub innych treści chronionych prawami autorskimi bez zgody autorów lub właścicieli praw. To może naruszać prawa własności intelektualnej i narażać twórców modeli SI na ryzyko pozwów sądowych.

Część danych używanych do szkolenia LLM może zawierać informacje osobiste lub wrażliwe, takie jak imiona, adresy, numery telefonów, adresy e-mail, historie medyczne lub preferencje polityczne. Te dane mogą być nieświadomie ujawnione przez modele SI, gdy generują tekst na podstawie danych wejściowych użytkowników. To może naruszać prywatność osób, których dane zostały wykorzystane do szkolenia modeli SI, i narazić je na ryzyko nadużycia lub dyskryminacji.

Niektóre dane używane do szkolenia LLM mogą być nieodpowiednie, obraźliwe, tendencyjne lub nieprawdziwe. Na przykład, niektóre modele SI korzystają z treści rasistowskich, seksistowskich, homofobicznych, nienawistnych lub fałszywych. Te dane mogą wpływać na jakość i wiarygodność tekstu generowanego przez modele SI i wprowadzać użytkowników w błąd lub krzywdzić.

Microsoft stara się zapewnić odpowiedzialne i etyczne stosowanie DMJ poprzez:

- Przestrzeganie zasad odpowiedzialnej SI: Microsoft opracował sześć zasad odpowiedzialnej SI, które mają na celu zapewnienie bezpieczeństwa, niezawodności, prywatności, przejrzystości i uczciwości modeli SI oraz poszanowania praw człowieka i wartości demokratycznych.

- Filtracja i moderacja treści: Microsoft stosuje mechanizmy filtracji i moderacji treści, aby wykrywać i eliminować szkodliwe użycie LLM, takie jak generowanie fałszywych informacji, obraźliwych treści lub naruszających prawa autorskie materiałów.

- Ochrona danych użytkowników: Microsoft zapewnia, że dane użytkowników nie są wykorzystywane do szkolenia LLM i że użytkownicy mają kontrolę nad swoimi danymi i ustawieniami prywatności. Microsoft stosuje również zabezpieczenia klasy korporacyjnej, takie jak uwierzytelnianie oparte na rolach i sieci prywatne, aby chronić dane przed nieuprawnionym dostępem lub ujawnieniem.

To prawdopodobnie są niewystarczające argumenty dla wielu użytkowników indywidualnych, do tej pory preferujących takie usługi, jak ChatGPT czy Google Bard. Dla klientów firmowych sytuacja wygląda zupełnie inaczej: Microsoft właśnie, pisząc kolokwialnie, pozamiatał. I konkurencji mieć w tej materii nie będzie - przynajmniej dopóki któryś z konkurentów zdecyduje się na podobne deklaracje.