„Nie rozumiemy, co się tutaj dzieje” - naukowiec szczerze o tym, jak działa sztuczna inteligencja

Zarówno entuzjaści AI, jak i naukowcy przyznają, że nasze ulubione modele generatywnej sztucznej inteligencji to nic innego jak zaawansowane narzędzia przewidywania tekstu. Mimo to nawet najpotężniejsze umysły tego świata rozkładają ręce: nie wiemy, jak działa AI, kontrolujemy ją metodą prób i błędów, a każdy koncern właściwie tworzy pudełko z niespodzianką, a nie inteligentny system.

Próbując okiełznać sztuczną inteligencję - wprowadzić ją w ramy życia społecznego i otoczyć dostosowanymi do niej normami prawnymi, dygnitarze Unii Europejskiej, Stanów Zjednoczonych, Wielkiej Brytanii oraz innych politycznych mocarstw spotykają się z twórcami popularnych obecnie modeli generatywnej AI. Bowiem by zrozumieć daną technologię, należy rozmawiać z jej twórcą, który w domyśle zna ją od podszewki i wytłumaczy co, gdzie, jak i po co.

Aczkolwiek to tylko teoria, bo jak przyznaje Sam Bowman, profesor na Uniwersytecie Nowojorskim i członek zespołu technicznego Anthropic, "jeśli otworzymy ChatGPT lub podobny system i zajrzymy do środka, zobaczymy miliony liczb zmieniających się kilkaset razy na sekundę i nie mamy pojęcia, co one oznaczają".

Czytaj również:

- Czy SI zabierze nam pracę? Bill Gates mówi, jak będzie

- Google Bard oficjalnie w Polsce. Sprawdzamy, jak wypada w porównaniu do ChatGPT, GPT-4 i Binga

- Prestiżowa uczelnia się ugięła i daje studentom czatbota. Zaskoczenie: tutaj bot zastąpi wykładowcę

Myślisz, że je rozumieją, ale w praktyce nie wiedzą nic. Nawet największe ośrodki badawcze mają związane ręce wobec AI

Sam Bowman był specjalnym gościem odcinka podcastu Unexplainable prowadzonego przez amerykański serwis Vox. Naukowiec uchylił rąbka tajemnicy co do tego jak działa - a właściwie tego jak bardzo naukowcy nie mają pojęcia, jak działa sztuczna inteligencja.

Praca nad dowolnym modelem sztucznej inteligencji rozpoczyna się od stworzenia sztucznej sieci neuronowej, czyli systemu komputerowego do pewnego stopnia wzorowanego na działaniu ludzkiego mózgu. Sieć neuronowa nie jest typowym programem komputerowym zaprojektowanym za pomocą tysięcy linijek kodu, a systemem, który na podstawie danych treningowych "uczy się" pewnych wzorców, i na podstawie tych wzorców generuje odpowiedzi - tekst, obrazy, dźwięk.

Jak wygląda trening AI? To właściwie szkolenie z autouzupełniania

Według naukowca sam trening jest właściwie szkoleniem z "autouzupełniania". Sztucznej inteligencji podaje się dane treningowe - w przypadku Bing AI, Barda i ChatGPT jest to tekst, który AI "czyta" słowo po słowie, a następnie na ich podstawie naukowcy proszą AI by ta odgadnęła kolejne słowa w tekście.

- Robi to z prawdopodobieństwem. Mówi: "Jest 20 procent szans, że to 'the', 20 procent szans, że to 'of'". A ponieważ wiemy, jakie słowo będzie następne, możemy powiedzieć, czy dobrze trafiła. Zajmuje to miesiące, miliony dolarów czasu komputerowego, a następnie otrzymujemy naprawdę wymyślne narzędzie autouzupełniania

Jednak na tym nie koniec, gdyż taka "czysta" sztuczna inteligencja miałaby tendencje do tworzenia szkodliwych, niewłaściwych czy po prostu błędnych treści. Tu do akcji wchodzi uczenie przez wzmacnianie, w którym dziesiątki, o ile nie setki ludzkich testerów rozmawia ze sztuczną inteligencją, oceniając każdą jej wypowiedź pozytywnie ("W porządku, uczyń całą tę odpowiedź bardziej prawdopodobną, ponieważ użytkownik ją polubił") lub negatywnie ("Uczyń całą tę odpowiedź mniej prawdopodobną, ponieważ użytkownik jej nie polubił").

Jak mówi Bowman, na tym jednak kończy się świadomość naukowców dotycząca tego jak działa AI, bowiem nie wiedzą oni, jak właściwie sieci neuronowe przyswajają, przetwarzają i postrzegają wzorce.

W nawiązaniu do swojej pracy naukowej opublikowanej w kwietniu bieżącego roku naukowiec opowiedział o dwóch dużych niewiadomych, których twórcy modeli generatywnej AI nie są w stanie wyjaśnić.

- Po pierwsze, tak naprawdę nie wiemy, co robią w jakimkolwiek głębszym sensie. Jeśli otworzymy ChatGPT lub podobny system i zajrzymy do środka, zobaczymy po prostu miliony liczb zmieniających się kilkaset razy na sekundę i po prostu nie mamy pojęcia, co one oznaczają. Poza niewielkimi wyjątkami nie możemy zajrzeć do środka tych rzeczy i powiedzieć: "Och, oto jakich koncepcji używa, oto jakich reguł rozumowania używa. Oto co robi, a czego nie pojmuje w żaden dogłębny sposób". Po prostu nie rozumiemy, co się tutaj dzieje. Zbudowaliśmy go, wytrenowaliśmy, ale nie wiemy, co robi

Drugim problemem - powiązanym bezpośrednio z pierwszym - jest brak możliwości kierowania działaniem danego modelu AI. Twórcy modeli generatywnej sztucznej inteligencji nie są w stanie kontrolować tego jak i co tworzy model. Mogą oni jedynie (poprzez uczenie przez wzmacnianie) nakierowywać AI na pożądane i niepożądane odpowiedzi, co Bowman opisał jako "niemal całkowita kontrola metodą prób i błędów".

Obie niewiadome są efektem samego sposobu, w jaki zaprojektowano generatywną sztuczną inteligencję. W przypadku programowania typowych programów komputerowych, takich jak choćby Microsoft Office czy nawet Deep Blue - programu, który wygrał z arcymistrzem szachowym Garri Kasparowem, wszystko jest opisane za pomocą linijek kodu, które opisują reakcję systemu na wprowadzenie informacji przez człowieka. W przypadku Microsoft Office będzie to choćby użycie skrótu klawiszowego czy zmiana czcionki, w przypadku Deep Blue posunięcie w grze.

W przypadku generatywnej AI nie ma możliwości zajrzenia w kod i przewidywania jak sztuczna sieć neuronowa zareaguje na dany prompt.

- Wszystko, co naprawdę możemy powiedzieć, to to, że istnieją dziesiątki pomniejszych liczb, które czasami idą w górę, a czasami w dół. Wszystkie razem wydają się robić coś związanego z językiem. Nie mamy odpowiednich koncepcji, które mapowałyby te neurony, aby naprawdę móc powiedzieć coś interesującego o tym, jak się zachowują

AI to pudełko z niespodzianką

Jest to dość paradoksalna sytuacja, w której twórcy nie są w stanie wytłumaczyć działania stworzonej przez siebie technologii. Według Bowmana jest ona efektem tego, że instytucje naukowe oraz koncerny tworzące AI nie budują systemu jako takiego, a jedynie dają komputerowi "zarys planu" i pozwalają sieci neuronowej rozwijać się samodzielnie.

- Myślę, że analogią może być tutaj próba wyhodowania ozdobnego topiary, ozdobnego żywopłotu, który próbujemy ukształtować. Sadzimy nasiona, wiemy, jaki kształt chcemy uzyskać i możemy wziąć nożyce i przyciąć je do tego kształtu. Nie oznacza to jednak, że rozumiemy cokolwiek z biologii owych roślin. Po prostu rozpoczynamy proces, pozwalamy mu się rozwijać, a na koniec próbujemy go nieco zmienić.

Biorąc to pod uwagę Bowman wyjaśnił, że niemożliwe jest wydanie przez daną firmę rozwijającą własną AI planu na najbliższej miesiące, ponieważ tempo i sposób rozwoju generatywnej sztucznej inteligencji jest nieprzewidywalny. Tak więc żadna firma nie jest w stanie z całym przekonaniem i szczerze powiedzieć: "W porządku, w przyszłym roku będziemy mogli zrobić to. A rok później będziemy w stanie zrobić to".

Naukowiec nawiązał także do sprawy modelu GPT-4, który krótko po zaprezentowaniu przez OpenAI mierzył się z ogromną falą krytyki przez nieścisłości w pracy naukowej opisującej jego działanie.

- Artykuł opisujący GPT-4 mówi o tym, że kiedy po raz pierwszy go wytrenowano, mógł on wykonać przyzwoitą pracę polegającą na przeprowadzeniu laika przez budowę laboratorium broni biologicznej. I zdecydowanie nie chcieli wdrażać tego jako produktu. Zbudowali go przez przypadek. A potem musieli spędzić miesiące na zastanawianiu się, jak to wyczyścić, jak poruszyć siecią neuronową, aby nie robiła tego, gdy wdrożyli ją w prawdziwym świecie.

To nie tylko niewiadome. Modele AI stają się zbyt duże, by je zrozumieć

Jak mówi amerykański profesor, sztuczna inteligencja to rozmowa o niewiadomych: niewiadomych tego jak działa sztuczna inteligencja, jak szybko się rozwija, jak ją kontrolować - społecznie i instytucjonalnie i tego czego możemy się spodziewać w ciągu najbliższego roku czy dwóch. Odpowiedź na te i inne pytania może dać zapożyczona z matematyki interpretowalność, czyli logiczne zrozumienie tego, w jaki sposób AI podejmuje decyzje. Jednak i to jest niczym szukanie igły w stogu siana, bowiem otwierając ludzką czaszkę, nie jesteśmy w stanie zobaczyć co myśli dana osoba. Na tej samej zasadzie ciężko jest przewidzieć działanie AI, która nie jest kierowana ludzką intuicją, a jedynie samodzielnie wytworzonymi wzorcami.

- Tak naprawdę nawet nie wiemy, czego szukamy. Inną kwestią jest to, że liczby stają się tutaj [przy rozwoju dużych modeli sztucznej inteligencji] naprawdę duże. W tych sieciach neuronowych istnieją setki miliardów połączeń. Więc nawet jeśli uda ci się znaleźć sposób na wpatrywanie się w kawałek sieci [neuronowej] przez kilka godzin, potrzebowalibyśmy, aby każda osoba na Ziemi wpatrywała się w tę sieć, aby wykonać całą pracę związaną z wyjaśnieniem jej działania

Czytaj również:

- Dramat aktorów. Hollywood chce zeskanować ich ciała, zapłacić grosze i nagrywać filmy bez ich udziału

- Samsung pracuje nad nową funkcją w smartfonach. Pracownikom zakazał z niej korzystać

- Zwolnił 90 procent pracowników i zastąpił ich chatbotem. Oto co się stało

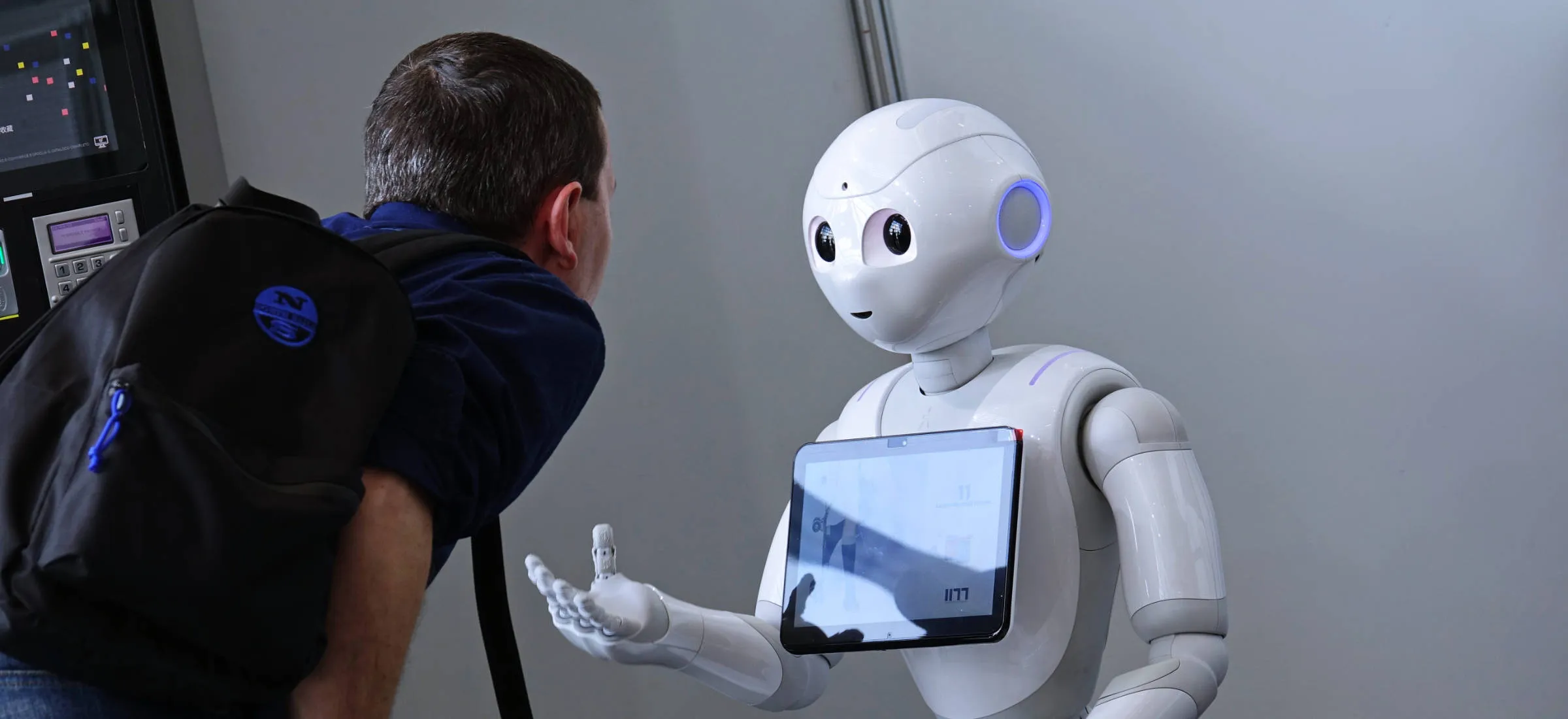

Zdjęcie główne: MikeDotta / Shutterstock