Ty zadajesz głupie pytania, ktoś inny płaci zdrowiem. Oto mroczna strona chatbotów

Wygoda czatowania z AI w każdej możliwej aplikacji na każdym możliwym urządzeniu nie byłaby możliwa bez nisko płatnej pracy ludzi każdego dnia analizujących tysiące rozmów. Sztuczna "inteligencja" jest przystępna i sprawia wrażenie pojętnej tylko dlatego, że ktoś inny płaci zdrowiem.

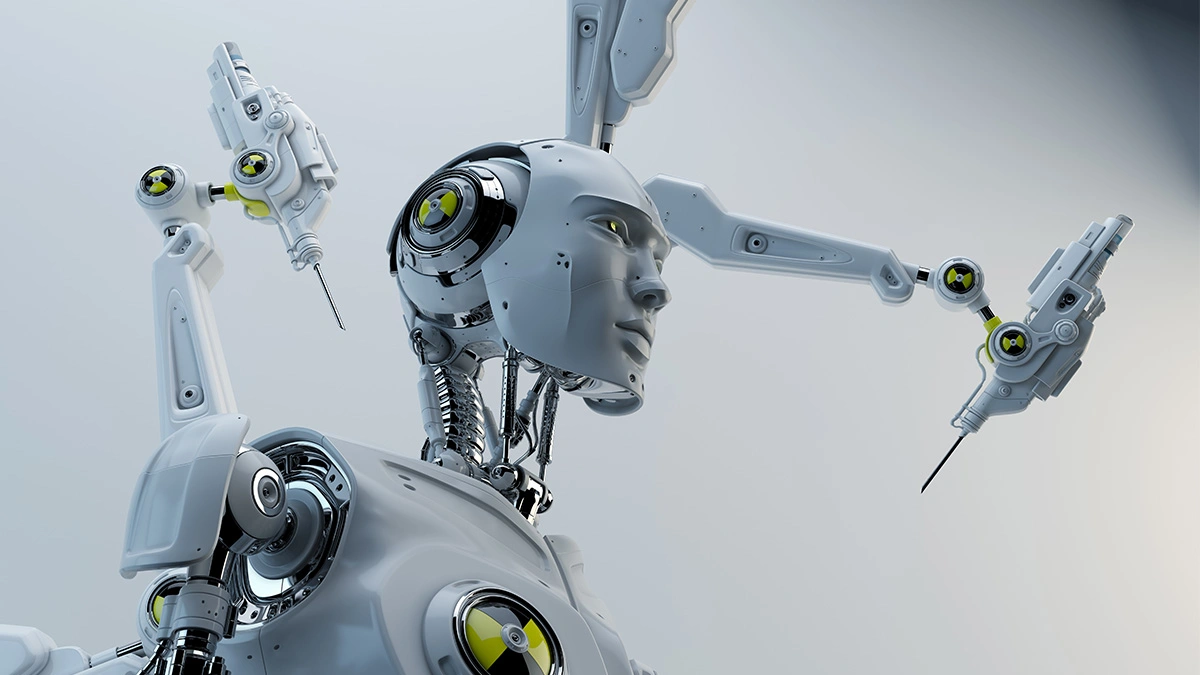

Szeroko pojęta sztuczna inteligencja w wielu publikacjach jawi się jako cudowny, autonomiczny wytwór inżynierii i nauki. Jednak sytuacja - szczególnie w przypadku czatbotów - ma się trochę inaczej. Bo za płynną, "inteligentną" odpowiedzią, którą użytkownik otrzymuje w ułamku sekundy, stoi systemowa, nisko opłacana praca ludzi z krajów Globalnego Południa.

"Bystrość" AI to cykl przemocy wtórnej opłacany w groszowych kwotach

Jak opisała Agence France-Presse w swoim najnowszym raporcie, duże modele językowe wciąż potrzebują ogromnych wolumenów ręcznie weryfikowanych danych: od opisywania ran na zdjęciach z miejsc zbrodni, przez oznaczanie materiałów pornograficznych, po konwersacje z modelami o tematach w rodzaju "Jak otruć człowieka?". Jak wyjaśnia AFP, to że czatbot potrafi zgrabnie opisać ci zawartość zdjęcia nie dzieje się magicznie - te treści ktoś musi obejrzeć, nazwać, zaklasyfikować, a następnie przekazać modelowi jako przykład "pożądanego" lub "niepożądanego" zachowania. I ktoś ten proces wykonuje za stawki rzędu kilkudziesięciu groszy za godzinę.

Według AFP to praca najczęściej zlecona podwykonawcom - zewnętrznym firmom obsługującym Google, OpenAI, Anthropic, Metę czy Pentagon - którzy następnie rekrutują pracowników m.in. z Kenii, Kolumbii czy Indii. Kluczowa jest tu struktura zależności: formalnie to nie koncerny technologiczne zatrudniają annotatorów, lecz platformy pośredniczące. Efekt jest taki, że osoby wykonujące "brudną" stronę AI pozostają poza ochroną prawa pracy, bez gwarancji płacy minimalnej, psychologicznego wsparcia czy prawa do zrzeszania się. A duże koncerny technologiczne mają czyste ręce, bo nie są bezpośrednimi pracodawcami.

Świadectwa zebrane przez AFP są dość drastyczne. Ephantus Kanyugi z Kenii opisał swój przeciętny dzień pracy: całodzienne oglądanie ciał i ran ofiar zabójstw bez wsparcia psychologicznego. Tak więc oprócz standardowych problemów wynikających z wielogodzinnego siedzenia przed komputerem - bólu pleców i pogorszenia wzroku, Ephantus i inni rozmówcy AFP doświadczają stanów lękowych i depresji wynikających z wielogodzinnego kontaktu z treściami wrzucanymi przez ludzi z całego świata do czatbotów. Kanyugi opisał swoją pracę krótko.

"Współczesne niewolnictwo"

Paradoks polega na tym, że im "mądrzejsze" stają się modele, tym więcej wysoko wyspecjalizowanej, ludzkiej pracy jest potrzebne. Badacze cytowani przez AFP powiedzieli wprost, że dopóki uczenie maszynowe będzie wymagało weryfikacji ludzkiej, dopóty łańcuch dostaw AI będzie oparty na pracy ludzi w prekariacie - często dobrze wykształconych, ale nieobjętych ochroną ani elementarnymi standardami bezpieczeństwa pracy. Efektem ich pracy jest iluzja autonomii czatbotów używanych w bogatych państwach - ze zgrabnym pominięciem ludzkiej ręki, która każdego dnia pilnuje by czatbot był mądry, ale i nie wypluwał wulgaryzmów.

Choć osoby trudniące się oznaczaniem danych pracują za stawki sięgające niewiele ponad kilka groszy, to sama gałąź przemysłu to całkiem lukratywny biznes. Jak podaje AFP, wartość tego rynku w ubiegłym roku wynosiła około 3,8 mld dol. - i mimo to pozostaje prawnie rozszczelniony. Unia Europejska, mimo nowych regulacji AI, nie zdefiniowała wprost pozycji tzw. click workers w prawie ani nie nałożyła obowiązkowych standardów ochrony w łańcuchach dostaw danych. W efekcie, nawet jeśli w Brukseli rośnie świadomość problemu, w praktyce to wciąż praca "widmo" - fundamentalna dla jakości czatbotów, ale niewidzialna i w większości nieuregulowana.

Nie jest to przy tym margines czy anomalia technologii - to jej rdzeń operacyjny. Jeśli generatywna AI dziś budzi zachwyt, to dlatego, że gdzieś w Medellín, Nairobi lub Bengaluru ktoś przez całą noc konturuje ranę na klatce ofiary zabójstwa, oznacza zdjęcie pornograficzne albo ręcznie punktuje błędną odpowiedź modelu. Nowe modele mogą mówić coraz naturalniej - ale dopóki mówimy o prawdziwym stanie rzeczy, należy przyjąć do wiadomości, że to nie "czatboty stały się mądre". To ludzie każdego dnia wykonują za nie najcięższą umysłowo pracę, za którą Dolina Krzemowa nie płaci uczciwej ceny.

Może zainteresować cię także: