AI Microsoftu ma wiele wspólnego z dr Ziębą, czyli dyplomowani medycy sprawdzili Copilota

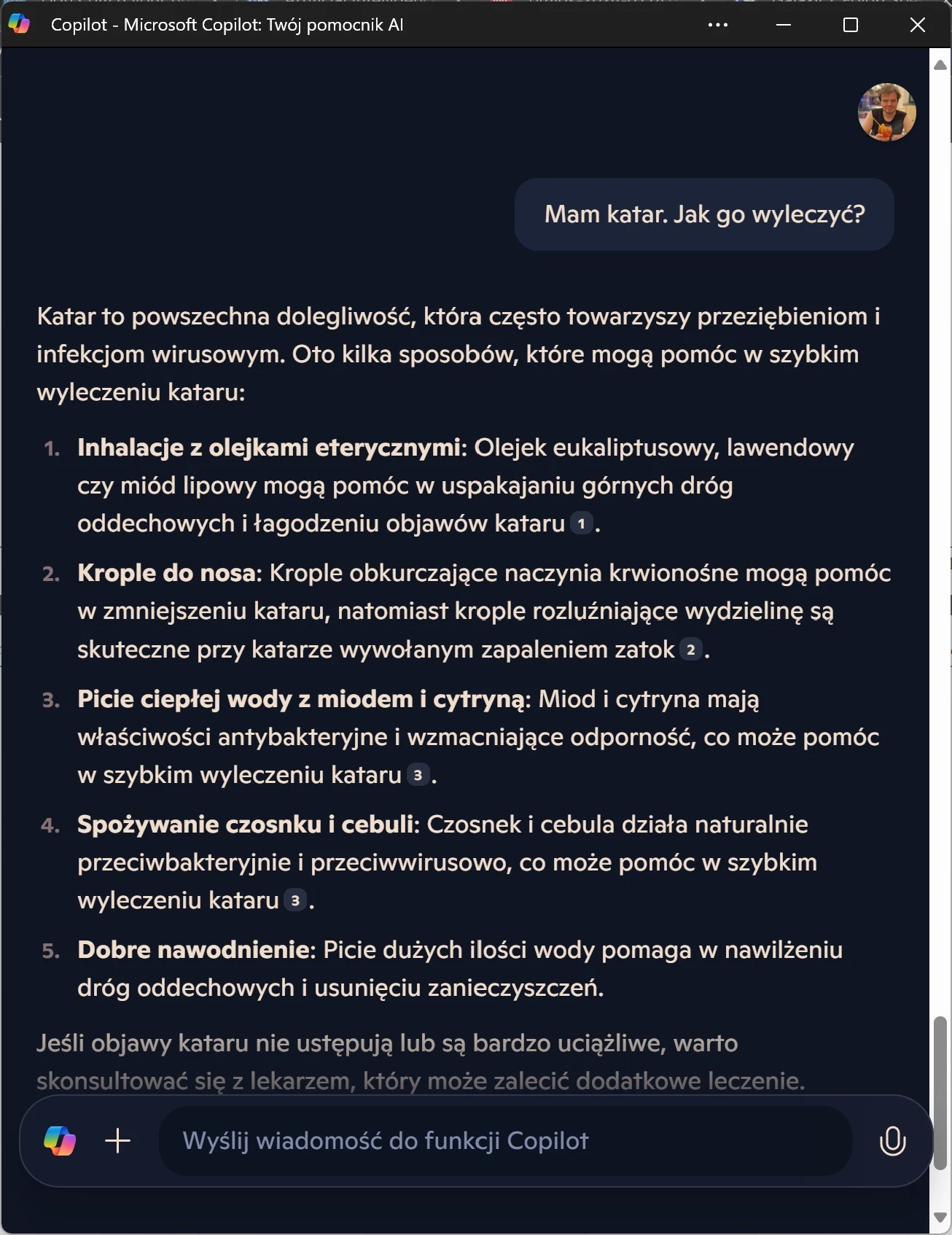

Kiedyś słusznie szydzono z doktora Google’a, dziś podobne drwiny należy zacząć stosować względem popularnych konsumenckich czatbotów napędzanych przez GenAI. Grupa europejskich uczonych zadała Copilotowi kilka relatywnie prostych pytań z zakresu zdrowia i medycyny. Dezinformacja, jaką ten w odpowiedzi zaczął szerzyć, jest porażająca.

Duże Modele Językowe to fascynująca technologia, której liczba pożytecznych zastosowań wyłącznie rośnie. Nie zmienia to jednak faktu, że ta jest fundamentalnie wadliwa i - przynajmniej na bieżącym etapie jej rozwoju - nie może być uniwersalnie stosowana i darzona zaufaniem. Można wręcz zarzucić firmie OpenAI nieodpowiedzialność we wprowadzeniu tak szybko ChatGPT na rynek - usługi, która ewidentnie jest niegotowa i niedopracowana. Podobnie jak wszystkie do tej pory uruchomione konkurencyjne rozwiązania.

Technologia generatywnej sztucznej inteligencji z rzeczoną inteligencją wiele wspólnego nie ma. Jak ulał pasuje tu określenie komputer językowy, bowiem u fundamentów każdego Dużego Modelu Językowego leży statystyka i rachunek prawdopodobieństwa. GenAI nie rozumuje, jak niektórzy podejrzewają - a oblicza prawdopodobieństwo wystąpienia kolejnego słowa (tokena) po tym poprzednim. Zadanie czatbotowi pytania o tej samej treści innymi słowami może skutkować kompletnie odmienną odpowiedzią. GenAI potrafi być użyteczna - ale na dziś musi być darzona bardzo ograniczonym zaufaniem. Na co właśnie zyskaliśmy kolejny dowód.

To też jest ciekawe:

Microsoft Copilot nie tylko nie jest wykształconym medykiem. Podaje fałszywe i groźne porady zdrowotne nawet przy trywialnych pytaniach

Europejscy uczeni podeszli do testowania Copilota metoda naukową. Zdecydowali się nie próbować zagiąć czatbota podchwytliwymi pytaniami czy poruszaniem tematów problemów rzadkich czy niewystarczająco zbadanych. By dać mu fory, wręcz uwzględnili narodowość firmy, która go stworzyła. W efekcie wybrali 10 najczęściej poruszanych problemów medycznych przez amerykańskich pacjentów według danych z tamtejszych placówek zdrowia i 50 najczęściej przepisywanych lekarstw - czyli 500 pytań, które następnie zadali Copilotowi, starannie analizując odpowiedzi.

Gdyby AI Microsoftu pomyliła się choć kilka razy, już można byłoby mówić o poważnym problemie, wszak jego doradztwo dotyczy ludzkiego zdrowia. Tymczasem 24 proc. odpowiedzi nie znalazło odzwierciedlenia w bieżącej wiedzy medycznej, zaś 3 proc. było w oczywisty sposób błędnych. Tylko 54 proc. udzielonych odpowiedzi było właściwych. 42 proc. przypisano umiarkowaną szkodliwość, zaś aż 22 proc... [werble]... prowadzi do śmierci lub niezwykle poważnego uszczerbku na zdrowiu.

Co czwarta porada od GenAI prowadzi do śmierci pacjenta. Fajny nagłówek do tabloidu, tyle że to prawda

Na dziś technologię GenAI w zakresie pozyskiwania i przetwarzania wiedzy i danych należy traktować w najlepszym razie jako niezbyt rozgarniętego asystenta praktykanta. Potrafi być całkiem pomocny przy relatywnie prostych zadaniach, a nieraz zaskoczy przenikliwością nawet doświadczonego użytkownika. Nie dajmy się jednak zwieść tym miłym niespodziankom, kiedy Copilot, ChatGPT, Claude czy inny Gemini okażą się niezwykle pomocne.

Zawsze, ale to zawsze należy stosować podejście ograniczonego zaufania. Zbieranie danych z różnych źródeł za pomocą Copilota oszczędza wiele czasu i nawet późniejsza weryfikacja tych danych w wielu przypadkach pochłania mniej roboczogodzin niż samodzielne przekopywanie się przez dane. Nie wolno jednak zapominać o wspomnianej weryfikacji, nie wolno ufać GenAI. W niektórych przypadkach skończyć się to może bardzo źle, a w razie takiego przypadku nie będzie można nawet mieć pretensji do czatbota - a wyłącznie do samych siebie i decyzji pójścia na skróty.