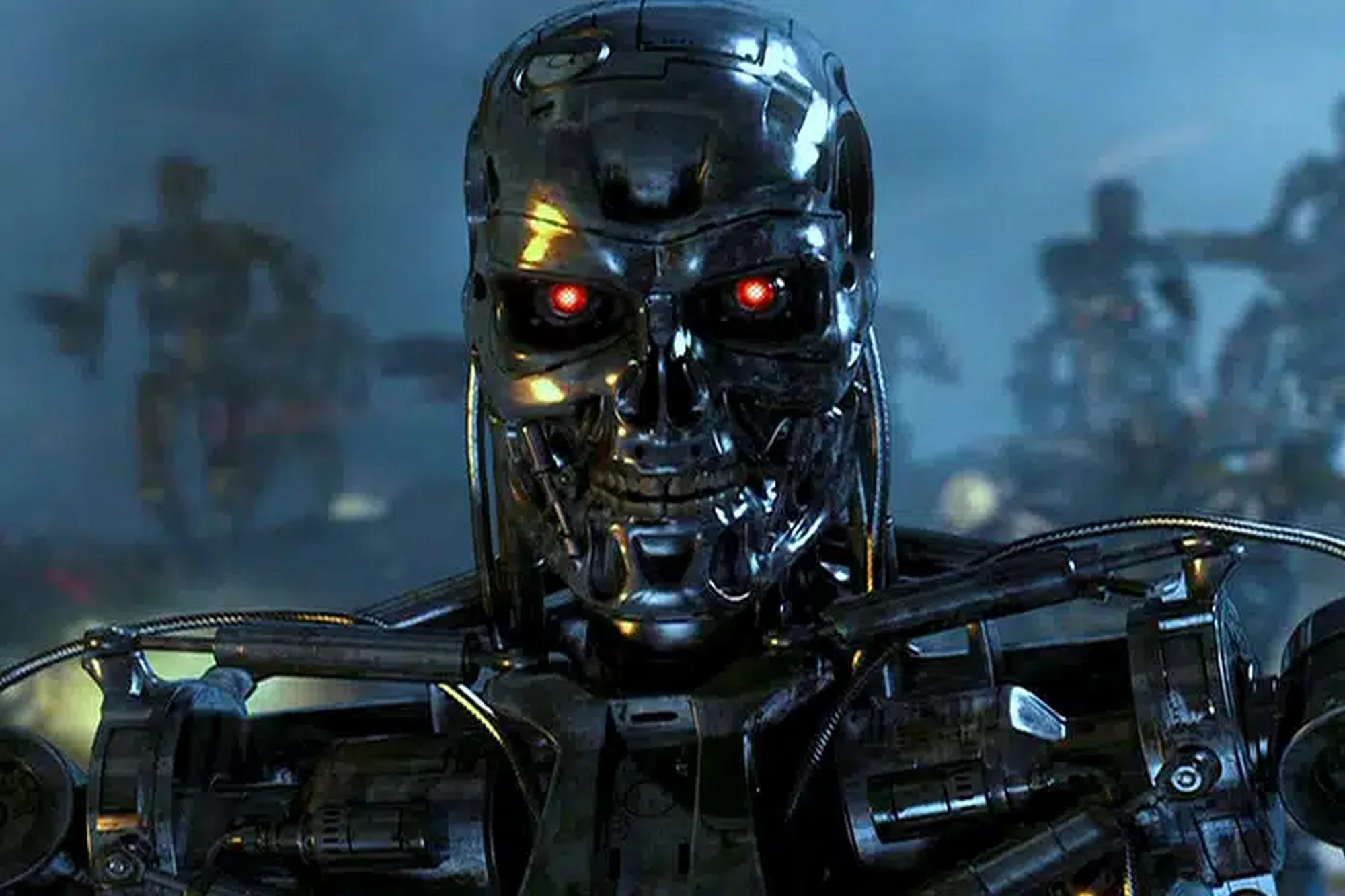

ChatGPT będzie bronią i to dosłownie. Nadchodzi czas prawdziwych Terminatorów

OpenAI po cichu usunął ze swojej polityki użytkowania sformułowanie wyraźnie zabraniające używania jego technologii do celów wojskowych i działań wojennych. Sztuczna Inteligencja oficjalnie już może być zastosowana militarnie. Teraz firma zastrzega tylko, że nie należy używać ich SI do szkodzenia sobie lub innym. Czy ChatGPT stanie się narzędziem do prowadzenia wojen, cyberwojen i dezinformacji?

Do 10 stycznia przepisy na stronie "Zasady użytkowania" OpenAI obejmowały zakaz działalności wiążącej się z wysokim ryzykiem obrażeń fizycznych, w tym "w szczególności rozwoju broni oraz używania do celów wojskowych i działań wojennych". Ten jasno sformułowany zakaz zastosowań wojskowych wykluczał jakiekolwiek oficjalne i niezwykle lukratywne kontrakty na użycie sztucznej inteligencji OpenAI przez Departament Obrony USA lub jakąkolwiek inną armię.

Nowa polityka podtrzymuje zalecenie, aby "nie korzystać z naszych usług w celu wyrządzenia krzywdy sobie lub innym" i jako przykład podaje "rozwój, lub używanie broni", ale całkowity zakaz używania „do celów wojskowych i działań wojennych” zniknął.

Więcej ważnych informacji o ChatGPT znajdziesz na Spider`s Web:

ChatGPT jako broń

W oświadczeniu dla The Intercept, portalu, który ujawnił zmianę w polityce, rzecznik OpenAI Niko Felix powiedział, że celem aktualizacji było "stworzenie zestawu uniwersalnych zasad, które są łatwe do zapamiętania i stosowania”. Felix dodał, że OpenAI chce realizować pewne projekty "związane z bezpieczeństwem narodowym", i podał jako przykład plan stworzenia narzędzi cyberbezpieczeństwa z DARPA, agencją badawczą Pentagonu.

Nie wszyscy są jednak przekonani, że OpenAI zachowuje się etycznie i odpowiedzialnie. Niektórzy eksperci i aktywiści ostrzegają, że usunięcie zakazu dotyczącego wojska może otworzyć furtkę do nadużyć i zagrożeń związanych z ChatGPT.

OpenAI doskonale zdaje sobie sprawę z ryzyka i szkód, jakie mogą wyniknąć z wykorzystania ich technologii i usług w zastosowaniach wojskowych

Sztuczna inteligencja i tak trafi do wojska

Sarah Meyers, dyrektor zarządzający Instytutu AI Now, który zajmuje się wpływem sztucznej inteligencji na społeczeństwo, skomentowała z kolei na X, że "biorąc pod uwagę użycie systemów SI do celowania w cywilów w Gazie, to znaczący moment, aby podjąć decyzję o usunięciu słów „militaria i wojna” z polityki dopuszczalnego użytkowania OpenAI”. Meyers zwróciła też uwagę, że Pentagon wykazuje duże zainteresowanie technologiami OpenAI i może naciskać na ich komercjalizację i militaryzację.

OpenAI twierdzi, że nadal jest zobowiązane do tworzenia i udostępniania otwartych i bezpiecznych technologii AI, które będą służyć ludzkości. Jednak firma nie jest organizacją non-profit, jak była na początku, lecz spółką z ograniczoną odpowiedzialnością, która ma prawo do zarabiania pieniędzy i podejmowania własnych decyzji biznesowych.

Dlatego użytkownicy ChatGPT powinni być świadomi, że korzystając z tej usługi, nie tylko tworzą teksty, ale też dostarczają dane, które mogą być wykorzystane do ulepszania i szkolenia modelu. Powinni też być ostrożni w kwestii tego, co i gdzie publikują, i jak chronią swoją prywatność i prawa autorskie. I powinni być aktywni i zaangażowani w dyskusję o tym, jak sztuczna inteligencja powinna być używana i regulowana, i jakie są jej etyczne i społeczne konsekwencje.