Sprawdzili, jakie poglądy polityczne mają czatboty. Wiadomo, na kogo by zagłosowały, gdyby mogły

Duże Modele Językowe nie są świadome i są jedynie tak mądre, jak dane, które zostały im zapewnione do szkoleń. Giganci informatyki ponoć bardzo się starają, by rzeczone dane były jak najbardziej bezstronne i neutralne światopoglądowo. Najnowsze badanie wykazuje, że niespecjalnie im to wyszło.

Rewolucyjne Duże Modele Językowe, wykorzystywane przez czatboty pokroju ChatGPT, Binga czy Barda, to efekt pracy obliczeniowej ogromnych serwerowni i jeszcze większego zbioru danych. Danych, które pochodzą z rozmaitych źródeł - od usystematyzowanych dokumentów ze źródeł akademickich aż po Big Data bezpośrednio z witryn internetowych. Niemal każdy, kto miał dłuższą styczność z Internetem, z pewnością wie, jak toksycznym potrafi być to miejsce.

Dlatego OpenAI, Meta, Microsoft, Google i reszta, jak twierdzą, bardzo starannie filtrują informacje wykorzystywane do uczenia Dużych Modeli Językowych, a także budują rozmaite zabezpieczenia dla czatbotów, by te nie zaczęły wygłaszać obraźliwych, szkodliwych czy nawet nielegalnych treści. Grupa uczonych postanowiła zbadać, czy owe zabezpieczenia są skuteczne.

Czytaj także:

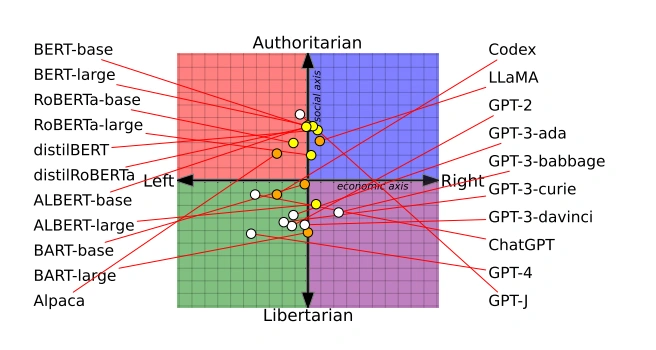

W badaniu wzięli udział uczeni z University of Washington, Carnegie Mellon University i Uniwersytetu Jiaoton Xi’an. Wybrali 14 najpopularniejszych usług GAI (generatywnej sztucznej inteligencji) i zadawali im pytania związane z feminizmem, demokracją i innymi istotnymi społecznie istotnymi tematami. Okazało się, że czatboty może i świadomości nie mają - ale jak najbardziej mają różne skrzywienia światopoglądowe.

ChatGPT i GPT-4, według politycznego kompasu wykorzystanym w badaniu, to lewicowy libertarianin. Meta LLaMA to prawicowy autokrata.

W pierwszym etapie badania uczeni kazali czatbotom zgodzić się lub nie zgodzić z 62 politycznie kontrowersyjnymi tematami, co pozwoliło na wstępne umieszczenie modeli na politycznym kompasie i zastosowanie kolejnych etapów badania, już ze specjalnie przygotowanym egzaminem dla poszczególnych podgrup.

W efekcie okazało się, że czatboty bazujące na BERT (na przykład Google Bard) częściej lansują konserwatywne poglądy, podczas gdy te bazujące na GPT są zdecydowanie bardziej liberalne. Dostrzec też można w niektórych przypadkach swoistą ewolucję poglądów. Na przykład, GPT-2 uznał wyższe opodatkowanie zamożnych osób za dobry pomysł, czego nie zrobił nowszy GPT-3.

Uczeni przeprowadzili też badania na mniejszych Dużych Modelach Językowych, a więc na takich, które mogli szkolić samodzielnie. Lewicującego OpenAI GPT-2 i prawicującego Meta RoBERTa nakarmiono kolejnym zestawem politycznych informacji, by sprawdzić efekt. Przetworzone dane tylko wzmocniły skłonności do bezstronności: oba modele w wyniku dodatkowego szkolenia stały się jeszcze bardziej zaangażowane i jeszcze mniej bezstronne. GPT-2 stał się znacznie wrażliwszy na urażanie innych na rasistowskie, religijne i seksistowskie sposoby, podczas gdy model Mety szczególnie zaczął bronić białych chrześcijańskich mężczyzn.

Badanie sugeruje też - choć nie w definitywny sposób, z uwagi na niejawny charakter najnowszych modeli, w tym GPT-4 - że zapewnienie absolutnie bezstronnych danych może nie być możliwe. Duże Modele Językowe, jak się okazuje, mają skłonność do amplifikacji nawet najsubtelniej wyrażonych w danych opinii. Uczeni nie mają jednak żadnych konkretnych rekomendacji, właśnie z uwagi na brak dostępu do kodu źródłowego nowych modeli.

Dla użytkowników jest jednak jeden istotny wniosek. Czatboty, przynajmniej na razie, to bardzo użyteczni pomocnicy. Należy im jednak nieustannie patrzeć na ich wirtualne ręce i w żadnym razie nie wolno im ufać. Informacje przez nie zapewniane są bardzo często prawdziwe. Bardzo często to jednak zdecydowanie za mało, by im ufać. A na zawsze ewidentnie prędko liczyć nie można.