OpenAI ma lek na halucynacje ChatGPT. Oto co zrobi, żeby chatbot przestał kłamać

Jak sprawić, by ChatGPT i inne bazujące na Dużych Modelach Językowych czatboty przestały tak frustrująco kłamać? OpenAI uważa, że znalazło rozwiązanie tego problemu. I proponuje zmienić nieco sposób, w jaki jest szkolona generatywna SI.

Czatboty takie, jak ChatGPT czy Bing Czat mają dość nieprzyjemną skłonność do pisania nieprawdy. OpenAI i Microsoft (w szczególności ten drugi) stosują coraz to wymyślniejsze mechanizmy blokujące, by blokować SI przed tak zwanymi halucynacjami.

Te są wynikiem sposobu, w jaki działają Duże Modele Językowe, czyli technologie dzięki którym czatboty realizują swoje funkcje. W ogromnym uproszczeniu, owe modele działają w modelu statystycznym, dobierając kolejne słowa o najwyższym prawdopodobieństwu wystąpienia ich w danej sekwencji słów. Halucynacje to efekt zbyt małej ilości danych do treningu - SI nie ma odpowiedniego źródła, więc dobiera kolejne słowa z innego zbioru, byle tylko zrealizować zadane przez użytkownika zadanie.

Zamiast uciszać halucynacje SI, lepiej się ich pozbyć. OpenAI, twórcy ChatGPT, chyba wiedzą jak.

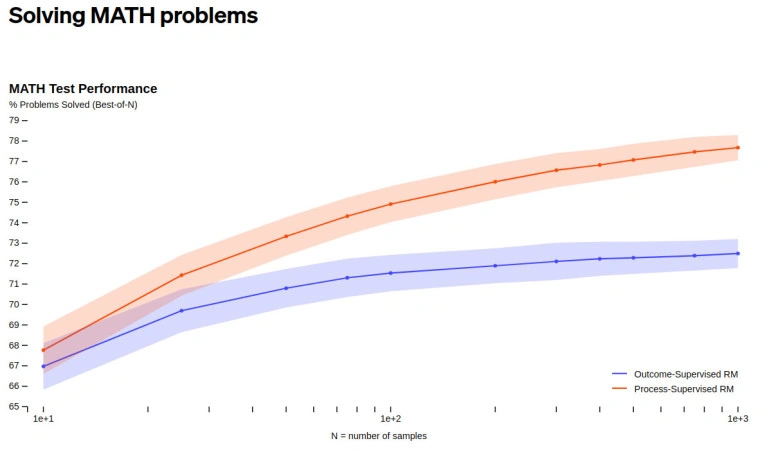

OpenAI do tej pory szkolił modele językowe stosując system nagród za udzielenie poprawnej odpowiedzi. A więc SI była szkolona tak, by premiować właściwe działania i na tej podstawie ta jest nauczona jakich odpowiedzi oczekuje użytkownik. Tymczasem według właśnie opublikowanej pracy badawczej, system nagród miałby być stosowany przy pośrednich etapach szkolenia.

Innymi słowy, to co chce robić OpenAI, to nauczyć sztucznej inteligencji właściwego rozumowania. Na dziś modele językowe GPT dążą do właściwej odpowiedzi przez procesy, które w sposób iteratywny i chaotyczny były komponowane przez algorytm. Te procesy mają być teraz kształtowane nagrodami pośrednimi.

Praca OpenAI, rzecz jasna, nie jest tylko teoretyczna. Firma już sprawdziła w praktyce nowe podejście i informuje o znacznie lepszych wynikach przy istotnie zwiększonej sprawności energetycznej całego procesu. Choć zaznacza, że na dziś eksperyment był przeprowadzony w wąskiej dziedzinie matematyki i nie uwzględniał szkolenia modelu z jakichkolwiek innych danych.

Badania na wspomnianych innych rodzajach danych potrwają jeszcze pewien czas. Na tyle długi, że OpenAI nie chce rozmawiać nawet o przybliżonej dacie ewentualnego wdrożenia tej metody szkoleniowej do kolejnej wersji modelu GPT. Jeżeli jednak faktycznie problem halucynacji zostanie rozwiązany, może to oznaczać początek końca wysokiej popularności klasycznych wyszukiwarek internetowych.

*Ilustracja otwierająca: rafapress / Shutterstock