Meta podzieliła się z naukowcami ważną technologią. Co potrafi SI właściciela Facebooka?

OpenAI miało być centrum badawczym, rozwijającym generującą własne treści SI na rzecz ogólnego pożytku. Meta chce dokonać czegoś podobnego, tyle że chce nauczyć SI co oznacza każdy piksel na każdym zdjęciu.

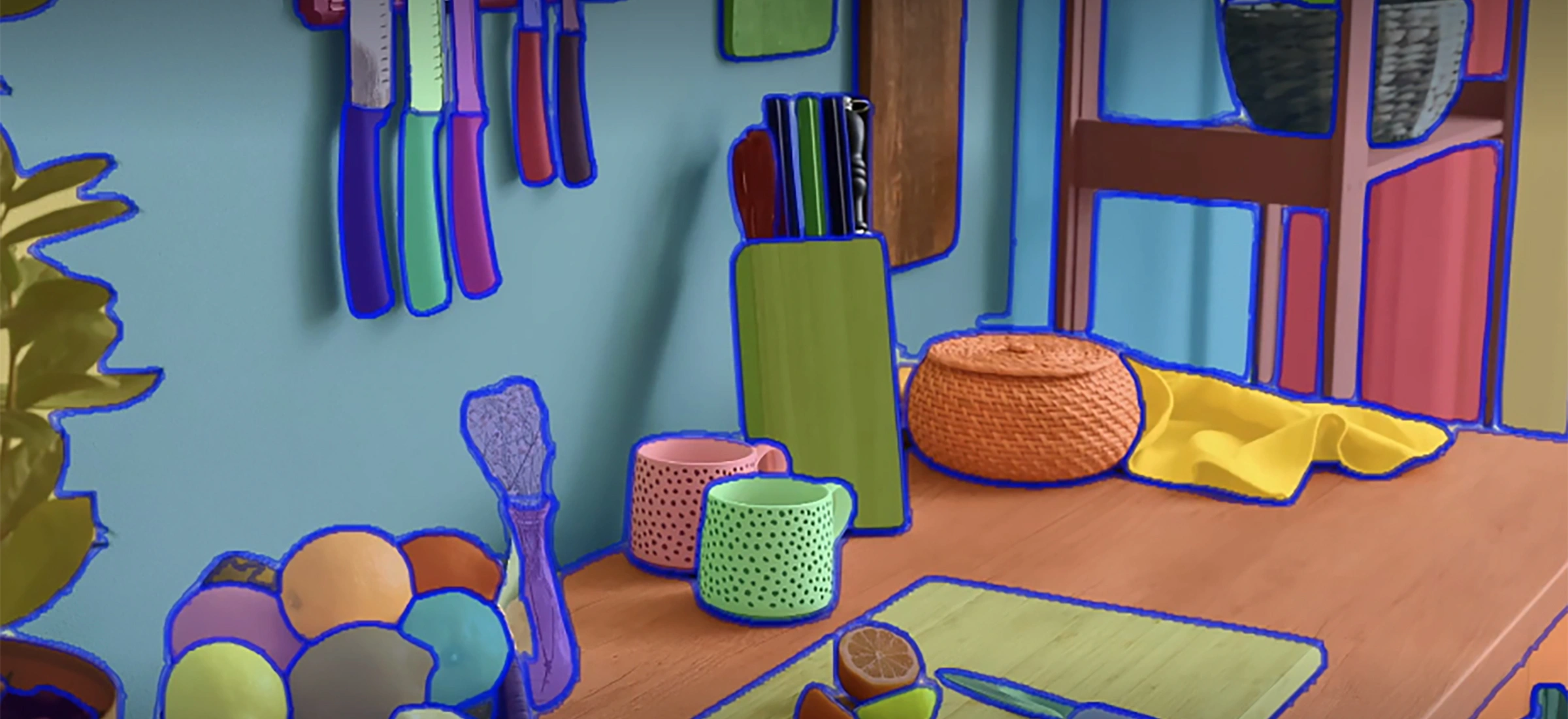

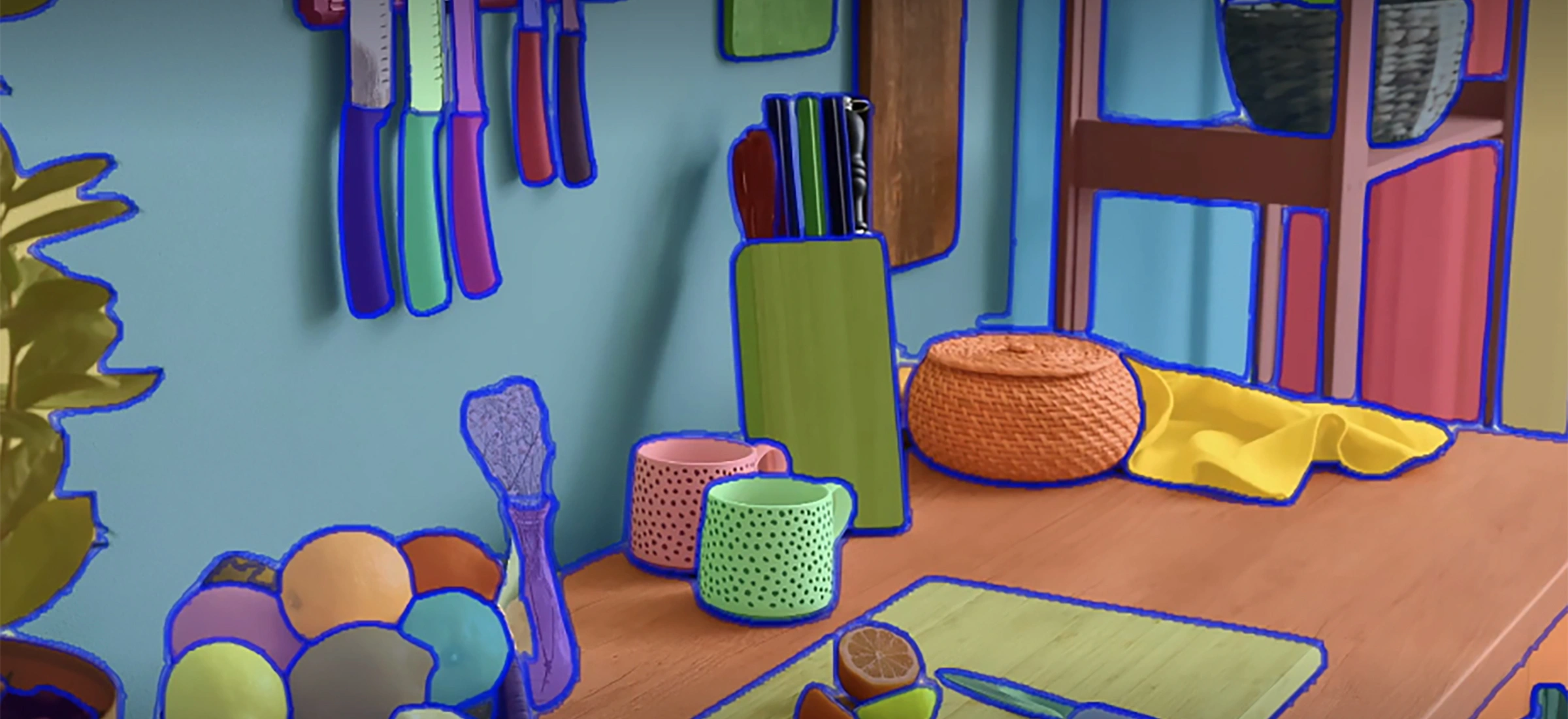

Meta (właściciel, między innymi, Facebooka, Instagrama i WhatsAppa) właśnie udostępniła za darmo i dla wszystkich (na licencji Apache 2.0) Segment Anything Model, czyli SI potrafiącą rozpoznać znaczenie pikseli na zdjęciach. Konkretniej, które piksele należą do którego widocznego na zdjęciu obiektu. To jedno z kluczowych wyzwań dla komputerowego rozpoznawania obrazu, czyli do bezbłędnego rozpoznawania treści dowolnego zdjęcia. Razem z SAM na tej samej licencji udostępniono Segment Anything 1-Billion, czyli dane, jakie zostały wykorzystane do stworzenia udostępnionego modelu.

Proces rozpoznawania przynależności pikseli do pozostałych ich grup - czyli rozpoznawania obiektów na zdjęciach i rozróżnianiu ich - jest badany przez wiele różnych firm informatycznych. Od tych zajmujących się aplikacjami do naukowej analizy danych, aż po branżę kreatywną i oprogramowanie do edycji zdjęć. Nie jest to przy tym łatwe zadanie, bo wymaga dostępu do ogromnej ilości danych i potężnej infrastruktury informatycznej - by mieć z czego wyszkolić wynaleziony nowy model SI.

Czytaj także:

- Mówisz notatnikowi co ma robić, a ten wykona za ciebie pracę. Tak działa Copilot w OneNote

- ChatGPT wsadził burmistrza do więzienia. OpenAI ma problem z halucynacjami, pozew wisi w powietrzu

Dar właściciela Facebooka dla społeczności inżynierów rozwijających algorytmy SI jest więc potencjalnie bardzo wartościowy.

Zwłaszcza że to najbardziej złożony model tego typu i największy zestaw danych treningowych, jaki został udostępniony do tej pory - nie mówiąc już o tak łagodnej licencji, jaką jest Apache 2.0. SAM potrafi generować graficzne maski dla każdego z rozpoznawanych obiektów i działa już nie tylko ze statycznymi zdjęciami, ale również z materiałami wideo. Potrafi też rozpoznawać obiekty, na które nigdy wcześniej się nie natknął.

Dane wykorzystane do szkolenia, jakie udostępniła Meta, składają się z 11 milionów zdjęć z gwarantowaną licencją i nienaruszających niczyjej prywatności. Model był też projektowany z myślą o byciu komponentem innego, większego modelu - na przykład dla mechanizmu analizującego treść składających się z multimediów i tekstu artykułów internetowych. Meta ma też nadzieje na jego użyteczność w rozpoznawaniu obiektów przez urządzenia do rzeczywistości rozszerzonej.

Uczeni i inżynierowie zainteresowani uzyskaniem Segment Anything Model bądź jego zestawu danych treningowych mogą udać się na microsoftowego GitHuba, gdzie jest dostępny do pobrania wraz z dokumentacją.