Google właśnie dał rozum robotom. Zaraz, a co z bezpieczeństwem?

Szykujcie się na inwazję robotów. Ale spokojnie, przynajmniej potrafią już pakować kanapki do woreczków. Google DeepMind pokazał modele Gemini Robotics.

Roboty wchodzą na wyższy poziom – i to dosłownie. Zapomnijcie o topornych, metalowych maszynach wykonujących w kółko te same ruchy. Nadchodzi era robotów, które myślą, uczą się i postrzegają rzeczywistość niemal tak jak my. Brzmi jak scenariusz średniego filmu science fiction? Być może, ale Google właśnie sprawił, że przyszłość staje się teraźniejszością. I nie, nie mówimy tu o kolejnym chatbocie, który udaje, że rozumie, co do niego piszesz.

Sztuczna inteligencja to już nie tylko algorytmy analizujące dane w chmurze. Teraz AI staje się dosłownie mózgiem robotów. To ona pozwala im widzieć, słyszeć, a raczej interpretować dźwięki, rozumieć nasze polecenia (i to bez konieczności uczenia się skomplikowanych komend) i – co najważniejsze – działać w realnym świecie.

Ktoś musi jednak tym wszystkim zarządzać, prawda? Nie chcemy przecież, żeby roboty nagle postanowiły przejąć kontrolę nad światem. Google DeepMind, zespół odpowiedzialny za jedne z najbardziej przełomowych osiągnięć w dziedzinie AI, właśnie odpala prawdziwą petardę.

Roboty z rozumem. Podziękujmy Google'owi

Google DeepMind, laboratorium badawcze Google zajmujące się sztuczną inteligencją, dokonało małego przełomu, prezentując dwa nowe modele AI o nazwie Gemini Robotics. Gigant twierdzi, że to nie tylko kolejny krok w rozwoju robotyki, ale wręcz ogromny "skok jakościowy".

Mają one wyposażyć roboty w zdolności, które do tej pory były domeną ludzi – rozumienie otoczenia, interakcję z przedmiotami i adaptację do zmieniających się warunków. To oznacza, że roboty przestają być jedynie zaprogramowanymi maszynami, a stają się partnerami, którzy mogą uczyć się i rozwiązywać problemy.

Gemini Robotics to technologia, która integruje trzy kluczowe obszary:

- Wzrok: roboty widzą świat dzięki kamerom i zaawansowanym algorytmom analizy obrazu.

- Rozumienie mowy: rozumieją polecenia wydawane w naturalnym, ludzkim języku, a nie tylko w skomplikowanym kodzie programistycznym.

- Działanie: potrafią działać – planować i wykonywać złożone sekwencje ruchów, aby osiągnąć zamierzony cel.

To wszystko jest możliwe dzięki ogromnej ilości danych, na których modele są trenowane, oraz dzięki innowacyjnym rozwiązaniom w dziedzinie sztucznej inteligencji. To tak, jakby dać robotowi nie tylko oczy i ręce, ale też mózg, który potrafi je skoordynować i wykorzystać do logicznego działania, np. do wkładania tych kanapek do woreczków.

Przeczytaj więcej o robotach:

Google DeepMind kładzie nacisk na trzy kluczowe cechy:

Po pierwsze - wszechstronność: roboty nie są ograniczone do jednego, wąskiego zakresu zadań. Potrafią radzić sobie z różnorodnymi wyzwaniami, nawet takimi, z którymi nie miały do czynienia podczas treningu.

Po drugie - interaktywność: to zdolność do płynnej komunikacji z człowiekiem. Roboty rozumieją polecenia wyrażone w naturalnym języku, potrafią na nie reagować i dostosowywać swoje zachowanie do zmieniających się instrukcji. Współpraca z robotem ma stać się bardziej intuicyjna.

Po trzecie - zręczność: umiejętność wykonywania precyzyjnych i delikatnych ruchów, takich jak chwytanie małych przedmiotów, manipulowanie nimi czy składanie skomplikowanych struktur.

Jest i ER. Eee, roboty?

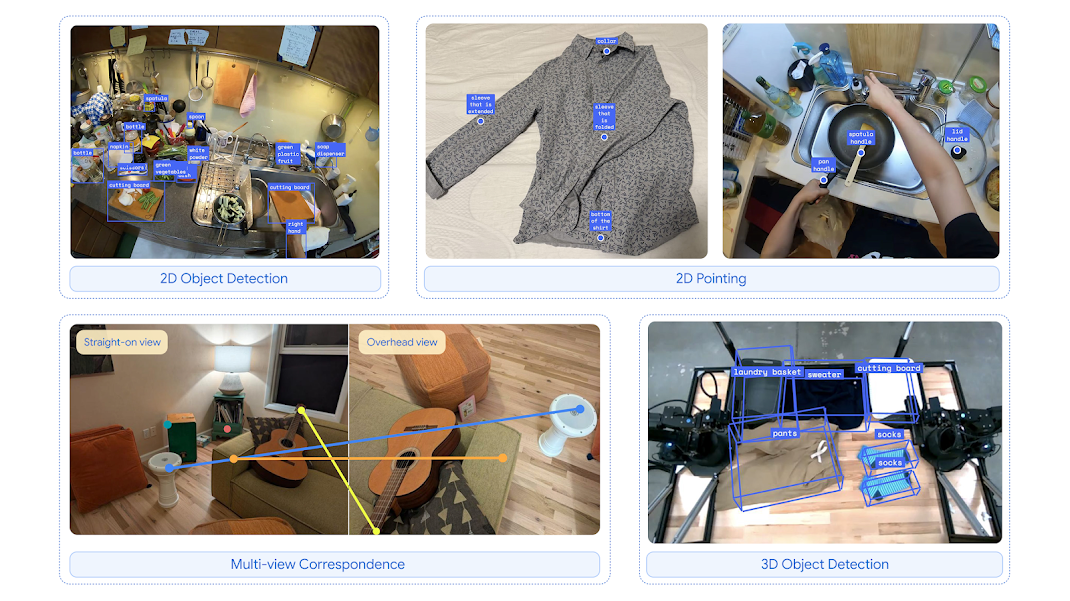

Oprócz głównego modelu Gemini Robotics, Google wprowadza również Gemini Robotics-ER, który jest wyspecjalizowany w rozumieniu przestrzeni. Ten model to połączenie nawigatora i stratega – potrafi ocenić otoczenie, zaplanować trasę, znaleźć najlepszy sposób chwytania przedmiotów i unikać przeszkód.

Gemini Robotics-ER może współpracować z istniejącymi systemami sterowania robotami, co znacznie ułatwia jego implementację w praktycznych zastosowaniach. Dzięki temu roboty mogą działać w bardziej złożonych i dynamicznych środowiskach, takich jak magazyny, fabryki czy nawet domy.

Google DeepMind ma zdawać sobie sprawę z tego, że rozwój robotyki wiąże się z ogromną odpowiedzialnością. Dlatego modele AI mają być projektowane tak, aby ich działania były przewidywalne i nie stanowiły zagrożenia dla ludzi i otoczenia.

Google twierdzi, że stosuje wielowarstwowe podejście do bezpieczeństwa, obejmujące zarówno podstawowe mechanizmy kontroli ruchu, jak i zaawansowane systemy rozumienia kontekstu. Dodatkowo firma udostępnia narzędzia i zbiory danych, które mają pomóc innym badaczom w ocenie i doskonaleniu bezpieczeństwa robotów.

Zaczynam się bać AI. Jakby, wcześniej to już odczuwałem, ale teraz sztuczna inteligencja jest w stanie sprawić, że kiedyś durny robot, teraz będzie turbodopalany inteligencją. Więc: co będzie za rok, dwa czy pięć lat?