Patrzysz w aparat, nawet gdy nie patrzysz w aparat. Tak będzie teraz działał iPhone

Jeśli korzystasz z wideorozmów, na pewno znasz sytuacje, kiedy wzrok rozmówcy jest skierowany gdzieś obok, ponieważ patrzy on na ekran swojego smartfona, a nie w oczko kamery. Apple to naprawi. I to w rozmowach prowadzonych na żywo.

Przy korzystaniu z przedniej kamerki smartfona problem jest zawsze ten sam: patrzymy w ekran, a nie w kamerę. Widok samego siebie (lub rozmówcy) na ekranie sprawia, że nasz wzrok odruchowo kieruje się właśnie na twarz, a więc na ekran.

To powoduje, że wideorozmowy są dość nienaturalne, bo nie da się zachować kontaktu wzrokowego. A nawet w rozmowie zdalnej, na odległość, jest to ważne.

Czy wyobrażacie sobie, że w rozmowie na żywo ktoś cały czas patrzyłby wam na usta, a nie na oczy? Byłoby to dziwne i krepujące. W wideorozmowach najczęściej tak to właśnie wygląda.

Człowiek zauważa nawet najmniejsze odchylenie wzroku innej osoby. Na twarze i oczy patrzymy przez dosłownie całe swoje życie, od momentu narodzin. Półroczne dziecko doskonale wie, kiedy rodzic patrzy na nie, a kiedy gdzieś obok. Od tego czasu człowiek tylko doskonali tę umiejętność.

Nie bez powodu w telewizji stosuje się promptery, a vlogi nagrywa się patrząc w obiektyw, a nie ekran. Widzowie od razu są w stanie wychwycić, że osoba przed kamerą nie miała wzroku skupionego na obiektywie, a więc nie utrzymywała z nami „kontaktu wzrokowego”.

Apple poprawi twoje oczy w rozmowach FaceTime. W iOS pojawi się automatyczna zmiana pozycji oczu, generowana na żywo.

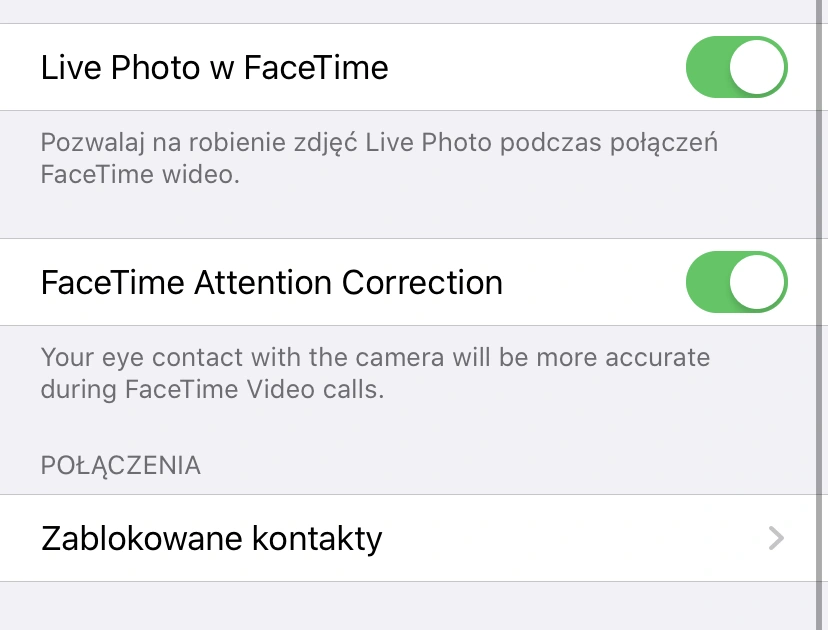

Jest to jedna z nowości, która zawitała do trzeciej bety w iOS 13. W ustawieniach FaceTime jest teraz nowe pole „FaceTime Attention Correction” odpowiedzialne za korektę wzroku. Po jego włączeniu iPhone będzie korygował pozycję źrenic.

Brzmi to futurystycznie… i takie właśnie jest. Smartfon na żywo analizuje twarz i tworzy de facto grafikę, ponieważ źrenice są wycinane i przesuwane w odpowiednie miejsce. To wszystko, klatka po klatce, jest realizowane na żywo. Apple wykorzystuje do tego ARKit i mapowanie twarzy.

Efekty wyglądają w praktyce tak, jak na dwóch załączonych zrzutach ekranu. Widać na nich odpowiednio ujęcie z rozmowy prowadzonej przy wyłączonej i przy włączonej funkcji „FaceTime Attention Correction”. Co ciekawe, kiedy przy włączonej funkcji korekcji spojrzymy w kamerkę, oczy będą wyglądać tak, jakbyśmy patrzyli wyżej, ponad smartfon.

Funkcja jest w fazie beta, ale powinna trafić w gotowej wersji do iOS 13.

Na razie nie wiadomo dokładnie, które modele iPhone’a wspierają nowość. Sprawdziliśmy, że funkcja działa na iPhonie XR i XS Max. Ciekaw jestem, czy podobne rozwiązanie trafi kiedyś do Androida. Pomysł jest świetny i warto byłoby go wdrożyć na całym rynku. To dalece bardziej przydatny drobiazg, niż mapowanie twarzy w filtrach na Snapchacie.