"Zwykli ludzie, po prostu wykonujący swoją pracę i nieokazujący szczególnej wrogości, mogą stać się agentami w straszliwym procesie destrukcji".

Stanley Milgram

I. W ogrodzie

Słychać plusk wody i śmiech dzieci kąpiących się w ogrodowym basenie. To pierwszy dźwięk, dominujący, idylliczny. Ale pod nim nieustannie sączy się drugi, cichszy pomruk – niski, przemysłowy szum dochodzący zza wysokiego muru. To mistrzowska warstwa dźwiękowa filmu Jonathana Glazera "Strefa interesów", która zamyka widza w świecie komendanta Auschwitz Rudolfa Hössa i jego rodziny, żyjących w starannie pielęgnowanym ogrodzie tuż obok fabryki śmierci.

Podobnie jest dzisiaj. Słyszymy entuzjastyczne przemówienia o świetlanej przyszłości, jaką zapewni rozwój sztucznej inteligencji. To pierwszy głośny dźwięk – obietnica postępu, demokratyzacji wiedzy i rozwiązania największych problemów ludzkości. Jednak pod tą melodią rozbrzmiewa drugi, starannie wyciszany pomruk – szum serwerowni realizujących nieetyczne cele, zasilanych nieuczciwie pozyskiwanymi danymi i napędzanych niewidzialną pracą rzeszy ludzi.

Aby osiągnąć efekt permanentnego niepokoju, Glazer posłużył się radykalnymi technikami filmowymi. Użył dziesięciu kamer ukrytych w meblach i ścianach, pracujących jednocześnie, bez widocznej ekipy i tradycyjnego oświetlenia. Efektem jest chłodne, beznamiętne spojrzenie, przypominające zapis z kamer przemysłowych lub systemu rozpoznawania twarzy. To nie przypadek, że jedna z najbardziej przejmujących sekwencji filmu ukazuje obraz z kamery termowizyjnej: to algorytmiczne oko, które widzi ciepło ciał, ale nie jest w stanie odróżnić ofiary od kata.

Film Glazera nie jest lekcją o Holokauście. Jest instrukcją patrzenia na mechanizmy wyparcia. To studium ludzkiej zdolności do życia tuż obok zbrodni, do budowania murów nie tylko fizycznych, ale przede wszystkim poznawczych, które pozwalają ignorować to, co niewygodne. Należy to podkreślić z całą mocą: nie chodzi o trywialne porównywanie tragedii czy zrównywanie ich skutków. Eksploatacja danych i wyzysk pracowniczy, choć szkodliwe, nie są w żadnej mierze porównywalne z ludobójstwem. Chodzi o analizę uniwersalnych struktur obojętności. Tych samych, które pozwalają zwykłym ludziom, jak ujął to psycholog Stanley Milgram, "stać się agentami w straszliwym procesie destrukcji", nie okazując nawet szczególnej wrogości.

Ta analiza jest próbą wsłuchania się w oba dźwięki i zdefiniowania tego, co można nazwać "algorytmem obojętności". Nie jest to algorytm zapisany w Pythonie czy Javie. To struktura poznawcza, społeczna i instytucjonalna, która pozwala nam żyć w bezpośredniej bliskości systemowego wyzysku, nie dostrzegając go lub – co gorsza – dostrzegając, ale racjonalizując jako nieunikniony koszt postępu. To nie jest bierność, lecz aktywny wysiłek poznawczy. To, co Hannah Arendt, relacjonując proces Adolfa Eichmanna, nazwała "banalnością zła", które nie wynikało z nienawiści, lecz z "zaniechania myślenia" – z rezygnacji z refleksyjnego osądu własnych działań i ich konsekwencji. Ten algorytm obojętności wznosi wokół nas trzy mury: techniczny (zamknięte "czarne skrzynki" algorytmów), retoryczny (język przekształcający wyzysk w "optymalizację") i psychologiczny (iluzja kontroli, która maskuje manipulację). Bitwa o przyszłość technologii jest w dużej mierze bitwą o to, co jako społeczeństwo zdecydujemy się usłyszeć.

II. Ogrodnik

Aby zrozumieć, jak działa algorytm obojętności, nie trzeba szukać anonimowych biurokratów. Wystarczy przyjrzeć się historii jednej z najbardziej wpływowych postaci w świecie AI – dr Fei-Fei Li. Jej kariera, pełna sprzeczności, nie jest żadną opowieścią o indywidualnym upadku moralnym, lecz lustrem, w którym odbija się cały system – jego presja, logika i zdolność do przekształcania nawet najszlachetniejszych intencji w narzędzia opresji.

Publiczny wizerunek dr Li to ucieleśnienie marzenia o technologii służącej ludzkości. Nazywana "matką chrzestną sztucznej inteligencji", jest twórczynią ImageNet, gigantycznej bazy danych, która zapoczątkowała rewolucję głębokiego uczenia.

Jej autobiografia, "Moje światy: sztuczne i realne", jest nazywana przez recenzentów "pięknym listem miłosnym do AI", który przedstawia inspirującą historię imigrantki pokonującej wszelkie przeciwności losu, by realizować swoją pasję.

Jako założycielka wartego 120 milionów dolarów instytutu Stanford Human-Centered AI stała się czołową orędowniczką „humanistycznej AI”, technologii tworzonej z myślą o człowieku. To jest jej ogród – starannie pielęgnowana narracja o postępie i dobrych intencjach.

Jednak za murem tego ogrodu kryje się inna rzeczywistość. Pierwszą rysę widać, gdy przyjrzymy się fundamentom jej największego dzieła. Etykietowanie 14 milionów obrazów w ImageNet nie było dziełem magii, lecz armii 49 tysięcy "niewidzialnych pracowników" ze 167 krajów, zatrudnionych za pośrednictwem platformy Amazon Mechanical Turk. Pracowali w tempie fabrycznej taśmy produkcyjnej, mając od 3 do 5 sekund na sklasyfikowanie jednego obrazu, często za stawki około dwóch dolarów za godzinę, pozbawieni podstawowych praw pracowniczych. Paradoksalnie ponad 70 proc. tych "klik-workerów" miało wykształcenie wyższe, co ujawnia, jak przemysł technologiczny zbudował wydajny model biznesowy do wydobywania wartości z globalnego prekariatu. W humanistycznej narracji książki dr Li na temat sposobu zaangażowania tej armii ludzi nie ma ani słowa.

Problem bynajmniej nie leży tylko w wyzysku, ale i w naturze samej pracy. Kategorie, których używali pracownicy, były przesiąknięte społecznymi uprzedzeniami. Przez lata w ImageNet istniały etykiety takie jak "alkoholik", "nie-osoba" czy obraźliwe terminy etniczne używane do klasyfikacji zdjęć ludzi. Skandal wybuchł, gdy artystyczny projekt "ImageNet Roulette" obnażył rasistowski i seksistowski charakter tych klasyfikacji, zmuszając twórców do usunięcia ponad 600 tysięcy zdjęć. Było już jednak za późno. Poprzez mechanizm transfer learning uprzedzenia z ImageNet zostały przeniesione do DNA całej generacji modeli AI, stając się fundamentem nowych systemów, które odziedziczyły te same wady.

Jednak to tylko wstęp do fałszywej poprawności. Mur ostatecznie runął w 2018 roku, gdy ujawniono wewnętrzne e-maile z Google'a na temat Projektu Maven – kontraktu z Pentagonem, w ramach którego technologia AI miała być wykorzystywana do analizy nagrań z dronów wojskowych, aby, jak to ujęto w dokumentach, "przyspieszyć łańcuch zabijania" (kill chain). Dr Li, pełniąca wówczas kluczowe funkcje wiceprezes (vice president) Google'a oraz głównego naukowca ds. AI/ML w Google Cloud, była w centrum tych wydarzeń. Kiedy szef Google'a ds. projektów obronnych zwrócił się do niej z "palącym pytaniem" o to, jak przedstawić projekt opinii publicznej, jej rada była jednoznaczna.

W e-mailach, które wyciekły do prasy, radziła, aby "UNIKAĆ ZA WSZELKĄ CENĘ jakiejkolwiek wzmianki lub implikacji AI". Sugerowała, by przedstawiać go jako dostarczanie "zwykłej technologii chmurowej" (vanilla cloud technology), aby chronić "bardzo pozytywny wizerunek" Google'a jako firmy promującej "humanistyczną AI". Ten cyniczny zabieg retoryczny stał w sprzeczności z jej późniejszymi publicznymi deklaracjami dla "The New York Times", w których twierdziła, że militaryzacja AI jest "głęboko sprzeczna z moimi zasadami". Ujawnione wiadomości pokazały też jej autentyczny entuzjazm dla zdobycia wojskowego kontraktu: "To takie ekscytujące, że jesteśmy blisko zdobycia MAVEN! To byłoby wspaniałe zwycięstwo".

Historia Fei-Fei Li pokazuje, że algorytm obojętności nie jest stanem pasywnym, lecz aktywnym procesem poznawczego i retorycznego zarządzania. Sprzeczność między publicznym humanizmem a prywatnym militaryzmem nie jest w tym systemie moralną porażką, lecz wymaganą umiejętnością przywódczą.

Presja grantowa, logika Doliny Krzemowej oparta na haśle "skaluj się albo giń" (scale or die) oraz imperatywy "publikuj albo przepadnij" (publish or perish) tworzą strukturalnie nieetyczny system, który wymusza kompromisy i korumpuje nawet najlepsze intencje. Dr Li nie jest anomalią. Jest dowodem na to, że system działa dokładnie tak, jak został zaprojektowany. Najbardziej symbolicznym tego przykładem jest jej uporczywe używanie metafory "Gwiazdy Północnej" do opisu swoich naukowych dążeń. W amerykańskiej kulturze związana jest ona z ucieczką niewolników ku wolności. Zawłaszczenie tego potężnego symbolu wyzwolenia do opisu projektów opartych na wyzysku i współpracy z wojskiem jest ostatecznym pokazem, jak język postępu może maskować praktyki opresji.

III. Militarne DNA sztucznej inteligencji

Fundamentalnym elementem architektury wyparcia jest mit, jakoby sztuczna inteligencja była neutralnym, akademickim przedsięwzięciem, które dopiero później zostało niefortunnie wykorzystane do celów militarnych. Historia pokazuje jednak coś dokładnie odwrotnego: AI od samego początku była projektem wojskowo-przemysłowym, a jej DNA jest nierozerwalnie splecione z logiką wojny, nadzoru i kontroli.

Oficjalna historia jako datę narodzin AI podaje lato 1956 roku – konferencję w Dartmouth College. Jednak prawdziwą kolebką tej technologii były otoczone najściślejszą tajemnicą bunkry Bletchley Park w 1943 roku, gdzie Alan Turing i jego zespół skonstruowali maszynę Colossus do łamania niemieckich szyfrów. Był to pierwszy na świecie programowalny, elektroniczny komputer cyfrowy wykonujący zadania, które dziś nazwalibyśmy inteligentnymi: rozpoznawanie wzorców i testowanie hipotez w celu wygrania wojny.

Nawet sama "akademicka" konferencja w Dartmouth była głęboko zakorzeniona w świecie obronności. Jej czterej główni organizatorzy byli weteranami badań finansowanych przez wojsko: pierwsza ucząca się sieć neuronowa Marvina Minskiego została sfinansowana przez Biuro Badań Marynarki Wojennej (ONR); Nathaniel Rochester z IBM projektował radary i sprzęt wojskowy; a Claude Shannon z Bell Labs pracował nad kryptoanalizą i systemem bezpiecznej łączności dla Roosevelta i Churchilla.

Prawdziwą skalę tej symbiozy ujawnił zimnowojenny projekt SAGE (Semi-Automatic Ground Environment) z lat 1958-1963. Ten kontynentalny system obrony powietrznej, którego koszt, szacowany na ponad 60 miliardów dzisiejszych dolarów, przewyższył Projekt Manhattan, był największym przedsięwzięciem komputerowym swojej epoki. Każde z 27 centrów dowodzenia mieściło gigantyczny, ważący 250 ton komputer IBM, a całość oprogramowania składała się z ponad 500 tysięcy linii kodu. SAGE był pionierem w dziedzinie sieci komputerowych, interaktywnych wyświetlaczy graficznych z pistoletami świetlnymi (prekursorem myszy) i pamięci z rdzeniem magnetycznym. Ta współpraca Sił Powietrznych USA, akademickiego MIT i korporacyjnego IBM na dekady scementowała model, w którym innowacje na masową skalę są napędzane przez potrzeby wojskowe.

W odpowiedzi na "szok Sputnika" w 1958 roku powstała agencja DARPA, która rozpoczęła "złoty wiek finansowania" badań nad AI. To jej hojne, długoterminowe granty, niemożliwe do uzyskania w normalnym trybie akademickim, ukształtowały trajektorię rozwoju tej dziedziny. Priorytetyzowano obszary o bezpośrednim zastosowaniu militarnym: autonomiczną nawigację, rozpoznawanie wzorców i planowanie strategiczne. Program taki jak Strategiczna Inicjatywa Obliczeniowa (SCI) z lat 80. miał jeden jasno określony cel: osiągnięcie "pełnej inteligencji maszynowej" na potrzeby armii.

Ta historyczna linia nie została przerwana. Dziś strumień pieniędzy płynących z Pentagonu do laboratoriów AI jest większy niż kiedykolwiek. W kwietniu 2025 r. Siły Powietrzne USA odnowiły i rozszerzyły parasolowy kontrakt z MIT Lincoln Laboratory – federalnym centrum badawczo-rozwojowym (FFRDC) – o łącznym limicie 12,2 mld dol., obejmujący wieloletnie badania, prototypowanie i wsparcie technologiczne dla Departamentu Obrony. Zaledwie dwa miesiące później, w czerwcu 2025 r., ta sama formuła FFRDC została wzmocniona w Carnegie Mellon: Software Engineering Institute otrzymał kontrakt o wartości 1,5 mld dol. na zaspokajanie potrzeb operacyjnych DoD w obszarze oprogramowania i sztucznej inteligencji.

Równolegle, w lipcu 2025 r., powołane w Pentagonie Biuro Głównego Specjalisty ds. Cyfryzacji i Sztucznej Inteligencji (CDAO) podpisało cztery bliźniacze umowy – po 200 mln dol. każda – z OpenAI, Google, Anthropic i xAI. Oficjalny cel jest prosty i wymowny: "przyspieszenie adaptacji zaawansowanej AI przez DoD", czyli włączenie modeli generatywnych i narzędzi uczenia maszynowego bezpośrednio w łańcuch decyzyjny i logistykę wojska.

Nie są to jednak wyłącznie pieniądze dla "wielkiej czwórki" AI. DARPA w maju 2020 r. przyznała 30,1 mln dol. Uniwersytetowi Stanforda na Projekt Pronto – badania bezpieczeństwa infrastruktury internetowej i komunikacji o znaczeniu strategicznym. A już od maja 2019 r. działa MIT–Air Force AI Accelerator, finansowany na poziomie ok. 15 mln dol. rocznie, łączący naukowców z wojskowymi zespołami wdrożeniowymi.

Te kilka przykładów – od kontraktów FFRDC po programy CDAO i granty DARPA – pokazuje skalę i ciągłość finansowania: miliardy dolarów kierowane do uczelni i prywatnych firm nie są marginesem, lecz główną arterią współczesnego ekosystemu AI. Innymi słowy, sztuczna inteligencja nie "została zmilitaryzowana" po fakcie – ona po prostu nadal powstaje w rytmie budżetów obronnych.

Ta militarna genealogia łączy się z jeszcze mroczniejszym dziedzictwem. Ideologia optymalizacji, która leży u serca Doliny Krzemowej, ma swój przerażający precedens w wykorzystaniu przez nazistowskie Niemcy technologii kart perforowanych od filii IBM do usprawnienia Holokaustu. Ta sama logika, która sprowadzała osobę do sortowalnego punktu danych w celu efektywnej eksterminacji, działa, gdy dzisiejszy system sprowadza ludzką tożsamość do problematycznej etykiety w celu efektywnej klasyfikacji. Skala szkód jest nieporównywalna, ale podstawowa, dehumanizująca logika jest przerażająco podobna.

Wpływ wojska nie jest zatem jedynie finansowy – jest przede wszystkim ideologiczny. Przez dekady finansowania badań rozwiązujących konkretne problemy militarne – identyfikację celów, przewidywanie ruchów wroga, automatyzację broni – ukształtowano samą definicję "inteligencji" w AI. Postęp w tej dziedzinie stał się tożsamy z rozwojem coraz bardziej wyrafinowanych form obliczeniowej kontroli, nadzoru i dominacji strategicznej. Inteligencja, którą budujemy, nie jest zatem uniwersalną, podobną do ludzkiej świadomością, lecz specyficzną, zmilitaryzowaną formą poznania, której podstawowe cele zostały zdefiniowane przez jej pierwszego i najważniejszego patrona.

Sztuczna inteligencja nigdy nie zdjęła munduru. Nałożyła tylko na niego bluzę z kapturem.

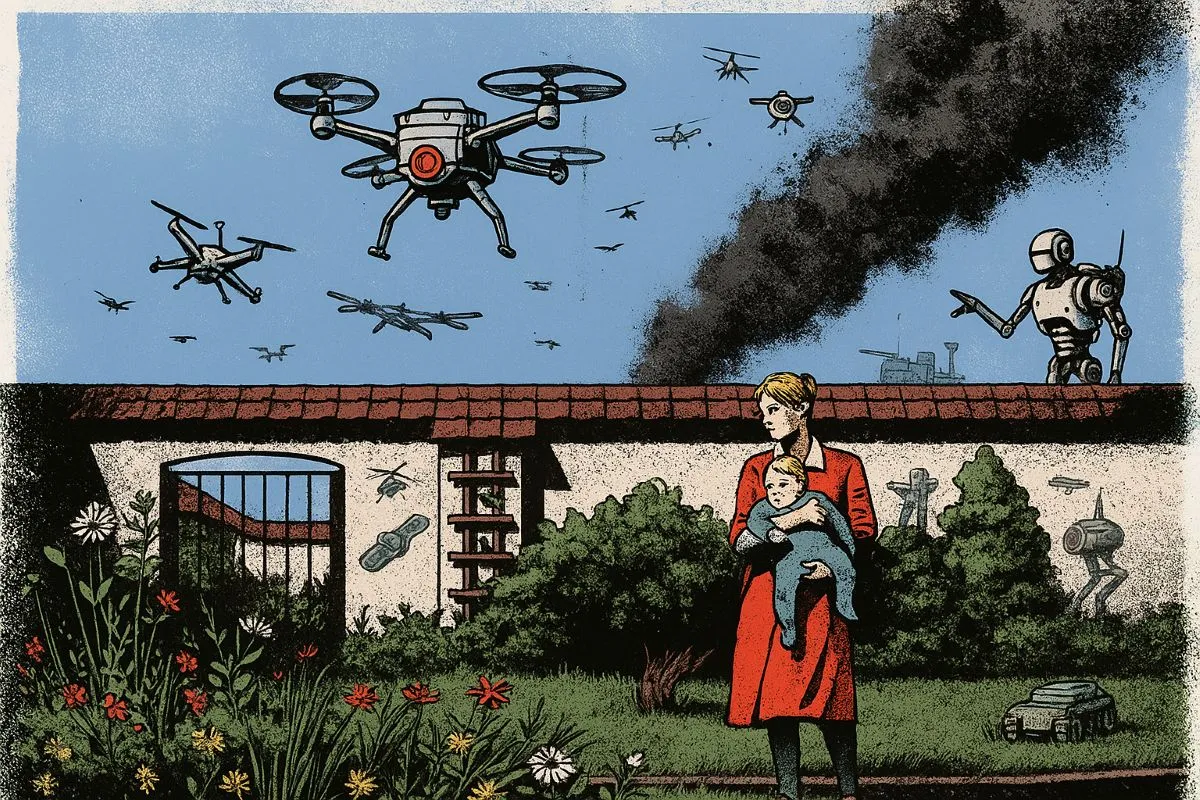

Fundamentalnym elementem architektury wyparcia jest mit, jakoby sztuczna inteligencja była neutralnym, akademickim przedsięwzięciem, które dopiero później zostało niefortunnie wykorzystane do celów militarnych. Historia pokazuje jednak coś dokładnie odwrotnego. Fot: ChatGPT

IV. Za murem

Przez dekady militaryzacja AI odbywała się w cieniu, za zasłoną tajemnicy wojskowej i korporacyjnego PR. Dziś jednak konsekwencje algorytmu obojętności nie są już hipotetyczną groźbą. Stają się w pełni widoczną, zautomatyzowaną rzeczywistością, a "drugi dźwięk" zza muru zamienia się w ogłuszający krzyk. Aby to zrozumieć, wystarczy spojrzeć na dwadzieścia sekund z życia systemu:

- 10:47:03

System Lavender identyfikuje cel: Mahmoud A., 34 lata, nauczyciel matematyki.

Algorytm przypisał mu współczynnik prawdopodobieństwa przynależności do Hamasu: 67 proc.

Próg aktywacji: 50 proc.

Status: ZATWIERDZONE DO ELIMINACJI.

- 10:47:08

System "Where's Daddy?" aktywowany. Lokalizacja celu potwierdzona w sieci domowej. Skan rodziny: żona, troje małych dzieci, matka. Łącznie 6 osób.

Dopuszczalny próg strat ubocznych dla celu niskiego priorytetu to 15.

Status: GOTOWE DO ATAKU.

- 10:47:15

Weryfikacja ludzka: dziewiętnastoletni żołnierz patrzy na ekran. Instrukcja: sprawdzić płeć celu. Mężczyzna? Tak.

Klik.

Status: ZATWIERDZONE.

- 10:47:23

System wybiera amunicję: "głupia bomba" (nienaprowadzana), by zaoszczędzić 50 tys. dolarów. Czas do uderzenia: 4 minuty.

Ta spekulacja w warstwie szczegółów opiera się na jak najbardziej realnych ramach. Systemy AI używane przez Siły Obronne Izraela (IDF) w Strefie Gazy – "Habsora" (Ewangelia) i "Lavender" – stanowią przerażającą kulminację wszystkich opisanych wcześniej tendencji. To już nie jest przygotowanie do wojny algorytmicznej. To jej pełna, operacyjna realizacja.

Systemy te spełniają wojskowe marzenie o perfekcyjnej, zoptymalizowanej maszynie do zabijania. "Habsora" to system AI, który masowo generuje cele – budynki, domy, infrastrukturę cywilną – do zniszczenia. "Lavender" idzie o krok dalej: tworzy "listę śmierci" dla 37 tys. osób podejrzewanych o przynależność do Hamasu, przypisując każdej z nich "współczynnik prawdopodobieństwa". Analizuje metadane z telefonów, wzorce ruchu, aktywność w mediach społecznościowych, szukając "sygnatur terrorysty". Co dokładnie jest taką sygnaturą? Nikt nie wie, bo AI to "czarna skrzynka". System sam się uczy, co oznacza bycie "celem".

W tym procesie rola człowieka została zredukowana do groteskowej formalności. Jak donoszą źródła, ludzka weryfikacja celu z listy "Lavender" trwa często nie dłużej niż 20 sekund i sprowadza się do potwierdzenia, że cel jest mężczyzną. Język operatorów tych systemów, przesiąknięty korporacyjną nowomową, mówi o "produkowaniu celów" i dbaniu o efektywność, by po każdym ataku na liście wciąż czekało "kolejnych 36 tysięcy" celów. Uzupełnieniem tego systemu jest program o ironicznej nazwie "Where's Daddy?", który specjalizuje się w namierzaniu celów, gdy te znajdują się w swoich domach, z rodzinami. Prowadzi to do bombardowania całych budynków mieszkalnych, co jest świadomą realizacją doktryny "dahiji", czyli niszczenia otoczenia cywilnego wroga.

Ta zautomatyzowana wojna nie toczy się w technologicznej próżni. Jest bezpośrednio połączona z Doliną Krzemową. Obrazy satelitarne o rozdzielczości 30 cm – wystarczającej, by odróżnić dziecko od dorosłego – dostarcza firma Maxar, której dane wykorzystuje Google Maps. Przetwarzanie danych odbywa się na serwerach Amazon Web Services (AWS) w Tel Awiwie. Microsoft, w ramach kontraktu IVAS wartego potencjalnie 22 miliardy dolarów, dostarcza armii zmilitaryzowaną wersję gogli HoloLens, których celem jest, jak ujęto to w dokumentach, „zwiększyć śmiertelność” (lethality) żołnierzy. A u podstaw tych systemów leżą te same technologie, jak framework TensorFlow od Google'a, które Fei-Fei Li wykorzystała do stworzenia ImageNet.

Fei-Fei Li marzyła o AI, która "widzi i rozumie świat jak człowiek". Ale jej historia, jak i historia całej Doliny Krzemowej, doprowadziła do czegoś odwrotnego: do AI, która nauczyła ludzi widzieć świat jak maszyny. W centrach dowodzenia oficerowie patrzą na ekrany i widzą nie ludzi, ale „cele”, nie domy, ale "struktury", nie rodziny, ale "klastry". Pojęcie "winy" zostaje zastąpione przez "współczynnik prawdopodobieństwa".

Prawo do obrony zostaje wyeliminowane przez klasyfikację algorytmiczną. To właśnie Dolina Krzemowa dała wojnie nowy język – język, w którym ludobójstwo brzmi jak prezentacja kwartalna.

Gdy "eliminacja" zastąpiła "morderstwo", a "metryka" zastąpiła "moralność", systemy takie jak Lavender stały się nieuniknione. Odpowiedzialność nie jest już tylko rozproszona; zostaje całkowicie scedowana na maszynę. To ostateczny wyraz algorytmu obojętności – system, który zabija bez podmiotu odpowiedzialnego za zabójstwo.

V. Usłyszeć drugi dźwięk

Po konfrontacji z najmroczniejszymi konsekwencjami algorytmu obojętności łatwo ulec poczuciu bezsilności. Jednak obecna trajektoria rozwoju AI nie jest nieunikniona. Konstrukcje obojętności zostały zbudowane przez ludzi i przez ludzi mogą zostać zburzone. Na obrzeżach technologicznego imperium już dziś powstają alternatywy, które udowadniają, że sztuczna inteligencja może być tworzona w sposób etyczny, transparentny i demokratyczny.

Projekty te nie są marginalnymi eksperymentami, lecz działającymi dowodami.

Mozilla Common Voice to gigantyczny zbiór nagrań głosowych (17 tysięcy godzin w 100 językach) budowany na zasadach, które w Dolinie Krzemowej brzmią jak herezja: prawdziwa zgoda wolontariuszy, pełna transparentność i traktowanie danych jako dobra wspólnego na licencji Creative Commons Zero Zamiast ukrywać ludzką pracę, projekt celebruje ją.

Islandia, kraj mniejszy od Szczecina, udowodniła, że suwerenność technologiczna jest możliwa, tworząc własny otwarty model językowy. Trenowano go na islandzkich tekstach – od sag po wpisy na blogach – w procesie konsultowanym ze społeczeństwem, którego celem jest ochrona kultury, a nie maksymalizacja zysku.

Z kolei Barcelona, poprzez platformę partycypacji obywatelskiej Decidim, pokazała, że dane miejskie to nie "ropa do wydobycia", lecz dobro wspólne do zarządzania przez społeczność, wzmacniając demokrację, zamiast ją osłabiać.

Jednak oddolne inicjatywy to za mało. Przemysł AI działa w próżni odpowiedzialności, w której negatywne skutki są pomijane. Czas to zmienić poprzez wprowadzenie mierzalnych standardów, podobnych do tych, które obowiązują w każdej innej branży. Nazwijmy ten hipotetyczny, lecz w pełni możliwy do wdrożenia standard AIIRS (AI Impact Reporting Standard). Zamiast pustych deklaracji etycznych firmy musiałyby raportować twarde dane w sześciu kluczowych obszarach:

- Indeks budżetu mitygacyjnego: jaki procent przychodów firma przeznacza na naprawę szkód wyrządzonych przez swoje algorytmy?

- Wskaźnik korekcji uprzedzeń: jak często modele są aktualizowane w odpowiedzi na wykryte problemy i dyskryminację?

- Ślad zasobowy: jaki jest prawdziwy koszt środowiskowy działania AI? (Szkolenie GPT-3 wygenerowało tyle CO2, co lot samolotem dookoła świata pięćset razy).

- Czas reakcji na incydent: ile godzin mija od zgłoszenia problemu do jego rozwiązania?

- Ocena podwójnego zastosowania: jaki procent wykorzystania technologii przypada na cele wrażliwe etycznie, jak dezinformacja czy inwigilacja?

- Wskaźnik audytu zgody: jaki procent danych treningowych pochodzi od osób, które świadomie wyraziły na to zgodę? (Dla ImageNet czy Common Crawl wskaźnik ten wynosiłby zero).

Zmiana systemowa zaczyna się jednak od indywidualnej świadomości. Możesz, Czytelniku, przeprowadzić "test własnego ogrodu". Spójrz po prostu w cyfrowe lustro swojego telefonu: które aplikacje zaprojektowane przez psychologów behawioralnych generują w tobie niepokój i uzależnienie? Którą jesteś gotów usunąć, by poczuć dyskomfort – pierwszy usłyszany dźwięk zza muru? A jeśli pracujesz w branży, zacznij mierzyć realne koszty swojej technologii. Albo przynajmniej pomyśl o tym - a gdy nadejdzie dogodny moment, będziesz gotowy do rozmowy o tym. I wreszcie, zaangażuj się politycznie. Pytaj swoich przedstawicieli o strategię cyfrową i domagaj się transparentności algorytmów. Bo, jak widzisz, technologia nie jest neutralna i wymaga demokratycznej kontroli.

Na koniec warto przytoczyć ciekawy fakt. Ten "drugi dźwięk", cichy pomruk ostrzeżeń, był obecny od samego początku. Już w latach 50. pewien matematyk z MIT próbował ostrzec świat. Był nim sam Norbert Wiener, twórca cybernetyki, który w pierwszym wydaniu "The Human Use of Human Beings" (w Polsce ukazała się jako "Cybernetyka i społeczeństwo", podczas gdy oryginalny tytuł podkreślał wykorzystanie ludzi przez ludzi poprzez technologię) przewidział "groźbę nowego faszyzmu zależnego od machine à gouverner" – maszyny sterującej. Ostrzegał przed naukowcami, którzy "są niczym biskupi z ich wpływami we wszystkich sferach życia i zagrożeniem związanym z podatnością na grzechy pychy i żądzy władzy".

Jego koledzy – von Neumann, Shannon, McCarthy – mieli, jak już wiemy, inne plany. Między innymi pod ich naciskiem Wiener wydał w 1954 roku ocenzurowaną wersję książki, pozbawioną najostrzejszych fragmentów i całego, kluczowego w kontekście ostrzeżeń, rozdziału "Voices of Rigidity" (w wolnym tłumaczeniu "Chór skostnienia" – krytyka doktrynerskiej "sztywności" Kościoła, partii komunistycznej i amerykańskiego konserwatyzmu oraz apel o wolną komunikację i zmienność). McCarthy, który nie lubił Wienera, ponoć nawet celowo ukuł termin "sztuczna inteligencja", aby w ten sposób odciąć się od terminu "cybernetyka".

To nie była tylko zmiana nazwy. To było wymazanie pamięci o ostrzeżeniach. "Świat przyszłości będzie areną coraz trudniejszych zmagań z ograniczeniami naszej inteligencji" – pisał Wiener – "a nie wygodnym hamakiem, w którym będziemy leżeć, obsługiwani przez swoje roboty-niewolników".

Tyle że, gdy w 1956 roku w Dartmouth chrzczono nową dziedzinę, Wiener był już persona non grata. Ostrzeżenia, że to, co powstaje, nie może służyć tym, których Wiener krytykował: wojsku, korporacjom, "wielbicielom gadżetów", zostały wyciszone. Stały w poprzek aspiracjom tych, którzy chcieli komercjalizować nowe technologie. Dziś, gdy słyszymy entuzjastyczne przemówienia o świetlanej przyszłości AI, warto pamiętać o tym pierwszym akcie uciszenia. Bo historia lubi się powtarzać – tyle że za każdym razem na większą skalę i z bardziej wyrafinowanymi metodami wyparcia. Od subtelnej zmiany terminologii począwszy.

Sztuka wyboru

Na koniec wracamy do ogrodu. Słychać pierwszy głośny dźwięk – kuszącą melodię postępu, wygody i personalizacji. Ale jeśli się wsłuchasz, usłyszysz też drugi pomruk – szum serwerowni, kliknięcia palców w cyfrowych fabrykach, warkot dronów. Mur, który oddziela te dwa dźwięki, nie jest z betonu. Jest w naszych głowach, zbudowany z wyparcia, iluzji kontroli i rozproszonej odpowiedzialności. Zaniechanie wyboru też jest wyborem. Każdy dzień, który spędzamy w ogrodzie, udając, że nie słyszymy, co dzieje się poza nim, jest głosem za jego istnieniem. Ale drugi dźwięk nie zniknie. Będzie coraz głośniejszy. Aż pewnego dnia obudzimy się i zdamy sobie sprawę, że żyjemy w "strefie interesów". I będziemy musieli zdecydować, jaką rolę chcemy w niej odegrać.

—

Pełna wersja eseju, rozszerzona o szereg wątków, informacji i danych, znajduje się tutaj: https://www.linkedin.com/pulse/jak-budujemy-algorytm-oboj%25C4%2599tno%25C5%259Bci-czyli-fei-fei-li-w-dzisiejszej-jan-du4te/

Tagi:

Najnowsze

Aktualizacja: 2026-03-11T19:44:20+01:00

Aktualizacja: 2026-03-11T19:02:10+01:00

Aktualizacja: 2026-03-11T18:29:09+01:00

Aktualizacja: 2026-03-11T17:55:53+01:00

Aktualizacja: 2026-03-11T17:48:43+01:00

Aktualizacja: 2026-03-11T16:52:46+01:00

Aktualizacja: 2026-03-11T16:42:06+01:00

Aktualizacja: 2026-03-11T15:55:46+01:00

Aktualizacja: 2026-03-11T15:35:38+01:00

Aktualizacja: 2026-03-11T15:03:48+01:00

Aktualizacja: 2026-03-11T14:21:24+01:00

Aktualizacja: 2026-03-11T13:39:12+01:00

Aktualizacja: 2026-03-11T13:24:44+01:00

Aktualizacja: 2026-03-11T12:14:57+01:00

Aktualizacja: 2026-03-11T11:32:16+01:00

Aktualizacja: 2026-03-11T10:33:12+01:00

Aktualizacja: 2026-03-11T09:21:58+01:00

Aktualizacja: 2026-03-11T08:29:13+01:00

Aktualizacja: 2026-03-11T08:00:43+01:00

Aktualizacja: 2026-03-11T07:24:19+01:00

Aktualizacja: 2026-03-11T06:45:00+01:00

Aktualizacja: 2026-03-11T06:34:00+01:00

Aktualizacja: 2026-03-11T06:23:00+01:00

Aktualizacja: 2026-03-11T06:12:00+01:00

Aktualizacja: 2026-03-11T06:01:00+01:00

Aktualizacja: 2026-03-10T20:03:37+01:00

Aktualizacja: 2026-03-10T19:10:13+01:00

Aktualizacja: 2026-03-10T18:50:41+01:00

Aktualizacja: 2026-03-10T18:45:26+01:00

Aktualizacja: 2026-03-10T17:28:11+01:00

Aktualizacja: 2026-03-10T17:15:29+01:00

Aktualizacja: 2026-03-10T17:04:30+01:00

Aktualizacja: 2026-03-10T16:47:26+01:00

Aktualizacja: 2026-03-10T16:27:01+01:00

Aktualizacja: 2026-03-10T16:01:48+01:00

Aktualizacja: 2026-03-10T15:53:10+01:00

Aktualizacja: 2026-03-10T13:49:27+01:00

Aktualizacja: 2026-03-10T13:05:38+01:00

Aktualizacja: 2026-03-10T12:33:12+01:00

Aktualizacja: 2026-03-10T11:09:08+01:00