Trudno ufać rewolucji AI. I wcale nie chodzi o politykę, lecz po prostu o matematykę

Wyobraź sobie świat, w którym kalkulator czasem twierdzi, że 2+2=5. Albo taki, w którym program księgowy spontanicznie wymyśla transakcje, których nigdy nie było. Brzmi absurdalnie? A jednak w ten właśnie świat wkraczamy wraz z obecną rewolucją sztucznej inteligencji.

Od zarania ery cyfrowej istniał jeden niepodważalny fundament - komputery mogły się zawieszać, mieć problemy z drukarkami czy irytować użytkowników niebieskimi ekranami śmierci, ale liczenia potrafiły wykonywać bezbłędnie. Ten fundament zaufania, budowany przez dekady, jest teraz systematycznie podważany przez to, co eksperci nazywają halucynacjami AI.

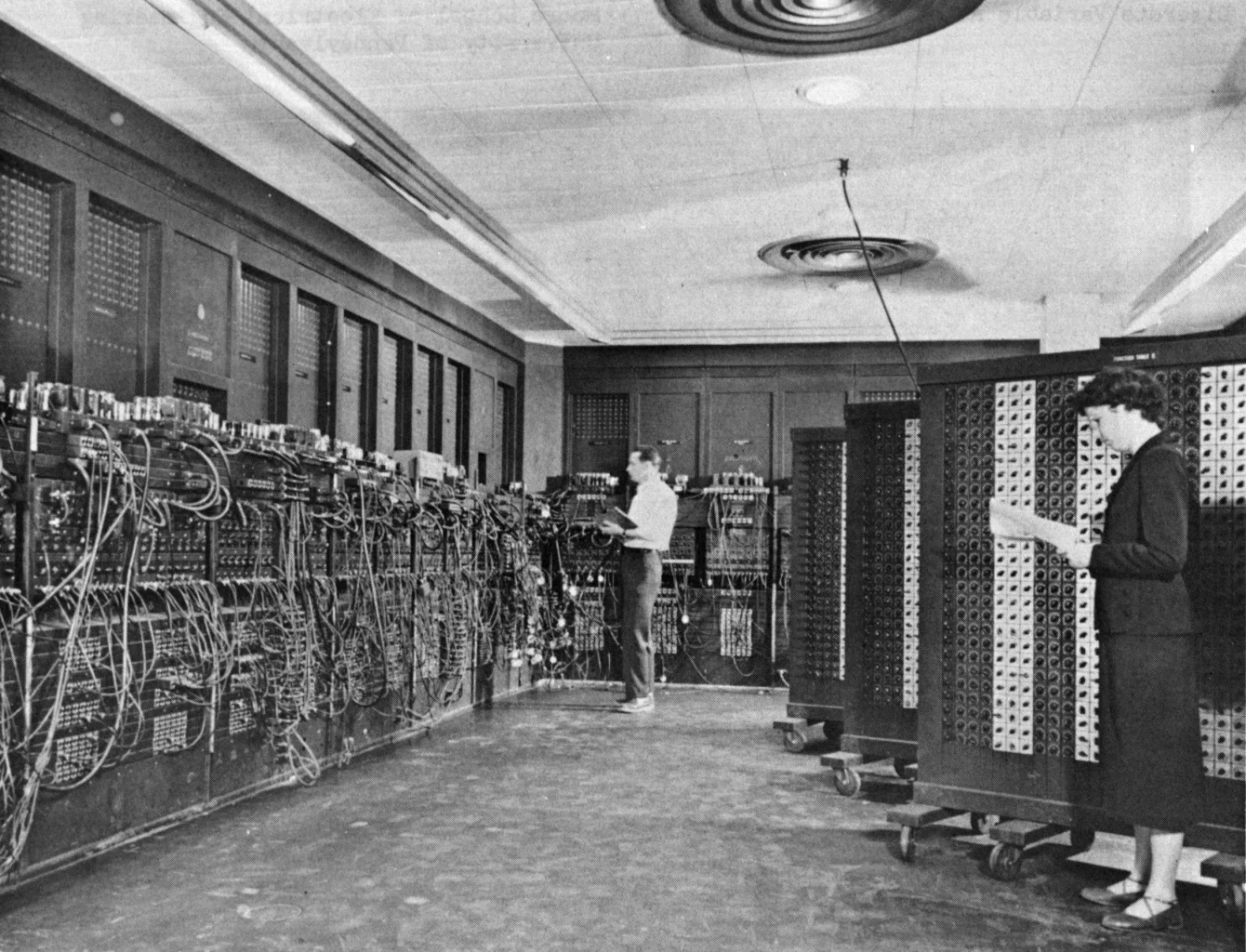

Historia komputerów rozpoczyna się nie od mediów społecznościowych czy gier wideo, lecz od potrzeby wykonywania złożonych obliczeń. Pierwszy elektroniczny komputer ogólnego przeznaczenia, ENIAC, zajmował prostokąt o wymiarach 7 na 13 metrów i zawierał prawie 18 tys. lamp oraz tysiące przekaźników. To imponujące urządzenie miało za zadanie obliczać tablice zasięgu pocisków dla artylerii oraz wspierać prace nad bombą wodorową. W ciągu sekundy potrafiło wykonać 5000 dodawań, 350 mnożeń lub 40 dzieleń - osiągi, które ówcześni dziennikarze określali jako szybciej niż myśl.

To też jest ciekawe:

Od tamtego czasu minęło ponad 75 lat, a komputery przeszły niezwykłą transformację. Z wypełniających całe pomieszczenia kolosów zmieniły się w urządzenia, które nosimy w kieszeniach. Jednak mimo wszystkich rewolucji technologicznych, ich podstawowa funkcja pozostała niezmienna - komputery to wciąż przede wszystkim maszyny liczące.

Excel - matematyka, której możesz zaufać

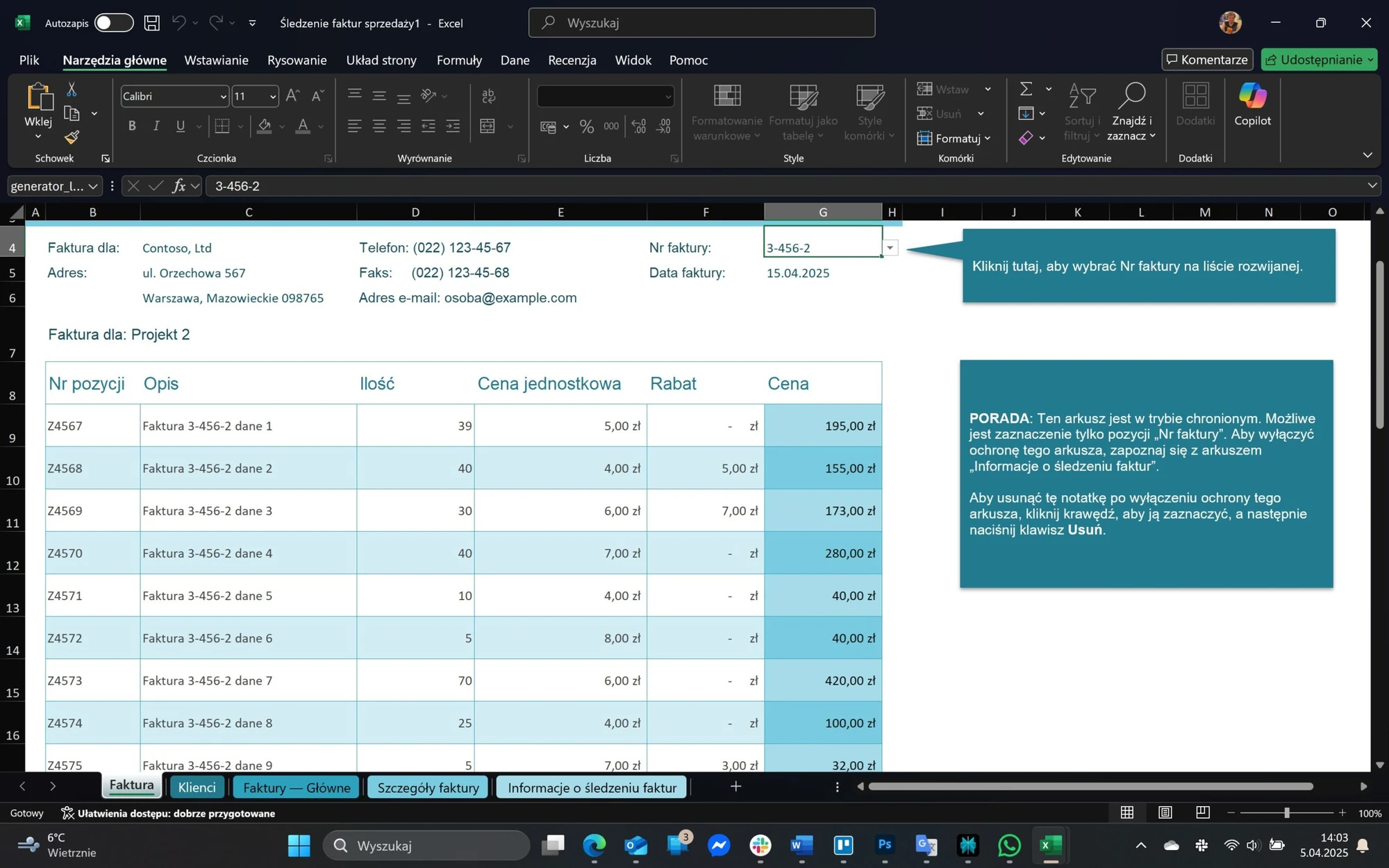

Doskonałym przykładem tej ciągłości jest Microsoft Excel - program, który w swojej istocie pozostaje zaawansowanym, wizualnym kalkulatorem. W ciągu ostatnich dekad Excel stał się fundamentem światowej gospodarki - od małych firm po największe korporacje, od planowania budżetów domowych po złożone modele finansowe Wall Street. I choć Excel bywa krytykowany za różne niedoskonałości, jedno pozostaje pewne - jego obliczenia są niezawodne.

Oczywiście w Excelu też mogą pojawić się błędy. Typowym przykładem jest komunikat #VALUE!, który pojawia się, gdy próbujemy wykonać operacje matematyczne na tekście zamiast na liczbach. Ale - i to kluczowa różnica - takie błędy mają zawsze jasno określone przyczyny i rozwiązania. Co więcej, Excel nigdy nie zgaduje ani nie wymyśla wyników obliczeń. Funkcja =SUMA(A1:A10) zawsze da dokładnie taki sam rezultat dla tych samych danych wejściowych, niezależnie od tego, czy wykonujemy ją po raz pierwszy, czy tysięczny.

Zobacz także: Jak zrobić film za pomocą AI? Oto najlepsze narzędzia

Ten deterministyczny charakter tradycyjnego oprogramowania budował przez dekady nasze zaufanie do komputerów. Mogliśmy narzekać na interfejs, szybkość działania czy kompatybilność, ale nigdy nie kwestionowaliśmy matematycznej poprawności wyników.

Halucynacje AI - gdy matematyka zaczyna fantazjować

I tu dochodzimy do sedna problemu z obecną rewolucją AI. Nowoczesne modele sztucznej inteligencji, szczególnie tzw. duże modele językowe (LLM), fundamentalnie różnią się od tradycyjnego oprogramowania. Nie są zaprogramowane, by wykonywać konkretne, deterministyczne operacje, lecz by rozpoznawać wzorce w ogromnych zbiorach danych i na ich podstawie generować prawdopodobne odpowiedzi.

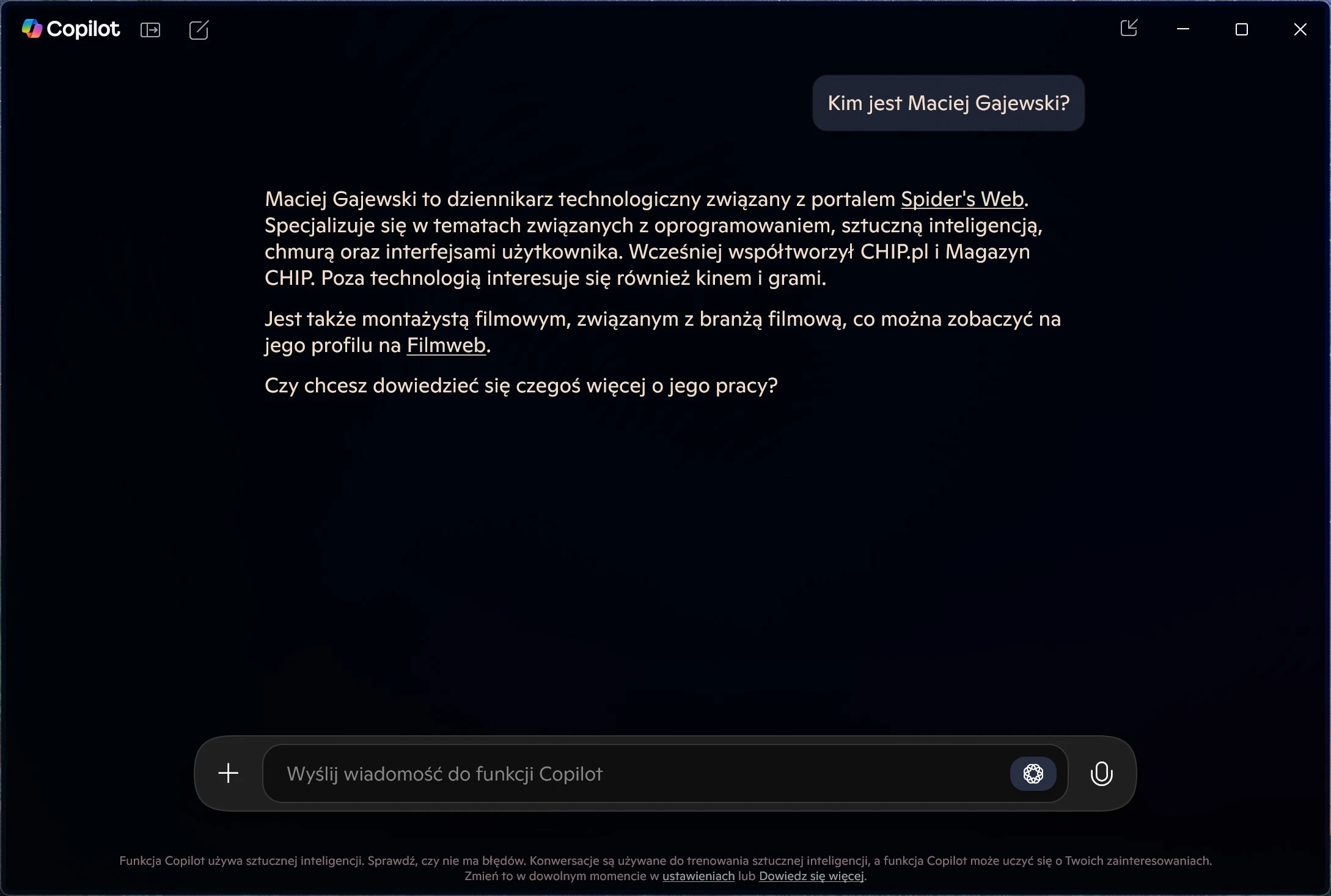

Ta fundamentalna zmiana w architekturze prowadzi do zjawiska, które eksperci nazywają halucynacjami AI - przypadków, w których modele sztucznej inteligencji generują informacje, które wydają się prawdziwe, ale są całkowicie nieprawidłowe lub niezwiązane z rzeczywistością. Co istotne te halucynacje nie są przypadkowymi błędami, ale wynikają z samej natury tych systemów - ze złożonych interakcji w danych treningowych, z konstrukcji modelu oraz ze sposobu, w jaki model interpretuje zapytania.

Najbardziej niepokojące jest to, że halucynacje AI często są podawane z takim samym poziomem pewności jak informacje faktyczne. Model może z równą pewnością stwierdzić, że Warszawa jest stolicą Polski (co jest prawdą) i że w 1995 r. odbyła się w niej olimpiada letnia (co jest kompletną fikcją). Dla użytkownika, zwłaszcza niespecjalisty, rozróżnienie między faktem a halucynacją może być niezwykle trudne.

Skala problemu halucynacji

Choć dokładne statystyki dotyczące częstotliwości występowania halucynacji AI są trudne do ustalenia, eksperci są zgodni - to powszechny problem, który dotyka wszystkich dużych modeli językowych. Najbardziej podatne na halucynacje są systemy, które nie posiadają skutecznych mechanizmów weryfikacji informacji, opierają się na przestarzałych danych oraz nie potrafią prawidłowo interpretować kontekstu zapytań.

Przyczyny halucynacji są złożone i wielowarstwowe. Wśród głównych czynników eksperci wskazują:

- Niedoskonałości danych treningowych - jeśli dane, na których trenowany jest model, zawierają błędy, nieścisłości lub sprzeczne informacje, model może je powielać lub generować nowe, nieprawdziwe treści.

- Przeuczenie modelu - sytuacja, gdy algorytm zbyt precyzyjnie dopasowuje się do zestawu danych treningowych, tracąc zdolność do uogólniania i poprawnego rozpoznawania nowych wzorców.

- Wadliwe założenia w konstrukcji modelu - jeśli projektanci AI oparli swoje rozwiązanie na błędnych założeniach, model może systematycznie generować halucynacje.

Konkretne przykłady systemów AI szczególnie podatnych na halucynacje to m.in. chińskie rozwiązania takie jak Qwen i DeepSeek, które mimo zaawansowania technologicznego wciąż zmagają się z tym problemem.

Problem zaufania - 98 proc. to wciąż za mało

I tu dochodzimy do fundamentalnego problemu zaufania. W tradycyjnym oprogramowaniu błędy były wyjątkiem, a nie regułą. W przypadku AI halucynacje są nieodłącznym elementem funkcjonowania systemu. Nawet jeśli model generuje poprawne informacje w 98 proc. przypadków, to pozostałe 2 proc. stanowi poważny problem.

Wyobraźmy sobie, że korzystamy z kalkulatora, który w 98 proc. przypadków podaje prawidłowy wynik, a w 2 proc. wymyśla odpowiedź. Czy zaufalibyśmy takiemu urządzeniu przy obliczaniu podatków, dawkowania leków czy projektowaniu mostu? Odpowiedź jest oczywista.

Problem halucynacji AI jest szczególnie istotny w zastosowaniach, w których wymagana jest pełna dokładność i poprawność merytoryczna - w medycynie, prawie, finansach czy inżynierii. W tych dziedzinach nawet minimalne prawdopodobieństwo błędu może prowadzić do katastrofalnych konsekwencji.

Excel kontra AI - kalkulacja kontra konfabulacja

Gdy w Excelu pojawia się błąd #VALUE!, program jasno informuje nas, że coś poszło nie tak. Nie próbuje zgadywać wyniku ani ukrywać problemu. Dodatkowo istnieją jasne wytyczne, jak taki błąd rozwiązać - np. upewniając się, że w formule matematycznej wszystkie wartości są liczbami, a nie tekstem.

Z kolei w przypadku systemu AI, gdy model nie zna odpowiedzi, często zamiast przyznać się do niewiedzy generuje przekonująco brzmiącą, ale fałszywą odpowiedź. Co gorsza, użytkownik może nawet nie zdawać sobie sprawy, że otrzymana informacja jest halucynacją.

Według raportu Salesforce State of Data and Analytics niemal 9 na 10 (87 proc.) analityków i liderów IT zgadza się, że postęp w sztucznej inteligencji sprawił, że zarządzanie danymi staje się coraz wyższym priorytetem. Jednak ten sam raport wskazuje na brak zaufania respondentów do dokładności danych oraz na obawy związane z bezpieczeństwem danych w kontekście AI.

Koszt weryfikacji - ukryta wada AI

Zwolennicy AI argumentują, że problem halucynacji można rozwiązać poprzez weryfikację informacji. Faktycznie, factchecking i weryfikacja efektów pracy z AI stają się niezbędnymi praktykami w każdej organizacji wykorzystującej te technologie. Problem w tym, że konieczność weryfikacji drastycznie obniża wartość tych systemów.

Wyobraźmy sobie następującą sytuację - zlecamy asystentowi AI napisanie raportu o rynku aut elektrycznych w Polsce. System generuje 20-stronicowy dokument pełen statystyk, trendów i prognoz. Dokument wygląda profesjonalnie i zawiera przekonujące argumenty. Problem w tym, że nie wiemy, które z tych informacji są prawdziwe, a które zostały wyhalucynowane. Aby to ustalić musimy sprawdzić każdą statystykę, każde twierdzenie, każdy fakt. A to oznacza, że de facto musimy wykonać pracę, którą miał za nas zrobić system AI.

To fundamentalny paradoks obecnej rewolucji AI - systemy, które miały oszczędzać nasz czas, często wymagają dodatkowej pracy związanej z weryfikacją ich wyników. W przypadku tradycyjnego oprogramowania, takiego jak Excel, mogliśmy po prostu zaufać wynikom obliczeń i skupić się na interpretacji danych.

Złość na matematycznie niedoskonały świat

Brak zaufania do systemów AI to nie kwestia technofobii czy oporu przed zmianą. To racjonalna odpowiedź na fundamentalną zmianę paradygmatu w relacji człowiek-komputer. Przez dekady budowaliśmy relację opartą na deterministycznej niezawodności maszyn liczących. Teraz wkraczamy w erę probabilistycznych modeli, które z samej swojej natury nie mogą zagwarantować takiej samej pewności.

Być może najtrafniej ujmuje to analogia do ludzkiej komunikacji. Tradycyjne oprogramowanie jest jak encyklopedia - może być niekompletna lub zawierać przestarzałe informacje, ale to, co w niej jest, można uznać za sprawdzone. Z kolei AI przypomina rozmowę z człowiekiem, który ma imponującą, ale niedoskonałą wiedzę - czasem się myli, czasem konfabuluje, a czasem przeinacza fakty.

I choć ta analogia może wydawać się atrakcyjna, to w kontekście komputerów oznacza fundamentalny regres w kwestii niezawodności. Od maszyn zawsze oczekiwaliśmy większej precyzji niż od ludzi. Teraz paradoksalnie musimy weryfikować wyniki pracy AI z taką samą ostrożnością, z jaką podchodzilibyśmy do informacji od przypadkowej osoby.

W poszukiwaniu matematycznej pewności

Czy oznacza to, że powinniśmy całkowicie odrzucić AI? Absolutnie nie. Systemy sztucznej inteligencji mają ogromny potencjał w wielu dziedzinach - od generowania kreatywnych treści po analizę ogromnych zbiorów danych. Problem polega na tym, że musimy nauczyć się nowego sposobu współpracy z tymi systemami - sposobu uwzględniającego ich fundamentalne ograniczenia.

Obecnie trwają intensywne badania nad metodami ograniczania halucynacji AI. Wśród proponowanych rozwiązań znajdują się poprawa jakości danych treningowych (im lepsze dane, tym mniejsza szansa na halucynacje), opracowanie bardziej przejrzystych metodologii szkoleniowych (modele, których działanie można zrozumieć i wyjaśnić, są mniej podatne na generowanie fałszywych informacji) i rozwój mechanizmów weryfikacji faktów (systemy, które automatycznie sprawdzają generowane treści pod kątem zgodności z wiarygodnymi źródłami).

Nowa etyka cyfrowej rzeczywistości

Obecna rewolucja AI wymaga od nas nie tylko nowych narzędzi i metodologii, ale także nowej etyki cyfrowej. Musimy na nowo zdefiniować, czym jest zaufanie w relacji człowiek-maszyna, jakie są granice odpowiedzialności za błędy generowane przez AI oraz jak chronić się przed dezinformacją w świecie, gdzie granica między faktem a fikcją staje się coraz bardziej rozmyta.

Według raportu Salesforce badającego zaufanie do danych w erze AI, zagrożenia bezpieczeństwa i brak harmonizacji danych utrudniają ich wiarygodność. Podczas gdy brak zaufania podkreśla walkę firm o wykorzystanie danych jako podstawy rozwiązań opartych na sztucznej inteligencji, to jednak największym wyzwaniem wśród ankietowanych są zagrożenia bezpieczeństwa danych.

Jest to szczególnie istotne w kontekście tzw. generatywnej sztucznej inteligencji, która niesie ze sobą dodatkowe ryzyko wycieku zastrzeżonych danych firmowych do publicznych, dużych modeli językowych.

Zamiast zakończenia

Nie ufam bieżącej rewolucji AI nie dlatego, że nie dostrzegam jej potencjału, ale dlatego, że rozumiem jej fundamentalne ograniczenia. Przez dekady budowaliśmy naszą cywilizację cyfrową na fundamencie niezawodnych obliczeń - od pierwszych mechanicznych kalkulatorów, przez monumentalny ENIAC, aż po wszechobecne dziś arkusze kalkulacyjne. Ta matematyczna pewność była gwarantem postępu w niezliczonych dziedzinach życia.

Obecna fala AI wprowadza nas w świat probabilistyczny, gdzie 98 proc. pewności to nowa norma. I choć dla wielu zastosowań może to być wystarczające, to w kluczowych obszarach - takich jak medycyna, finanse czy bezpieczeństwo - potrzebujemy znacznie wyższych standardów.

Prawdziwe wyzwanie polega więc na tym, by czerpać z potencjału AI, jednocześnie nie tracąc z oczu matematycznej pewności, która przez dekady była fundamentem naszego zaufania do technologii. Bo choć komputery mogą teraz rozmawiać, tworzyć obrazy i pisać poezję, to nadal ich najważniejszą funkcją pozostaje bezbłędne liczenie - ta sama funkcja, którą pełniły, gdy wypełniały całe pomieszczenia i były obsługiwane przez zespoły naukowców w białych fartuchach. Bo w świecie, gdzie coraz trudniej odróżnić fakty od fikcji, matematyczna pewność staje się wartością cenniejszą niż kiedykolwiek wcześniej.