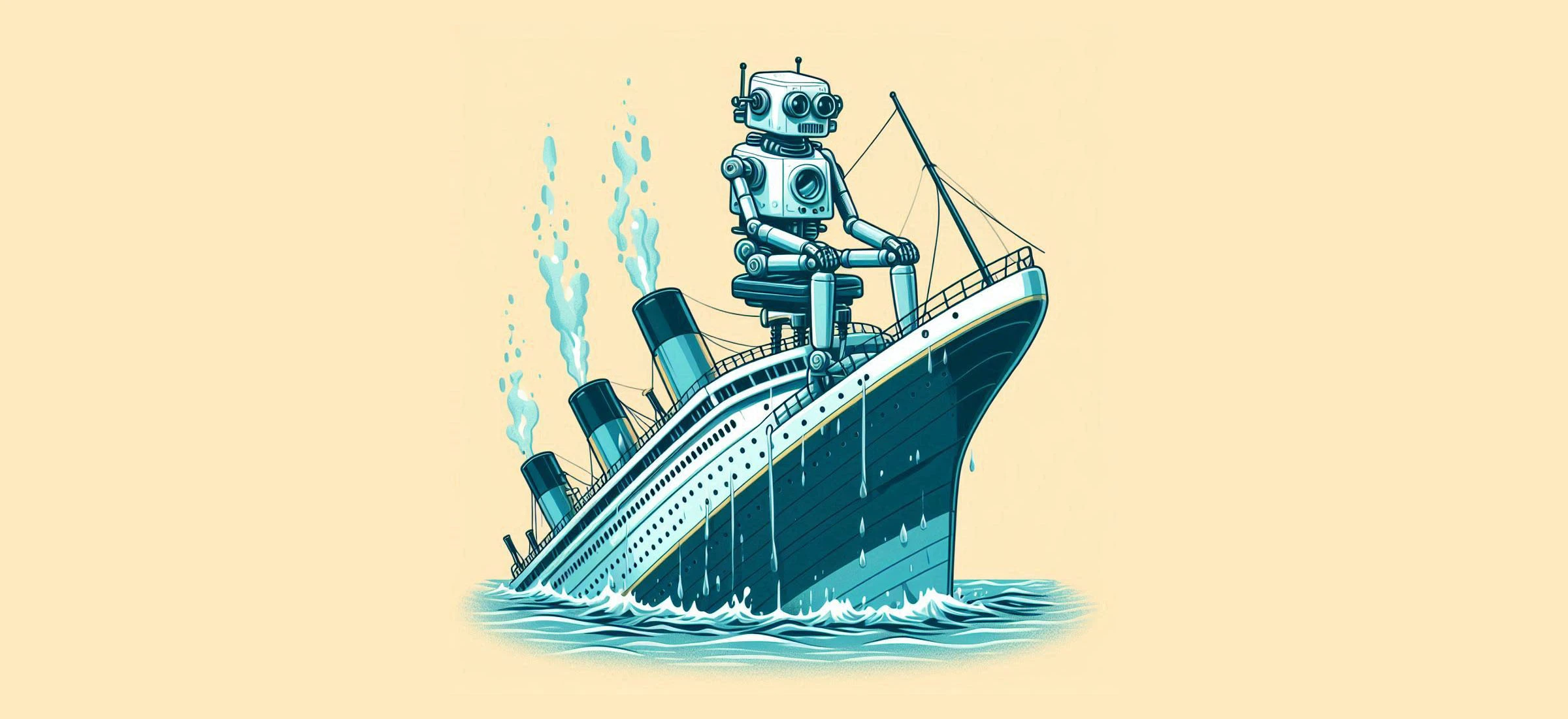

Uciekł z najważniejszej firmy AI na rynku. Mówi o katastrofie i Titanicu

Według byłego pracownika OpenAI twórcy ChatGPT i twórcy Titanica mają ze sobą więcej wspólnego, niż myślisz. Inżynier odszedł z pracy, gdyż jego zdaniem podejście do zabezpieczeń silnej sztucznej inteligencji mało się różniło od niedbałości o wystarczającą liczbę szalup.

W ostatnich miesiącach OpenAI przeszło przez wiele zawirowań. Choć firma jest obecnie jedną z najbardziej liczących się w świecie technologii, a jej dyrektor generalny przyjmowany jest przez głowy państw.

Jednak po drugiej stronie kurtyny stoją liczne przetasowania w zarządzie OpenAI, jej relacje z Microsoftem i Elonem Muskiem, a także fakt, że OpenAI często musi się tłumaczyć z działania swoich modeli AI i podejmowanych decyzji. Ponadto firma ma także rzeszę byłych pracowników, którzy opowiadają, jak było w szeregach firmy.

OpenAI niczym White Star Line. Według inżyniera AI, obie tworzą Titanica

Jednym z nich jest Wiliam Saunders, który ostatnio udzielił wypowiedzi w podcaście youtubera Alexa Kantrowitza. Saunders pracował przez trzy lata dla OpenAI jako członek zespołu Superaligment, którego zadaniem było opracowanie rozwiązań technicznych i technologicznych pozwalających na kontrolę "superinteligentnych systemów sztucznej inteligencji". Zespół Superalignment został rozwiązany w maju bieżącego roku.

Saunders opuścił OpenAI w lutym bieżącego roku i jak opisuje, nie chciał on być częścią zespołu budującego "Titanica wśród AI".

Naprawdę nie chciałem skończyć pracując dla Titanica sztucznej inteligencji, dlatego zrezygnowałem. Podczas moich trzech lat w OpenAI czasami zadawałem sobie pytanie: Czy ścieżka, którą podążało OpenAI, bardziej przypominała program Apollo, czy raczej Titanica?

Program Apollo to seria amerykańskich lotów kosmicznych, których celem było lądowanie człowieka na Księżycu i jego bezpieczny powrót na Ziemię. Zadanie to zostało zrealizowane w 1969 roku podczas misji Apollo 11.

Jak wyjaśnia inżynier, porównanie do Titanica wynika z faktu, że jego twórcy uważali statek za niezatapialny i wobec czego zdecydowali, że na statku ma znacznie mniej szalup ratunkowych niż pasażerów - i co tragicznie zweryfikowała praktyka.

Według Saundersa postępowanie zarządu OpenAI jest podobne, gdyż jego zdaniem "priorytetowo traktowane są nowe, lśniące produkty" niż kwestie bezpieczeństwa rozwijanych produktów. Jego zdaniem katastrofa AI porównywalna z Titanikiem mogłaby mieć postać silnej sztucznej inteligencji, która "samodzielnie kieruje cyberatakiem na dużą skalę, pomaga tworzyć broń biologiczną czy próbuje zwieść ludzi w kampanii informacyjnej".

Dołączając do OpenAI inżynier miał nadzieję, że firma będzie miała podejście podobne do tego, jakie NASA miała podczas programu Apollo.

Nawet gdy zdarzały się duże problemy, jak w przypadku Apollo 13, mieli wystarczająco dużo redundancji i byli w stanie dostosować się do sytuacji, aby bezpiecznie sprowadzić wszystkich z powrotem.

Redakcja serwisu Business Insider zauważyła, że program Apollo nie był idealny i również naznaczony był ludzkimi błędami i przeoczeniami. Wobec czego Saunders doprecyzował, że silnej sztucznej inteligencji - czyli głównego zainteresowania zespołu Superalignment - nie da się stworzyć bez żadnego ryzyka. Inżynier chciałby, aby OpenAI bardziej poważnie podeszło do potencjalnych zagrożeń i "podjęło wszelkie możliwe kroki w cel zapobiegnięcia im".

Więcej na temat OpenAI: