Google wyjaśnił, jak działa tryb portretowy w Pixelu 4. Jest kilka niespodzianek

Google Pixel 3 miał aparat z tylko jednym obiektywem, a dawał świetne rozmycie w zdjęciach portretowych. Pixel 4 z podwójnym układem działa jeszcze lepiej. Google tłumaczy, jak to osiągnął.

Smartfony Google Pixel mają niewątpliwie jedne z najlepszych aparatów na rynku mobilnym. Pixel 2 i 3 były w swoim czasie wyznacznikiem jakości zdjęć i to pomimo faktu, ze miały zaledwie jeden obiektyw.

Google długo opierał się przed dodawaniem nowych szkiełek, choć konkurencja ochoczo korzystała z tej możliwości. Mimo to Pixel 2 nawiazywał z konkurentami wyrównaną walkę nawet w tak wymagającej dziedzinie, jak rozmycie tła w trybie portretowym. Pixel 3 jeszcze bardziej poprawił ten mechanizm.

Google wyjaśnia tryb portretowy w Pixelu 4. Jest kilka niespodzianek.

Google na swoim blogu przedstawił sposób, w jaki działa tryb portretowy Pixela 4. Uwielbiam takie wpisy, bo mało który producent chwali się, jak robienie zdjęć działa od zaplecza.

Pixel 4 wykorzystuje dwa podstawowe mechanizmy z poprzedników, czyli algorytmy uczenia maszynowego i autofocus fazowy na matrycy dual-pixel. Algorytmy AI porównują zrobione zdjęcie z nieprzebraną bazą zdjęć Google’a, by oszacować, co powinno być ostre, a co jest na drugim planie i ma być rozmyte. W końcu dane pozyskane z naszych fotek w Zdjęciach Google muszą się do czegoś przydać.

Mechanizm dual-pixel AF jest znacznie ciekawszy, bo wykorzystuje autofocus do pozyskiwania informacji o głębi. Jest to możliwe dzięki detekcji fazowej, która w przeciwieństwie do detekcji kontrastu nie ustawia ostrości metodą prób i błędów. Układ AF wie, czy w danej chwili ostrzy przed czy za obiektem, a te dane mogą posłużyć do określenia odległości między obiektami.

Z kolei komórki dual-pixel bazują na połówkach piksela, które są odczytywane jedna po drugiej. W dużym skrócie, działa to mniej więcej tak, jak podwójny obiektyw, tyle że rozstaw między dwoma "obiektywami" (komórkami na matrycy) to pół piksela. Tak ekstremalnie mała różnica pozwala wykryć zależności między pierwszym a drugim planem tylko dla obiektów, które są bardzo blisko obiektywu.

Tym samym Google po raz kolejny korzysta z istniejących rozwiązań w niecodzienny sposób. Układ ustawiania ostrości został zaprzęgnięty do pozyskiwania informacji o głębi sceny.

W Pixelu 4 dochodzi do tego drugi obiektyw.

W trybie portretowym Pixel 4 obserwuje kadr dwoma obiektywami jednocześnie. Są one rozstawione względem siebie w znacznie większej odległości niż pojedyncze piksele, a więc efekt paralaksy (przesunięcia pierwszego planu względem drugiego) jest bardziej zauważalny.

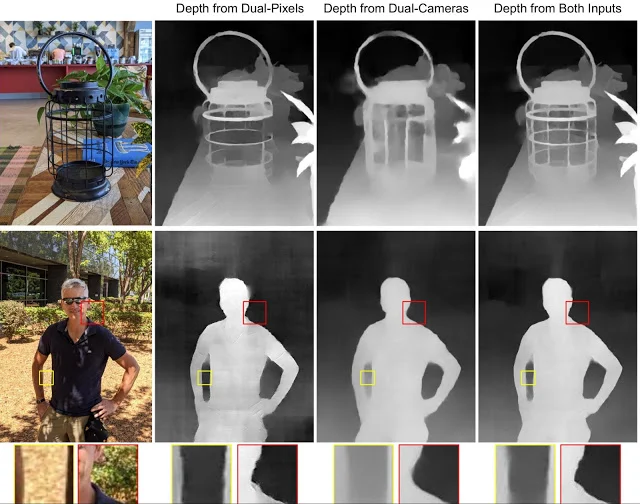

Pixel 4 zbiera informacje z układu dual-piel AF i z podwójnego układu obiektywów, analizuje je i na ich podstawie tworzy mapę głębi. Na blogu Google można zobaczyć, że połączenie obu technik daje znacznie dokładniejszą mapę, niż korzystanie z jednej techniki.

Na koniec Pixel 4 zajmuje się rozmyciem tła.

Główną cechą trybu portretowego jest rozmycie tła. Ten efekt jest uzyskiwany na styku warstwy sprzętowej i programowej. Owszem, wymienione wyżej techniki służą do stworzenia mapy głębi, ale drobne obiektywy z małymi matrycami nie są w stanie rozmyć tła w sposób naturalny, fizyczny. Efekt bokeh jest uzyskiwany przez oprogramowanie, czyli po prostu przez sztuczne rozmycie tego, co według danych z mapy głębi znajduje się dalej.

Rozmycie tła do tej pory było uzyskiwane poprzez nałożenie odpowiedniego filtra na tło. W Pixelu 2 i 3 było to robione na ostatnim etapie, co powodowało nie do końca naturalne efekty. Przed nałożeniem filtra aparat mapował tony, czyli kompresował informacje o światłach i cieniach: wyciągał dane z cieni i przygaszał światła. Filtr rozmywający tło miał więc mniej informacji o najjaśniejszych światłach, a to właśnie one nadają charakter rozmyciu.

Dlatego też w Pixelu 4 rozmycie jest tworzone już na etapie surowych danych RAW, a dopiero później następuje mapowanie tonów. Wymaga to oczywiście większej mocy obliczeniowej, ale przecież nowsze procesory mobilne nie powstają bez powodu. Ten sam system trafił też do Pixela 3 i 3a jako aktualizacja.

Efekt? Mniej pomyłek.

Bardzo podoba mi się, że Google nie mówi o idealnych portretach. Na blogu można przeczytać, że wszystkie te techniki mają sprawić, że na zdjęciach będzie mniej błędów wywołanych złym wykryciem krawędzi i rozpoznaniem tła.

Co więcej, Google podkreśla też ograniczenia swojego aparatu. Im bardziej zbliżymy się do obiektu, tym łatwiej o lepszy bokeh, ale granicą jest odległość 20 cm, ponieważ jest to minimalna odległość ostrzenia teleobiektywu. Poniżej tej wartości aparat wykrywa tło tak, jakby miał tylko jeden obiektyw.

I właśnie dzięki takim sztuczkom fotografia mobilna robi dziś to, co jeszcze kilka lat temu było zarezerwowane dla lustrzanek.

Pierwsze próby ze sztucznym rozmywaniem tła wyglądały bardzo sztucznie, ale dziś rozmycie potrafi wyglądać bardzo wiarygodnie, zwłaszcza jeśli oglądamy zdjęcie w rozmiarze internetowym. Nie mam wątpliwości, że za kilka lat przeciętny widz nie będzie w stanie odróżnić naturalnego rozmycia lustrzanki od rozmycia ze smartfona.