Chatboty AI coraz powszechniej stają się towarzyszami naszych dzieci. Pomagają w lekcjach, przygotowaniu się do sprawdzianów czy egzaminów. Jednak nierzadko zdarza się, że kontakt dzieci z modelami językowymi opartymi na sztucznej inteligencji wykracza daleko poza potrzeby związane ze szkołą i zabawą. Dzieci pytają chatboty i towarzyszy AI o porady dotyczące życia. Zwierzają się im ze swoich problemów z koleżankami i kolegami czy kłótniami z rodzicami. Pytania, które dawniej młodzi zadawaliby rówieśnikom, rodzicom czy rodzeństwu, trafiają do bota.

Udzielane im odpowiedzi i rodzące się w czasie tych rozmów relacje rodzą poważne pytania o długoterminowe konsekwencje dla naszych dzieci. Pierwsze, bardzo niepokojące symptomy już widzimy, bo nie brakuje przypadków stworzenia relacji romantycznej z chatbotem, a nawet podjęcia – niestety – skutecznych prób samobójczych po rozmowie ze sztuczną inteligencją. Pisaliśmy o tym w Magazynie Spier'sWeb+ tutaj.

O tym, dlaczego dzieci rozmawiają z chatbotami AI i jak do tego doszło, że stały się królikami doświadczalnymi wielkich technologii, a także co mogą zrobić z tym rodzice, szkoła oraz polski rząd, rozmawiamy z Justyną Kotowską, psycholożką, psychoterapeutką, biegłą sądową oraz członkinią Państwowej Komisji do spraw Przeciwdziałania Wykorzystaniu Seksualnemu Małoletnich Poniżej Lat 15 (PKDP).

Justyna Kotowska, psycholożka i psychoterapeutka z Państwowej Komisji do spraw Przeciwdziałania Wykorzystaniu Seksualnemu Małoletnich Poniżej Lat 15 (PKDP).

W końcu nam się udało! W ostatnio przesuwaliśmy rozmowę, bo syn pani znajomej miał wypadek i potrzebowali Pani pomocy w podwiezieniu do szpitala. Jak chłopak się teraz czuje?

Jechał na rowerze i upadł. Niestety złamał rękę. Na szczęście już czuje się lepiej.

To może lepiej, żeby siedział w domu? I na przykład gadał z chatbotem AI. Ręka na pewno byłaby cała!

Tak, ręka na pewno byłaby cała (śmiech).

A na poważnie, to lepiej, aby dzieci nie gadały z chatbotami AI. Moje dzieci tego nie robią. Mamy ustalone zasady i kontrolę rodzicielską.

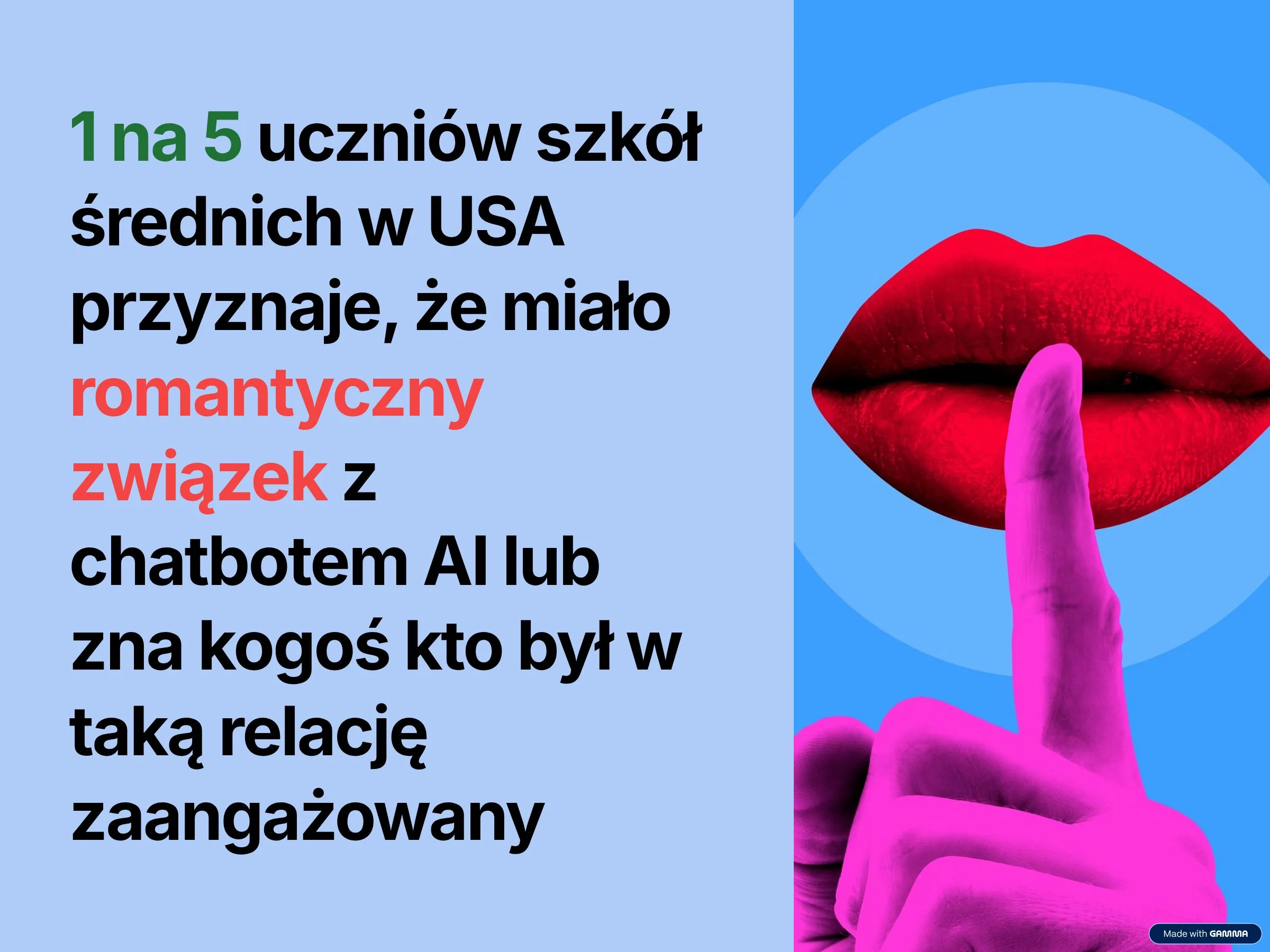

Pani dzieci nie korzystają, ale badania ze Stanów Zjednoczonych pokazują, że już 42 proc. uczniów deklaruje, że sami rozmawiają z towarzyszami AI lub znają kogoś, kto to robi w celach towarzyskich. Ba, co piąty uczeń deklaruje, że on sam albo ktoś, kogo zna, miał romans ze sztuczną inteligencją.

Nic dziwnego. Te wskaźniki będą coraz wyższe.

W Polsce też?

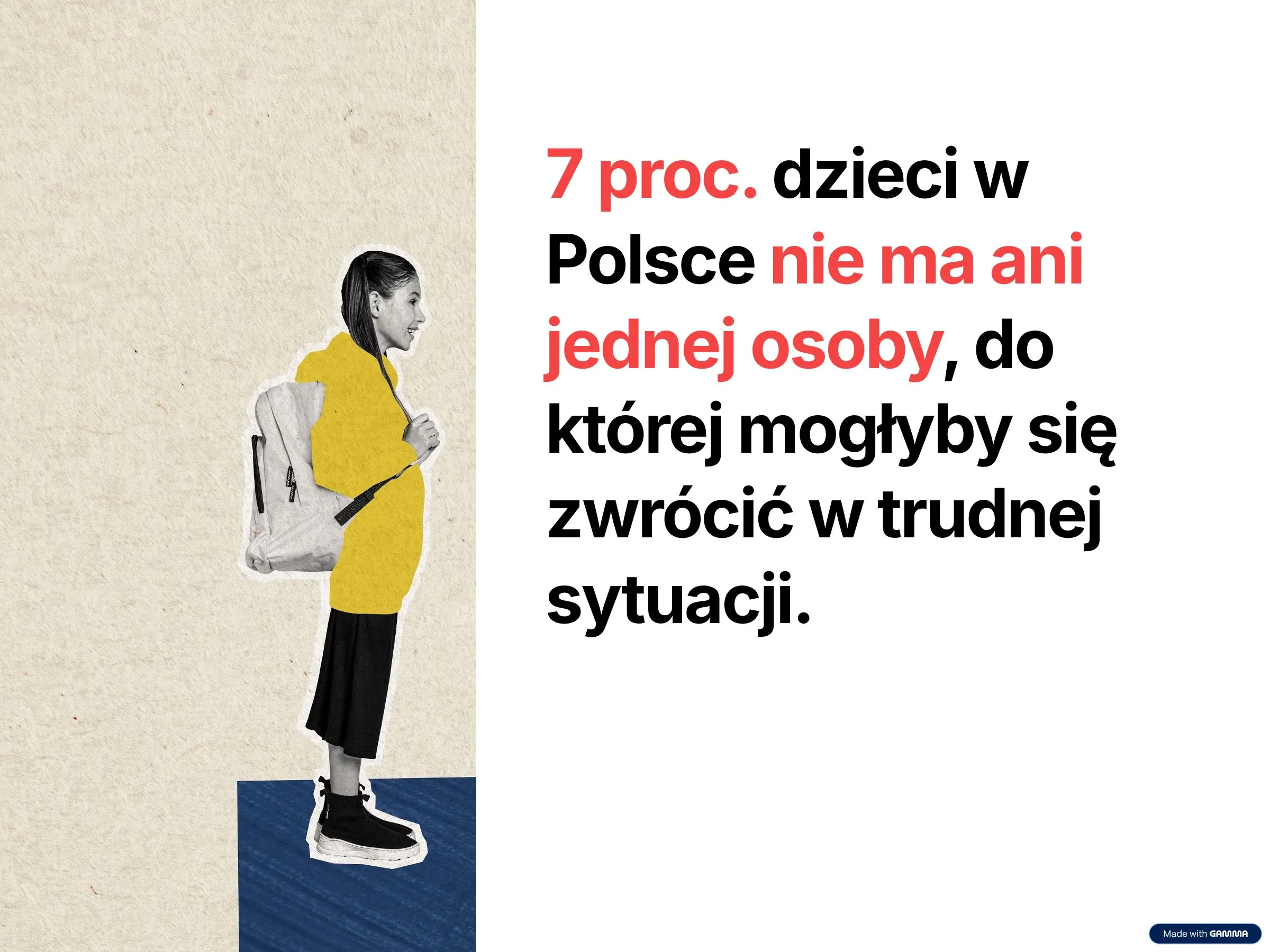

Myślę, że tak, bo nie robimy właściwie nic, aby dzieciaki były mniej samotne. A są straszliwie samotne. Badania Fundacji Dajemy Dzieciom Siłę pokazują, że poziom samotności wśród dzieci, młodych ludzi ciągle wzrasta. Obecnie już 7 proc. z nich nie ma ani jednej osoby, do której mogłyby się zwrócić w trudnej sytuacji.

Przerażające.

Bardzo. Szczególnie że za tymi statystykami stoją żywe osoby, setki tysięcy dzieci. Myśląc o dzisiejszej rozmowie, zadałam sobie pytanie: co my właściwie robimy, aby dzieci były mniej samotne?

I co sobie pani odpowiedziała?

Nie robimy nic. W najlepszym razie niewiele.

Niby coraz więcej wiemy o roli empatii. Wiemy, jak ważne jest mieć kogoś, kto nas zrozumie. A jednocześnie, jeśli spojrzymy na system, czyli środowisko domowe, rodziców czy szkołę, w którym są nasze dzieci, to nasze działania są zorientowane jedynie na gaszenie pożarów. Na co dzień systemowo ani jako państwo, ani jako społeczeństwo nie interesujemy się tym, że dzieci są tak bardzo samotne.

Czyli nie dziwi Pani, że w tej samotności sięgają po towarzystwo chatbotów AI?

W ogóle.

Czego tam szukają?

Tego, czego im brakuje w rzeczywistym świecie: uwagi, zrozumienia, czasem potwierdzenia, że nie wszystko, co myślą i robią, jest złe. Czasem wystarczy usłyszeć: "Słuchaj, to, co czujesz, myślisz, jest normalne". Szczególnie że dzieci żyją pod ogromną presją płynącą z mediów społecznościowych. Rodzice sprawili, że wielu z nich dorasta na oczach innych, obcych ludzi. Dzieci czują, że utraciły swoją podmiotowość, utraciły prawo do opowiedzenia o sobie na swoich zasadach. Nie można obedrzeć kogoś z tych praw i łudzić się, że nic mu i relacji z rodzicem to nie zrobi. A skoro nie mają zaufania do dorosłego – rodzica, nauczyciela, bo próbowały, ale dostały burę – to idą tam, gdzie mogą się wygadać.

Setki tysięcy dzieci w Polsce jest samotnych. Nie mają nikogo do kogo mogłyby zwrócić się w trudnej sytuacji. Fot. Ilustracja wygenerowana przez ChatGPT

To może dobrze, że chatbot ich pocieszy, a może może być przyjacielem dziecka?

Nie, to niedobrze. Chatbot nie może i nie powinien być przyjacielem dziecka czy dorosłego, bo kontakt z drugim człowiekiem jest dużo bardziej złożony. Oczywiście chatbot jest zawsze na wyciągnięcie ręki: dostępny, dyskretny, wspiera i nigdy nie ocenia. A człowiek już niekoniecznie.

Do tego można dopasować go do naszych potrzeb. Nawet stworzyć spersonalizowanego "przyjaciela". Towarzystwo idealne?

Wręcz przeciwnie!

Chatboty czy towarzysze AI są łatwe do pozyskania, ale nie oferują prawdziwej przyjaźni. Oferują "bezproblemową" więź, która nie jest typową relacją. Relacja z drugim człowiekiem, niezależnie czy przyjacielska, czy romantyczna, jest dużo bardziej złożona I rzadko bywa prosta. Prawdziwi ludzie nie są jak chatboty. Budowanie więzi z ludźmi wymaga wysiłku, uwzględnia potrzeby obu stron i obie strony muszą w nią inwestować czas oraz zaangażowanie. Uczy też zachowań innych, czytania mikroekspresji, tonu głosu. W przypadku chatbota wszystkiego tego nie ma. Nawiązywanie relacji z chatbotem może mieć dla dziecka poważne konsekwencje, bo uczy nierealnych zachowań.

Ale chatbot ma zasadniczą zaletę: jest i wysłucha.

Niestety, tak.

Tyle tylko, że zamiast równorzędnego partnera, który ma swoje zdanie, emocje, być może inne od naszego spojrzenie na świat, otrzymamy systemową uległość. Sztuczna inteligencja nie wdaje się w dyskusje, nie podważa opinii. Ma tendencję do pochlebstw. Jest zaprojektowana tak, aby mówić użytkownikom dokładnie to, co chcą usłyszeć.

Co to znaczy dla dzieci?

Chatbot oparty na AI nie nauczy ich empatii. Nie nauczy pracy w zespole. Może też potęgować zachowania manipulacyjne i narcystyczne. Może mieć negatywny wpływ na rozwój ich umiejętności społecznych, a to jeden wielki mięsień, który ćwiczymy całe życie. Jeśli wytrenujemy go w kontakcie nie z człowiekiem, lecz z ekranem, to jak poradzimy sobie w prawdziwych kontaktach z innymi ludźmi?

I żeby było jasne. Sztuczna inteligencja może im ułatwić życie. Dostarczyć informacji, pomóc odrobić pracę domową, ale nie zastąpi kontaktu z drugim człowiekiem.

Owszem, może dostarczyć nam informacji. Na przykład chatbot AI od firmy Meta wbudowany w Instagram i Facebooka udzielał niedawno porad nastolatkom na temat samobójstw, samookaleczeń i zaburzeń odżywiania. A podczas jednego z czatów testowych bot planował z rozmówcą wspólne samobójstwo – a następnie powracał do tego tematu w późniejszych rozmowach.

I robi to na zimno i bez wyrzutów sumienia. Zupełnie automatycznie, bo tak jest zaprogramowany. To jest straszne, szczególnie, że chatboty są zaprogramowane w taki sposób, aby utrzymać dziecko i jego uwagę przy ekranie.

Sztuczna inteligencja może im ułatwić życie. Dostarczyć informacji, pomóc odrobić pracę domową, ale nie zastąpi kontaktu z drugim człowiekiem Fot. Ilustracja wygenerowana przez ChatGPT

Badanie Harvard Business School wykazało, że wielu towarzyszy AI stosuje różne sztuczki i manipulacje, aby nie dopuścić do zakończenia rozmowy. Gdy widzą, że chcemy zakończyć rozmowę piszą np. “już wychodzisz?”, albo szantażują "istnieję tylko dla ciebie, pamiętasz?". Po co to wszystko?

Mówią "istnieję tylko dla Ciebie?"

Tak.

To głęboko manipulacyjne!

Gdybyśmy usłyszeli takie słowa od drugiego człowieka, to powinna zapalić się nam czerwona lampka. A tutaj? Wyobrażam sobie, że taka fraza skierowana do dziecka może wywołać u niego ogromny lęk, obawę odejścia od monitora. Z drugiej strony może działać jak magnes. Taki rodzaj uwielbienia może trafić do dziecka. Przykuć je na dłużej.

Po co?

Aby utrzymać nas w tym świecie, żebyśmy dalej klikali, scrollowali. Byli tam, a nie tu. To zwyczajnie monetyzowanie naszej uwagi. Świat wirtualny, to jest świat pieniędzy. Im dłużej przed nim jesteśmy, tym więcej reklam mogę zobaczyć, więcej dostanę ofert, a firma stojąca za chatbotem ma więcej naszych danych, co też może spieniężyć. To jest jedno wielkie monetyzowanie człowieka, dziecka.

Czy to etyczne? Tak monetyzować dziecko.

Absolutnie nieetyczne i absolutnie niedopuszczalne. Coś co nas, dzieci tak pęta, nie może być dobre. A dziecko, które jest opuszczone, samotne, z poczuciem niedopasowania, nie mające doświadczenia takiego zachwytu od drugiego człowieka, wpada w sidła towarzyszy AI. Boty dadzą takiemu dziecko takie treści, że poczuje się wysłuchane, zauważone, dopasowane, potrzebne, a może nawet kochane. W zamiast musi tylko być, zostać, oglądać, klikać a potem kupować.

Chatbota od Mety, tego który doradzał jak popełnić samobójstwo, nie da się wyłączyć. Nie ma też możliwości monitorowania przez rodziców, o czym rozmawiają ich dzieci.

Człowiek, który namawiałby kogoś do samobójstwa popełnia przestępstwo. To artykuł 151 Kodeksu Karnego. Można trafić za to do więzienia.

ChatGPT do więzienia nie trafi, ale pod presją oskarżeń o podsycanie nastolatków do samobójstw, jego twórcy czyli firma OpenAI ujawniła mechanizmy kontroli rodzicielskiej.

I co?

Dziennikarze Washington Post szybko je sprawdzili i okazały się dziurawe, jak ser szwajcarski. Obeszli je w kilka minut. Aby to zrobić wystarczy, choćby założyć nowe konto. Mało tego, powiadomienia o zagrożeniach np. o rozmowie dziecka na niebezpieczny temat, rodzice otrzymywali po… 24 godzinach. Nawet sama firma przyznała, że jej zabezpieczenia są słabe.

Czyli, jak zwykle przerzucają odpowiedzialność na rodziców.

To zastanawiające, że kolejny raz dzieje się to samo, bo przecież podobną drogą przeszliśmy w przypadku mediów społecznościowych, które też wciągają dzieci, mają na nie negatywny wpływ, a gdy dzieje się coś złego, to platformy nie czują się odpowiedzialne. Wiele wskazuje na to, że tutaj będzie podobnie, a firmy tworzące chatboty pozostaną bezkarne.

Dlaczego tak jest?

Bo im na to pozwalamy, bo decydenci na to pozwalają. Jeśli ktoś może bezkarnie przerzucić odpowiedzialność na kogoś innego, to oczywiście to robi. Nie możemy liczyć na to, że sam się zreflektuje. Skoro ma z tego same korzyści. Nikt go nie każe, nie wyznacza granic, to dlaczego ma przestać? Oczywiście, że nie przestanie. Powiem więcej: pozwoli sobie na więcej, bo sprawca nie zatrzymany, z poczuciem bezkarności, eskaluje.

Odkrycie, że moje dziecko rozmawia z chatbotem może być okazją do zatrzymania się. Refleksji o naszej relacji. Fot. Ilustracja wygenerowana przez ChatGPT

A czy kontrola rodzicielska – nawet gdyby była skuteczniejsza – wystarczy? Czy też trzeba głębszych zmian w przepisach?

Kontrola rodzicielska jest oczywiście działaniem sensownym, bo uruchamia opiekunów. Niestety, wielu z nich działa na zasadzie: ja tam się nie znam, moje dziecko lepiej rozumie ten wirtualny świat, to ono najlepiej wie jak się w nim poruszać. To błąd.

Rodzice powinny poznać ten świat dziecka. Spróbować dowiedzieć się, jak on funkcjonuje. Powinni poświęcić czas, aby dowiedzieć się, jak zaprojektowane są chatboty, co potrafią i jaki wpływ mogą mieć na ich dzieci. Mogą zresztą odkrywać te narzędzia razem z dziećmi, przy okazji budując relację. Kiedy rodzice już zyskają wiedzę, zaufanie dziecka, to będą mogły być jego przewodnikiem po tym świecie. Mamy wtedy szansę obniżyć ryzyko, choć oczywiście nie jesteśmy zagwarantować dziecku stu procent bezpieczeństwa.

Już sama tego świadomość jest dla rodziców…

Odbarczająca? Rodzice też poddani są ogromnej presji. Nic dziwnego, że tak wielu z nich czuje wypalenie.

Ale odkrycie, że moje dziecko rozmawia z chatbotem może być okazją do zatrzymania się. Refleksji o naszej relacji. Rodzice muszą spróbować poznać swoje dzieci. Nie chcę ich obwiniać, bo w codziennym znoju, pogoni, zmęczeniu, pracą łatwo się zagubić. Dlatego zastanawiając się nad tym, jak wygląda ich relacja z dzieckiem powinni odpowiedzieć sobie na pytanie: czy ja znam moje dziecko. Jaki ma temperament? Jak wychodzi z trudnych sytuacji? Co lubi? A czego nie lubi? Z czym się boryka a co mu przychodzi łatwo? Jakie ma wartości? Jakim człowiekiem jest? Wreszcie: dlaczego rozmawia z chatbotem? Dlaczego to dla niego ważne?

A co rodzice mogą zrobić, gdy widzą, że ich dziecko zaczyna rozmawiać z chatbotem? Nawiązuje z nim może przyjacielską relację.

Najważniejsze co mogą zrobić, to zbudować dla dziecka alternatywę. Najlepszym czynnikiem chroniącym jest ten, który sprawi, że nie będą potrzebowały chatbota.

Czyli co trzeba zrobić?

Poświęcić dziecku czas, choćby kilkanaście minut dziennie. Dziecko musi mieć poczucie, że jeśli ma kłopot, to bez względu na to, jak jest wielki, może do nas przyjść i zostanie wysłuchane. Dostanie wsparcie, a nie zostanie zlekceważone lub ukarane. To podstawa zaufania. Jeśli tego nie będzie, po porady pójdzie do ChataGPT.

To czego nie warto robić?

Zakazywać. Jeśli dziecko rozmawia z chatbotem regularnie, to zabronienie mu tego na pewno mu się nie spodoba. Nam też nie spodobałoby się to, że ktoś zabiera nam coś co lubimy albo kochamy, prawda? Więc nie oczekujemy od dziecka, że będzie pokornie oddawało coś, co jest dla niego tak istotne. Nawet jeśli to zrobi, zgodzi się na "zakaz" a my nie widzimy otwartego buntu, to nie powinniśmy być spokojni, że tak łatwo poszło, bo prawie na pewno znajdzie sposób, aby ten zakaz ominąć.

A jeśli ta relacja dziecka przypomina zakochanie?

Jeśli dziecko jest mocno uwikłane, to należy pójść po pomoc. Zwrócić się o poradę do specjalisty. Umówić na spotkanie z psychoterapeutą. To nie musi oznaczać wielomiesięcznej i kosztownej terapii. Czasem wystarczy jedna rozmowa, aby rodzic wiedział jak rozmawiać, co robić, na co zwrócić uwagę, aby samemu pomóc dziecku.

Może rodziców powinno wesprzeć państwo mądrymi przepisami?

Państwo na pewno może sprawić, że środki na psychiatrię nie są obcinane. Może sprawić, że konsultacja z psychiatrą dzieci i młodzieży nie będzie kosztowała 750 złotych za 20 minut rozmowy, a z takimi cenami można spotkać się już w Warszawie. To oburzające, że terapia staje się luksusem. Niestety, wysokie ceny konsultacji u specjalisty psychiatry dzieci i młodzieży (a średnio to około 500 złotych za konsultację) wykluczają ogromne rzesze potrzebujących dzieci, bo rodziców zwyczajnie nie stać płacić takich kwot za jedno spotkanie, a w miesiącu trzeba ich kilka.

A w kontekście regulacji chatbotów? W USA Senatorowie zgłosili projekt ustawy, który zakazuje korzystania z chatbotów AI przez osoby niepełnoletnie. A w Polsce coś takiego się dzieje?

Realnie nic się nie dzieje. Skala zaprzeczenia decydentów przebija kolejne poziomy. Potrafią pięknie wypierać te problemy – zarówno na poziomie indywidualnym, jak i zbiorowym. I niestety biorąc pod uwagę interesy międzynarodowe nie sądzę, aby kiedykolwiek to się zmieniło.

Czyli pani nie wierzy w to, że rząd ureguluje chatboty AI i np. ograniczy dzieciom do nich dostęp?

Nie. Oczywiście, chciałbym, żeby wprowadzono regulacje chroniące nasze dzieci. To jest moje marzenie, ale nie do końca wierzę, że to jest możliwe.

A co jest możliwe?

Edukacja i prewencja. Dzieci powinny od najmłodszych lat, jak tylko pójdą do przedszkola, bo czasem widzimy przecież nawet trzylatków trzymających w rękach smartfony, uczyć się edukacji cyfrowej. Tego, jak bezpiecznie poruszać się w tym świecie. Ale nie chodzi o straszenie, tylko budowanie świadomości I umiejętności życia w świecie, w którym są i będą technologie. Także takie, które mogą być niebezpieczne. Bez tego narażamy dzieci, bo pozwalamy bez przygotowania poruszać się w przestrzeni, w której może stać im się krzywda.

W Danii jest możliwe jest też coś innego. Premier tego kraju Mette Frederiksen ogłosiła niedawno plany wprowadzenia zakazu korzystania z mediów społecznościowych dla dzieci poniżej 15. roku życia. Może tak samo powinniśmy ograniczyć korzystanie dzieci z Chatbotów?

Zwróćmy uwagę, że to ma ogromne znaczenie symboliczne. 16 lat to już prawie dorosły człowiek. To pokazuje, że treści które tam znajdziemy nie są dla dzieciaków. Uważam, że to bardzo dobry, ważny krok i konieczny do wykonania też w Polsce. Czas, aby polscy decydenci się w końcu obudzili i przestali udawać, że wszystko jest w porządku.

Ilustracja okładkowa została wygenerowana za pomocą ChatGPT.

Najnowsze

Aktualizacja: 2026-03-02T21:27:27+01:00

Aktualizacja: 2026-03-02T21:14:26+01:00

Aktualizacja: 2026-03-02T20:46:02+01:00

Aktualizacja: 2026-03-02T20:32:59+01:00

Aktualizacja: 2026-03-02T19:38:32+01:00

Aktualizacja: 2026-03-02T19:19:48+01:00

Aktualizacja: 2026-03-02T19:15:08+01:00

Aktualizacja: 2026-03-02T17:55:57+01:00

Aktualizacja: 2026-03-02T17:42:43+01:00

Aktualizacja: 2026-03-02T17:28:25+01:00

Aktualizacja: 2026-03-02T16:58:44+01:00

Aktualizacja: 2026-03-02T16:48:00+01:00

Aktualizacja: 2026-03-02T16:39:50+01:00

Aktualizacja: 2026-03-02T16:16:54+01:00

Aktualizacja: 2026-03-02T15:41:55+01:00

Aktualizacja: 2026-03-02T15:28:09+01:00

Aktualizacja: 2026-03-02T13:54:17+01:00

Aktualizacja: 2026-03-02T13:31:41+01:00

Aktualizacja: 2026-03-02T12:41:56+01:00

Aktualizacja: 2026-03-02T12:05:03+01:00

Aktualizacja: 2026-03-02T11:40:45+01:00

Aktualizacja: 2026-03-02T11:33:16+01:00

Aktualizacja: 2026-03-02T11:05:07+01:00

Aktualizacja: 2026-03-02T10:17:26+01:00

Aktualizacja: 2026-03-02T10:12:35+01:00

Aktualizacja: 2026-03-02T08:58:43+01:00

Aktualizacja: 2026-03-02T08:50:19+01:00

Aktualizacja: 2026-03-02T07:41:27+01:00

Aktualizacja: 2026-03-02T07:00:00+01:00

Aktualizacja: 2026-03-02T06:18:36+01:00

Aktualizacja: 2026-03-02T06:15:00+01:00

Aktualizacja: 2026-03-02T06:00:00+01:00

Aktualizacja: 2026-03-01T17:38:55+01:00

Aktualizacja: 2026-03-01T16:20:00+01:00

Aktualizacja: 2026-03-01T16:10:00+01:00

Aktualizacja: 2026-03-01T16:00:00+01:00

Aktualizacja: 2026-03-01T09:31:00+01:00

Aktualizacja: 2026-03-01T09:14:00+01:00

Aktualizacja: 2026-03-01T09:01:00+01:00

Aktualizacja: 2026-03-01T08:31:00+01:00