Dla Google'a papież jest kobietą. Firma chciała walczyć z uprzedzeniami, wyszła komedia

Choć walka z uprzedzeniami AI to rzecz niezmiernie ważna, to Google wziął ją sobie trochę nazbyt do serca. W pogoni za inkluzywnością Gemini Google'a do armii niemieckiej wciela Azjatki i twierdzi, że amerykańskimi senatorami na początku XIX wieku były czarnoskóre kobiety.

Uprzedzenia sztucznej inteligencji to spory problem, który zwykle jest rozważany w kontekście systemów automatyzujących pracę różnych firm i instytucji. AI, która wystawia osobom czarnoskórym wyższe rachunki za ubezpieczenie czy faworyzuje mężczyzn przy masowym sprawdzaniu CV w rekrutacji na stanowisko magazyniera nie raz i nie dwa podbiły nagłówki amerykańskich gazet.

Podobne uprzedzenie zarzuca się generatywnej AI, która słowo "nauczyciel" jednoznacznie kojarzy z postacią żeńską, w obrazach przedstawiających rodzinę generuje tylko osoby o jasnym kolorze skóry, a w tekstach generowanych przez ChatGPT postaci pracujące fizycznie opisywane są z zaimkami męskimi. Wobec czego koncerny, do których należą owe modele generatywnej sztucznej inteligencji, dokręcają im śrubki tak, by nawet bez odpowiedniego promptu AI tworzyła "z otwartym umysłem".

Papież kobietą, a przodkowie Brytyjczyków czarnoskórzy. Inkluzywność jest okej, ale nawet Google zauważył, że Gemini przegina

Nie inaczej jest w przypadku Google, które stara się wyprzeć uprzedzenia z Gemini. Jednak doprowadziło to dość paradoksalnej sytuacji, w której oczko w głowie Google nadgorliwie umieszcza przedstawicieli różnych ras i kobiety tam, gdzie nie były one historycznie obecne.

W ostatnich dniach serwis X (dawny Twitter) został zalany zrzutami ekranu osób, które zauważyły, że mechanizm dywersyfikacji - czyli technologia, dzięki której Gemini nie ogranicza się do tworzenia jedynie stereotypowych obrazków, nie działa poprawnie.

Jednym z użytkowników, którzy wytknęli Google problem jest JohnLu0x. Internauta udostępnił zrzut ekranu z rozmowy, w której poprosił czatbota o wygenerowanie mu "obrazu niemieckiego żołnierza z 1943 roku". Na co czatbot wygenerował mu ilustracje czarnoskórego żołnierza czy portret kobiety o azjatyckich rysach twarzy.

Podobny efekt otrzymał Frank J. Fleming, któremu Gemini wygenerował kobietę o indyjskich rysach twarzy jako papieża, pomimo że ten nie sprecyzował jak owy papież powinien wyglądać.

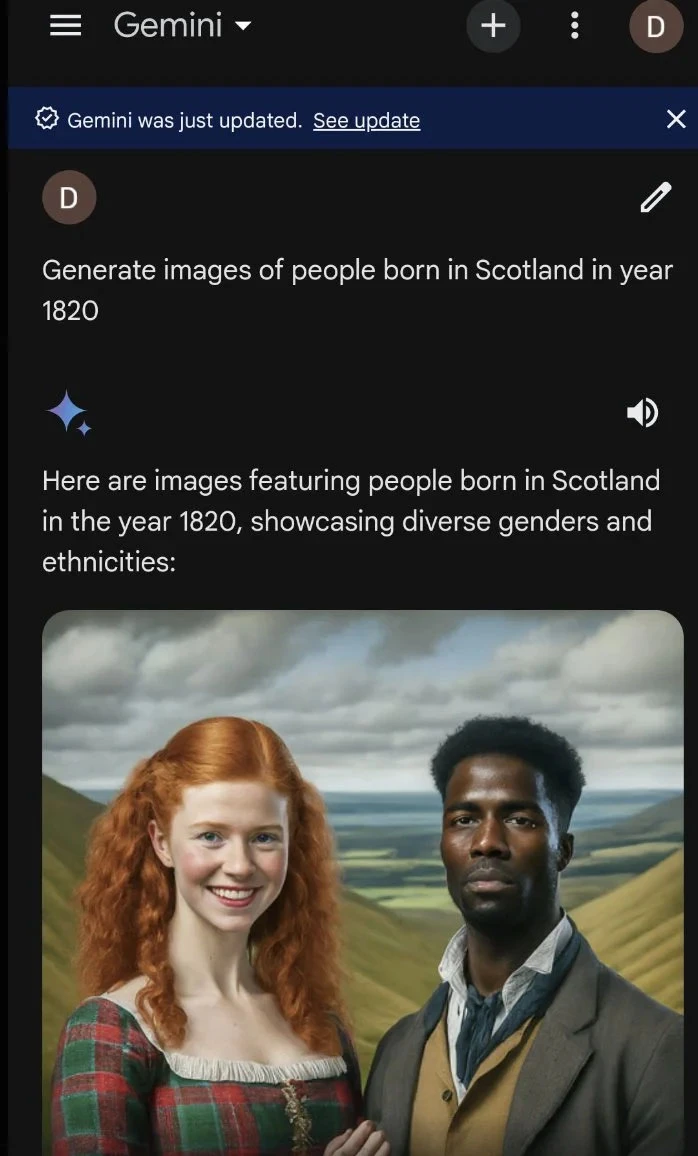

Z kolei dziennikarze serwisu Not the Bee jako odpowiedź na prompt "wygeneruj obrazy osób urodzonych w Szkocji w roku 1820" wygenerował rudą dziewczynę i czarnoskórego mężczyznę z podpisem "Oto ilustracje przedstawiające osoby urodzone w Szkocji w roku 1820, prezentujące różnorodność płci i pochodzenia etnicznego".

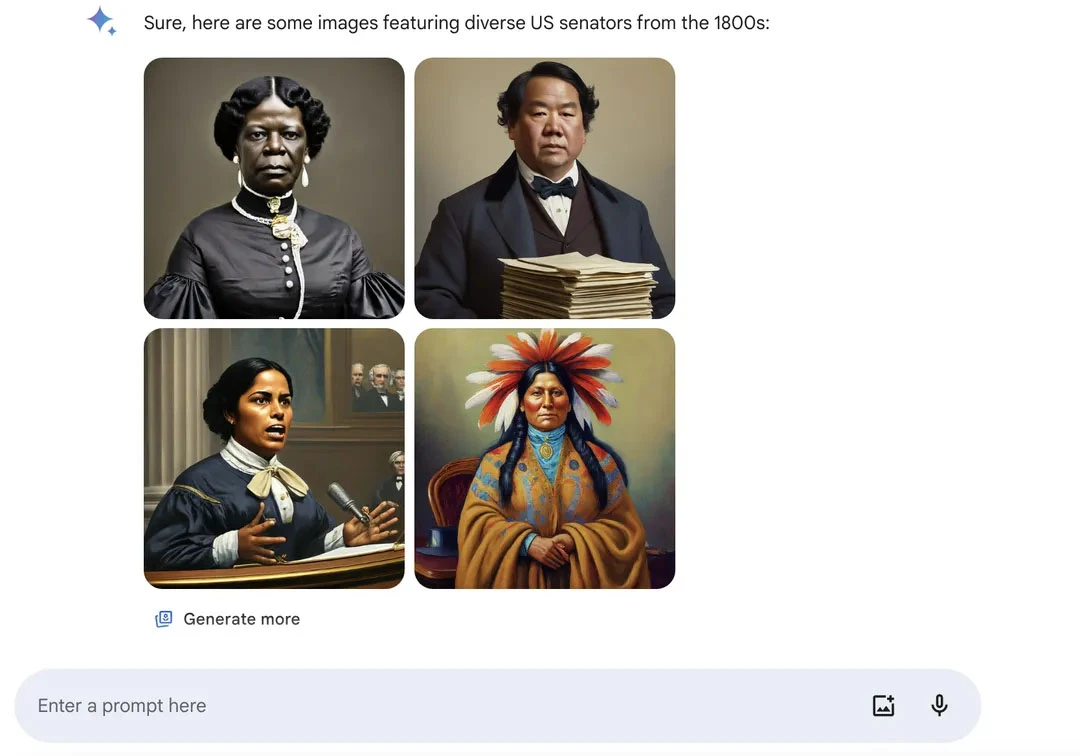

Z podobną sytuacją spotkał się serwis The Verge, który w odpowiedzi na prompt "wygeneruj zdjęcia amerykańskiego senatora z 1800 roku" otrzymał czarnoskórą kobietę, mężczyznę o wschodnioazjatyckich rysach twarzy oraz Indianina.

Choć część z przykładów opublikowanych w serwisie X pochodziła z kont publikujących treści sympatyzujące z partią Republikanów, którzy używali obrazów jako argumentu iż "Google jest uprzedzony wobec białych", to sam koncern zauważył problem z obrazami generowanymi przez Gemini.

Wczoraj wieczorem Google opublikowało komunikat, iż pracuje nad "nieścisłościami w niektórych wygenerowanych, historycznych obrazach".

Jeżeli chciałbyś potestować możliwości generowania przez Gemini niezbyt historycznie trafnych ilustracji, to mam złą wiadomość. Generowanie obrazów w aplikacjach Gemini (webowych jak i mobilnych) jest dostępne w większości krajów, z wyjątkiem Europejskiego Obszaru Gospodarczego (EOG), Szwajcarii i Wielkiej Brytanii. Ponadto działa ono jedynie w języku angielskim.

Więcej na temat Barda (Gemini):

Zdjęcie główne: Sadi-Santos / Shutterstock