Oddali sparaliżowanej kobiecie głos. Wykorzystali mikroczip w mózgu i technologię z The Last of Us

Choć systemy pozwalające osobom sparaliżowanym na komunikację istnieją już od lat, to są one stosunkowo powolne i mało efektywne. Nadzieję na komunikację w nawet najcięższych przypadkach medycznych dają amerykańscy naukowcy, którzy za pomocą czipu wszczepionego w mózg, sztucznej inteligencji i małej pomocy osób biorących udział w tworzeniu The Last of Us, przywrócili kobiecie zarówno głos, jak i mimikę twarzy.

Wykorzystanie interfejsów mózg-maszyna najczęściej kojarzymy z przedsiębiorstwem Elona Muska - Neuralink i projektami, które mają doprowadzić do rozszerzenia granic ludzkich możliwości. Jednak jak udowadniają amerykańscy naukowcy, zastosowania takich systemów mogą być bardziej przyziemne, oddając umiejętności tym, którzy je utracili.

Czip w mózgu, port w głowie i sztuczna inteligencja od twórców The Last of Us. Tak naukowcy przywrócili kobiecie mowę

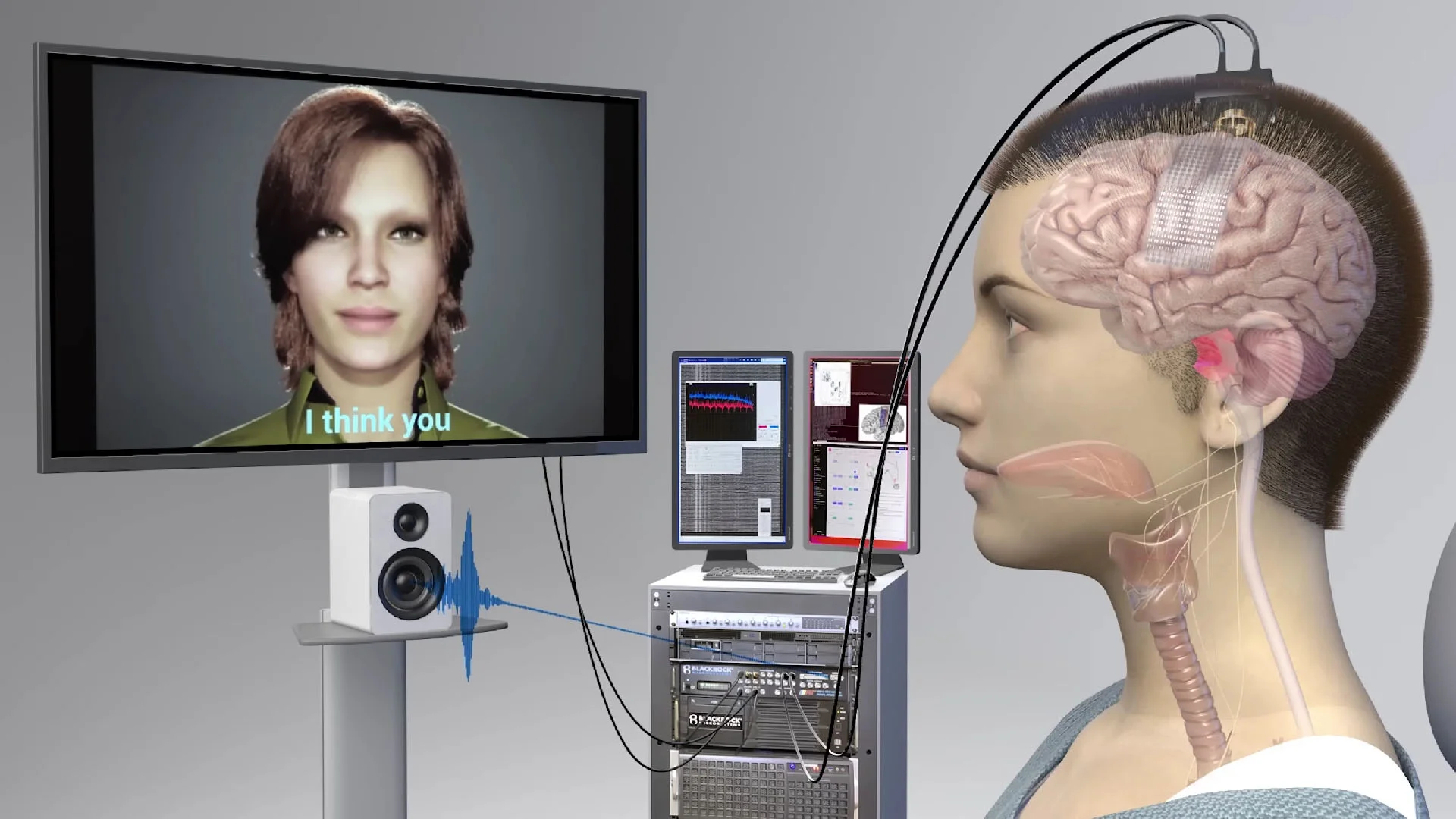

Uczeni z kalifornijskich uniwersytetów w San Francisco i Berkeley opracowali system komunikacji mózg-komputer, który pozwala na przetwarzanie sygnałów z mózgu na zrozumiałe dla komputera, które ten zamienia na mowę i ekspresję emocji. Publikację naukową opisującą projekt i przebieg eksperymentalnego systemu uczeni opublikowali na łamach czasopisma Nature.

W eksperymentalnej pracy udział wzięła 48-letnia Ann Johnson, która w wieku 30 lat podczas gry w siatkówkę doznała udaru mózgu. Kobieta doświadczyła nie tylko paraliżu, ale i zespołu zamknięcia - stanu, w którym człowiek pozostaje całkowicie świadomy i w pełni zdolności umysłowych, przy jednoczesnym, niemalże całkowitym paraliżu ciała.

Przeczytaj także:

- Optyk wciska ci drogie soczewki chroniące przed niebieskim światłem? Pokaż mu te badania

- Zielona kometa zbliża się do Ziemi. Wypatrzysz ją gołym okiem

- Dajesz dziecku smartfon, żeby mieć święty spokój? Natychmiast przestań

Dotychczas Ann korzystała z urządzenia wspomagającego komunikację, które za pomocą ruchów jej głowy oraz naklejki na okularach pozwala jej wpisywać tekst na ekranie komputera. Jednak urządzenie jest stare i powolne, a jak mówi jej rodzina, zwykła wymiana zdań zajmuje jej od 5 do 7 minut.

W wypowiedzi dla NBC News Ann przyznała, że wzięła udział w eksperymencie, gdyż obecnie jej celem jest zostanie doradcą. Posiadanie awatara znacznie ułatwiłoby jej pracę.

Rola Ann w eksperymencie była kluczowa, gdyż na powierzchni jej mózgu zespół pod przewodnictwem Edwarda Changa, przewodniczącego Wydziału Chirurgii Neurologicznej na Uniwersytecie Kalifornijskim w San Francisco, umieścił specjalny czip. Czip jest cienki niczym papier, jednocześnie zawiera w sobie 253 elektrody, które umiejscowione są tak, by pokrywać obszar odpowiedzialny za mowę. Jak mówią badacze, elektrody przechwytują sygnały, które - gdyby nie udar - trafiłyby do mięśni języka, szczęki i krtani, a także twarzy Ann.

Minusem systemu jest fakt, że na czaszce Ann znajduje się "port", dzięki któremu naukowcy są w stanie podłączyć kobietę do komputera przetwarzającego sygnały z jej mózgu.

Za systemem rozpoznawania mowy u Ann stoi nic innego jak sztuczna inteligencja. Jednak naukowcy podjęli się nowatorskiego podejścia do AI, w którym zamiast trenować sztuczną inteligencję do rozpoznawania całych słów, naukowcy stworzyli system, który dekoduje słowa z fonemów.

Jak tłumaczą uczeni, fonemy to podjednostki mowy, które tworzą słowa mówione w taki sam sposób, w jaki litery tworzą słowa pisane. Na przykład w języku angielskim "Hello" (Cześć) zawiera cztery fonemy: "HH", "AH", "L" i "OW".

Korzystając z tego podejścia, komputer musiał nauczyć się tylko 39 fonemów, aby odszyfrować dowolne słowo w języku angielskim. Zwiększyło to zarówno dokładność systemu, jak i uczyniło go trzykrotnie szybszym. Z kolei aby stworzyć głos, zespół opracował algorytm syntezy mowy, który spersonalizował tak, aby brzmiał jak jej głos przed urazem.

Ponieważ Ann była w pełni sprawna przed wypadkiem, zachowały się jej nagranie głosu, a konkretnie jedno - z jej ślubu, które posłużyło jako próbka do odtworzenia głosu.

Ostatnim elementem systemu jest awatar wzorowany na wyglądzie Ann, który odwzorowuje jej mimikę twarzy na podstawie sygnałów, jakie przesyła mózgu. Silnik zapewniający model o realistycznych ekspresjach twarzy zapewniła Speech Graphics - firma, którą mogą kojarzyć fani Halo Infinite czy The Last of Us Part II.

To Speech Graphics opracowało technologię fotorealistycznej animacji twarzy w obu tytułach, którą na potrzeby systemu przetwarzania fali mózgowych na mowę zaadaptowali kalifornijscy naukowcy. Awatar Ann potrafi nie tylko się smucić czy uśmiechać, ale także ruszać językiem, wargą i szczęką, odwzorowując ruchy, które człowiek wykonuje podczas mowy.

- Nadrabiamy stracone połączenia między mózgiem a układem głosowym, które zostały przerwane przez udar. Kiedy badana po raz pierwszy użyła tego systemu do mówienia i poruszania twarzą awatara jednocześnie, wiedziałem, że będzie to coś, co będzie miało ogromny potencjał.

Jak mówią naukowcy, kolejnym etapem ich prac nad rozwojem systemu mózg-maszyna dla osób w sytuacji podobnej do Ann jest uczynienie systemu bezprzewodowym.

Jednocześnie na łamach czasopisma Nature holenderski neuropsychofarmakolog Nick F. Ramsey oraz amerykański neurolog Nathan E. Crone wskazują, że choć system jest przełomowy i stanowi ważny krok w przywracaniu sprawności komunikacyjnych osobom sparaliżowanym, to ma on dwa zasadnicze ograniczenia.

Po pierwsze, uczeni poddają w wątpliwość czy opracowany system komputerowy może być obsługiwany przez osobę bez wiedzy eksperckiej. Po drugie, system został opracowany z myślą o Ann, która ma szczątkowe możliwości ekspresji (wydawania dźwięków, poruszania głową oraz mięśniami twarzy) i nie jest jasne jak system działałby w przypadku osób o całkowitym braku owych zdolności.