Microsoft buduje potęgę, kiedy inni się bawią. Ma nowego, kluczowego sojusznika

Współfinansowany przez Microsoft model językowy GPT od firmy OpenAI wywrócił świat informatyki do góry nogami. Generatywna sztuczna inteligencja to prawdziwa rewolucja i wszyscy inwestują miliony dolarów, by dogonić wspomniany Microsoft. Tymczasem ten właśnie ogłosił sojusz z Metą - właścicielem Instagrama i Messengera. Obie firmy oprócz GPT będą wspólnie pracować nad modelem językowym Llama 2.

ChatGPT to największa produktowa premiera w historii. Czatbot od firmy OpenAI potrafi bowiem niezwykle sprawnie analizować ludzką mowę wyrażoną tekstem i ją rozumieć - na tyle, na ile maszyna może wykazać się jakimkolwiek zrozumieniem czegokolwiek. Z ChatGPT można swobodnie rozmawiać. Przede wszystkim jednak można go wykorzystać do analizy danych. Okazało się, że technologia GPT - choć pod wieloma względami wciąż wadliwa - może zautomatyzować ogromną ilość czynności i oszczędzać jeszcze większą liczbę roboczogodzin. To rewolucja.

GPT mogłoby jednak nie powstać, gdyby nie główny inwestor OpenAI, jakim jest Microsoft. Gigant wyłożył już na swojego partnera miliardy i właściwie to nie kupił go prawdopodobnie właściwie tylko z obawy o możliwe postępowanie antymonopolowe ze strony stosownych urzędów. Jednak jako główny udziałowiec ma wpływ na rozwój technologii, pełen w nią wgląd i przede wszystkim może ją wykorzystywać w swoich produktach i usługach. I zresztą to robi, technologia GPT jest łączona z technologiami Microsoftu i już implementowana w Bingu, Microsoft 365, Dynamics 365, Githubie, Windowsie i reszcie, zyskując ogromną przewagę nad konkurencją.

Rzeczona konkurencja jednak nie śpi. Google buduje swój model językowy, można go już testować w ramach usługi Bard. Swoje modele budują też Meta i Amazon, Alibaba, Adobe i właściwie wszystkie ważne firmy z tak zwanego Big Techa. Nic dziwnego, zdaniem niektórych generatywna sztuczna inteligencja to rewolucja na miarę graficznego interfejsu użytkownika czy smartfonu.

Zaległości konkurencji jednak niestety dość boleśnie widać. Prawdopodobnie nikt jeszcze rok temu nie przypuszczał, że nadejdą takie czasy, gdy Bing będzie wymieniany za wzór dla Google’a. Tymczasem porównanie możliwości Bing Czata (bazującego m.in. na GPT-4) i Barda wypada dość żałośnie, bynajmniej dla Binga. Te zaległości konkurencja jednak na pewno nadrobi. Pytanie tylko, gdzie w czasie tego nadrabiania odskoczy Microsoft?

Do świata open-source. Microsoft i Meta ogłaszają sojusz, na czym skorzystać ma otwartoźródłowy model językowy Llama 2.

Llama to rozwijana przez Metę konkurencja dla GPT od OpenAI. Choć może konkurencja to nienajlepsze określenie, bo sugeruje, że właściciel Facebooka zaczął swoje prace istotnie później od OpenAI - tymczasem GPT i Llama ponoć powstawały równolegle. Od teraz Llama 2 należeć będzie również do technologii Microsoftu. No, w pewnym sensie.

Meta i Microsoft nie tylko połączą siły w kwestii rozwoju samego języka. Llama 2 będzie oficjalnie obsługiwany przez chmurę Azure i system operacyjny Windows. Deweloperzy będą mogli wybierać pomiędzy różnymi odmianami tego modelu (rozmiary 7B, 13B i 70B - nazwy symbolizują miliardy parametrów), w zależności od potrzeb tworzonych przez nich aplikacji.

Azure nie będzie przy tym jedyną chmura skonfigurowaną pod hosting Llama 2 i operowanie nim - będzie jednak chmurą programistom przez Metę rekomendowaną (model będzie dostępny też na AWS oraz Hugging Face). Z kolei instancje lokalne Lllama 2 działające w windowsowych aplikacjach będą zgodne ze środowiskiem QNNX i interfejsem DirectML, a więc z zapewnianymi w Windowsie natywnymi bibliotekami do obsługi oprogramowania związanego z SI i uczeniem maszynowym. Swoją drogą, QNNX powstało też przy pomocy, między innymi, inżynierów Mety, a efektem tej współpracy jest chociażby integracja QNNX z PyTorchem.

Llama 2 jest w pełni darmowa nie tylko do celów naukowych, ale i również komercyjnych.

Meta i Microsoft udostępnią zarówno model ogólny, jak i dodatkowe modele wyspecjalizowane dla poszczególnych branż. Już dziś klienci chmury Azure mogą zacząć korzystać z tego modelu językowego, jest już dostępny w katalogu Azure AI. To bardzo mądra decyzja, świadcząca o dalekowzroczności firmy Zuckerberga.

Na dziś nie sposób porównać sprawności energetycznej czy informacyjnej modelu Llama 2. Jest jednak wysoce prawdopodobne, że nadal nie jest on tak zaawansowany, jak model stworzony przez OpenAI. Meta (ani nikt inny) nie rozwijała badań nad Dużymi Modelami Językowymi tak intensywnie i przy wykorzystaniu tak dużych środków, jak OpenAI z Microsoftem. Prawdopodobnie nadal wymaga dużo pracy. Całkowita otwartość to świetny sposób na przyspieszenie tych prac.

Otwarta natura modelu sprawia, że zainteresowani specjaliści i programiści spoza Mety czy Microsoftu mogą go analizować i ulepszać, dzieląc się z resztą społeczności swoimi usprawnieniami. Z kolei udostępnienie tego modelu nie tylko badaczom, ale też podmiotom planującym za jego pomocą zarabiać pieniądze dodatkowo motywuje niezależnych programistów - którzy będą go ulepszać nie tylko hobbystycznie, ale też zawodowo, z uwagi na konkretne potrzeby danego podmiotu gospodarczego. Open-source to niemal synonim innowacji, o czym Meta i Microsoft bardzo dobrze wiedzą. GPT-4 wymaga subskrypcji ChatGPT Plus do uzyskania dostępu do API. PaLM 2 nie jest jeszcze publicznie dostępny, poza usługą Bard.

Lllama 2 kontra GPT-4 i Palm 2. Jakie są różnice między modelem Mety, Google’a i OpenAI?

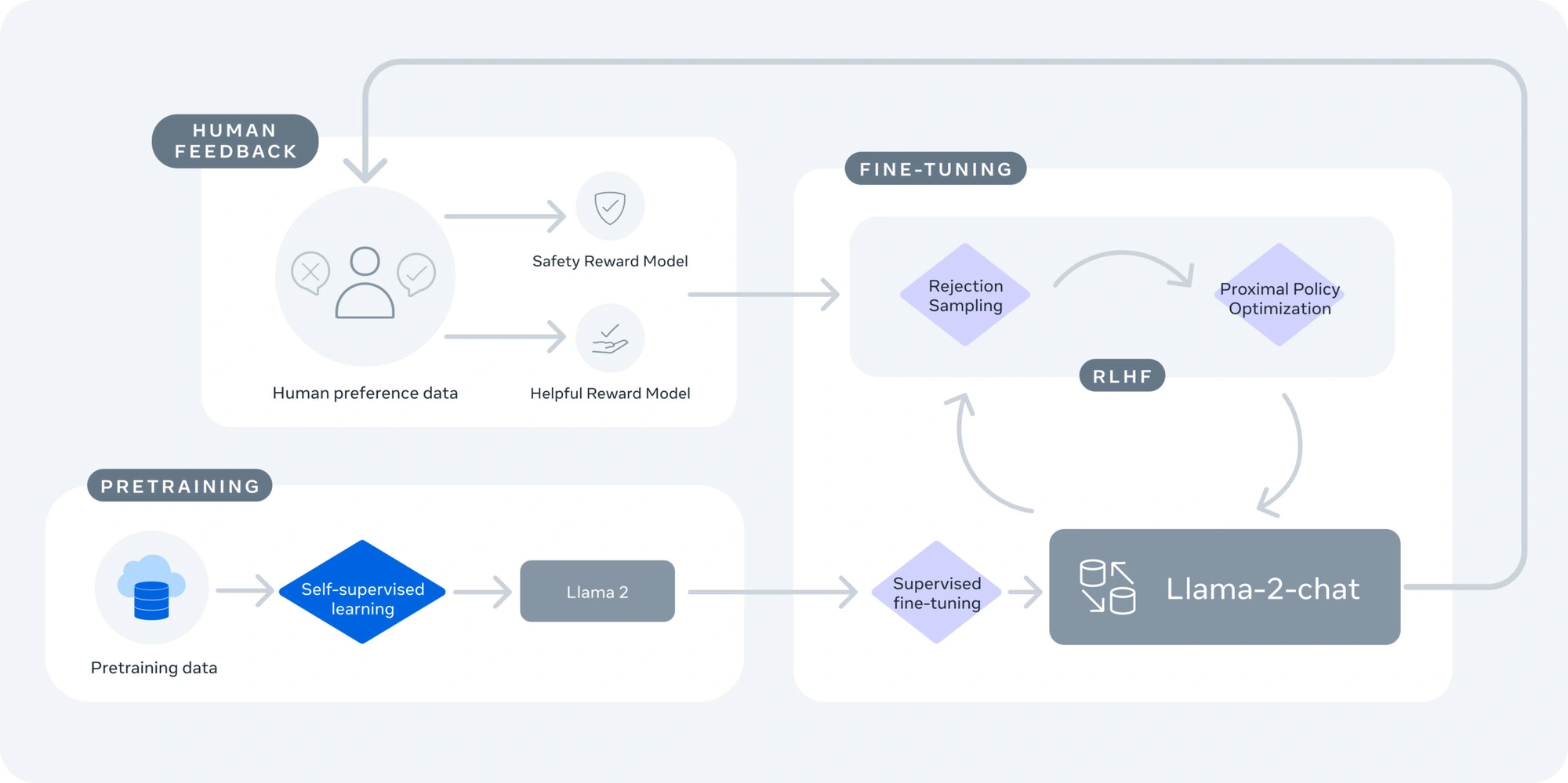

Llama 2 potrafi generować tekst i kod w odpowiedzi na podane polecenia, podobnie jak inne systemy LLM. Model został wytrenowany na dwóch bilionach tokenów z różnych źródeł internetowych, głównie w języku angielskim. Llama 2 ma dwie wersje: Llama 2 i Llama 2-Chat, która została dostosowana do prowadzenia dwustronnych rozmów. Każda z nich ma trzy poziomy złożoności: 7 miliardów parametrów, 13 miliardów parametrów i 70 miliardów parametrów. Im więcej parametrów, tym lepsza jakość generowanego tekstu.

Llama 2 jest najmniejszym z trzech modeli pod względem liczby parametrów. GPT-4 ma nieznaną ich liczbę, ale prawdopodobnie jest większy niż GPT-3.5, który ma 175 miliardów parametrów. PaLM 2 ma również nieznaną liczbę parametrów, ale PaLM pierwszej gemeracji ma 540 miliardów parametrów. Llama 2, jak zauważyliśmy wyżej, został wytrenowany na dwóch bilionach tokenów z różnych źródeł internetowych, głównie w języku angielskim. GPT-4 został wytrenowany na ponad trzech bilionach tokenów z różnych źródeł internetowych i obrazów. PaLM 2 został wytrenowany na znacznie większym zbiorze danych niż PaLM, ale dokładna wielkość nie jest znana.

Llama 2 obsługuje 20 języków, GPT-4 obsługuje 26 języków, a PaLM 2 obsługuje 100 języków. Google twierdzi, że PaLM 2 jest lepszy od GPT-4 w wielojęzyczności i tłumaczeniu, co trudno zweryfikować. Tym niemniej sama Meta przyznaje, że Llama 2 jest mniej potężny niż GPT-4 i że istnieje luka w wydajności między nimi. GPT-4 osiąga lepsze wyniki niż Llama 2 w niektórych zadaniach, takich jak MMLU, HellaSwag i ARC-E. Google z kolei twierdzi, że PaLM 2 ma lepsze zdolności rozumowania niż GPT-4 w WinoGrande i DROP, a także lepiej radzi sobie z matematyką.

Zamknięta technologia czy open-source? Microsoft na oba pytania odpowiada: tak. I buduje potęgę nie tylko w generatywnej SI.

Microsoft bez wątpienia odniósł gigantyczne korzyści w związku z partnerstwem z OpenAI. Sojusz z Metą również zapewni mu dalsze możliwości rozwoju i wprowadzania w szybkim tempie kolejnych innowacji. A w najgorszym razie, w najbardziej pesymistycznym dla Microsoftu scenariuszy: firma zarobi worki pieniędzy już za samo przetwarzanie Dużych Modeli Językowych w chmurze Azure. Microsoft nawet gdy przegra w tym wyścigu, to i tak wygra wiele. A póki co znajduje się na prowadzeniu.

Firma nie polega jednak tylko na OpenAI. Przez ostatnią dekadę inwestowała setki milionów dolarów w rozwój innych rodzajów SI i mechanizmów ML, nie tylko generatywnych. Wskazać można chociażby Microsoft Syntex, który umożliwia automatyczne tworzenie i zarządzanie metadanymi, ekstrakcję informacji z dokumentów, klasyfikację i ochronę danych oraz tworzenie inteligentnych formularzy.

Z kolei GitHub Copilot sugeruje linie lub całe funkcje kodu programistycznego na podstawie kontekstu i preferencji dewelopera. W ramach Microsoft 365 funkcjonują mechanizmy SI pilnujące poprawności pisowni i gramatyki, interpretujący polecenia głosowe, tłumaczące teksty na inne języki, automatycznie dbające o estetykę dokumentów czy nawet zapewniające osobistą analitykę. No i samo Azure AI to gigantyczna platforma chmurowa, która zapewnia dostęp do wysokiej jakości modeli i usług AI w zakresie przetwarzania obrazów, mowy i języka.

Jeżeli sztuczna inteligencja to faktycznie najważniejsza technologia bieżącej dekady, to nie ma lepszej informacji dla Microsoftu. Bardzo niewiele podmiotów będzie w stanie go na dziś dogonić, czego główną przyczyną jest wymagana chmura obliczeniowa, wieloletnie badania i rozwój nad SI oraz dekady doświadczenia w przetwarzaniu big data, w tym w środowiskach korporacyjnych. Ewidentnie rozumie to nawet taka firma, jak Meta - która przecież jest co najmniej takim samym informatycznym gigantem w ogólnym ujęciu, jak Microsoft. Obyśmy tylko nie doczekali się monopolu.