Apple będzie skanować twoje zdjęcia w poszukiwaniu dziecięcej pornografii

Apple wprowadza kontrowersyjną nowość – będzie skanować twoje zdjęcia w poszukiwaniu dziecięcej pornografii. Teraz tłumaczy, jak ma to działać.

W Cupertino traktują poważnie narastający problem drapieżników seksualnych, czyhających na małe dzieci, jak również kwestię niechcianej ekspozycji na nagie zdjęcia w internecie, nierzadko rozsyłane w formie spamu. Z tego względu w wersji beta nowych systemów operacyjnych pojawiła się nowa funkcja, której zadaniem jest rozpoznawać, blokować i zgłaszać treści o charakterze dziecięcej pornografii lub zachowań pedofilskich. Jesienią trafi ona do wszystkich użytkowników iOS 15, iPadOS 15, watchOS 8 oraz macOS Monterey.

Jak wszystko w życiu, ma to zarówno dobre, jak i złe strony. Zacznijmy od tych drugich.

Apple będzie skanował twoje zdjęcia. Eksperci są jednoznacznie krytyczni.

Apple w specjalnym komunikacie szczegółowo tłumaczy, jak działa technologia odpowiadająca za skanowanie zdjęć na urządzeniach użytkownika.

Przede wszystkim, skanowanie nie odbywa się w chmurze, lecz na urządzeniu. Algorytm rozpozna niepożądane treści porównując je ze zbiorami zdjęć referencyjnych dostarczonych przez organizacje praw dziecka. Ta baza danych również ma być przechowywana na urządzeniu w formie niemożliwych do odczytania hashów. Proces skanowania odbywa się w chwili próby transferu zdjęcia z urządzenia do iCloud Photos i jest szyfrowany przy użyciu techniki przecięcia zbioru prywatnego – to znaczy, że choć dwie strony (w tym przypadku Apple i dostawcy zdjęć referencyjnych) mogą porównywać swoje zbiory danych, tak żadna ze stron nie może udostępnić drugiej niczego prócz „elementów przecięcia”, czyli zgodnych wyników.

Eksperci jednak zwracają uwagę na fakt, iż pod płaszczem bezpieczeństwa najmłodszych Apple otwiera sobie furtkę do stworzenia infrastruktury podsłuchowej. O taki backdoor od lat proszą Apple’a agencje rządowe, by zyskać dostęp do smartfonów przestępców, lecz do tej pory firma Tima Cooka konsekwentnie odmawiała rządom tego typu narzędzi. Zdaniem ekspertów nowa funkcja to pierwszy krok ku zmianie tego stanowiska, co jest szczególnie niepokojące w przypadku chociażby Chin.

Stanowisko w tej sprawie na Twitterze zabrali profesorowie inżynierii cyberbezpieczeństwa i kryptografii, a także Edward Snowden:

Profesor kryptografii z Uniwersytetu Hopkinsa podkreśla jednak, że na ten moment niemożliwa jest dogłębna i krytyczna analiza nowej funkcji przez niezależnych ekspertów, gdyż Apple nie udostępnia im niezbędnej ku temu dokumentacji.

Spore zastrzeżenia ekspertów rodzi też rozszerzenie funkcji o skanowanie szyfrowanego komunikatora iMessage, co również może w przyszłości doprowadzić do nadużyć, zwłaszcza ze strony rządowej. Ponownie przywoływane są tu Chiny, w których iMessage jest jedynym mainstreamowym, szyfrowanym komunikatorem, do którego rząd nie ma dostępu (choć istnieje silne podejrzenie, iż chiński rząd i tak ma dostęp do tych wiadomości, jeśli tylko użytkownik skorzysta z kopii zapasowej w chmurze).

Od strony użytkowej nowa funkcja jest jednak dobrze przemyślana i bardzo potrzebna.

Skanowanie w poszukiwaniu dziecięcej pornografii w wydaniu Apple’a zdaje się być dobrze przemyślane, a Apple zapewnia, że szansa na „fałszywie pozytywny” wynik wynosi 1 do tryliona. W teorii powinno to uchronić madki robiące zdjęcia swoim nagim pociechom przed nalotem opieki społecznej.

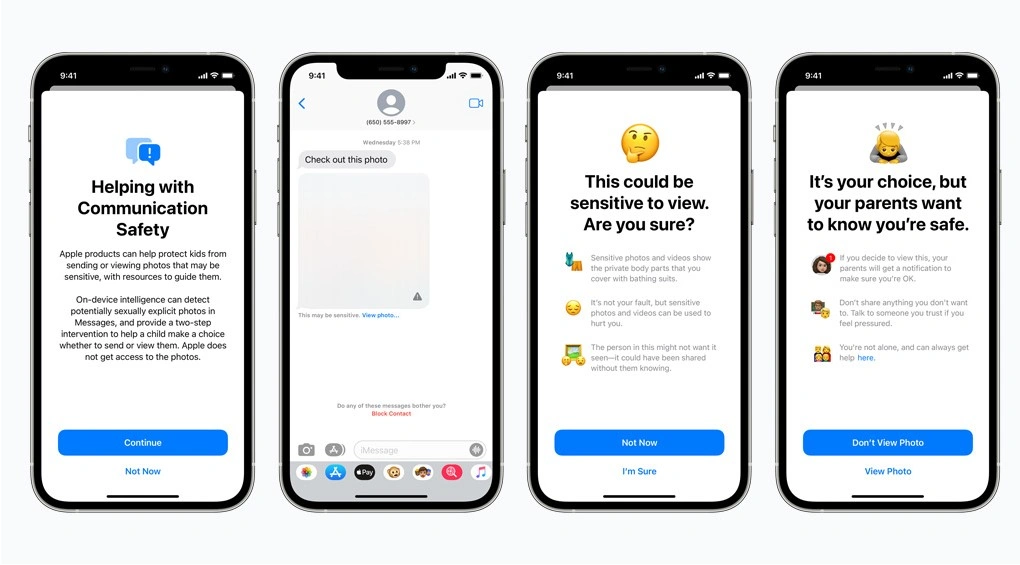

I choć eksperci jednoznacznie bombardują pomysł skanowania zawartości iMessage, tak praktyczne implikacje tej funkcji są bardzo potrzebne. Jeśli np. mamy skonfigurowanego iPhone’a dla dziecka i to dziecko dostanie w komunikatorze zdjęcie rozpoznane jako nieodpowiednie, to rodzic od razu otrzyma stosowny monit. Co więcej, dziecko nie będzie mogło takiego zdjęcia zobaczyć automatycznie – jeśli wybierze opcję „zobacz” przy zdjęciu oznaczonym jako nieodpowiednie, Apple wyświetli komunikat z zapytaniem, czy na pewno chce to zrobić. Jeśli dziecko mimo wszystko zdecyduje się obejrzeć zdjęcie, rodzice otrzymają powiadomienie.

W dobie niesłabnącego problemu pedofilii i groomingu takie rozwiązanie jest na wagę złota, zwłaszcza że mówimy o funkcji ściśle zintegrowanej z największym ekosystemem technologii użytkowej na świecie.

Minie jeszcze miesiąc lub dwa, nim nowa funkcja trafi do wszystkich użytkowników. Stanie się to bowiem dopiero w chwili oficjalnej premiery nowych systemów, a te zaczynają trafiać do użytkowników wraz z nowymi iPhone’ami, które mamy zobaczyć już we wrześniu lub październiku.

Apple zarzeka się, że nowa funkcja została opracowana ze 100-procentowym poszanowaniem prywatności użytkowników. Teraz jest najlepszy czas, by otworzyć się na opinie ekspertów i dowieść, że faktycznie tak jest.