Sztuczna inteligencja napisała maturę 2023. Jak GPT-4 poradził sobie z językiem polskim?

Maj to piękne zielone drzewa, zapach kiełbasy z grilla i oczywiście matury. Postanowiłam rozpocząć maj wraz z maturzystami i wykorzystałam narzędzie, które od pół roku rozwiązuje prace domowe do rozwiązania matury z języka polskiego. Jak poszło modelowi GPT-4 z tegoroczną maturą na poziomie podstawowym?

Pomimo że większość Polaków może mówić o maturze w języku przeszłym i przytaczać liczne anegdoty związane z ich własnymi doświadczeniami, na początku maja cały kraj żyje egzaminami dojrzałości. Ich wynik stanowi zarówno świadectwo całego, dwunastoletniego toku nauczania, jak i główny czynnik decyzyjny przy przyjęciu na studia. A dla tych, którzy są tylko biernymi obserwatorami czytającymi prasę, matury są niczym więcej jak ciekawostką na temat tego, z czym mierzą się właśnie młodzi dorośli.

Choć zadania maturalne zmieniają się co roku, to zakres materiału, który obejmują, jest powszechnie dostępny, w dużym uproszczeniu zawierając tylko to, czego przeciętny licealista nauczył się w ciągu całej swej szkolnej edukacji. Jednak w praktyce przypadki idealnego rozwiązania egzaminów maturalnych są rzadkie, a z czasem szkolna wiedza się rozmywa, sprawiając, że matura na poziomie podstawowym sprawia problemy osobom, które opuściły mury szkolne lata temu. A jak jest ze sztuczną inteligencją?

GPT-4 podejmuje najcięższą rękawicę języka polskiego: zadania maturalne

GPT-4 to obecnie najpotężniejszy model w stajni OpenAI, który firma reklamuje zarówno jego zwiększonymi możliwościami rozumienia intencji, generowania lepszej jakości treści i - co ważniejsze dla nas, Polaków - rozumienia języka innego niż angielski. No i nie zapominajmy: GPT-4, tak jak jego poprzednik GPT-3, został wytrenowany na setkach tysięcy artykułów, publikacji, książek oraz Wikipedii. Nie ma więc lepszej szansy dla GPT-4 na wykazanie się niż polskie matury.

Maturami "karmiłam" już wcześniej zarówno ChatGPT i GPT-4, jednak zwykle były to zadania z różnych lat i różnych przedmiotów. Teraz skupię się wyłącznie na języku polskim, a konkretnie na 7 zadaniach. Choć bardzo chciałabym przepuścić wszystkie zadania maturalne - których jest ponad 20, to ich ilość oraz treść na to nie pozwala. Treść, ponieważ niektóre zadania opierają się na załączonych w arkuszu ilustracjach lub relatywnie długich tekstach źródłowych. Dlatego wybrałam z arkusza kilka zadań i delikatnie zmieniłam ich sformułowanie na łatwiejsze dla zrozumienia dla sztucznej inteligencji.

Matura 2023 z języka polskiego. Zadanie 1. kontra ChatGPT

Tekstem źródłowym w zadaniu był artykuł Agnieszki Krzemińskiej "Podróż jak prozak. Po co człowiekowi czasowa zmiana miejsca" opublikowany w Poradniku Psychologicznym "Polityki" (1/2019).

Na podstawie podanego tekstu, można stwierdzić, że turystyka faktycznie zmienia podróżującego człowieka. Autor odwołuje się do różnych aspektów tej transformacji.

Przede wszystkim, podróże mają wymiar poznawczy. Jak wspomina autor, turystyka jest "typowo ludzką formą bezinteresownej aktywności poznawczej". Podczas podróży uczymy się nowych rzeczy, poznajemy inne kultury, języki, smaki i dźwięki. To wszystko jest częścią procesu edukacyjnego, który wpływa na rozwój człowieka.

Podróżowanie pozwala również na zyskanie nowych doświadczeń i perspektyw. Autor zauważa, że podróżowanie jest jak rytuał przejścia. Jest to czas, w którym można robić rzeczy, których normalnie by się nie robiło - na przykład szastać pieniędzmi, jeść i pić bez umiaru, czy próbować nowych rzeczy. Wszystko to zmienia człowieka, kształtuje jego doświadczenia i wpływa na jego sposób postrzegania świata.

Podróżowanie może także przynieść korzyści dla zdrowia psychicznego. Autor podkreśla, że podróże pozwalają skupić się na sobie i swoich potrzebach, co skutecznie obniża poziom stresu. Wspomnienia z podróży mogą pomóc utrzymać równowagę po powrocie do domu.

Jednak autor zauważa, że turystyka ma również swoje negatywne aspekty. Może prowadzić do snobizmu i współzawodnictwa, a także do destrukcji kulturowego i naturalnego środowiska. Ale mimo tych negatywów, podróże nadal są ważnym elementem rozwoju i zmiany człowieka.

Podsumowując, na podstawie cytowanego tekstu, można stwierdzić, że turystyka rzeczywiście zmienia podróżującego człowieka, zarówno pod względem edukacyjnym, jak i doświadczeniowym, a także wpływa na jego zdrowie psychiczne. Jednak te zmiany mogą mieć zarówno pozytywne, jak i negatywne konsekwencje.

GPT-4 poprawnie zinterpretował zadanie, jednakże jego odpowiedź jest zbyt długa i nacechowana licznymi powtórzeniami ("autor zauważa", "podróże"). Jednak tylko teoretycznie rozwiązanie zadania jest za długie, jednak praktycznie treść polecenia nie ma ono z góry narzuconej długości, która tak czy tak różni się w zależności od pisma egzaminowanego.

Zadanie 7. (tzn 2. dla ChatGPT, ale 7. na maturze 2023)

Nazwa wirusa komputerowego "Trojan" (Koń trojański) jest trafna, gdy odwołamy się do mitu o wojnie trojańskiej. Mit ten opowiada o konflikcie między Grekami a mieszkańcami Troi, której kulminacyjnym punktem było wprowadzenie do miasta Troi drewnianego konia wypełnionego greckimi żołnierzami.

Grekowie zbudowali ogromnego drewnianego konia, wewnątrz którego ukryli swoich żołnierzy. Następnie podstępnie przekonali Trojan, że jest to dar pokojowy dla ich miasta. Po wprowadzeniu konia do miasta Trojańczycy świętowali, nieświadomi ukrytych w nim żołnierzy. Gdy noc nastała, greccy żołnierze wyszli z konia, otworzyli bramy Troi i pozwolili na wkroczenie reszty armii, która zniszczyła miasto.

Podobnie jak w mitologicznym Koniu trojańskim, wirus komputerowy Trojan ukrywa się w pozornie nieszkodliwym i wartościowym oprogramowaniu. Może to być skrypt powłoki, nowa gra komputerowa czy znana aplikacja. Użytkownicy nie są świadomi jego obecności ani szkodliwych intencji.

Gdy wirus Trojan zostaje zainstalowany na komputerze użytkownika, działa w ukryciu, nie zdradzając swoich destrukcyjnych celów. W odpowiednim momencie może uszkodzić system komputera lub inne komputery w sieci. Tak jak greccy żołnierze z mitu o wojnie trojańskiej, wirus Trojan działa podstępnie i niepostrzeżenie, aby osiągnąć swoje cele.

W związku z powyższym, odwołując się do mitu o wojnie trojańskiej, można uznać nazwę wirusa komputerowego "Trojan" za trafną. Podobnie jak w mitologicznym Koniu trojańskim, wirus ten ukrywa się w pozornie nieszkodliwym oprogramowaniu, aby wprowadzić szkodliwe funkcje i uszkodzić system użytkownika lub inne komputery działające w sieci.

Ponownie pojawia się problem długości, jednocześnie według nieoficjalnego klucza odpowiedzi, drugi akapit po drobnej redukcji długości byłyby dobrą odpowiedzią na zadanie.

Zadanie 10.

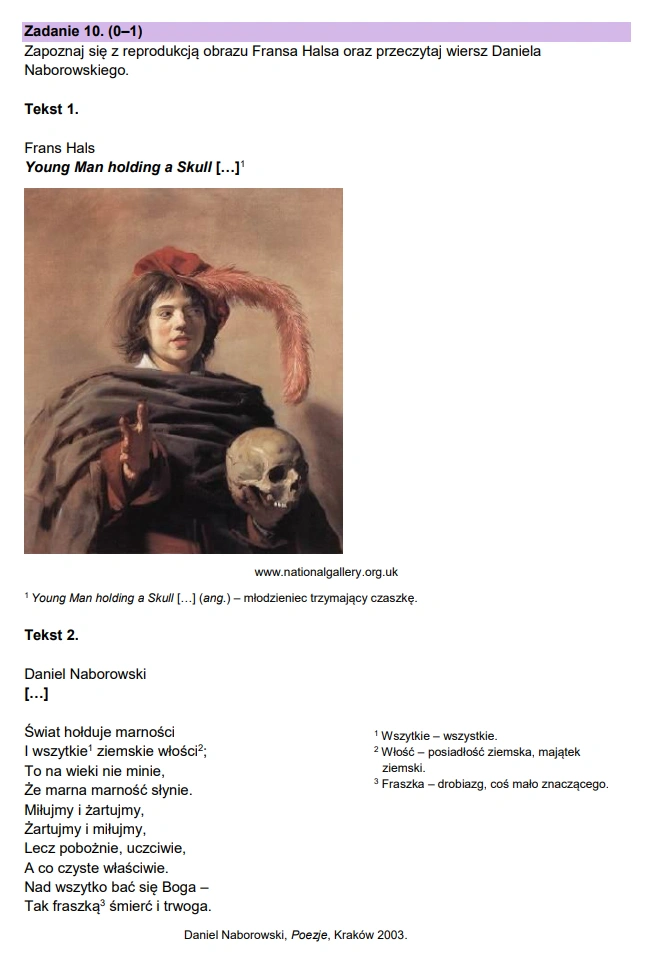

Motywem, który łączy wiersz Daniela Naborowskiego i obraz Fransa Halsa "Young Man holding a Skull" (Młodzieniec trzymający czaszkę) jest memento mori, czyli przypomnienie o śmierci i przemijaniu.

W wierszu Naborowskiego, autor odnosi się do marności świata, wskazując, że ziemskie włości nie mają trwałej wartości. Nakłania czytelnika do miłowania i żartowania, ale jednocześnie przestrzega, aby czynić to pobożnie i uczciwie. Kluczowe jest tu wezwanie do obawiania się Boga oraz stwierdzenie, że "fraszką śmierć i trwoga". Wiersz przypomina, że życie jest krótkie i nietrwałe, a śmierć jest nieunikniona, dlatego ważne jest, aby korzystać z życia, ale jednocześnie żyć zgodnie z zasadami moralnymi i pobożnością.

W obrazie Fransa Halsa przedstawiony jest młodzieniec trzymający czaszkę. Czaszka jest symbolem śmierci i przemijania. Postać młodzieńca, który trzyma czaszkę, sugeruje, że nawet młodzi ludzie powinni zdawać sobie sprawę ze swojej przyszłej śmierci i efemeryczności życia. Obraz również przypomina o marności ziemskich dóbr i ambicji, które są przemijające wobec nieuchronności śmierci.

Podsumowując, motywem łączącym wiersz Daniela Naborowskiego i obraz Fransa Halsa "Young Man holding a Skull" jest memento mori - przypomnienie o śmierci i przemijaniu. Obydwa dzieła wskazują na nietrwałość życia i ziemskich ambicji, jednocześnie podkreślając znaczenie życia zgodnie z zasadami moralnymi i pobożnością.

I to jest akurat ciekawe bo... GPT-4 się wywalił. Motyw wspólny dla prac Naborowskiego i Halsa to "vanitas" (łac. marność), skupiony wokół fascynacji śmiercią i przemijaniem. Vanitas nawiązuje do średniowiecznego memento mori, jednak jest odmiennym motywem. Sztuczna inteligencja OpenAI traci właśnie jeden punkt.

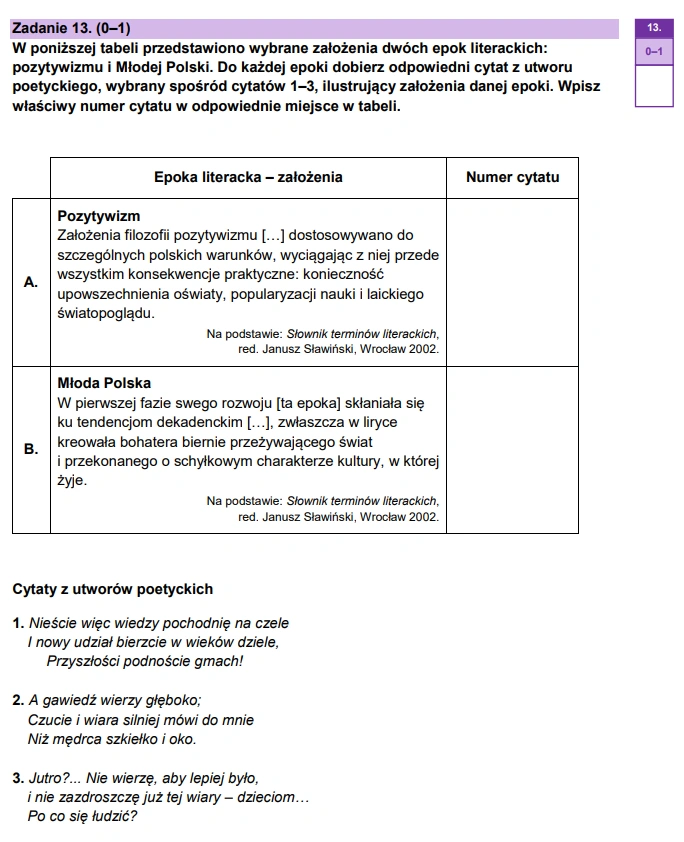

Zadanie 13.

Cytat numer 1 reprezentuje epokę literacką pozytywizmu, podczas gdy cytaty numer 2 i 3 są reprezentatywne dla Młodej Polski.

Pozytywizm to epoka literacka, która promowała idee postępu, nauki, racjonalizmu oraz zaangażowanie społeczne. Cytat numer 1 ("Nieście więc wiedzy pochodnię na czele I nowy udział bierzcie w wieków dziele, Przyszłości podnoście gmach!”) oddaje ducha tej epoki, podkreślając wagę wiedzy i rozwijania przyszłości.

Młoda Polska to epoka literacka, która kładła nacisk na indywidualizm, subiektywizm, uczucia oraz często wyrażała sceptycyzm wobec postępu i racjonalizmu. Cytat numer 2 ("A gawiedź wierzy głęboko;Czucie i wiara silniej mówi do mnie Niż mędrca szkiełko i oko.”) ilustruje tę postawę, podkreślając, że uczucia i wiara mają większe znaczenie niż naukowe podejście i racjonalizm. Cytat numer 3 ("Jutro?... Nie wierzę, aby lepiej było, i nie zazdroszczę już tej wiary – dzieciom… Po co się łudzić?”) również wpisuje się w kontekst Młodej Polski, wyrażając pesymizm, brak wiary w przyszłość i odmienne podejście niż to promowane przez pozytywistów.

Ze względu na użycie tabeli do przedstawienia zadania niemożliwym było przekazanie go sztucznej inteligencji w formacie takim, jak jest on w arkuszu egzaminacyjnym. Dlatego wstępna odpowiedź GPT-4 brzmiała 1 to pozytywizmu, 2 i 3 to Młoda Polska. Jednak po doprecyzowaniu pytania, model wskazał cytat numer 3 jako reprezentujący Młodą Polskę, w związku z czym jego odpowiedź zgadza się z nieoficjalnym kluczem odpowiedzi.

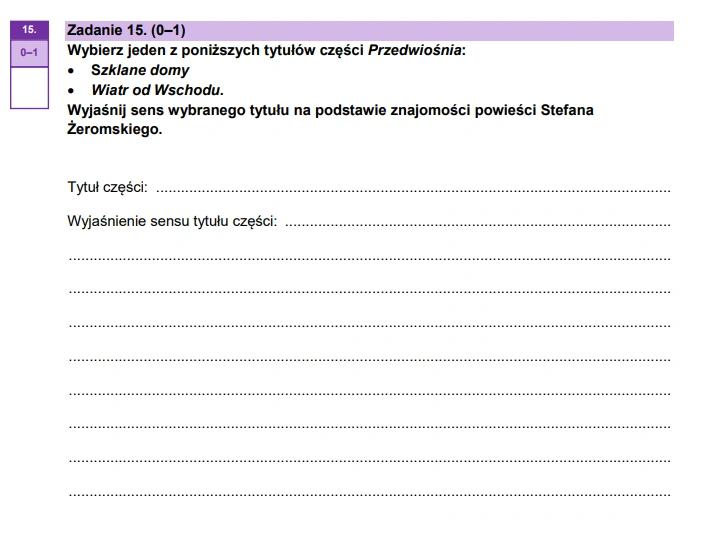

Zadanie 15.

Wyręczyłam GPT-4 i samodzielnie wybrałam za niego "Szklane domy".

W powieści Stefana Żeromskiego "Przedwiośnie" część zatytułowana "Szklane domy" odnosi się do alegorycznego znaczenia, które ukazuje kontrast między ideałami a rzeczywistością.

W "Szklanym domu" młody bohater powieści, Cezary Baryka, opuszcza swoje rodzinne strony i przybywa do Warszawy. Tytułowe "szklane domy" symbolizują marzenia, aspiracje i ideały bohaterów, które kierują ich działaniami. Te ideały wydają się być przezroczyste i kruche, tak jak szkło, ponieważ nie zawsze są one realne lub osiągalne w trudnych warunkach społecznych i politycznych ówczesnej Polski.

Cezary i inni bohaterowie muszą zmierzyć się z różnymi wyzwaniami i dylematami moralnymi oraz politycznymi, które zmuszają ich do zrewidowania swoich ideałów i przekonań. Tytuł "Szklane domy" jest więc metaforą, która sugeruje, że ideały i marzenia ludzi mogą być piękne, ale zarazem kruche i podatne na zniszczenie przez konfrontację z surową rzeczywistością.

W ten sposób, tytuł "Szklane domy" jako część powieści "Przedwiośnie" podkreśla główny motyw utworu - próbę pogodzenia ideałów i marzeń z realiami życia, a także dążenie do odbudowy i zmiany w trudnych czasach.

GPT-4 całkiem dobrze załapał, o jaką książkę chodzi (w przeciwieństwie do GPT-3.5, który swego czasu pisał kompletne głupoty przy pytaniach o literaturę pozytywistyczną). Mimo to jako egzaminujący uznałabym odpowiedzi GPT-4 za nadinterpretację i zbytnie skupienie się na wartości logicznej wyrażenia "szklane domy". Sztuczna inteligencja całkowicie pominęła kontekst samej powieści, w której to ojciec Cezarego Baryki przedstawił mu Polskę zabudowaną nowoczesnymi, szklanymi domami i stanowiły symbol utopijnej wizji Seweryna Baryki.

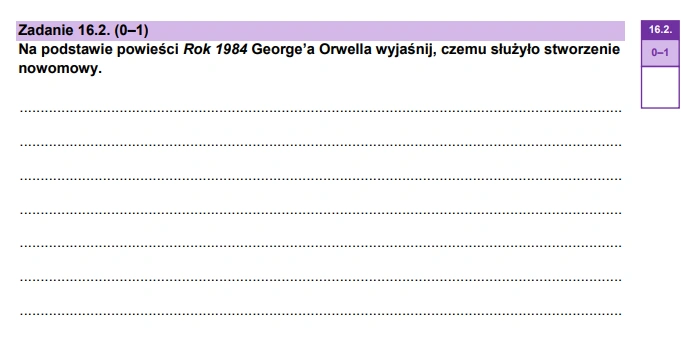

Zadanie 16.2.

W powieści George'a Orwella "Rok 1984" nowomowa to sztuczny język stworzony przez rządzącą Partię, aby kontrolować ludność i ograniczyć ich wolność myśli oraz wyrażania sprzecznych z oficjalną ideologią poglądów. Służyła ona kilku kluczowym celom:

1. Kontrola myśli: Nowomowa miała za zadanie ograniczyć zakres słów i pojęć, dzięki czemu ludzie mieli trudności z wyrażaniem i kształtowaniem myśli sprzecznych z doktryną Partii. Język został uproszczony, a wiele słów i pojęć zastąpiono jednym, wieloznacznym terminem, co utrudniało myślenie o alternatywnych ideach czy opozycyjnych poglądach.

2. Utrwalanie ideologii: Nowomowa wprowadzała nowe słowa i frazy, które utrwalały ideologię Partii. Przykładem jest słowo "dwójmyślenie", które oznacza zdolność do utrzymania dwóch sprzecznych przekonań w umyśle jednocześnie i akceptacji obu. Promowanie takich pojęć pomagało utrwalać lojalność wobec Partii.

3. Skupienie uwagi na Partii: Język nowomowy był tak skonstruowany, że skupiał uwagę ludzi na Partii i jej władzy. Zmniejszenie zakresu słów oraz ich uproszczenie sprawiało, że ludzie myśleli głównie o sprawach związanych z Partią, co umacniało jej kontrolę nad społeczeństwem.

4. Eliminowanie buntu: Nowomowa pozbawiała ludzi narzędzi wyrażania sprzeciwu wobec Partii. Zmniejszając zakres języka, Partia sprawiała, że ludzie nie potrafili nawet wyrazić swojego niezadowolenia czy buntu, co utrudniało organizowanie opozycji.

Podsumowując, nowomowa w powieści "Rok 1984" służyła kontroli ludności przez Partię poprzez ograniczanie wolności myśli, utrwalanie ideologii, skupienie uwagi na Partii oraz eliminowanie możliwości buntu. Nowomowa była jednym z kluczowych narzędzi totalitarnej władzy w świecie przedstawionym przez Orwella.

Ponownie wracamy do problemu długości, ale co ważniejsze pojawił się problem punktowania przez GPT-4 argumentów. Podczas pracy z GPT-4, która wymagała argumentacji, model wykazywał silną preferencję punktowania argumentów. Ponadto odpowiedź sztucznej inteligencji - choć poprawna - właściwie nie wymagała punktowania, gdyż cały ostatni akapit byłby wystarczający do zaliczenia zadania.

Czy GPT-4 wie tyle, co maturzysta?

Postawiony przed sześcioma (z ponad 20) zadań GPT-4 poradził sobie całkiem nieźle. Co prawda popełnił kilka błędów rzeczowych, lecz w zadaniach, w których zadanie byłoby bez wątpienia zaliczone poradził sobie całkiem nieźle. Warto także zauważyć, że nie GPT-4 praktycznie nie popełnił żadnego błędu ortograficznego, interpunkcyjnego czy gramatycznego (co nie jest tak oczywiste w przypadku innych dużych modeli językowych).

Kilka razy wytknęłam SI zbyt długie rozwinięcie odpowiedzi, co jest problemem trudnym do rozwiązania. Bo z jednej strony to wina promptu - nie precyzował długości, z drugiej same zadania nie miały sprecyzowanej długości wypowiedzi, a jedynie pole, które wskazuje maturzystom orientacyjną długość tekstu.

Nawet pomimo faktu, że nie jest to moja pierwsza zabawa z GPT-4, to możliwości modelu nadal mnie pozytywnie zaskakują. Matura napisana przez GPT-4 na pewno nie jest na "sto procent", ale na mocne 70 procent? Pewnie tak.