Najnowsza historia laptopów - tak ewoluował komputer przenośny

W poprzednim tekście na temat rozwoju mobilnych komputerów zatrzymałem się na roku 2000. Datę tę wybrałem nie bez powodu. Po pierwsze, jest to przełom stuleci, czas szczególny i symbol sam w sobie. O wiele ważniejsze jednak jest, że wtedy laptopy przybrały obecną formę i zamiast ciągle się zmieniać, zaczęły stopniowo, delikatnie ewoluować.

Myślę, więc jestem… laptopem

Jednak zanim to zrobię, przedstawię komputer, który został pominięty w poprzednim tekście, a jest jednym z najważniejszych sprzętów na rynku i jest uosobieniem delikatnej, niezauważalnej wręcz ewolucji jak żaden inny. Nie ma chyba na świecie firmy, która nie marzyłaby o tym, aby wprowadzony przez nich na rynek produkt stał się standardem w swojej klasie. Wyznacznikiem jakości, jednoznacznym z daną kategorią skojarzeniem i punktem wyjściowym do porównań wszystkich produktów konkurencji. Niewielu się to jednak udaje.

Z tym zadaniem poradził sobie jednak IBM, którego linia laptopów ThinkPad stała się synonimem laptopa biznesowego i od lat cieszy się niesłabnącą popularnością. Stał się odpowiednikiem dobrze skrojonego garnituru w świecie laptopów. Nawet pomimo tego, że komputer z tym logo wprowadzony na rynek w tym roku trudno jest odróżnić laikowi od jego odpowiednika sprzed kilkunastu lat.

Co najciekawsze, produkowanie „czarnych pudełek” (jak opisywał je zresztą sam IBM) nie było wcale planem od samego początku, kiedy w 1992 zadebiutował pierwszy model ThinkPada. Komputer miał być prosty w swojej formie, skupiony jak najbardziej na wykonywaniu powierzanych mu zdań i o tym właśnie miał informować wszystkich, którzy na niego spojrzeli. Nikt nie spodziewał się, że wizerunek ten błyskawicznie stanie się na tyle charakterystyczny i mocny, że każda najmniejsza zmiana może spotkać się z gigantycznym sprzeciwem fanów. Tak, nawet w czarnym pudełku można się zakochać.

Mimo niewielkich zmian w wyglądzie przez długie lata, lista innowacji, które przyniosły nam w tym czasie kolejne laptopy z serii ThinkPad mogłaby zawstydzić niejedną linię „designerskich” laptopów. TrackPoint, którego można było odnaleźć już w pierwszym ThinkPadzie, lampki oświetlające klawiaturę na długo przed wprowadzeniem bardziej subtelnego podświetlenia, czytnik odcisku palca (2004 rok), stalowe ramy obudowy, a później wzmocnienie obudowy stopami tytanu lub magnezu czy genialne klawiatury (w tym takie jak ta zastosowana w modelu 701), odporne na zalanie – to tylko niektóre z nich.

Do ThinkPadów można podchodzić różnie. Dla jednych są odpowiednikiem dyskretnej, luksusowej limuzyny, dla innych natomiast są tym samym, czym wozy dostawcze – mułami roboczymi, niemożliwymi do „zajechania”. Niezależnie od tego, pewne jest jednak jedno – teoretycznie niepozorny, nie rzucający się w oczy komputer, dla niektórych będący wręcz zaprzeczeniem estetyki, rozpoznasz zawsze z daleka i powiążesz z małą, czerwoną kropką.

Podwaliny pod Core2 Duo

W 2003 roku miała premierę platforma Intel Centrino, która składała się z procesora, chipsetu, płyty głównej oraz interfejsu sieci bezprzewodowej. Była ona przeznaczona do komputerów przenośnych. W 2002 roku laptopy stanowił zaledwie 23,5% wszystkich sprzedanych komputerów, jednak Intel przeczuwał, że tego typu maszyny szybko wyprą komputery stacjonarne. By przyspieszyć ten proces zdecydował się wprowadzić na rynek platformę, która będzie cechować się dwukrotnie niższym poborem energii. Intel Centrino jest platformą o tyle ciekawą, że bazuje na architekturze P6 stosowaną w procesorach Pentium III.

Laptopy dla entuzjastów i profesjonalistów

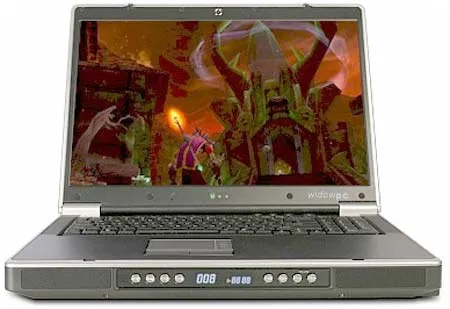

W połowie pierwszej dekady XXI wieku pojawiły się dwie maszyny, które raz na zawsze zmieniły rynek komputerów. Pierwsza z nich to wydany w 2005 roku WidowPC Sting 917X2, jeden z pierwszych laptopów stworzonych z myślą o graczach.

Urządzenie to nie należało do lekkich, gdyż było wyposażony w bardzo wydajne podzespoły i umożliwiające działanie takiego potwora bardzo głośne chłodzenie. Dzięki zastosowaniu w tym laptopie procesora AMD Athlon 64 X2 był to też pierwszy komputer mobilny wyposażony w dwurdzeniowy procesor. Inne zastosowane podzespoły to 2 GB pamięci RAM, karta graficzna Nvidia GeForce 7800 GTX 256 MB, nagrywarka DVD oraz 17-calowy ekran o rozdzielczości 1920 x 1200 pikseli, nieosiągalnej nawet dla większości dzisiejszych komputerów. Cena takiego komputera wynosiła aż 3500 dol. i z całą pewnością nie była to maszyna przeznaczona dla przeciętnego zjadacza chleba.

Dosłownie kilka miesięcy później na rynku pojawił się pierwszy laptop reklamowany jako maszyna, która może dorównać komputerom stacjonarnym. Był to oczywiście wydany w 2006 roku Apple MacBook Pro, czyli pierwszy komputer Apple wykorzystujący podzespoły znane ze standardowych pecetów, w tym procesory Intela oparte o architekturę x86.

Apple MacBook Pro oprócz tego wykorzystywał 1 GB pamięci RAM, dysk twardy o pojemności 80-120 GB, nagrywarkę DVD oraz kartę pamięci ATI Mobility Radeon X1600 ze 128 lub 256 MB pamięci. Maszyna była dostępna w dwóch wersjach - 15,4-calowej z ekranem o rozdzielczości 1440 x 900 pikseli oraz większej, 17-calowej z wyświetlaczem cechującym się rozdzielczością 1680 x 1050 pikseli. Od tego czasu MacBook Pro stał się marzeniem niemal każdego komputerowego estety.

Pierwsze tchnienie współczesnej mobilności

W 2006 roku, jeszcze przed prezentacją iPhone’a, Intel wraz z Microsoftem przeczuwali nadejście ery mobilności. Niestety ówczesny układy Intela nie miały za wiele wspólnego z energooszczędnością, zaś Microsoft dysponował znienawidzonym systemem Windows Vista, który ze względu na duże wymagania nadawał się jak pięść do nosa. Z tego powodu w wielu urządzeniach tego typu zdecydowano się na zastosowanie oprogramowania Windows XP.

Jeśli chodzi o specyfikację, UMPC były wyposażone w 7-calowy ekran o rozdzielczości 800 x 480 pikseli i często były pozbawione klawiatury. Oprócz tego sprzęty te miały jednordzeniowe procesory Intel Celeron M oraz Pentium M o częstotliwości taktowania zegara rdzeni równej 900-1000 MHz. Sprzęt ten ważył mniej niż 1 kg i umożliwiał podłączenie wielu urządzeń bezprzewodowych umożliwiających stworzenie z niego miniaturowego, pełnowartościowego, ale bardzo wolnego komputera. Urządzenia te, zupełnie niedopasowane do rynku, zostały wyparte z rynku przez netbooki, a następnie tablety.

Jednym z najważniejszych wydarzeń ostatnich lat było pojawienie się zupełnie nowej platformy mobilnej, czyli netbooków. Jednak zanim pierwsze tego typu maszyny faktycznie powstały, pojawiła się bardzo szlachetna koncepcja OLPC, czyli One Laptop Per Child. Ten powołany w styczniu 2005 roku projekt przewidywał dostarczenie do najbiedniejszych krajów prostych komputerów, które ułatwiłyby edukację tamtejszych dzieci. Urządzenie to przed swoją premierą cieszyło się ogromną popularnością w mediach, ponieważ miało kosztować mniej niż 100 dol. Jak na ówczesne czasy koszt takiego sprzętu był zatem najzwyczajniej w świecie wyjątkowo niski, wręcz śmieszny.

Niestety ostatecznie cena tej maszyny wyniosła 140 dolarów, by na rynku konsumenckim wynieść aż 200 dolarów. Specyfikacja tej maszyny to układ AMD Geode LX-700 o częstotliwości taktowania 433 MHz i wyposażony w wiele zintegrowanych układów, w tym chip graficzny. Komputer był też wyposażony w 256 MB pamięci RAM, 1 GB pamięci dyskowej oraz 7,5-calowy wyświetlacz o rozdzielczości 1200 x 900 punktów. Choć sprzęt ten nie osiągnął zamierzonych celów i nie sprzedał się tak jak planowano, był bardzo ważną maszyną, dzięki której producencie podchwycili ideę netbooków.

Pierwszą maszynę tego typu wydał Asus. Jego EeePC 2G miał procesor Intel Celeron-M YLV 353 900 MHz, zintegrowaną kartę graficzną GMA900, 512 MB pamięci RAM, 2 GB pamięci dyskowej oraz 7-calowy ekran z ogromną ramką, o rozdzielczości 800 x 480 pikseli. Były one oparte na bardzo słabych komponentach, na przykład procesorach Intel Atom, które wówczas miały znaczny problem nawet z zachowaniem płynności przeglądania stron internetowych.

Netbooki ze względu na za małe wymiary i niską rozdzielczość ekranu niepozwalającą na wygodną pracę po kilku latach zostały wyparte przez 10-calowe komputery oparte na platformie AMD Ontario, które w swoim czasie było najlepszą tanią platformą mobilną.

Komputery z procesorami AMD C-60 oraz C-70 można było kupić już za 1200 zł, a oferowały przy tym rozsądną moc i bardzo długi czas pracy na akumulatorze. Dostępne były też 11-calowe komputery oparte o APU z serii E. Dysponowały one większą rozdzielczością ekranu niż netbooki (1366 x 768 pikseli), miały większą klawiaturę, a takie były znacznie wydajniejsze od ówczesnych modeli z procesorami Atom i z tych powodów znacznie bardziej nadawały się do pracy i grania w starsze tytuły. Intel starał się im przeciwstawiać swoje procesory Atom połączone wraz z kartami graficznymi GeForce. Powodowało to jednak konieczność stosowania bardziej skomplikowanej płyty głównej, co znacznie podnosiło cenę komputera.

Czas na fuzję

Rok 2006 był ważny nie tylko dla branży mobilnej, ale też dla całego rynku PC. Wówczas doszło do wyjątkowo znaczącej i niespodziewanej transakcji. Otóż wówczas AMD, główny konkurent Intela, postanowił wykupić firmę ATI tworzącą układy graficzne Radeon. Tym samym AMD stało się nie tylko konkurentem Intela, ale również Nvidii.

To właśnie dzięki temu ruchowi możliwe okazało się stworzenie systemów z serii Fusion - jednego układu pełniącego zarazem funkcję procesora oraz karty graficznej. Dzięki temu powstały takie platformy jak Ontario, Zacate, Llano, Trinity, Richland, Kaveri oraz wiele innych. W ten sposób AMD stał się też firmą, która oferuje w swoich układach najwydajniejsze chipy graficzne, dzięki czemu komputery napędzane przez AMD są jednostkami nadającymi się do każdego rodzaju zadań - pracy, konsumpcji multimediów oraz grania w starsze tytuły lub nowsze przy ograniczeniu ustawień szczegółowości grafiki.

Połączenie procesora i karty graficznej w jeden układ okazało się bardzo ciekawą koncepcją, która jak najbardziej ma przyszłość. Jest to pierwszy głęboko zintegrowany układ w komputerze, który jest w stanie wykonać wiele różnego rodzaju działań. Co prawda w początkowym okresie APU nie było doceniane, gdyż oprogramowanie korzystało glównie z rdzeni procesora, ale teraz cały czas się to zmienia. Coraz więcej firm zauważyło, że w wielu rodzajach obliczeń wykorzystanie jednego układu składającego się z różnorodnych, zintegrowanych części jest bardziej opłacalne niż wykonywanie wszystkich możliwych rodzajów obliczeń za pomocą procesora. Widać to w programach takich jak Libre Office, Winzip czy Photoshop.

W dodatku coraz więcej funkcji typowych dla APU, takich jak chociażby HSA, sprawia, że układy te stają się coraz szybsze i lepiej działają w wielu programach. Proces ten będzie postępował cały czas między innymi ze względu na zastosowanie APU AMD w nowoczesnych konsolach do gier. Dzięki temu nowe gry będą doskonale przystosowane do korzystania z tego typu układów. Z kolei za producentami gier pójdą też deweloperzy innych programów, którzy będą chcieli coraz częściej stosować wielordzeniowość i inne nowe rozwiązania w swoich produktach.

Zalety tego typu rozwiązań dostrzega też Intel, który stara się braki w swoich układach graficznych kompensować za pomocą dodatkowych zintegrowanych układów, takich jak QuickSync, które nie działają tak wydajnie jak jeden APU pracujące na współdzielonej pamięci

Wszystko musi być Ultra

Apple również zauważył, że ludzie potrzebują mobilnych komputerów. Nie zdecydował się jednak na wydanie swojego netbooka, ponieważ komputery te wówczas nie mogły zaoferować odpowiedniej płynności działania oraz wyglądu przystającego komputerom Apple. Zamiast tego w 2008 roku pojawił się pierwszy MacBook Air wyposażony w procesor Core 2 Duo, mało pojemny, ale bardzo szybki i odporny na uszkodzenia dysk SSD (od 2010 roku) oraz 11,6- lub 13,3-calowy ekran.

Był to komputer piękny, wydajny i jak na swoje czasy bardzo szybko się uruchamiał. Wszystko dzięki zastosowaniu wspominanego już wcześniej dysku SSD. Komputer ten cechował się bardzo cienką obudową i długim czasem pracy na akumulatorze. MacBook Air raz na zawsze odmienił rynek laptopów i przez bardzo długi czas nie doczekał się żadnej poważnej konkurencji.

O dziwo producenci komputerów z systemem Windows potrzebowali aż trzech lat na stworzenie komputera konkurencyjnego dla MacBooka Air. Nieco pomógł w tym Intel. Firma ta, podobnie jak Microsoft, przespała mobilną rewolucją (mimo iż Apple prosił ją o stworzenie procesora do iPhone'a) i szukała sposobu na ożywienie kurczącego się rynku komputerów. Było nim wprowadzenie Ultrabooków, czyli komputerów mających konkurować z MacBookami Air pod kątem atrakcyjności oraz wydajności. W tym celu Intel ustalił sztywną specyfikację, której musiały się trzymać wszystkie przedsiębiorstwa produkujące tego typu komputery.

Dzięki temu większość UItrabooków była komputerami niezwykle ładnymi i wystarczającymi do codziennych zadań. Niestety Intel przy okazji ustalania specyfikacji Ultrabooków sprawił, że taką nazwę mógł nosić tylko komputer wyposażony w procesory Intel Core. Intel w ten sposób zagarnął dla siebie całą nową kategorię sprzętową, a Ultrabooki stały się komputerami niewyrównanymi pod względem specyfikacji. Miały bardzo wydajne procesory z rodzin Core i5 oraz Core i7, ale mało wydajne karty graficzne. W praktyce oznaczało to, że na urządzeniach takich nie dało się praktycznie grać w żadne nowe tytuły.

O ile użytkownikom Mac OS X wada ta nie przeszkadzała, to osoby korzystające z Windowsa, które po wydaniu grubych kilku tysięcy na komputer nie mogły uruchomić znacznej większości gier nawet w niskich ustawieniach szczegółowości grafiki, były zawiedzione. Producenci starali się łatać te braki za pomocą dedykowanych kart graficznych Nvidia GeForce, jednak ze względu na bardzo cienką obudowę możliwe było używanie do tego celu stosunkowo mało wydajnych modeli, które i tak powodowały znaczne nagrzewanie się obudowy komputera i skrócenie jego czasu pracy.

Problem ten z czasem się zmniejszył, jednak i tak pod względem wydajności zintegrowanych układów graficznych rządzi AMD. Dlatego uważam, że wiele osób wolałoby mieć Ultrabooka ze słabszym procesorem i mocniejszym układem graficznym. W ten sposób te cienkie urządzenia stałyby się bardziej uniwersalne.

Polityka Intela zmusiła AMD do działania w segmencie komputerów Ulltrathin, który istniał długo przed Ultrabookami. O tym, jak bzdurny jest podział na Ultrabooki i Ultrathiny świadczy fakt, że na rynku istnieje mnóstwo konstrukcji, które są wyposażone nawet w identyczne obudowy, ale inne układy. Ten z procesorem Core jest Ultrabookiem, zaś bliźniacza maszyna z procesorem AMD tego znaczka mieć nie może. A szkoda, bo komputery AMD są przez to gorzej postrzegane, choć nie powinny. Po prostu dwie konkurujące ze sobą firmy mają różne priorytety. Jednostki Intela górują pod względem energooszczędności, zaś układy AMD są bardziej zrównoważone i nadają się do większej liczby zadań.

Na rynku każdy znajdzie coś dla siebie. Szkoda tylko, że zanim to zrobi, w głowie będzie miał prawdziwy galimatias.

Trochę tablet, trochę komputer

Coraz większa popularność tabletów oraz spadający popyt na laptopy sprawił, że wiele firmy postanowiło połączyć możliwości tabletu i laptopa. Pojawiły się wówczas dwa typy komputerów - tablety z doczepianą klawiaturą, a także maszyny konwertowalne. Pierwszego rodzaju urządzeń chyba nie trzeba nikomu przedstawiać - są to urządzenia, w których wszystkie podzespoły znajdują się w części tabletowej.

Z kolei stacja dokująca w formie klawiatury pełni formę warstwy ochronnej, może się w niej znajdować też dodatkowy akumulator lub dysk twardy, na który nie ma miejsca w tablecie. Zaletą takiego urządzenia jest możliwość używania go jako pełnoprawnego tabletu, zaś wadą złe wyważenie. Ze względu na umieszczenie wszystkich podzespołów w górnej części urządzenia bardzo łatwo jest je przewrócić.

Z kolei urządzenia konwertowalne to laptopy umożliwiające obrócenie ekranu o niemal 360 stopni i używanie jak tabletu. Zaletą tego typu urządzeń jest budowa umożliwiająca wygodniejszą pracę biurową. Wadą z kolei duże wymiary i waga, przez które trudno jest używać tego sprzętu jak typowego tabletu, praktycznie nie da się go trzymać w jednej ręce. Zaletą tego, że komputery upodobniły się do sprzętów mobilnych jest wprowadzenie nie tylko ekranów dotykowych, ale też znaczne zwiększenie ich szczegółowości. Przez bardzo długi czas komputery były wyposażone w ekrany o niskiej rozdzielczości.

Gdy Apple, a za nim inni producenci komputerów, zdecydowali się na wprowadzenie do urządzeń mobilnych bardziej szczegółowych ekranów klasy Retina, niektóre małe smartfony i tablety zaczęły mieć większą rozdzielczość wyświetlaczy niż laptopy oraz niektóre monitory komputerowe. Producenci komputerów dzięki temu zauważyli, że użytkownicy potrzebują lepszych ekranów i zaczęło pojawiać się coraz więcej laptopów z ekranami 900p oraz 1080p.

Kamieniem milowym w tej dziedzinie było wydanie w 2012 roku MacBooka Pro z ekranem Retina o rozdzielczości o maksymalnej rozdzielczości 2880 x 1440 pikseli. Z kolei w 2014 roku na rynku zaczęły pojawiać się pierwsze laptopy wyposażone w ekrany o rozdzielczości 4K.

Nie tylko parametry

W końcu jednak okazało się, że kiedy stworzenie cienkiego, wydajnego i przyzwoicie wycenionego komputera przenośnego jest możliwe, konieczne będzie poszukiwanie dodatkowych rozwiązań, które pozwalają wyróżnić laptopa. Stąd też przy współczesnych premierach procesorów nie zawsze słyszymy o wzroście mocy czy wydajności, choć z całą pewnością możemy na to liczyć. Większość klientów jest już bowiem w pełni usatysfakcjonowana tym, jak sprawnie działa ich komputer, licząc na to, że po zmianie na nowy... zauważą jakąkolwiek różnice. A skoro w wydajności jest już niewiele miejsca na nowości, pozostają dodatkowe funkcje. A te stara się nam zaoferować zarówno Intel, jak i AMD.

Wystarczy porównać chociażby to, jak kiedyś przesyłaliśmy obraz z komputera na telewizor - konieczny był kabel łączący obydwa urządzenia. Dziś sporo osób jest bardziej zainteresowanych tym, czy ich nowy laptop obsługuje WiDi/ScreenMirror niż to, ile operacji na sekundę jest w stanie wykonać. Szukamy tego, co faktycznie może nam się przydać - nieprzebrane zapasy mocy z całą pewnością nie należą do tej kategorii.

Kolejne tego typu funkcje to opisywane przez nas AMD Face Login, czyli logowanie się do systemu operacyjnego oraz serwisów internetowych za pomocą technologii rozpoznawania twarzy, a także sterowanie gestami. Co prawda to ostatnie rozwiązanie działa tylko w kilku aplikacjach, ale z całą pewnością będzie rozszerzane na nowe programy. AMD zapowiada też, że dzięki wykorzystaniu mocy zintegrowanej karty graficznej możliwe będzie stworzenie kolejnych funkcji niedostępnych u konkurencji. Oprócz tego AMD stara się nie tylko tworzyć ciekawe rozwiązania, ale też samodzielnie naprawiać braki oprogramowania. Przykładem tego jest wykorzystanie w komputerach AMD technologii Bluestacks, która dodaje do komputerów z systemami Windows 8 ogromną bazę aplikacji mobilnych. Krótko mówiąc, umożliwia uruchamianie nie tylko aplikacji stworzonych z myślą o środowisku Microsoftu, ale też tych stworzonych dla systemu Android.

Jak wygląda rynek, co przyniesie przyszłość?

W tym momencie warto się zastanowić, jak komputery będą wyglądać w przyszłości. Jedno jest pewne, laptopy będą przejmować coraz więcej cech tabletów. Każdy komputer zostanie wyposażony w wyświetlacz dotykowy oraz wiele multimedialnych funkcji, takich jak bezprzewodowe przesyłanie obrazu (Miracast oraz AMD/Intel Wireless Display), bezprzewodowe ładowanie, sterowanie gestami (AMD Gesture Control), głosem (Cortana) oraz odczytywanie naszych emocji z twarzy i rozpoznawanie osoby, która pracuje przy komputerze (Face Login).

Gdy dodamy do tego zwijane wyświetlacze oraz stosowanie APU wyposażonych w wydajne zintegrowane chipy graficzne okaże się, że będziemy mogli wszędzie ze sobą nosić maszynę wystarczającą do wymagającej pracy oraz do gier, jednocześnie wyposażoną w ogromny ekran wielkości dużego telewizora. Czy to nie piękna wizja?

Patrząc na najnowszą historię laptopów można dojść do wniosku, że największy wpływ na niego miały cztery firmy - dwie tworzące podzespoły i dwie tworzące komputery. Do pierwszej kategorii należą Intel i AMD. Intela trzeba pochwalić za to, że rozruszał rynek x86, a następnie wypuszczał kolejne Pentiumy i na początku XXI wieku stworzył architekturę Centrino, z której wywodzą się wszystkie jego do dziś używane układy. Jednocześnie firma ta kładła ogromny nacisk na energooszczędność, dzięki czemu komputery długo działają na bez ładowania.

Z kolei AMD początkowo tworzyło świetne procesory Athlon 64, by następnie przejąć ATI, jedno z czołowych przedsiębiorstw tworzących karty graficzne i stworzyć zupełnie nowy typ układu, czyli APU. Chip, który udowadnia kilka rzeczy: Że zintegrowana karta graficzna nie musi być słaba, że nawet tani układ może oferować moc wystarczającą na wszystkich płaszczyznach i że o jakości komputera nie decyduje sucha wydajność, ale zawarte w nim nowoczesne funkcje.

Obie firmy ponadto angażowały się w powstawanie nowych kategorii urządzeń - AMD współtworzyło OLPC, które potem przerodziły się w netbooki, zaś Intel wykreował Ultrabooki oraz mniej udane rozwiązania, takie jak UMPC, które też były ważne, gdyż pokazały, jak rynek urządzeń mobilnych nie powinien wyglądać. Jeśli zaś chodzi o firmy tworzące same komputery, zdecydowanie może podobać się postawa Apple oraz IBM, a potem Lenovo. Firma spod znaku nadgryzionego jabłka jako pierwsza wdrożyła gładzik i łączność bezprzewodową WiFi, a następnie pokazała, że laptopy mogą wyglądać naprawdę stylowo.

Oprócz tego w mistrzowski sposób zakorzeniła się na rynku mobilnym i niemal stała się przedmiotem kultu. Z kolei Thinkpady stworzone ponad dwie dekady temu jako pierwsze wprowadziły trackpoint i się kultowymi, archetypowymi przykładami laptopów do pracy oraz... istnymi MacBookami rynku PC. Obie firmy pokazały konkurencji, jak powinny wyglądać prawdziwe laptopy i tym samym sprawiły, że rynek przenośnych komputerów wygląda obecnie tak, a nie inaczej.

Zdjęcie główne pochodzi z serwisu Shutterstock.