Skąd w ogóle wzięła się sztuczna inteligencja? To historia wielkich rozczarowań i małych sukcesów

Zanim pojawił się ChatGPT, AI miała wzloty, upadki i zimy finansowania. Historia jej rozwoju to lekcja technologicznej cierpliwości i ambicji.

Sztuczna inteligencja przestała być domeną laboratoriów i podręczników - dziś towarzyszy nam w wyszukiwarkach, edytorach tekstu, smartfonach i komunikacji z innymi ludźmi. Ale droga do tego momentu była zaskakująco długa i pełna zakrętów.

Historia AI to nie opowieść o jednym przełomie, lecz ciągła walka z ograniczeniami technologicznymi, brakiem danych, a czasem z własnymi złudzeniami. Od symbolicznych reguł logicznych i programów które po miesiącach treningu nauczyły się grać w warcaby, po samouczące się modele językowe - rozwój tej dziedziny pokazuje, że to, co kiedyś uchodziło za niemożliwe, z czasem staje się oczywistością.

Gdy matematyka spotkała mózg

Narodziny idei sztucznej inteligencji nie zaczęły się od komputerów. Zaczęło się od ludzi, którzy próbowali zrozumieć, jak działa ludzki umysł i czy da się jego zasady zapisać w matematycznej formie. Z tej perspektywy przełomową publikacją był artykuł z 1943 roku autorstwa Warrena McCullocha i Waltera Pittsa "A Logical Calculus of the Ideas Immanent in Nervous Activity" (Logiczne obliczenie idei immanentnych w aktywności nerwowej), w którym zaprezentowali matematyczny model neuronu i pierwszy mechaniczny model mózgu. To właśnie duetowi amerykańskich badaczy zawdzięczamy koncepcję, w której ludzki mózg to nic innego, jak maszyna zdolna rozwiązywać złożone problemy logiczne. Ich model dowodził, że sieć neuronowa może dokonać każdego obliczenia, jakie da się przeprowadzić przy pomocy teoretycznej maszyny Turinga.

W tym samym czasie Claude Shannon - twórca teorii informacji - udowodnił, że komunikację można wyrazić w sposób ścisły - jako zbiory bitów, szumów i entropii. Dzięki niemu informacja stała się czymś, co można mierzyć, przesyłać i przetwarzać - była fundamentalna nie tylko dla sztucznej inteligencji, ale i dla całego pojęcia informacji. Równolegle, bo w 1948 roku Norbert Wiener wydał książkę "Cybernetics: Or Control and Communication in the Animal and the Machine". Opisał w niej systemy – zarówno biologiczne, jak i techniczne – które działają na zasadzie sprzężenia zwrotnego. Pokazał, że organizm, maszyna czy społeczeństwo może funkcjonować efektywnie dzięki cyklowi: odbierania informacji, analizy, działania i korekty na podstawie efektów. Koncepcja ta była rewolucyjna, bo podważała granicę między żywym a mechanicznym sugerując, że maszynę można zaprogramować do działania adaptacyjnego. To właśnie cybernetyka dała AI pierwsze teoretyczne narzędzia do rozumienia i modelowania zachowań inteligentnych systemów. I to właśnie te trzy pozornie czysto teoretyczne prace stanowiły intelektualny grunt, na którym AI mogło wykiełkować.

Ale to Alan Turing nadał tej idei najśmielszy kierunek. W 1950 r. swoim eseju zaproponował sposób, by to sprawdzić - test Turinga. Polegał on na zorganizowaniu rozmowy między człowiekiem a maszyną (za pomocą tekstu), podczas której trzeci uczestnik - sędzia - miał zgadnąć, z kim rozmawia. Jeśli nie potrafiłby odróżnić człowieka od maszyny, oznaczałoby to, że maszyna przeszła test, wykazując się zachowaniem nieodróżnialnym od inteligencji ludzkiej. Test Turinga nie był technicznym eksperymentem, lecz ramą filozoficzno-praktyczną: inteligencja nie musi być biologiczna, by być realna.

"Sztuczna inteligencja" zaczęła się całkiem podobnie do romansu z lat 50.

Wszystkie te idee - matematyczne modele neuronów, teoria informacji, sprzężenie zwrotne, a także test Turinga - spotkały się w jednym miejscu i czasie. W 1955 r. John McCarthy, Marvin Minsky, Claude Shannon i Nathan Rochester przez kilka letnich tygodni prowadzili burzę mózgów, podczas której próbowali odpowiedzieć na pytanie - czy każdą formę inteligencji można zapisać na tyle precyzyjnie, by dało się ją odtworzyć w komputerze? Naukowcy byli zgodni - można i trzeba próbować. Efektem była zorganizowana przez nich konferencja, podczas której ogłosili termin "sztuczna inteligencja" oraz organizację warsztatów w Dartmouth przez sześć tygodni w lecie 1956 r, w czasie której 20 naukowców debatowało nad zagadnieniami takimi jak komputery, przetwarzanie języka naturalnego, sieci neuronowe, teoria obliczeń, abstrakcja i kreatywność

[...] "Nie jest trudno zaprojektować maszynę, która wykazuje następujący rodzaj uczenia się. Maszyna jest wyposażona w kanały wejściowe i wyjściowe oraz wewnętrzne środki zapewniające zróżnicowane odpowiedzi wyjściowe na sygnały wejściowe w taki sposób, że maszyna może być "szkolona" w procesie "prób i błędów" w celu nabycia jednej z szeregu funkcji wejścia-wyjścia. Taka maszyna, umieszczona w odpowiednim środowisku i wyposażona w kryteria "sukcesu" lub "porażki", może zostać wyszkolona do wykazywania zachowań "dążenia do celu". Jeśli maszyna nie jest wyposażona w sposób abstrakcyjnego przetwarzania materiałów sensorycznych lub nie jest w stanie go rozwinąć, może poruszać się po skomplikowanym środowisku jedynie poprzez żmudne, powolne kroki i generalnie nie osiągnie wysokiego poziomu zachowań" [...]

To właśnie wtedy narodziła się nazwa sztucznej inteligencji. John McCarthy ukuł ten termin chcąc wyraźnie odróżnić nową dziedzinę od cybernetyki i automatyki. Choć warsztaty w Dartmouth nie miały charakteru formalnego i nie przyniosły ze sobą spektakularnego przełomu naukowego, to wyznaczyły kierunek badań na kolejne dekady.

Od hipotez do pierwszych programów

Wkrótce po warsztatach zaczęły powstawać pierwsze działające programy, które (przynajmniej częściowo) realizowały zarysowane wcześniej idee. Jeszcze w tym samym roku w Dartmouth Allen Newell i Herbert Simon zaprezentowali Logic Theorist - program komputerowy, który potrafił samodzielnie dowodzić twierdzeń matematycznych. Logic Theorist udowodnił 38 z pierwszych 52 twierdzeń zawartych w rozdziale drugim książki Principia Mathematica autorstwa Whiteheada i Bertranda Russella, a także znalazł nowe krótsze dowody dla niektórych z nich. Nieco później ci sami badacze stworzyli General Problem Solver - program mający symulować proces rozwiązywania problemów logicznych. Choć działał skutecznie w przypadku prostych zadań, szybko ujawnił ograniczenia - rzeczywisty świat okazał się znacznie bardziej złożony niż zestawy puzzli.

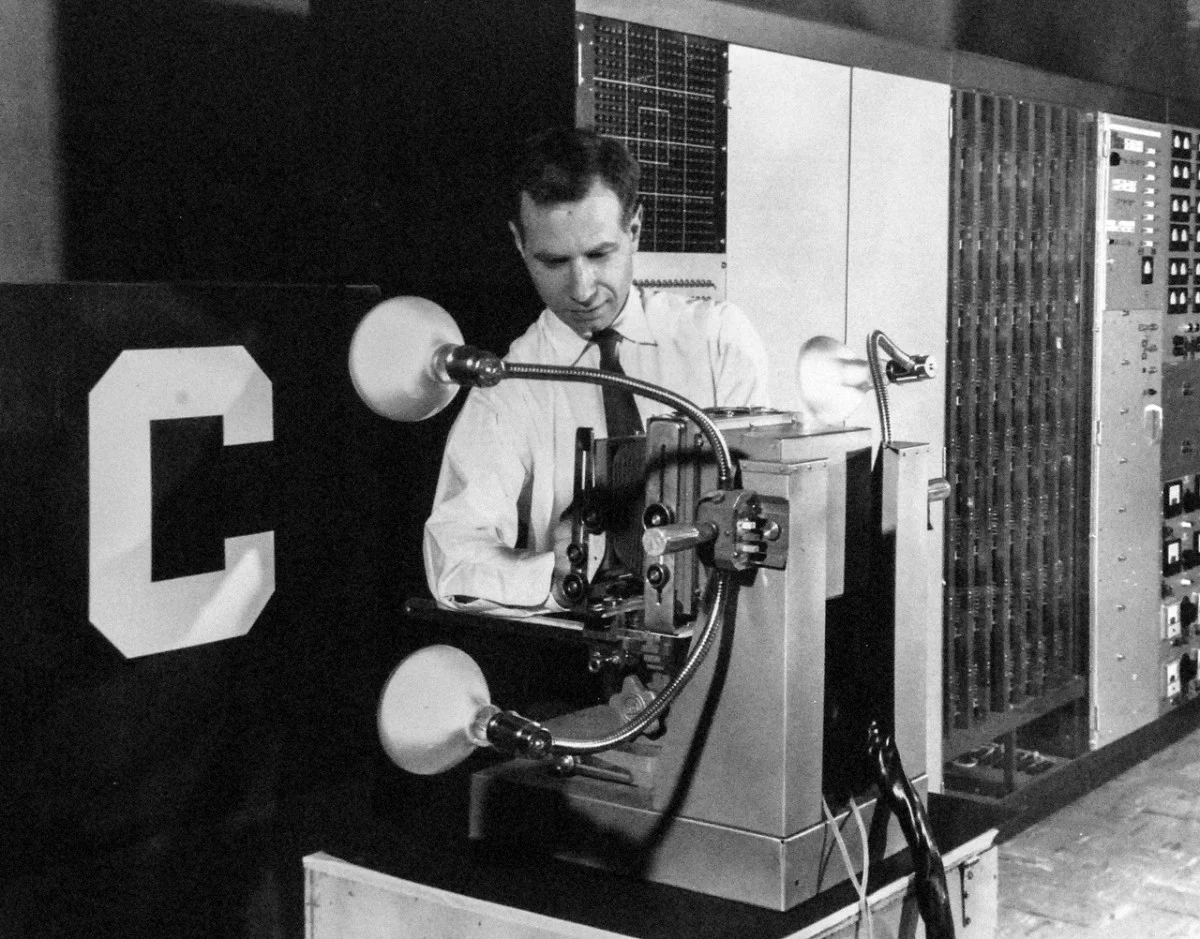

W tym samym czasie Arthur Samuel pracował nad czymś, co dziś nazwalibyśmy systemem uczącym się. Jego program do gry w warcaby analizował rozegrane partie, wyciągał wnioski z porażek i modyfikował strategię. Był to pionierski przykład uczenia maszynowego, w którym algorytm optymalizował swoje działanie w oparciu o doświadczenie.

Jeszcze większe nadzieje wiązano z perceptronem, który w 1958 r. zbudował Frank Rosenblatt. Była to pierwsza rzeczywista sieć neuronowa, wykorzystująca wagowe połączenia między "neuronami" oraz mechanizm korekcji błędów. Początkowo perceptron potrafił rozpoznawać wzory, takie jak litery alfabetu, ale szybko stał się symbolem ambitnych planów - Rosenblatt twierdził, że jego maszyna z czasem nauczy się czytać i tłumaczyć języki. Optymizm był ogromny.

Równolegle rozwijały się też języki programowania stworzone z myślą o AI. John McCarthy opracował LISP - elastyczny język, który przez dekady służył jako główne narzędzie pracy badaczy sztucznej inteligencji. W laboratoriach MIT powstały pierwsze interfejsy do komunikacji z komputerami w języku naturalnym, a program ELIZA, stworzony przez Josepha Weizenbauma, potrafił prowadzić proste rozmowy psychoterapeutyczne.

"ELIZA miała na celu symulację pracy psychiatry. Rola psychiatry została wybrana do tej próby rozmowy, ponieważ komputer mógł zawsze odpowiedzieć „Proszę kontynuować”, jeśli nie rozumiał, co zostało powiedziane. W przeciwnym razie maszyna dysponowała serią zaprogramowanych zdań, które mogła generować, gdy napotykała rozpoznane słowa lub struktury"

Ponadto ELIZA nie była w stanie nauczyć się nowych wzorców mowy ani nowych słów wyłącznie poprzez interakcje. Mimo to wiele osób miało wrażenie, że maszyna ich rozumie.

W latach 60. pojawiły się także pierwsze eksperymenty hardware'owe, łączące dotychczasowy dobytek oprogramowania z urządzeniami bardziej zgrabnymi niż wielkie metalowe szafy. Najbardziej znanym projektem tamtego okresu był Shakey - pierwszy robot mobilny, który samodzielnie podejmował decyzje na podstawie mapy otoczenia i planowania trasy. Choć poruszał się powoli i topornie, Shakey był dowodem na to, że AI może wyjść poza ekrany i działać w fizycznym świecie.

Jednak już w latach 70. nastąpiło bolesne zderzenie z rzeczywistością.

Nastała zima AI. Seria rozczarowań, cięć i powrót do podstaw

Postępy w AI były mniejsze, niż zapowiadano. W 1973 r. opublikowano tzw. raport Lighthilla, który skrytykował stan badań nad sztuczną inteligencją, wskazując na ograniczoną użyteczność tworzonych systemów i ich niemożność skalowania. Rząd Wielkiej Brytanii, kierując się jego wnioskami niemal całkowicie wstrzymał finansowanie projektów związanych z AI.

Nie był to odosobniony przypadek. W Stanach Zjednoczonych DARPA i inne agencje rządowe zaczęły oczekiwać namacalnych rezultatów, a nie jedynie teorii. To zakończyło złoty okres badań podstawowych. Dodatkowy cios przyszedł ze strony samych badaczy. Marvin Minsky i Seymour Papert opublikowali w 1969 r. książkę "Perceptrons", w której wykazali, że pojedyncze warstwy sieci neuronowych nie są w stanie rozwiązać nawet prostych problemów, takich jak funkcja XOR. Krytyka - choć dotyczyła tylko najprostszych modeli - skutecznie zniechęciła środowisko do dalszego rozwoju tej gałęzi nauki.

Tak rozpoczęła się tzw. zima AI - okres, w którym entuzjazm opadł, a finansowanie się kurczyło. W tym czasie rozwijały się przede wszystkim systemy ekspertowe, takie jak MYCIN i DENDRAL. Oparte na regułach "jeśli [...] to [...]” oraz na bazach wiedzy, potrafiły skutecznie wspomagać lekarzy czy chemików w wąsko zdefiniowanych dziedzinach. Były skuteczne, ale pozbawione zdolności adaptacji czy uczenia się.

Dopiero w drugiej połowie lat 80. nastąpiło powolne odrodzenie AI. Kluczowym przełomem było ponowne odkrycie algorytmu backpropagation, umożliwiającego skuteczne uczenie wielowarstwowych sieci neuronowych. Prace Geoffreya Hintona, Davida Rumelharta i Ronalda Williamsa przywróciły wiarę w sieci głębokie. Równolegle John Hopfield zaprezentował model sieci zdolnej do przechowywania wzorców - sieć Hopfielda - a Rumelhart i James McClelland zaproponowali nową paradygmatyczną koncepcję przetwarzania rozproszonego (PDP).

AI wróciła na ścieżkę rozwoju. Choć nadal nie była inteligentna w ludzkim rozumieniu, to zaczęła działać szybciej, skuteczniej i - co najważniejsze - na danych, a nie tylko regułach. Przed badaczami otworzył się nowy rozdział, którego rozwój miał już niebawem przyspieszyć wykładniczo.

Po długiej zimie AI, badania nad sztuczną inteligencją zaczęły odzyskiwać tempo

Kluczową rolę odegrał rozwój metod opartych na danych, rosnąca dostępność mocy obliczeniowej oraz praktyczne zastosowania AI w przemyśle i technologii. Na przełomie lat 80. i 90. uczenie maszynowe, wcześniej traktowane jako jedna z wielu gałęzi AI, zaczęło zyskiwać na znaczeniu jako niezależna dziedzina.

Jednym z przełomów było zastosowanie sieci neuronowych do rozpoznawania pisma odręcznego przez systemy bankowe i pocztowe. W 1989 r. Yann LeCun i jego zespół opracowali system oparty na tzw. konwolucyjnej sieci neuronowej (CNN), który rozpoznawał cyfry w kodach pocztowych. Był to jeden z pierwszych sukcesów AI w zastosowaniach komercyjnych - rozpoznawanie obrazów na dużą skalę.

W latach 90. rozwijano również algorytmy takie jak maszyny wektorów nośnych (SVM), które okazały się bardzo skuteczne w klasyfikacji danych. Równolegle powstawały systemy rekomendacyjne, używane później przez Amazon, Netflix czy Yahoo!. Kluczowym wydarzeniem stało się zwycięstwo komputera IBM Deep Blue nad mistrzem świata w szachach, Garrim Kasparowem, w 1997 roku. Choć Deep Blue nie korzystał z metod uczenia, a z rozbudowanej bazy reguł i przeszukiwania drzew decyzyjnych, był to symboliczny moment - maszyna pokonała człowieka w jednej z najbardziej złożonych gier logicznych.

Eksplozja danych i głębokie uczenie

Na początku XXI wieku sztuczna inteligencja wkroczyła w epokę danych. Pojawienie się internetu, eksplozja cyfrowych treści i rozwój usług online wygenerowały niespotykaną wcześniej ilość informacji, które można było analizować, klasyfikować i modelować. AI przestała być dziedziną eksperymentalną - zaczęła zasilać wyszukiwarki, systemy rekomendacji, filtry spamu i mechanizmy rozpoznawania obrazu.

Kluczowym punktem zwrotnym był rok 2006, gdy Geoffrey Hinton i jego zespół zaproponowali sposób efektywnego trenowania głębokich sieci neuronowych poprzez warstwowe wstępne uczenie (greedy layer-wise pretraining). Metoda ta pozwoliła na znacznie lepszą optymalizację modeli i otworzyła drogę do budowy znacznie głębszych, bardziej wyrafinowanych sieci.

W 2012 roku świat AI zmienił się na dobre. Model AlexNet, zbudowany przez Alexa Krizhevsky’ego, Ilyę Sutskevera i Hintona, wygrał prestiżowy konkurs ImageNet Large Scale Visual Recognition Challenge - z wynikiem o ponad 10 punktów procentowych lepszym niż konkurencja. AlexNet był głęboką konwolucyjną siecią neuronową (CNN), która uczyła się rozpoznawać obiekty na milionach zdjęć. Ten sukces pokazał, że metody deep learningu mogą nie tylko działać, ale działać spektakularnie – pod warunkiem, że dysponujemy odpowiednimi danymi i mocą obliczeniową.

W tym samym czasie zaczęła się rewolucja w przetwarzaniu języka naturalnego (NLP). W 2013 roku zespół Google Brain opracował word2vec - algorytm uczący się reprezentacji słów jako wektorów, uwzględniających ich kontekst semantyczny. Dzięki temu słowa zaczęto traktować nie jako symbole, ale jako punkty w przestrzeni matematycznej, między którymi można wykonywać operacje, np. "król" - "mężczyzna" + "kobieta" = "królowa".

Rozwój sieci rekurencyjnych (RNN), w szczególności architektur LSTM i GRU, umożliwił analizowanie sekwencji tekstu, a modele typu sequence-to-sequence (seq2seq) pozwalały tłumaczyć całe zdania między językami. To właśnie w tym okresie Google Translate zaczął działać nie na zasadzie reguł językowych, lecz uczenia maszynowego - trenowanego na milionach par zdań. Pojawiły się także pierwsze chatboty, które potrafiły generować proste odpowiedzi na zadawane pytania.

To wszystko działo się równolegle - i konsekwentnie budowało fundament pod architekturę, która miała zmienić wszystko.

"Uwaga to wszystko, czego potrzebujesz"

W 2017 r. zespół badaczy z Google Brain i Google Translate opublikował artykuł, który miał zrewolucjonizować krajobraz AI: Attention Is All You Need. Publikacja ta przedstawiła nową architekturę sieci neuronowej - Transformera - która zrywała z dotychczasowymi metodami przetwarzania sekwencji.

Dotychczas dominujące modele rekurencyjne (RNN, LSTM) analizowały tekst krok po kroku, co utrudniało równoległe przetwarzanie i ograniczało efektywność. Transformer działał inaczej: analizował całą sekwencję naraz, przyglądając się relacjom między wszystkimi słowami jednocześnie - bez względu na ich odległość. Kluczem do sukcesu był mechanizm samouważności (self-attention), dzięki któremu model mógł dynamicznie ważyć znaczenie słów względem siebie.

Transformer nie był większy ani głębszy od wcześniejszych sieci - był inaczej zorganizowany. Dzięki temu trenował się szybciej, skuteczniej i na znacznie większych zbiorach danych. Wkrótce kolejne firmy i zespoły badawcze zaczęły adaptować tę architekturę do różnych zadań: tłumaczeń, streszczania, klasyfikacji tekstu, generowania kodu czy rozpoznawania mowy.

Transformer nie był jedynie lepszym modelem. Był nowym paradygmatem.

AI trafia do mainstreamu

Po publikacji artykułu Attention Is All You Need w 2017 roku świat sztucznej inteligencji wszedł w nową fazę rozwoju. Architektura transformera okazała się tak elastyczna i skuteczna, że szybko stała się fundamentem kolejnych przełomowych modeli językowych. W 2018 r. Google wprowadził model BERT (Bidirectional Encoder Representations from Transformers), który po raz pierwszy umożliwił kontekstowe rozumienie języka "w obie strony" - czyli analizę słów nie tylko w kontekście wcześniejszych, ale też późniejszych fragmentów zdania.

Modele takie jak BERT, RoBERTa, XLNet czy T5 szybko znalazły zastosowanie w wyszukiwarkach, tłumaczeniach maszynowych, systemach rekomendacyjnych i chatbotach w obsłudze klienta. Choć przeciętny użytkownik nie zdawał sobie z tego sprawy, wiele usług codziennego użytku zaczęło działać szybciej, trafniej i bardziej naturalnie właśnie dzięki architekturze transformer opisanej w "AI: Attention Is All You Need". Rozpoczął się etap AI boom, czyli dynamicznego wdrażania modeli językowych w produktach cyfrowych, głównie na zapleczu.

W tym samym czasie OpenAI rozwijało własną linię modeli Generative Pretrained Transformer. W 2018 roku zaprezentowano GPT-1, rok później GPT-2 - model, który wzbudził kontrowersje ze względu na potencjalne możliwości generowania fałszywych informacji. Już wtedy GPT-2 potrafił tworzyć długie, spójne wypowiedzi na różne tematy, ale nie został w pełni udostępniony publicznie.

W 2020 r. światło dzienne ujrzał GPT-3 - model z 175 miliardami parametrów, znacznie potężniejszy niż wszystkie poprzednie. Dzięki metodzie tzw. few-shot learning, GPT-3 potrafił rozwiązywać zadania po otrzymaniu zaledwie kilku przykładów. Umożliwiało to generowanie kodu programistycznego aplikacji, tłumaczeń, streszczeń, a nawet poezji - wszystko bez konieczności dodatkowego trenowania ze zroeintowaniem na konkretne zadania.

Choć dostęp do GPT-3 oferowano poprzez API, dla większości użytkowników technologia ta pozostawała abstrakcyjna. Interfejsy oparte na promptach tekstowych wymagały zrozumienia sposobu działania modeli, a także umiejętności formułowania odpowiednich zapytań. To wciąż nie był moment wejścia AI do masowej świadomości - technologia była dostępna, ale nieoswojona.

ChatGPT był przełomem. Nie z perspektywy technicznej, a socjologicznej

To zmieniło się w listopadzie 2022 r., kiedy OpenAI udostępniło ChatGPT - prosty interfejs oparty na modelu GPT-3.5, który umożliwiał prowadzenie płynnych rozmów z AI w formie czatu. Z perspektywy interfejsu, ChatGPT nie różnił się wiele od typowego komunikatora. Z perspektywy użytkownika - to było jak rozmowa z istotą, która rozumie, co się do niej mówi. I to właśnie interfejs rozmowy z AI, a nie technologia przebiły AI do mainstreamu. Bo pierwsza iteracja ChatGPT to de facto ponad dwuletni model GPT-3 dostrojony tak, aby łatwiej się z nim konwersowało.

Jednak tyle (albo aż) wystarczyło, by ChatGPT zyskał milion użytkowników w ciągu zaledwie pięciu dni, a w kolejnych tygodniach trafił na nagłówki mediów, do szkół, firm, redakcji i laboratoriów badawczych. Po raz pierwszy model AI nie tylko działał, ale był dostępny, zrozumiały i użyteczny dla każdego - niezależnie od wiedzy technicznej.

Wkrótce pojawiły się kolejne modele i konkurencyjne rozwiązania: Claude od Anthropic, Bard (obecny Gemini) od Google, LLaMA od Meta. ChatGPT doczekał się wersji GPT-4, a OpenAI zaprezentowało także modele multimodalne - zdolne do przetwarzania obrazów, dźwięku i wideo. Rozwój interfejsów (takich jak wtyczki, narzędzia kodowania, edytory) sprawił, że AI stała się nie tylko wszechobecna, ale także niewidzialna - zintegrowana z produktami, aplikacjami i narzędziami pracy.

Patrząc ze współczesnej perspektywy widać wyraźnie, że kluczowe momenty w historii AI polegały nie tyle na przełomowych algorytmach, co na ich połączeniu z danymi, mocą obliczeniową i rzeczywistym zastosowaniem. Od testu Turinga po ChatGPT, od perceptronów po architekturę transformer, każda generacja narzędzi uczyła się na sukcesach i błędach poprzedników. Historia AI uczy, że technologia dojrzewa wolniej, niż obiecują to wizje futurystów - ale gdy już zaskoczy, zmienia reguły gry. To właśnie skrupulatne dążenie do wyznaczonego ponad 70 lat temu celu, a nie magia, uczyniła niemożliwe możliwym.