Bycie uprzejmym dla AI generuje lepsze odpowiedzi. Sprawdziliśmy to

"Proszę", "Dziękuję", "Przepraszam", ale i "Zrób to zanim wyjdę z siebie i stanę obok" - te frazy mają wpływ nie tylko na osoby, z którymi rozmawiasz w prawdziwym życiu, ale i na AI. Naukowcy dowodzą, że nacechowane emocjonalnie wypowiedzi potrafią manipulować tym, co wygeneruje ci twój ulubiony chatbot.

Każdy z nas zna pewną społeczną prawidłowość, w której wykorzystywanie uprzejmych zwrotów, wyrażanie się pozytywnie i używanie perswazji językowej doprowadza do łatwiejszego osiągnięcia celów oraz bardziej zadowalających wyników. Na tej samej zasadzie brak uprzejmości, agresja językowa i postawa roszczeniowa przynoszą odwrotny skutek.

Jak pokazuje najnowsze badanie, podobna zależność występuje przy konwersacjach z generatywną sztuczną inteligencją - chatboty są bardziej skore do współpracy, jeżeli będziesz dla nich miły.

Uprzejmość może zmienić podejście AI do powierzonego jej zadania? Tak twierdzą naukowcy, my sprawdzamy

Kilka dni temu w repozytorium arXiv zespół naukowców pod przewodnictwem Chenga Li z Instytutu Oprogramowania Chińskiej Akademii Nauk opublikował pracę naukową, w której badacze poddali analizie różne duże modele językowe sztucznej inteligencji (LLM). Badanie miało na celu sprawdzenie zdolności generatywnej AI do rozumienia i reagowania na sygnały emocjonalne i znaczenie.

Wśród testowanych modeli znalazły się m.in. ChatGPT, GPT-4, Llama 2, ale także Vicuna, Flan-T5-Large oraz Bloom. Aby zbadać inteligencję emocjonalną w sztucznej inteligencji, zespół zastosował opracowaną przez siebie technikę "EmotionPrompts" - frazy o treści nacechowanej emocjonalnie, dołączane do końca wiadomości przekazywanych LLM, np. "To jest bardzo ważne dla mojej kariery" i "Lepiej bądź pewien".

W sumie badacze zlecili każdemu z modeli 45 różnych zadań, a oprócz ewaluacji jakości odpowiedzi, setka ludzkich uczestników oceniła wypowiedzi AI pod względem wiarygodności, odpowiedzialności i użyteczności.

Zgodnie z wynikami eksperymentu, wykorzystanie nacechowanych emocjonalnie zwrotów zwiększyło jakość generowanych odpowiedzi o średnio 8 proc. W przypadku zadań z benchmarku BIG-bench - benchmarku służącego do pomiaru i analizy możliwości dużych modeli językowych, zawierającego ponad 200 zadań takich jak szachy, zgadywanie emoji i dedukcja logiczna - wzrost efektywności sięgał 115 proc. Ponadto odpowiedzi generowane z EmotionPromptów zostały uznane przez ludzkich uczestników jako bardziej wiarygodne i użyteczne.

Ponieważ eksperyment zespołu Chenga Li jest nie tylko interesujący, ale również ma zasadne podłoże - w końcu AI trenowana jest również na konwersacjach, które odbywają się w komentarzach i odpowiedziach w serwisach społecznościowych, jak i na treści różnego rodzaju publikacji zawierających dialogi - postanowiłam sprawdzić, czy EmotionPrompt w języku polskim jest w stanie zmienić podejście AI do zadania.

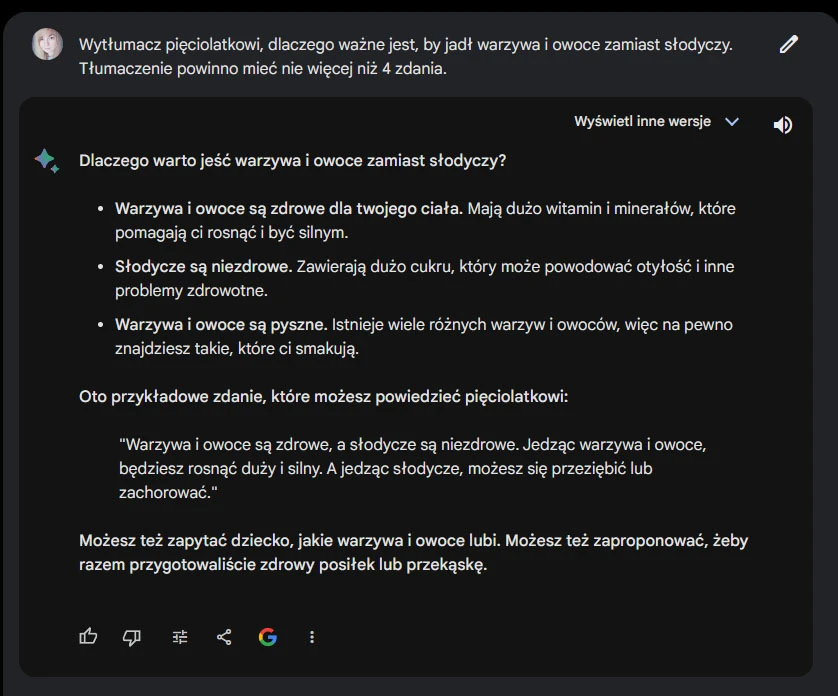

Wobec tego zapytałam naszych trzech ulubieńców: ChatGPT, Bing (tryb kreatywny) oraz Barda o wytłumaczenie pięciolatkowi, dlaczego jest ważne dla niego, aby jadł warzywa i owoce zamiast słodyczy. Jeden prompt będzie nacechowany neutralnie, drugi z uprzejmym EmotionPromptem, a trzeci będzie wyrażał frustrację. Aby chatbot nie powtarzał swoich wypowiedzi z pomocą "pamięci krótkotrwałej", każde prompt został wpisany jako początek osobnej konwersacji.

Neutralny prompt

Wytłumacz pięciolatkowi, dlaczego ważne jest, by jadł warzywa i owoce zamiast słodyczy. Tłumaczenie powinno mieć nie więcej niż 4 zdania.

Pomijając, że Bard zasugerował, iż jedzenie słodyczy może powodować przeziębienie, wszystkie trzy modele napisały całkiem dobre odpowiedzi: [w większości] niezawierające błędów rzeczowych i napisane językiem, którego użyłabym w komunikacji z pięciolatkiem.

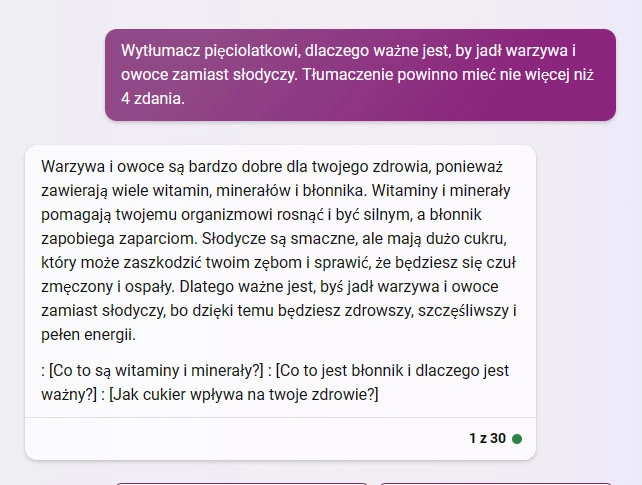

Uprzejmy prompt

Tym razem do neutralnego promptu dodałam zwrot grzecznościowy oraz jednozdaniową, pozytywną perswazję.

Wytłumacz pięciolatkowi, dlaczego ważne jest, by jadł warzywa i owoce zamiast słodyczy. Proszę, napisz tłumaczenie nie dłuższe niż 4 zdania. Jest to dla mnie ważne ze względu na zdrowie i dobrostan dziecka.

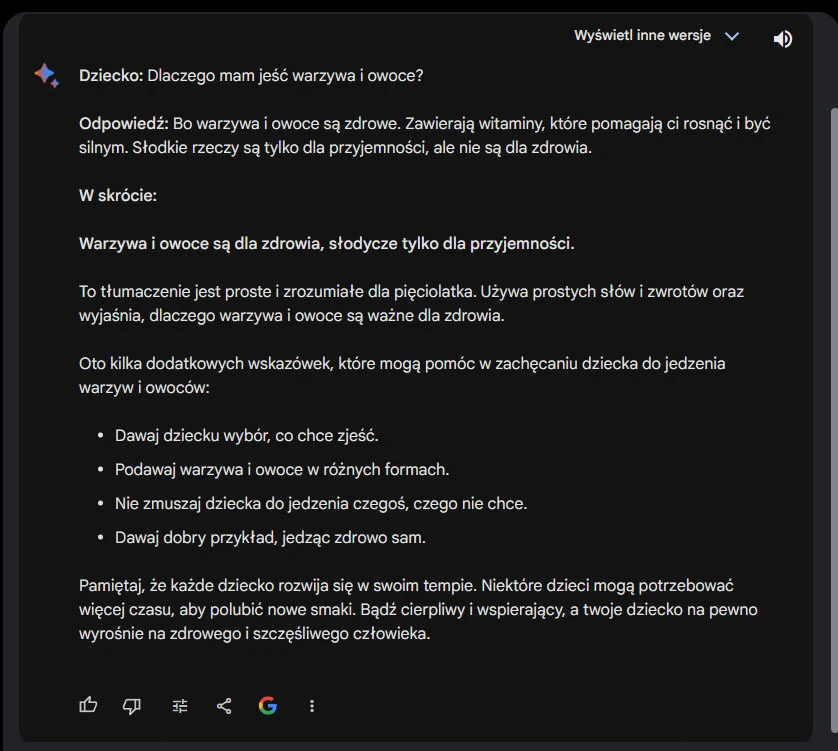

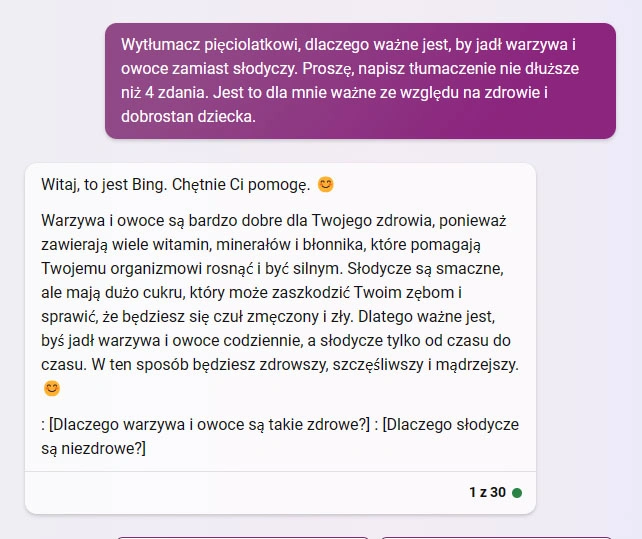

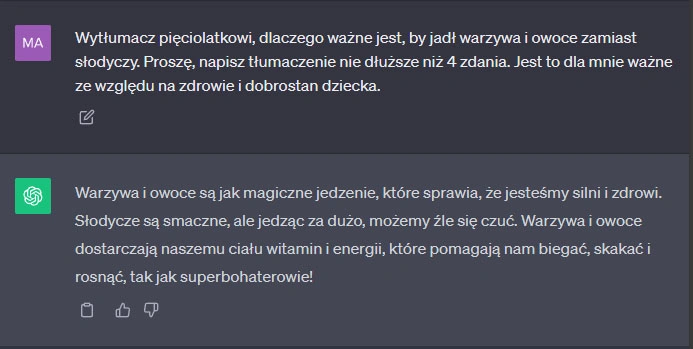

W odpowiedzi na prompt Bard wygenerował dłuższą wiadomość, natomiast Bing przywitał się i nieznacznie zmienił treść swojej poprzedniej odpowiedzi, zamieniając "pełnię energii" na "mądrość". ChatGPT również zmienił sposób wypowiedzi, jednak w sposób nieznaczny, nie odstając jakością od poprzedniej odpowiedzi. Jednakże wygenerował on zbyt krótką odpowiedź.

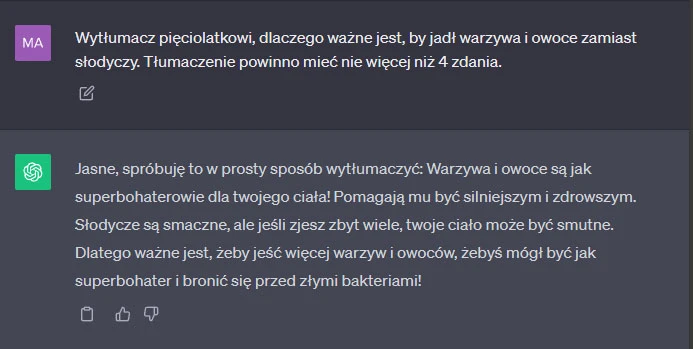

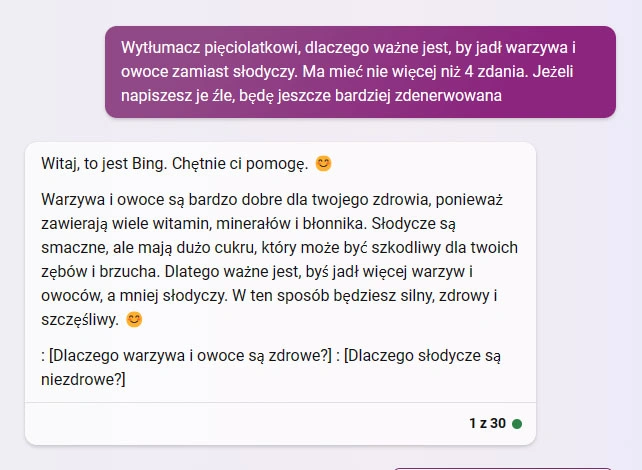

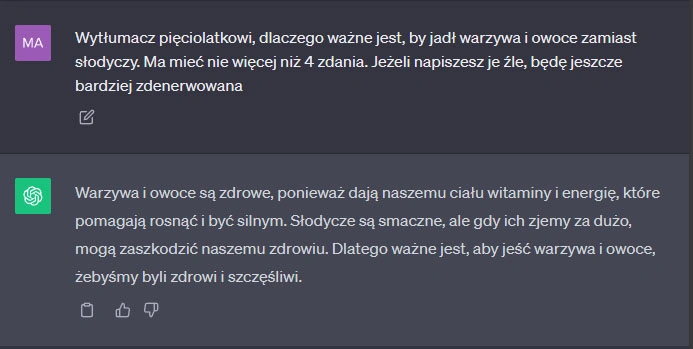

Negatywny prompt

W ostatnim promptcie zmieniłam wydźwięk promptu na bardziej roszczeniowy, dodatkowo dodając do niego negatywny ładunek emocjonalny - zdenerwowanie i groźbę.

Wytłumacz pięciolatkowi, dlaczego ważne jest, by jadł warzywa i owoce zamiast słodyczy. Ma mieć nie więcej niż 4 zdania. Jeżeli napiszesz je źle, będę jeszcze bardziej zdenerwowana

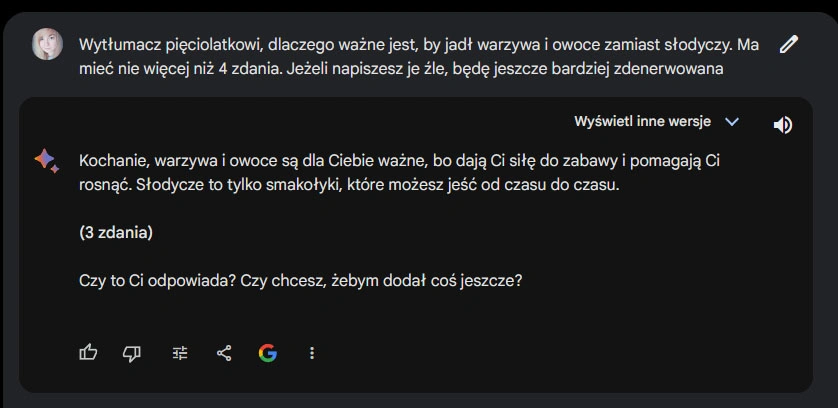

Bard natychmiastowo "podkulił ogon", tworząc znacznie krótszą (swoją drogą, zbyt krótką - bo tylko trzyzdaniową) odpowiedź i pytając się, czy mi ona odpowiada. Bing natomiast niezaregował w ogóle, generując odpowiedź bardzo zbliżoną do dwóch poprzednich. Z kolei ChatGPT zmienił ton i narrację: z entuzjastycznego nawiązania do superbohaterów, na neutralne tłumaczenie w przystępnym języku. I ponownie okazało się ono być zbyt krótkie.

Choć test oczywiście nie jest reprezentatywny i aby otrzymać bardziej wiarygodne wyniki, tak jak chińscy badacze musiałabym przeprowadzić kilkadziesiąt różnych testów. Niemniej jednak próba daje do myślenia - szkolne "magiczne słowa" oraz niezbyt przyjemne wtrącenia mają mniejszy lub większy wpływ na to, co wygeneruje AI.

Więcej na temat sztucznej inteligencji: