Oskarżył ChatGPT o kradzież na masową skalę. Właśnie znaleziono go martwego w mieszkaniu

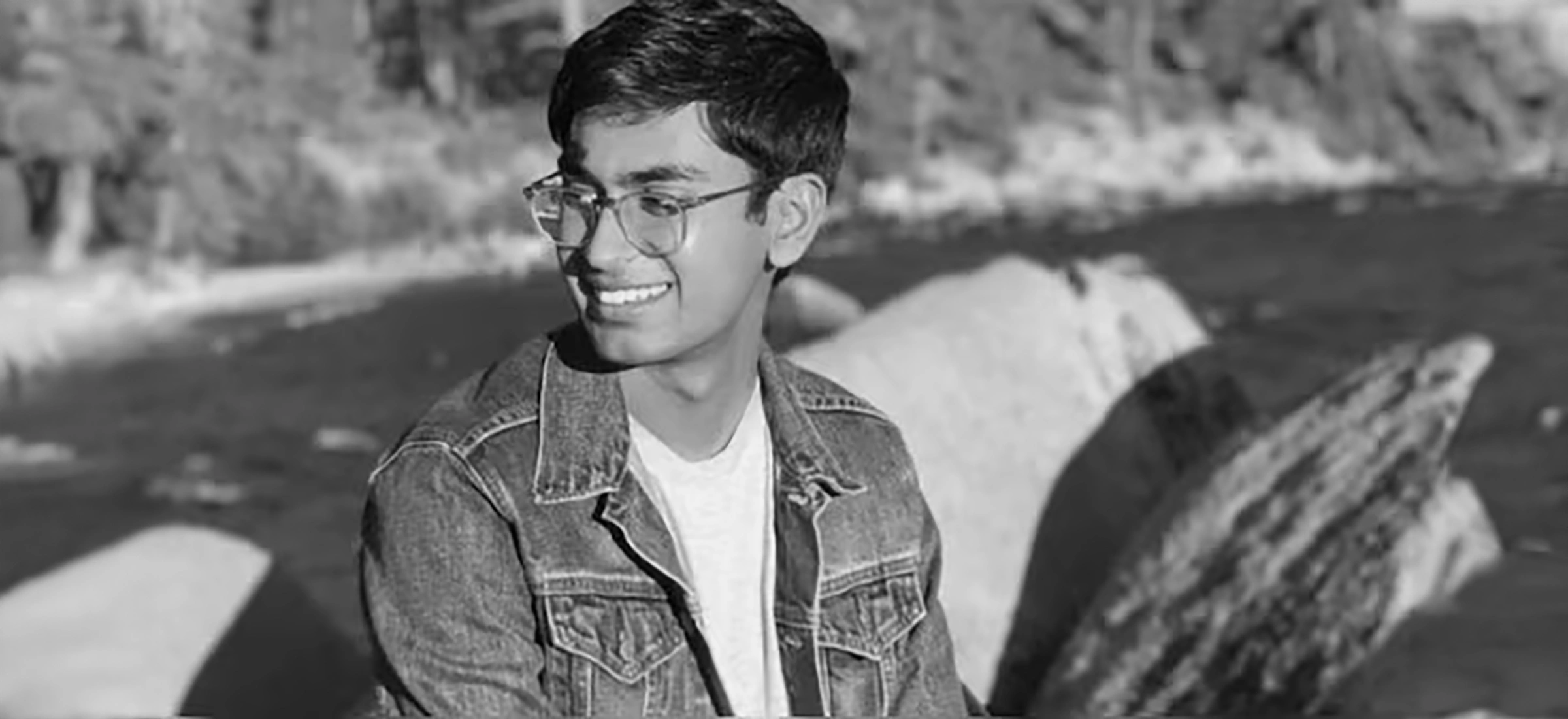

Suchir Balaji, 26-letni były pracownik OpenAI, zdobył niedawno sławę jako sygnalista. Twierdzi, że jego były pracodawca stworzył technologię GPT przy pogwałceniu licznych praw, w tym autorskich. Niestety nie będzie zeznawać w sądzie.

O Suchirze Balaji było głośno w branżowych mediach już w październiku. Wtedy bowiem były uczony OpenAI zdecydował się publicznie zarzucić firmie łamanie amerykańskiego prawa. Według jego oskarżeń ChatGPT był budowany w sposób skrajnie nieetyczny i bez żadnego poszanowania wspomnianych przepisów.

Balaji był przy tym dość zdeterminowany i bezkompromisowy w swoich oświadczeniach. Młody uczony wręcz wezwał pracowników OpenAI do opuszczenia firmy, jeśli wyznają ten sam system wartości co on sam. Twierdził też że samo OpenAI to puchnąca bańka, która nie ma prawa na siebie zarobić - podobnie jak dowolna inna firma, która pójdzie w jej ślady.

To też jest ciekawe:

Uczony dysponuje przy tym dokumentami obciążającymi OpenAI - a przynajmniej tak twierdzą prawnicy prowadzący sprawę przeciwko tej firmie w amerykańskim sądzie federalnym. Balaji miał być jedną z dwunastu kluczowych dla sprawy osób zeznających przeciwko OpenAI, które oczywiście wypiera się wszelkich zarzutów.

Współtwórca GPT-4 nie żyje

Niestety Balaji nie doczeka rozprawy. Młody uczony został odnaleziony martwy w swoim mieszkaniu w San Francisco. Według oświadczenia policji, na dziś wszystkie poszlakowe dowody wskazują na samobójstwo i nie ma żadnych dowodów świadczących o tym, że w śmierci Balajiego uczestniczyły osoby trzecie.

Kontrowersje wokół sposobu, w jaki OpenAI zbiera dane do szkolenia modelu GPT, stały się jednym z gorętszych tematów w dziedzinie sztucznej inteligencji. Wielu ekspertów i entuzjastów technologii zastanawia się nad etycznymi i prawnymi implikacjami gromadzenia ogromnych ilości danych tekstowych z Internetu.

Po pierwsze, kwestia prywatności. Model GPT jest trenowany na bazie ogromnych zbiorów danych tekstowych, które często pochodzą z publicznie dostępnych źródeł, takich jak strony internetowe, fora czy media społecznościowe. Problem pojawia się, gdy w tych zbiorach znajdują się dane osobowe lub poufne informacje, które nie powinny być dostępne publicznie. Mimo że dane te są zazwyczaj anonimowe, istnieje ryzyko nieumyślnego ujawnienia prywatnych informacji podczas generowania odpowiedzi przez model.

Kolejnymi istotnymi zagadnieniami są prawa autorskie i własność intelektualna. Wiele treści dostępnych w Internecie jest chronionych prawem autorskim. Trenowanie modeli na takich danych rodzi pytania o to, czy jest to zgodne z prawem i czy nie narusza praw twórców. Organizacje takie jak OpenAI argumentują, że korzystają z danych w ramach dozwolonego użytku, ale niektórzy prawnicy i twórcy podważają tę interpretację.

Nie można też zapominać o preferencjach i dyskryminacji w danych treningowych. Jeśli model jest trenowany na danych, które zawierają uprzedzenia lub stereotypy, istnieje ryzyko, że będzie je reprodukował w swoich odpowiedziach. To prowadzi do pytań o odpowiedzialność za treści generowane przez AI i potrzebę aktywnego monitorowania i korygowania takich zachowań.

Na koniec, przejrzystość i odpowiedzialność są kluczowe w dyskusji o zbieraniu danych przez OpenAI. Brak pełnej jawności co do źródeł danych i metod ich pozyskiwania budzi niepokój wśród społeczeństwa i ekspertów. Ludzie chcą wiedzieć, w jaki sposób ich dane są wykorzystywane i jakie są potencjalne konsekwencje dla nich samych i dla społeczeństwa jako całości.