Jaka przyszłość czeka Wikipedię w dobie zalewu AI? Spytałem o to szefową technologii Wikipedii

Na swój sposób wręcz szkoda, że Wikipedia nie jest jakąś komercyjną spółką technologiczną. W czasach, kiedy Duże Modele Językowe ułatwiają masowe powielanie fałszywych informacji, ta w coraz większym stopniu stanowi dla internautów bezpieczną przystań. Jest jednak jeden problem. A właściwie to kilka.

Wikimania to wydarzenie, które przyciąga entuzjastów wolnej wiedzy z całego świata. To coroczna konferencja poświęcona projektom Wikimedia, takim jak Wikipedia, Wikisłownik czy Wikimedia Commons. W tym roku spotkanie odbyło się w sercu Górnego Śląska w Katowicach, co jest wyrazem uznania dla rosnącej społeczności Wikimedia w Polsce.

Konferencja zgromadziła szerokie grono uczestników, w tym wolontariuszy, edytorów, programistów i partnerów projektów Wikimedia. Była to okazja do wymiany doświadczeń, dyskusji o przyszłości wolnej wiedzy oraz o wyzwaniach, jakie niesie ze sobą cyfrowa transformacja. Warsztaty, prelekcje i panele dyskusyjne pozwoliły uczestnikom na pogłębienie swojej wiedzy i umiejętności.

Czytaj też:

Jednym z najważniejszych tematów tegorocznej Wikimanii była rola i znaczenie edukacji w kontekście wolnej wiedzy. Podkreślano, jak ważne jest, aby informacje były dostępne dla każdego, bez ograniczeń, co jest fundamentem misji Wikimedia. Uczestnicy zastanawiali się również nad sposobami, w jakie technologie, takie jak sztuczna inteligencja mogą wspierać rozwój i dystrybucję wolnej wiedzy na świecie.

Jedną z uczestniczek katowickiej Wikimanii była dyrektor techniczna Wikimedii. Niemożliwym było przegapienie okazji na rozmowę

Selena Deckelmann to postać, która odgrywa znaczącą rolę w świecie technologii i wolnej wiedzy. Jako Chief Product and Technology Officer w Fundacji Wikimedia, Selena przyczynia się do rozwoju i innowacji w projektach Wikimedia, w tym w jednym z najczęściej odwiedzanych serwisów na świecie - Wikipedii. Jej doświadczenie i zaangażowanie w otwarte technologie są kluczowe dla misji fundacji, która dąży do zapewnienia wolnego i otwartego dostępu do wiedzy na całym świecie.

Przed dołączeniem do Fundacji Wikimedia Selena Deckelmann miała imponującą karierę w Mozilli, gdzie jako Senior Vice President była odpowiedzialna za przeglądarkę Firefox. Przez niemal dekadę w Mozilli pełniła różne funkcje, w tym Vice President for Firefox Desktop oraz Senior Director for Web Platform Engineering and Gecko Runtime. Jej wkład w rozwój oprogramowania otwartoźródłowego, w tym znaczący wkład w bazę danych PostgreSQL, podkreśla jej pasję do tworzenia technologii wspierających społeczności i promujących inkluzję.

- To mój pierwszy raz w Polsce, ale też to drugi raz, kiedy Wikimania odbywa się w Polsce. Jest przepięknie. Pochodzę z Oregonu, więc czuję się u was szczególnie jak w domu. Na imprezie zjawiło się ponad 1000 osób, kolejne 1500 uczestniczy online. Jest wspaniale - jak z uśmiechem mówi Deckelmann w rozmowie ze Spider’s Web. Dyrektorka przy tym szybko się zorientowała po kierunku naszej rozmowy, że czytelnicy naszego serwisu nie boją się nerdowych tematów. Na szczęście dla nas Wikimedia nie jest firmą, która musi się bać o strategie marketingowe czy NDA - Decklemann nie bała się udzielać bardzo konkretnych odpowiedzi na pytania.

Wikipedia to projekt na miarę korporacji Big Tech - a utrzymywany jest przez społeczność i filozofię open source. To nie oznacza, że nie poszukuje specjalistów

Treść Wikipedii jest dostępna na licencji Creative Commons Attribution-ShareAlike 3.0 Unported License (CC BY-SA), co oznacza, że każdy może nie tylko korzystać z zawartości Wikipedii, ale również ją modyfikować i rozpowszechniać pod warunkiem zachowania tej samej licencji i wskazania autorów oryginalnej treści. To fundamentalna zasada otwartości, która umożliwia społeczności na całym świecie współtworzenie projektu. Jak jednal zauważa Decklemann na tym nie koniec.

Oprogramowanie, na którym działa Wikipedia, znane jako MediaWiki, jest wolnym oprogramowaniem dostępnym na licencji GNU General Public License. Oznacza to, że każdy może pobrać kod źródłowy, modyfikować go, a także używać do własnych celów bez żadnych opłat licencyjnych. MediaWiki jest stale rozwijane przez społeczność wolontariuszy oraz pracowników Fundacji Wikimedia, co zapewnia ciągłą aktualizację i ulepszanie platformy.

Szczególnie ważne jest odzwierciedlenie otwartości Wikipedii w jej modelu zarządzania. Decyzje dotyczące rozwoju projektu są podejmowane przez społeczność w procesie, który jest transparentny i otwarty dla wszystkich zainteresowanych. To podejście demokratyczne i partycypacyjne jest kluczowe dla utrzymania projektu jako otwartoźródłowego i zapewnia, że Wikipedia pozostaje dostępna, aktualna i przydatna dla użytkowników na całym świecie.

- Infrastruktura Wikipedii i wszystkie projekty Wikimedii pracują pod kontrolą otwartoźródłowego oprogramowania. Staramy się zwiększyć liczbę osób współpracujących z nami nad jego rozwojem i idzie nam to dobrze - przez ostatnie 12 miesięcy liczebność zespołu zwiększyła się o 25 proc. - jak z dumą zauważa nasza rozmówczyni.

Największe wyzwanie dla Wikipedii? Bez niespodzianek - obsługa gigantycznego ruchu i utrzymanie serwerów. Ale jakie jest drugie?

Wikipedia jako niekomercyjny projekt musi się nieustannie mierzyć z brzemieniem swojej popularności. Codziennie odwiedzana jest przez niezliczoną liczbę internautów, botów wyszukiwarek, nawet skrypty sztucznej inteligencji. Rozsądne zarządzanie zasobami informatycznymi jest tu kluczowe. Dlatego też pytając o to, z czym aktualnie Deckelmann się mierzy poprosiłem o opisanie drugiego największego aktualnie problemu. O pierwszym wszak słyszymy co roku, kiedy Wikimedia zbiera datki od ochotników na dalsze swoje utrzymanie.

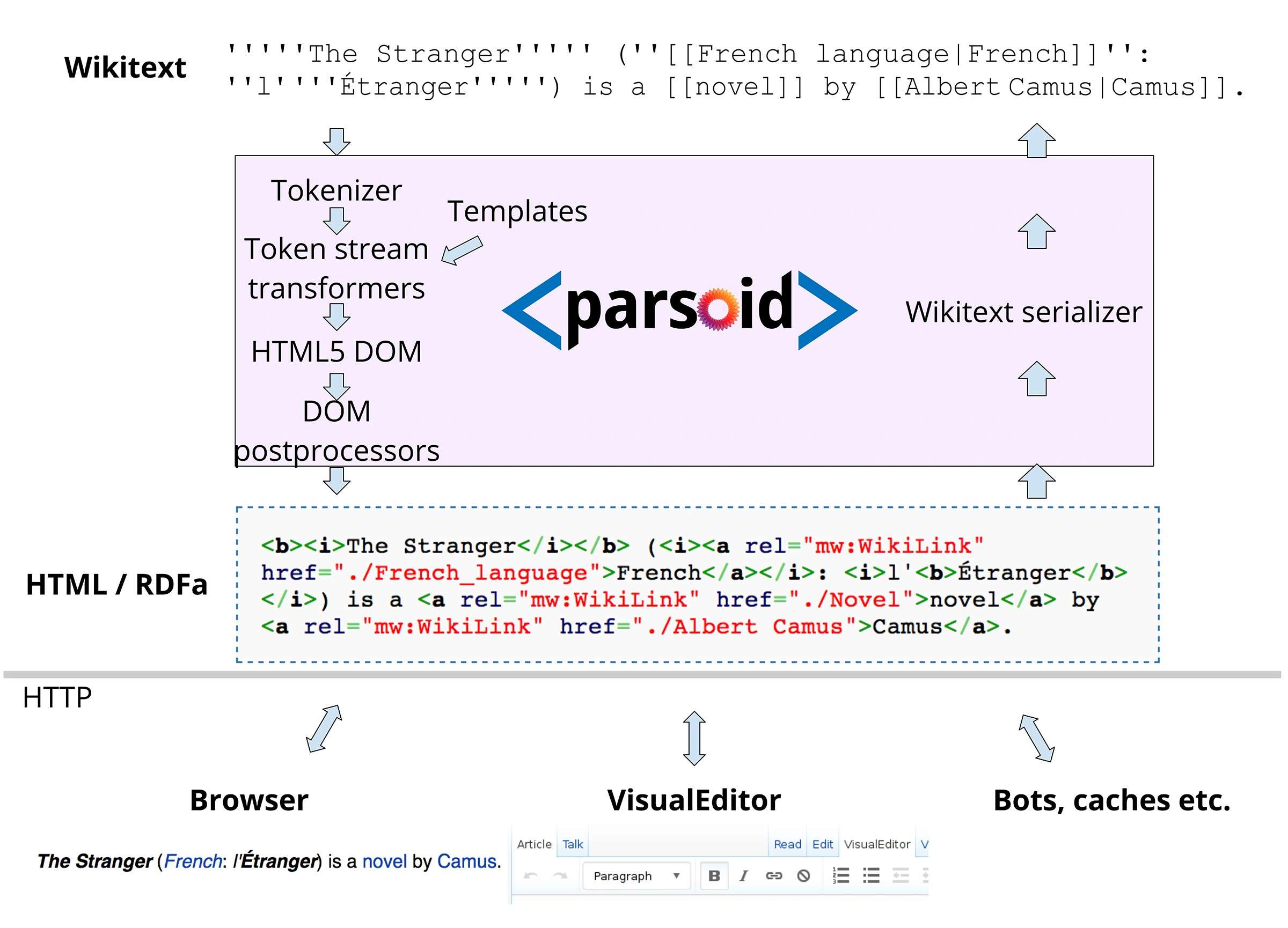

- Mamy takie narzędzie, które się nazywa Parsoid. I właśnie trwa migracja na jego nową wersję. To jedna z największych zmian infrastrukturalnych, jakich się podjęliśmy. To jakby dokonywać operacji wymiany mózgu na żywym organizmie. Ten nowy mózg obsłuży absolutnie wszystkie teksty, które ludzie napisali na Wikipedii przez ponad 20 lat, by móc następnie je przetwarzać i serwować odbiorcom w ramach aplikacji Wikipedia. A zwracam uwagę, że nie używamy HTML-a do formatowania i wzbogacania tekstu, a wikitext, na który składa się ponad 300 skryptów - jak nam zdradza CTO Wikimedii.

Parsoid to kluczowy komponent infrastruktury projektów Wikimedia, w tym Wikipedii. To dwukierunkowy parser, który umożliwia konwersję między wikitextem a HTML5. Został pierwotnie napisany w JavaScript i uruchomiony na Node.js, ale w 2019 r. został przeniesiony na PHP. Wersja PHP zastąpiła wersję JS na klastrze Wikimedia w grudniu 2019 r. Parsoid jest obecnie integrowany z rdzeniem MediaWiki z celem ostatecznego zastąpienia natywnego parsera MediaWiki.

Parsoid ma na celu zapewnienie bezbłędnej konwersji w obie strony, czyli uniknięcie utraty informacji oraz zapobieganie brudnym diffom - różnicom, które są trudne do śledzenia i rozumienia. Na wiki Wikimedia Parsoid jest obecnie pośredniczony za pomocą RESTBase, który przechowuje HTML przetłumaczony przez Parsoid. Na początku 2024 r. Parsoid zaczął być używany na niektórych produkcyjnych wiki jako domyślny parser dla widoków do czytania. Opłaciło się?

- Oj tak. Bo dzięki temu możemy sprawniej i szybciej renderować witrynę. Z tym mierzy się każdy twórca aplikacji internetowych, wy pewnie też. Im więcej dodawanych jest funkcji do aplikacji, tym aplikacja działa wolniej, obciążając serwery, generując koszty i irytując odbiorców. My musimy zadbać przy tym o to, by nowy Parsoid renderował wszystko poprawnie w ponad 300 językach, które obsługujemy. Na szczęście wiemy o nich bardzo wiele - mówi Deckelmann.

A co z generatywną sztuczną inteligencją? Dla Wikipedii to szansa czy zagrożenie?

- Wiesz, jesteśmy Wikipedią. Niemal wszystkie Duże Modele Językowe były szkolone przede wszystkim na naszych zasobach. Stanowimy istotny składnik wszystkich LLM-ów - jak zauważa moja rozmówczyni. - Sztuczna inteligencja jest z Wikipedią od lat. Nasi autorzy używają uczenia maszynowego do wychwytywania błędów w tekstach. Mamy wręcz do AI platformę o nazwie Lift Wing, na której hostujemy modele językowe - dodaje.

Lift Wing to innowacyjne narzędzie Wikimedii, które stanowi kluczowy element infrastruktury służącej do obsługi modeli uczenia maszynowego. To skalowalna infrastrukturana Kubernetes wykorzystująca KServe. Lift Wing jest częścią szerszego projektu mającego na celu modernizację uczenia maszynowego w Wikimedii. Narzędzie to zastąpiło infrastrukturę ORES, oferując bardziej zaawansowane i elastyczne rozwiązania do obsługi modeli.

Lift Wing hostuje modele uczenia maszynowego jako usługi, które są asynchronicznymi mikrousługami zdolnymi do transformacji surowych danych i dokonywania predykcji. Każda usługa ma obrazy produkcyjne, które są publikowane w rejestrze Docker WMF za pośrednictwem Deployment Pipeline. Te obrazy są wykorzystywane do konfiguracji isvc w wikimediowym helmfile ml-services w repozytorium operations/deployment-charts. To podejście umożliwia szybką i efektywną implementację modeli, co jest niezwykle ważne w dynamicznie rozwijającym się świecie technologii.

Lift Wing jest dostępny jako wolne oprogramowanie na licencji GNU General Public License, co oznacza, że każdy może pobrać jego kod źródłowy, zmodyfikować go i używać do własnych celów bez opłat licencyjnych. Dla niektórych specjalistów może okazać się to bardzo pomocne, bo tak jak Wikimedia chce zapewnić jak najwięcej narzędzi swoim twórcom, tak ma finansowo ograniczone zasoby. - Nie mamy zbyt wielu procesorów. Bardzo dbamy o to, by cokolwiek co wdrażamy od razu było opłacalne finansowo. Nie skupujemy więc masowo układów graficznych, co wymusza oczywiście ostrożne planowanie testowania i wdrażania poszczególnych modeli SI – przyznaje CTO.

Deckelmann nie boi się jednak o jakość samej Wikipedii w kontekście spamu związanego z nieprawdziwymi, fake’owyymi treściami masowo produkowanymi przez rozmaite podmioty. Czasami nieświadomie na skutek halucynacji, czyli inherentnego problemu Dużych Modeli. - Dyskusje na ten temat są gorące. Obawiamy się spamu i spadku jakości treści na Wikipedii z uwagi na generatywną SI i mamy poświęcony temu projekt. Naszą siłą jest jednak nasza społeczność, która wzajemnie się weryfikuje. Uważam wręcz, że w czasie, w którym bardzo trudno odróżnić prawdę od fikcji z uwagi na eksplozję popularności GenAI, Wikipedia wręcz lśni jako miejsce, któremu można ufać. I w którym źródło każdej informacji można sprawdzić - twierdz nasza rozmówczyni.

Czy to oznacza, że nie ma się czego obawiać? Wręcz przeciwnie. - Oczywiście że to poważne zagrożenie. Na szczęście i tu nasza społeczność okazała się kreatywna, tworząc systemy rankingowe źródeł informacji i samych współtwórców. Dysponujemy w efekcie dużą bazą wiarygodnych i mniej wiarygodnych źródeł. Na przykład tworzona jest masa witryn z nieprawdziwymi nekrologami. Mieliśmy mnóstwo dyskusji w naszej amerykańskiej części społeczności na temat wiarygodności informacji podawanych przez Fox News - niektóre ich reportaże są źródłem ważnych informacji, niektóre… nie - jak ostrożnie próbuje się wypowiadać moja rozmówczyni, zdecydowanie i zrozumiale nie chcąc w rozmowie ze mną opowiadać się po żadnej poglądowej czy politycznej stronie.

- Nauczyliśmy się z doświadczenia jak wiele zmienia dyskusja. Część naszych technicznych narzędzi jest wręcz zaprojektowana z myślą o jak najwygodniejszej wymianie opinii i poglądów na temat treści danego tekstu na Wikipedii, czy nawet zastosowanego w nim wydźwięku. Nie da się uniknąć osób o skrajnych poglądach, nawet wśród specjalistów w danych dziedzinach, ale nasze i cudze badania potwierdzają, że wymiana poglądów i merytoryczna dyskusja doprowadzają do łagodzenia ekstremalnego spojrzenia na niektóre kwestie.

Uważam, że odnieśliśmy szczególny sukces, bo gdy widzę inne fora dyskusyjne, często widzę też na nich skrajną polaryzację i wzajemną antagonizację. Postawienie na wewnętrzną dyskusję sprawiło, że nasi autorzy chcą od siebie się nawzajem uczyć i wymieniać wiedzą – jak argumentuje. Duże Modele Językowe tworzą przekonujące długie i krótkie wypowiedzi na dowolny temat. Nie są w stanie jednak symulować kultury Wikispołeczności i tym samym jej przeniknąć.

Przyszłość Wikipedii mieni się w czarnych barwach. Ale to akurat dobrze

Zapytałem panią Deckelmann o przyszłość Wiki - ale nie z punktu widzenia jej współtwórców, infrastruktury czy polityki, ale z punktu widzenia użytkowników. Tych biernych, którzy z Wikipedii korzystają tylko by zdobyć wiedzę. - Nie jesteśmy z tych, co superszybko wdrażają nowe niesprawdzone technologie, ale z tym to akurat jesteśmy mocno opóźnieni. Wdrażamy w końcu ciemny motyw interfejsu. Jeszcze nie we wszystkich wersjach językowych, ale wkrótce i te będą dostępne w ramach dark mode. Druga rzecz jest dla nerdów, ale chyba jestem wśród swoich - zmieniamy krój czcionki umożliwiając powiększanie tekstu w linii bez konieczności logowania się - mówi CTO Wikimedii.

Czytelność, lekkość i łatwość użycia niezmiennie pozostać mają absolutnym priorytetem w kwestii aplikacji Wikipedia, podobnie jak kolejne funkcje ułatwień dostępu dla osób o rozmaitych formach niepełnosprawności. Paradoksalnie dla Wikipedii od strony technicznej jest to nieco łatwiejsze zadanie niż dla innych, bo witryna nie musi przejmować optymalizacją setek reklamowych skryptów, które zmuszone są stosować komercyjne witryny. Niezmiennie musi jednak pamiętać, że nie stoją za nią wirtualne pieniądze jej akcjonariuszy, a budżet obliczony na bazie dobrowolnych wpłat.

Jej przyszłość wydaje się jednak bardzo jasna - i to mimo wspomnianych opóźnień w drobiazgach pokroju ciemnego motywu wyglądu aplikacji.