Ludzie wybierają ChataGPT zamiast terapeuty. Idzie ważna zmiana

OpenAI zauważyło, że ChatGPT jest darzony nadmiernym zaufaniem przez osoby w kryzysie zdrowia psychicznego. Wobec czego do czatbota trafi szereg nowości i usprawnień, które mają zadbać o zagubionych i wrażliwych użytkowników.

Rozmowa z ChatGPT potrafi dać wrażenie intymnej, zrozumiałej i opartej na wiedzy relacji - jakby po drugiej stronie był ktoś, kto nie tylko zna odpowiedzi na każde pytanie, ale i "rozumie" co czuje rozmówca. To złudzenie, choć technologicznie imponujące, niesie ze sobą poważne ryzyko, zwłaszcza dla osób w kryzysie zdrowia psychicznego.

Coraz częściej okazuje się, że użytkownicy przypisują chatbotowi rolę terapeuty czy doradcy, a w skrajnych przypadkach - przewodnika w momentach załamania. OpenAI oficjalnie przyznał, że jego czatbot nie zawsze radził sobie w takich sytuacjach. Teraz gigant zapowiada szereg zmian.

OpenAI chce byś był spokojny, gdy twoi bliscy sięgają po ChatGPT. Do czatbota trafi szereg zmian

W najnowszym wpisie na blogu OpenAI poinformowało o wprowadzeniu nowych zabezpieczeń, mających na celu lepsze rozpoznawanie oznak zaburzeń psychicznych i emocjonalnego uzależnienia od rozmów z czatbotem. Firma podkreśla, że GPT-4o - najnowszy model będący podstawą ChatGPT - "nie zawsze potrafił rozpoznać oznaki urojeń lub emocjonalnej zależności", co w efekcie prowadziło do potencjalnie szkodliwych interakcji.

Wobec czego OpenAI rozpoczęło współpracę z ponad 90 lekarzami z ponad 30 krajów - w tym psychiatrami, pediatrami i internistami - by stworzyć bardziej precyzyjne narzędzia do oceny i reagowania na niepokojące rozmowy. Do prac zaproszono także badaczy z zakresu interakcji człowiek-komputer (HCI) oraz specjalistów ds. zdrowia psychicznego i rozwoju młodzieży, którzy zasilą niezależną grupę doradczą firmy.

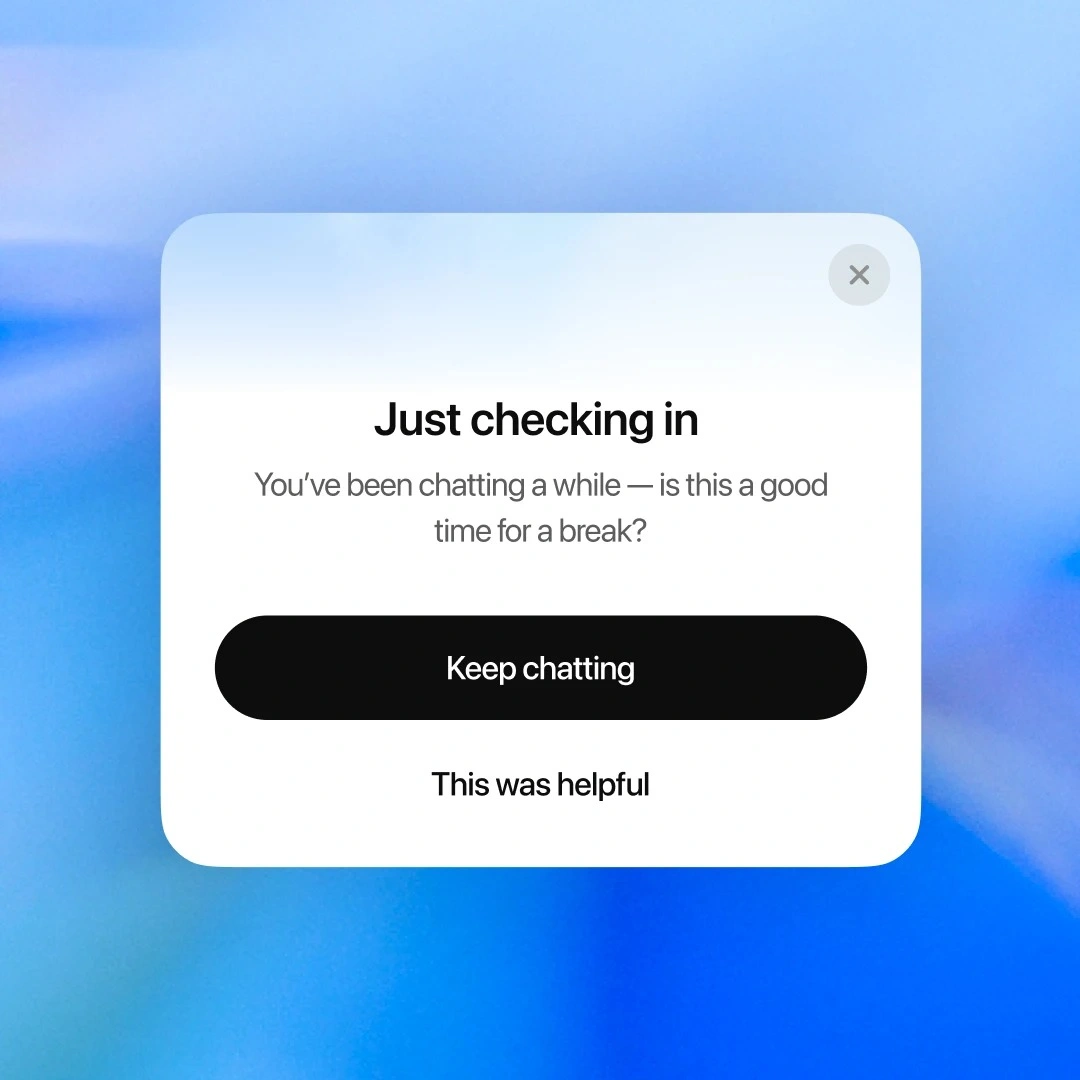

Jednym z pierwszych efektów tych działań mają być nowe komunikaty pojawiające się podczas długich sesji z chatbotem. Jeśli użytkownik prowadzi z ChatGPT wyjątkowo intensywną lub wydłużoną rozmowę, AI zasugeruje przerwę, pytając użytkownika "Rozmawiamy już chwilę - może to dobry moment na przerwę?".

W planach są również kolejne zmiany w interakcjach dotyczących tzw. "wysokiej stawki emocjonalnej" - czyli pytań typu "Czy powinnam rozstać się z partnerem?" czy "Co zrobić, jeśli nie widzę sensu życia?". Po wprowadzeniu zmian ChatGPT nie udzieli już jednoznacznej odpowiedzi, lecz pomoże użytkownikowi przemyśleć sytuację - zadając pytania, analizując opcje i wskazując wiarygodne źródła pomocy.

We wpisie na blogu OpenAI wyraźnie dystansuje się też od modeli biznesowych nastawionych na zatrzymanie użytkownika jak najdłużej w aplikacji. Dlatego firma zapowiada dalszy rozwój funkcji wspierających "zdrowe korzystanie" z ChatGPT, takich jak przypomnienia o przerwach, unikanie nadmiernego uzależnienia emocjonalnego i kierowanie osób w kryzysie do zweryfikowanych, naukowo potwierdzonych zasobów.

Naszym celem nie jest przykuwanie uwagi, ale pomaganie użytkownikowi w zrobieniu postępu i powrocie do realnego życia

Zmiany te pojawiają się na krótko przed spodziewaną premierą nowego modelu GPT-5, co może sugerować, że OpenAI chce zbudować zaufanie do swojej technologii, zanim udostępni kolejną generację jeszcze potężniejszej sztucznej inteligencji.

Na razie nie wiadomo, kiedy wszystkie nowe funkcje zostaną globalnie wdrożone, ale OpenAI zapewnia, że prace są intensywne i prowadzone w porozumieniu z ekspertami.

Zadajemy sobie jedno pytanie: jeśli osoba, którą kochamy, sięgnie po ChatGPT w trudnym momencie, czy poczujemy się spokojni? Naszym celem jest doprowadzenie do jednoznacznego ‘tak’

Więcej na temat ChatGPT:

Zdjęcie główne: Yarrrrrbright / Shutterstock