Moje 9 ulubionych trików AI, działających lokalnie i bez Internetu dzięki rdzeniom Tensor

Dzięki kartom NVIDIA GeForce RTX z rdzeniami Tensor posiadacze komputerów mogą korzystać z rozwiązań sztucznej inteligencji lokalnie, bez dostępu do Internetu i bez wsparcia chmury. Sam regularnie używam przynajmniej dziewięciu takich narzędzi, wspomagających mnie w codziennej pracy oraz zabawie.

Brak połączenia. Nawiąż łączność z Internetem i spróbuj ponownie - wiele popularnych narzędzi AI wyświetli podobny komunikat, kiedy nieoczekiwanie stracimy dostęp do sieci. Rozwiązania takie jak ChatGPT, Copilot, Gemini czy Descript wymagają Internetu do działania, są bowiem oparte o złożone obliczenia realizowane w chmurze. Korzystając z tych usług nasze urządzenie jest tylko elementem początkowym, podczas gdy cała praca odbywa się zupełnie gdzie indziej, w wielkich serwerowniach oraz centrach danych. Dlaczego tam?

Typowe urządzenia w naszym domu - laptopy, smartfony czy tablety - nie poradziłyby sobie z ogromną liczbą jednocześnie realizowanych obliczeń, charakteryzujących modele AI. Stąd ucieczka w chmurę. Część narzędzi AI potrafi jednak działać całkowicie offline, bez dostępu do Internetu. Jak to w ogóle możliwe? To zasługa wieloletniego rozwoju układów i podzespołów, dzięki którym na rynku pojawiły się jednostki GPU oraz CPU (karty graficzne i procesory) wyposażone w rdzenie dedykowane operacjom związanym ze sztuczną inteligencją, modelami AI oraz uczeniem maszynowym.

Najbardziej wydajnym rozwiązaniem tego typu dostępnym na rynku są aktualnie karty GeForce RTX 40 firmy NVIDIA, z rdzeniami Tensor odpowiedzialnymi za operacje AI, wielkie modele oraz uczenie maszynowe. To właśnie w oparciu o te same rdzenie, odpowiednio dopasowane do specyfiki infrastruktury serwerowej, działają takie narzędzia jak Copilot czy ChatGPT. Moc kart GeForce RTX 40 jest jednak na tyle wielka, że użytkownicy komputerów i laptopów z tymi GPU mogą korzystać z lokalnych modeli sztucznej inteligencji, bez dostępu do Internetu.

Lokalne modele sztucznej inteligencji mają wiele przewag nad modelami globalnymi

Po pierwsze, działają offline i nie wymagają dostępu do Internetu. Co za tym idzie, można na nich polegać w zróżnicowanych warunkach. Także tam, gdzie nie dociera do nas globalna sieć. Po drugie, w pełni lokalne modele stanowią gwarancję naszej prywatności i naszego bezpieczeństwa, ponieważ całość danych pozostaje na domowym urządzeniu. Po trzecie, lokalne modele zazwyczaj są darmowe, w przeciwieństwie do wielu popularnych sieciowych usług AI, zwłaszcza tych odpowiedzialnych za generowanie obrazu, dźwięku oraz wideo.

Teraz ciekawostka: jeśli jesteś graczem, raczej na pewno korzystałeś z lokalnego modelu AI, wspartego uczeniem maszynowym. Takim rozwiązaniem jest na przykład technika DLSS, drastycznie zwiększająca wydajność w grach wideo. Popularność lokalnych modeli stale rośnie, tak samo jak katalog narzędzi AI możliwych do wykorzystania przez typowego użytkownika. Nie tylko w obszarze gier wideo, ale także (a może przede wszystkim) pracy oraz twórczości.

Z tego powodu chciałbym wam pokazać moje dziewięć ulubionych sztuczek opartych o lokalnie działające AI oraz uczenie maszynowe, z których korzystam regularnie i które wykorzystują rdzenie Tensor w posiadanej przeze mnie karcie graficznej: Zotac Gaming GeForce RTX 4090.

1. Drastycznie zwiększam wymiary i wyrazistość obrazka, bez pogarszania jego jakości

Zdarza się, że chcemy powiększyć wymiary obrazka albo go wyostrzyć, ale dzieje się to z odczuwalną utratą jakości. Programy graficzne takie jak Photoshop minimalizują ten regres, lecz nawet one nie są tak skuteczne w powiększaniu plików graficznych jak mój ulubiony Final 2x. Jeśli o nim nie słyszeliście, koniecznie musi się to zmienić. To potężne i darmowe narzędzie, które wykorzystuje akcelerację GPU kart GeForce RTX 40 do powiększania, wyostrzania, a nawet odtwarzania od zera plików graficznych.

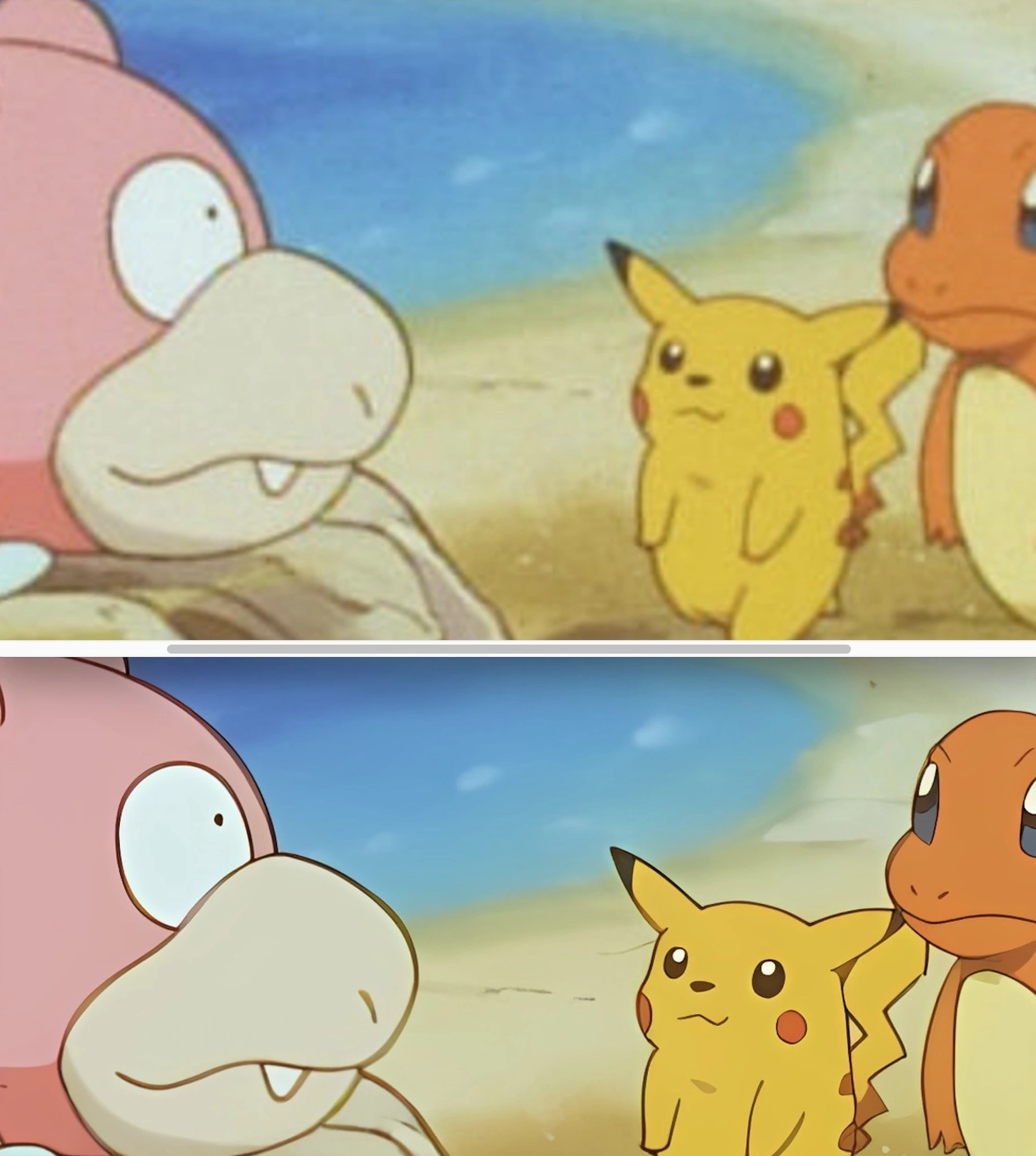

Final 2x może korzystać z wielu różnych lokalnych modeli AI do ulepszania grafiki, wybieranych przez użytkownika. Jedne lepiej działają z realistycznymi obiektami i kadrami (np. ślubna fotografia pradziadków, śliczny plener), podczas gdy inne świetnie spisują się z bardziej bajkowymi kreacjami (np. kadr z anime). Niezależnie od motywu, przy dobrze dobranym modelu uzyskany efekt zawsze jest niezwykle imponujący. Z kolei sama obsługa darmowego Final 2x jest dziecinnie prosta.

Najpierw przeciągam obrazek w okno interfejsu, następnie wybieram model AI oraz układ odpowiedzialny za zadanie. Można wybrać procesor, ale w przypadku chęci wykorzystania GPU konieczne jest posiadanie karty firmy NVIDIA. To właśnie opierając zadanie o GeForce RTX 40 najszybciej uzyskuje się wyniki, zazwyczaj w zaledwie kilka sekund. Efekt jest naprawdę świetny. Obrazki 600 na 400 pikseli zamieniają się w ostre jak brzytwa grafiki 1000p. Spójrzcie zresztą na moje pokemony!

2. Zmieniam tło mieszkania i wyciszam pralkę podczas ważnej wideokonferencji

Kiedy trzeba ukryć rozgardiasz w mieszkaniu, a także dźwięk pralki niestrudzenie pracującej w tle, AI potrafi być wybawieniem. Lokalnie działające modele sztucznej inteligencji w czasie rzeczywistym modyfikują dźwięk i obraz rejestrowany przez kamerkę oraz mikrofon. Dzięki temu zawsze zachowujemy pozorny profesjonalizm podczas wideokonferencji. Nawet z górą nieposkładanych ubrań za plecami, a także wyciem zmywarki w sąsiednim pomieszczeniu.

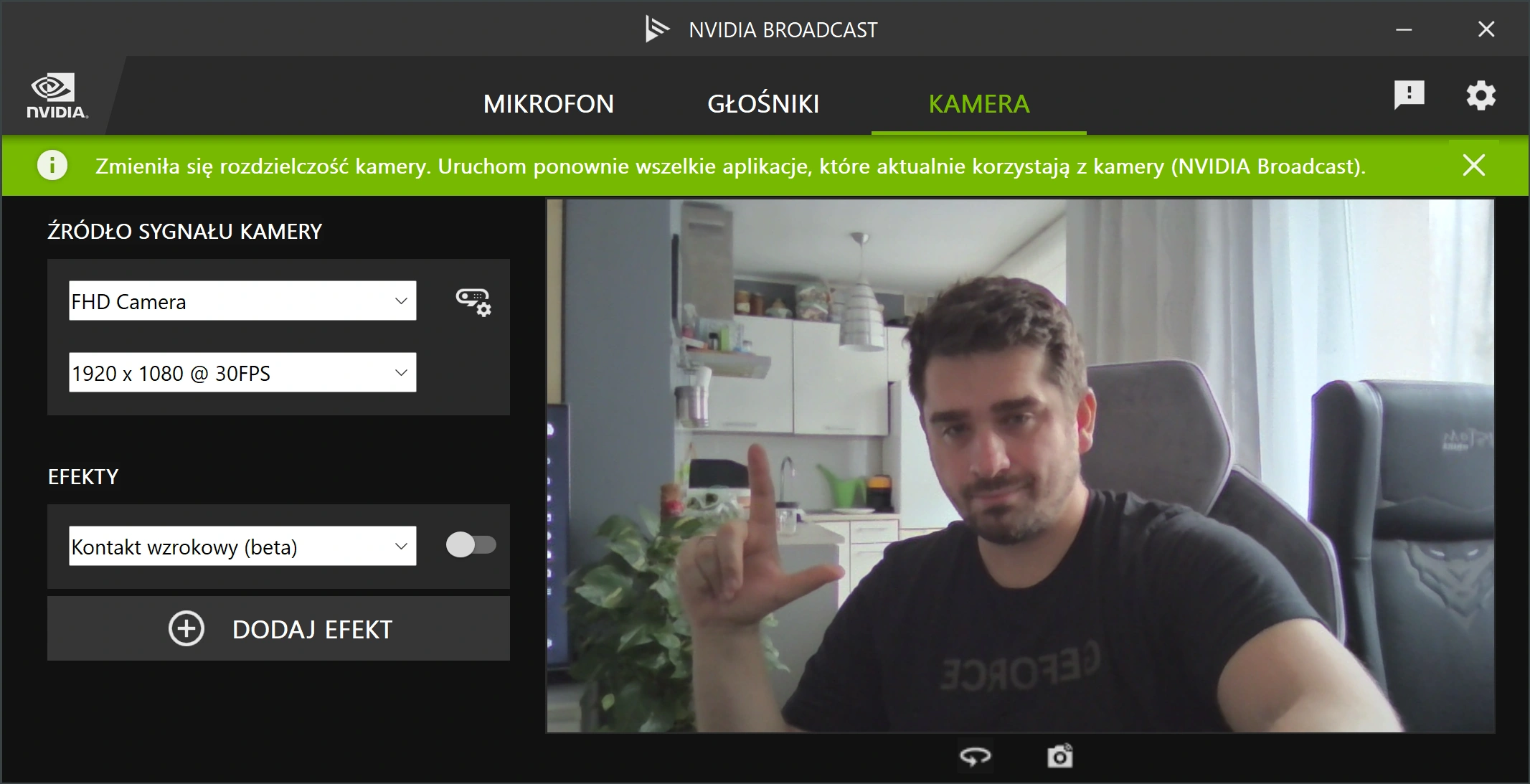

Oczywiście zmiana tła i redukcja szumu to funkcje, które były dostępne dla użytkowników komputerów od lat, na długo przed postępującą rewolucją AI. Jednak dopiero modele wsparte uczeniem maszynowym potrafią tak precyzyjnie wycinać kontury użytkownika i tak drastycznie zwiększać jakość naszego dźwięku w czasie rzeczywistym, mimo braku porządnego mikrofonu. Palce nie są już ucinane, włosy nie są golone, z kolei oprawki okularów nie roztapiają się na krawędziach. W tak precyzyjny sposób działa np. NVIDIA Broadcast.

NVIDIA Broadcast to zarówno program, jak i wirtualne źródło audio/wideo. Najpierw z poziomu aplikacji Broadcast wybieramy tło, korygujemy dźwięk i ustawiamy interesujące nas efekty. Później w popularnych programach takich jak Teams, Slack, OBS czy Discord wskazujemy aplikację NVIDIA w polu wyboru kamerki oraz mikrofonu. Dzięki temu zabiegowi możemy korzystać z audio i wideo wspartego AI na każdej popularnej platformie z rozbudowaną funkcją wideorozmowy.

Co świetne, modele AI takie jak NVIDIA Broadcast nie tylko czyszczą z szumów oraz hałasów otoczenia własne nagranie z mikrofonu, ale także nagrania pochodzące od moich rozmówców. Jeśli w zawodowej grupie macie osobę, która regularnie puszcza podczas wideokonferencji sonaty swojego psa, AI będzie tutaj wybawieniem.

3. Czytam z kartki albo z Worda, ale moje oczy wpatrują się w rozmówcę. Uwielbiam opcję kontaktu wzrokowego napędzaną AI.

To jedna z najlepszych rzeczy, jakie przydarzyły się w ostatnim czasie pracownikom biurowym. Dzięki funkcji kontaktu wzrokowego, realizowanej w czasie rzeczywistym za pośrednictwem sztucznej inteligencji oraz rdzeni Tensor, wideorozmówcy mogą odnosić wrażenie, iż stale wpatrujemy się w ekran, zachowując z nimi kontakt wzrokowy. Praca naszych gałek ocznych jest symulowana z taką naturalnością, że robi to na mnie nieustanne wrażenie.

Kiedy mój rozmówca odnosi wrażenie, że patrzę mu prosto w oczy, w tym samym czasie czytam raport pdf, albo zaglądam na kartkę papieru leżącą na klawiaturze laptopa. W oknie wideokonferencji nie widać jednak, abym posiłkował się tymi materiałami. Tam jestem skoncentrowany na osobie po drugiej stronie, z pewnym wzrokiem utkwionym w obiektywie. Marzenie introwertyka zostało spełnione!

Warto dodać, że System Windows 11 nauczył się podobnego rozwiązania, opartego o procesy angażujące procesory. Jednak na ten moment najbardziej realistyczny, ciągły i wiarygodny efekt kontaktu wzrokowego generują karty GeForce RTX z rdzeniami Tensor. Kapitalnie działa to w praktyce.

4. Robię zdjęcie w kiepskich warunkach, potem AI oczyszcza je z szumu i artefaktów

Uwielbiam, absolutnie uwielbiam funkcję Usuń szum dzięki AI w popularnym programie Lightroom. Lokalnie działający model sztucznej inteligencji od Adobe robi prawdziwe cuda ze zdjęciami, które na skutek kiepskiego oświetlenia, złych ustawień aparatu lub niskiej jakości obiektywu chorują na szumy, artefakty i barwne zniekształcenia. Szczerze, to dziwi mnie, że tak zniuansowana i rozbudowana funkcja AI może być realizowana lokalnie, bez wsparcia chmury.

Narzędzie Usuń szum dzięki AI w Lightroomie pozwala wybrać siłę nanoszonego efektu, dopasowując ją do jakości zdjęciu. Operacje na wielkich fotografiach RAW mogą zajmować nawet kilka minut, w zależności od wydajności karty graficznej. Jednostki GPU takie jak GeForce RTX 4080 i 4090 zapewniają oczywiście najszybsze rezultaty. Jednak nawet na korzystnych cenowo modelach RTX 4050 oraz RTX 4060 efekt jest tak samo kapitalny, po prostu dłużej się na niego czeka. Ręczna redukcja szumu na stałe odchodzi do przeszłości, AI robi to po prostu lepiej.

Zresztą, nie będę gołosłowny. Spójrzcie na moje zdjęcia przed i po wykorzystaniu lokalnego modelu AI napędzanego rdzeniami Tensor. Różnica jak dzień i noc

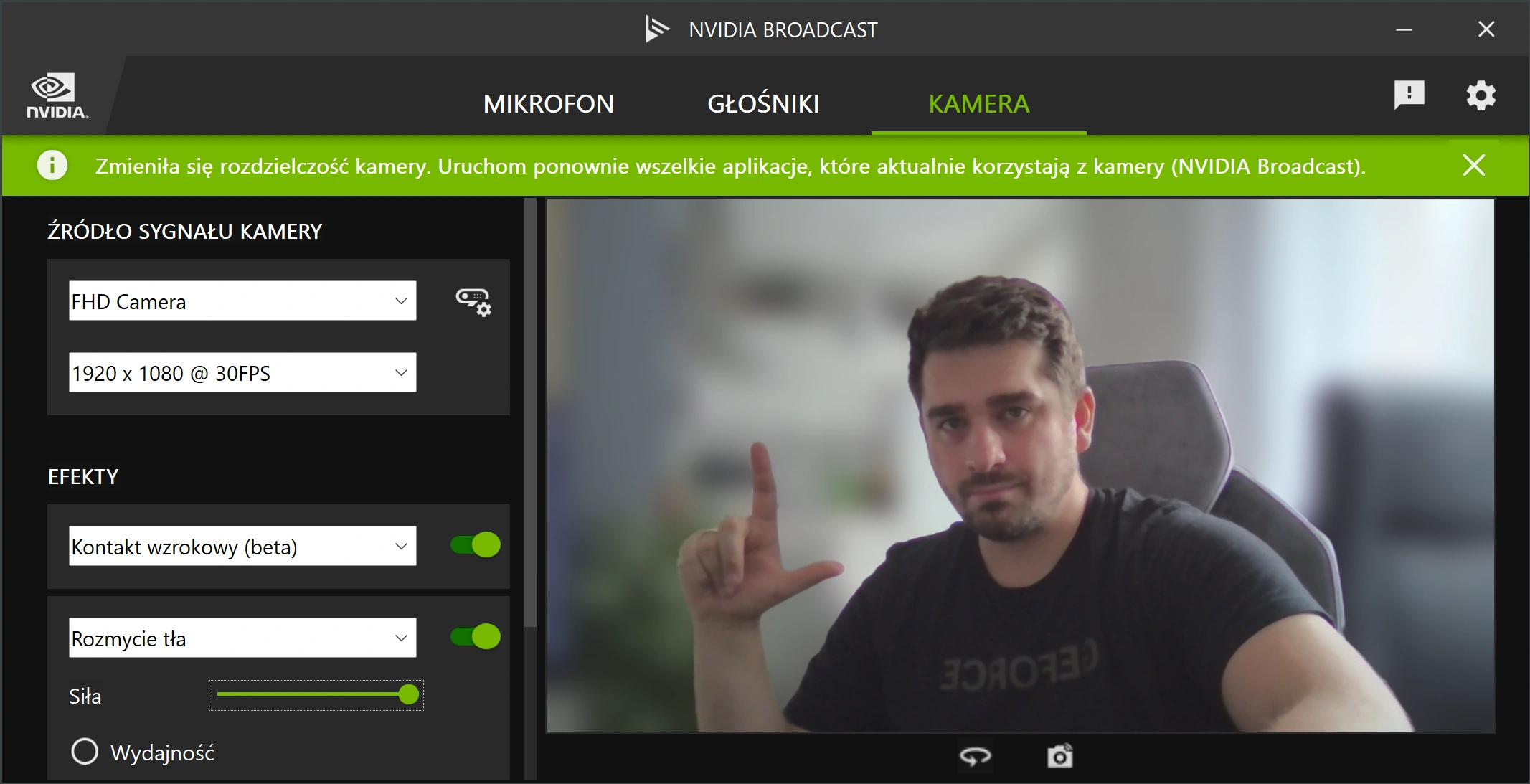

5. Przyspieszam dwukrotnie płynność w wymagających grach, zmieniając jeden suwak w opcjach

Gdybym mógł włożyć pod pachę mój laptop do gier, cofnąć się w czasie o dekadę i pokazać możliwości pakietu DLSS 3 ówczesnym graczom, opadłyby im szczęki. Za pomocą jednego suwaka w ustawieniach gry wideo praktycznie podwajam płynność rozgrywki. To zasługa generatora klatek, stanowiącego część rozwiązań DLSS trzeciej generacji dla graczy, będących znakiem rozpoznawczym kart GeForce RTX.

Generator tworzy zupełnie nowe klatki w grach wideo, na podstawie klatki bazowej, przy użyciu rdzeni Tensor i bez angażowania w tym celu innych podzespołów. Dzięki temu rozgrywka odczuwalnie zyskuje na płynności, a liczba wyświetlanych klatek na sekundę znacząco rośnie, czasem wręcz dwukrotnie. Co by nie być gołosłownym, poniżej kilka moich przykładowych wyników, na domowym PC z kartą GeForce RTX 4090, procesorem Intel Core i9-13900K oraz 64 GB pamięci RAM:

NVIDIA GeForce RTX 4090, DLSS w trybie zbalansowanym:

- Cyberpunk 2077, 4K, Ultra, DLSS Off: 75 - 82 fps

- Cyberpunk 2077, 4K, Ultra, DLSS On: 103 - 111 fps

- Cyberpunk 2077, 4K, Ultra, DLSS On, generator klatek: 132 - 143 fps

Uzysk jest więc niesamowity. Różnica między grą uruchomioną bez wsparcia DLSS, a tą samą grą z wykorzystaniem generatora klatek, wynosi w moim przypadku aż 60 fps-ów. To niemal podwojenie płynności. Podczas dynamicznego ruchu (np. szybka jazda samochodem przez miasto, z jednoczesną silną rotacją kamery) uzysk generatora spada, lecz efekt i tak jest niezwykle imponujący. Do tego NVIDIA nieustannie rozwija tę technologię, przez co rezultaty będą wyłącznie lepsze.

6. Zamieniam bazgroły godne pięciolatka w piękne, pełne detali grafiki

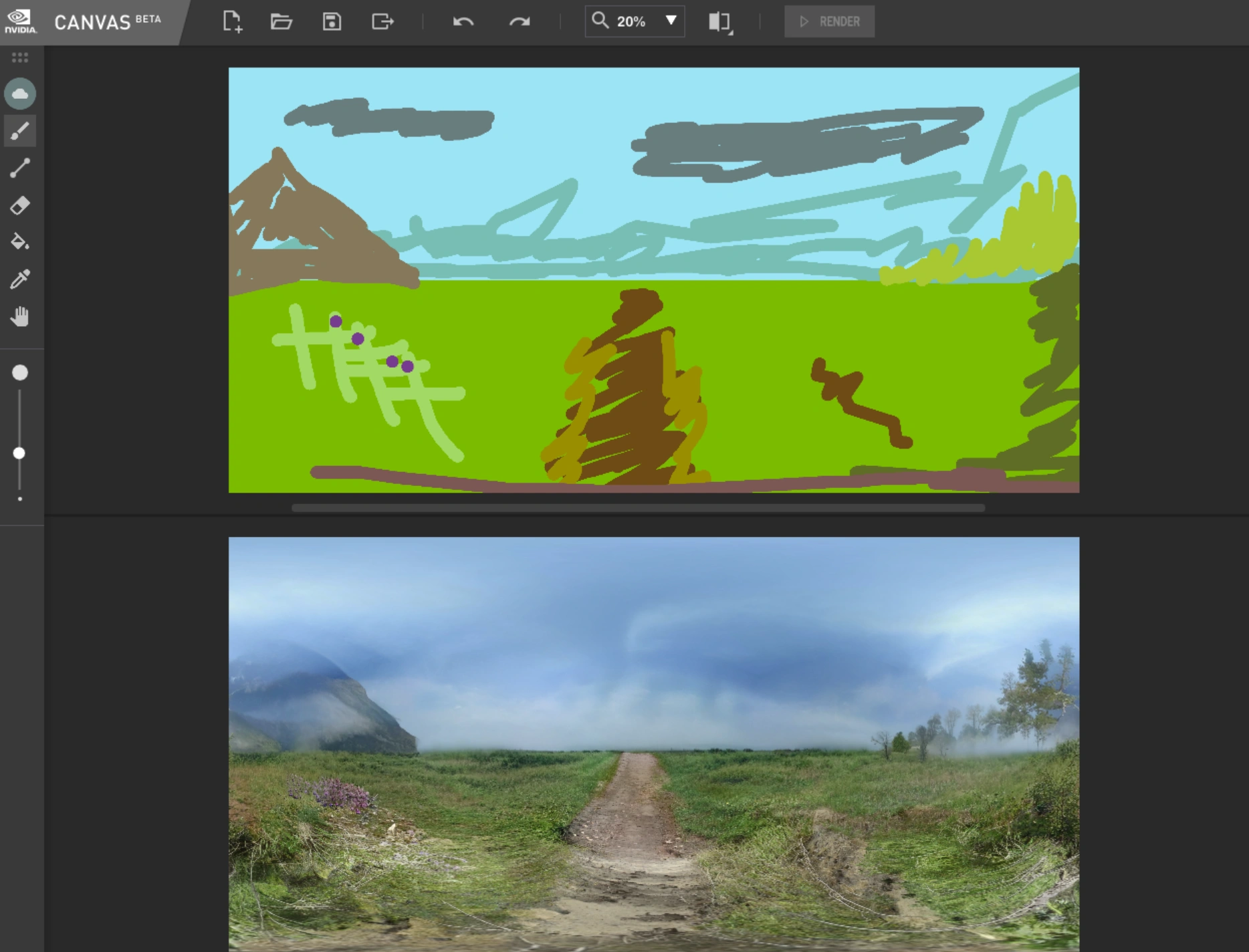

Generatywne modele AI tworzące grafikę to najprawdopodobniej drugi najpopularniejszy przykład wykorzystania sztucznej inteligencji przez typowego użytkownika, zaraz po wszechwiedzących czatbotach. Okazuje się jednak, że wcale nie trzeba mieć dostępu do Internetu, aby wyczarować na swoim komputerze coś pięknego z niemal niczego. Lokalne modele sztucznej inteligencji są już na tyle zaawansowane, by radzić sobie z generowaniem szczegółowych, realistycznych obrazów. Do tego w czasie rzeczywistym, bez ekranów ładowania i pasków postępu!

Spójrzcie zresztą na moje dzieło. Zielona łączka ze ścieżką i górą w oddali wygląda tak źle, że byle przedszkolak namalowałby coś lepszego. Mimo tego program NVIDIA Canvas zamienia moje bazgroły w szczegółową grafikę, wyglądająca na tyle dobrze, że bez problemu można się nią posłużyć w codziennej pracy, np. jako tło do tekstowego ogłoszenia na mediach społecznościowych. Co najbardziej niesamowite, Canvas zamienia bazgroły na szczegółowe grafiki w czasie rzeczywistym. Każda wykonana przez mnie koślawa kreska od razu jest interpretowania na ścianę lasu, pełną detali ścieżkę czy uroczy potok.

NVIDIA Canvas jest świetna z jeszcze jednego powodu. Program napędzany rdzeniami Tensor jako jedno z niewielu lokalnie działających narzędzi jest w stanie generować szerokie panoramy w wysokiej rozdzielczości. Uzyskane materiały są na tyle wielkie i ostre, że bez problemu mogą pełnić rolę grafik tytułowych na Spider’s Web.

7. Wskazuję kursorem element zdjęcia, sztuczna inteligencja wycina ten obiekt co do włoska

Pamiętam moje pierwsze komercyjne zlecenie z obszaru grafiki komputerowej. Parę stron do katalogu reklamowego dla dystrybutora kosmetyków. Siedziałem wtedy z lupą w Photoshopie, wycinając modelki z lśniącymi włosami, oczywiście kawałek po kawałku. Solidna pojedyncza wycinka potrafiła zabrać mi nawet kilka minut. A teraz... teraz po prostu najeżdżam kursorem na panią na zdjęciu, a AI robi całą resztę, rozpoznając cały kształt i zaznaczając go z imponującą skrupulatnością.

To wręcz zdumiewające, jak szybko Photoshop akcelerowany kartą RTX rozpoznaje dany obiekt i go zaznacza. Człowiek, wazon, chmura, całe pasmo górskie - operacja zawsze trwa mniej niż sekundę. Fioletowy obrys jest nie tylko skuteczny, ale i sprytny. Zazwyczaj rozróżnia obiekty, plany, tekstury i powierzchnie, dzięki czemu minuty żmudnej pracy zamieniam w jeden klik. Ewentualnie trzy, gdy chcę zaznaczyć i zmodyfikować kilka obiektów jednocześnie.

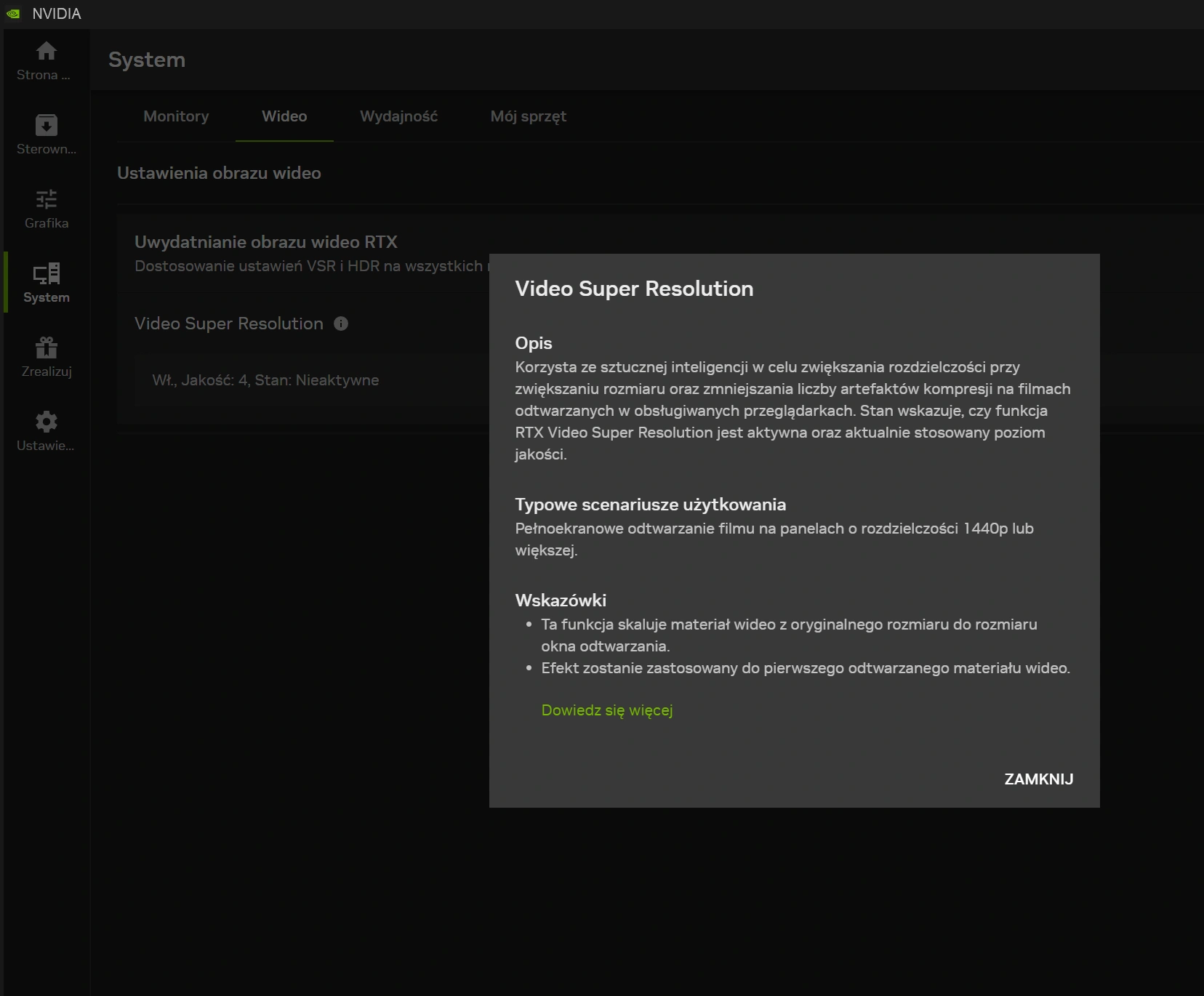

8. Zamieniam zwykłe wideo na YouTube w ostre jak brzytwa materiały w super rozdzielczości

Świetną funkcją AI od NVIDIA, o której mówi się zdecydowanie zbyt mało, jest Video Super Resolution. Rozwiązanie wykorzystuje lokalną sztuczną inteligencję do ulepszania jakości wideo wyświetlanego w przeglądarkach Chrome oraz Edge, a także w programie VLC. VSR sprawia, iż obraz jest odczuwalnie ostrzejszy i klarowniejszy od oryginału, poprzez jego obróbkę w czasie rzeczywistym, podczas oglądania przez użytkownika.

Efekt jest imponujący zwłaszcza, kiedy w narzędziu NVIDIA App ustawimy maksymalny, czwarty poziom jakości Video Super Resolution. Nie zdziwcie się tylko wtedy, jeśli nagle usłyszycie dźwięk wentylatorów swojego komputera stacjonarnego lub laptopa. Taka obróbka wideo w czasie rzeczywistym wymaga bowiem sporej mocy obliczeniowej. Uzyskany efekt zdecydowanie wart jest jednak odrobiny szumu.

Świetnie jest to, że Video Super Resolution zwiększa jakość wideo niezależnie od platformy. Może to być YouTube, Netflix, Max czy TED. Dlatego, jeśli macie np. ulubiony teledysk, zwiastun albo fragment filmu, polecam zobaczyć go na nowo, z aktywowanym VSR. Aż dziw, że ta opcja jest domyślnie wyłączona w aplikacji NVIDIA. Pewnie chodzi o optymalizację systemu podczas korzystania z wielu kart przeglądarki internetowej.

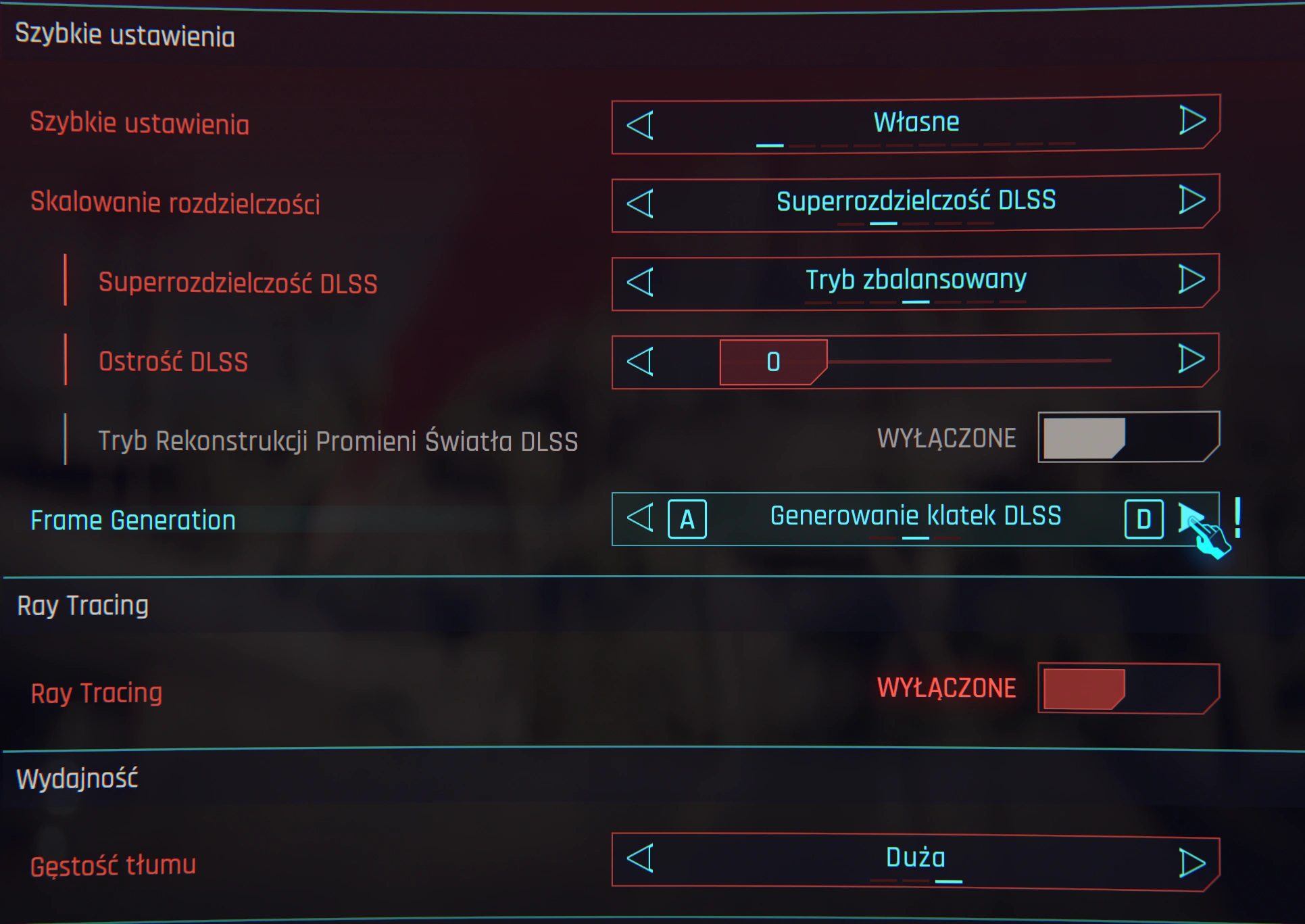

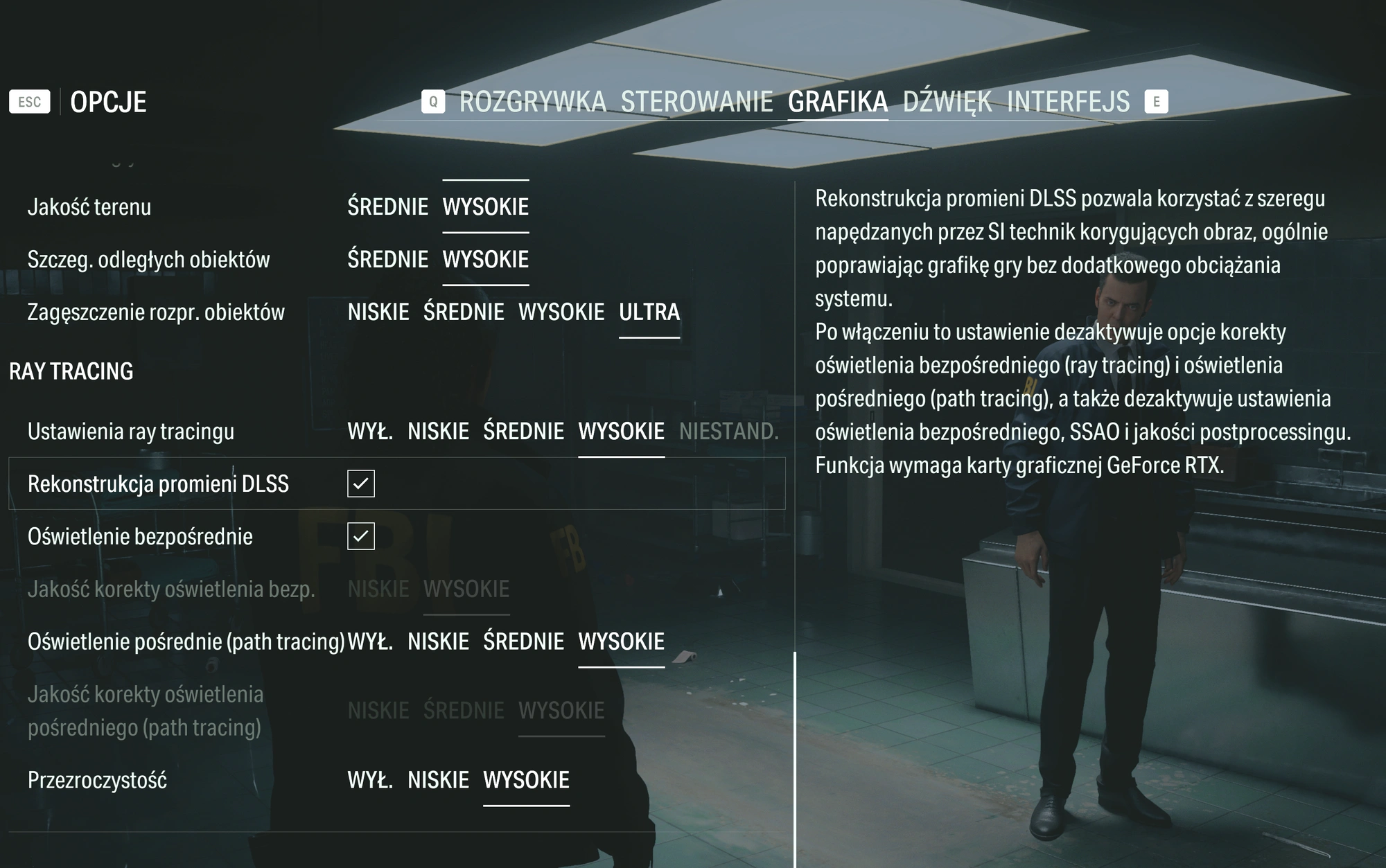

9. Rekonstruuję promienie światła, dzięki czemu gry wideo wchodzą na nowy poziom realizmu

Niesamowite jest to, jak może się różnić ta sama scena w grze wideo, na skutek innego typu oświetlenia. Doskonałym tego przykładem jest klimatyczny thriller Alan Wake 2 od uznanego studia Remedy. Jeśli włączymy w nim opcję śledzenia promieni światła w czasie rzeczywistym (ray tracing), uzyskamy niezwykle kompleksową scenę: pełną cieni, promieni, refleksów i odbić obliczanych w czasie rzeczywistym, zgodnie ze znanymi nam prawidłami fizyki. Ot, taka namiastka prawdziwego świata, włożona do gry wideo.

Niestety, promienie śledzone w czasie rzeczywistym są potężnym obciążeniem dla układów graficznych, nawet tych topowych. Dlatego większość graczy rezygnuje z ray tracingu, zyskując dzięki temu znacznie większą wydajność oraz odczuwalnie wyższą płynność, kosztem mniej naturalnego i zniuansowanego światła. Tutaj wchodzi NVIDIA, cała na biało zielono, z funkcją ray tracing reconstruction.

Ray tracing reconstruction odtwarza efekty śledzenia promieni w czasie rzeczywistym, w oparciu o uczenie maszynowe, zachowując przy tym wysoką płynność rozgrywki. Narzędzie dostępne w pakiecie DLSS 3,5 spisuje się znacznie lepiej niż standardowa rekonstrukcja promieni przy użyciu DLSS. Tzw. odszumiacz efektów RT zostaje bowiem zamieniony na złożony model AI biorący pod uwagę 5-krotnie więcej danych, jednocześnie odciążając VRAM w karcie graficznej. Rezultat? Piękniejsze, dokładniejsze promienie w czasie rzeczywistym, z jednoczesnym lekkim zwiększeniem wydajności w grze. Dzięki RTR gry takie jak Cyberpunk 2077 czy Alan Wake 2 mogą zachwycać złożonością środowiska świetlnego, bez powodowania zadyszki komputera.

Możliwości lokalnego AI będzie jedynie przybywać. Regularnie pojawiają się nowe, imponujące rozwiązania

Na przykład Subsync, dopasowujący napisy do konkretnej wersji filmu lub serialu, eliminując problemy z synchronizacją. Lokalne modele sztucznej inteligencji potrafią coraz więcej, coraz szybciej i coraz lepiej, a liczba narzędzi AI działających offline rośnie z tygodnia na tydzień. To jak śniegowa kula, która zaczyna toczyć się z wysokiego zbocza, rosnąc i rosnąc po drodze.

Jesteśmy dopiero na początku tej drogi, dopiero wchodzimy na dziki step pełen trudnych do wyobrażenia możliwości, a już teraz typowy użytkownik zyskuje masę kapitalnych narzędzi, generujących efekty o jakich dawniej można było wyłącznie marzyć. Do tego wiele z nich, jak NVIDIA Broadcast, Subsync, czy Final 2x jest kompletnie darmowych, a także banalnych w obsłudze oraz bardzo łatwych w instalacji. Ależ jestem ciekaw, co przyniosą kolejne miesiące.