Tak uczy się sztuczna inteligencja. Model Google'a dorównuje człowiekowi

Najbardziej znane nam modele sztucznej inteligencji swój potencjał opierają na wcześniej już zdobytej wiedzy, generując często błędne dane tam, gdzie danych treningowych zabrakło. DeepMind przeciera szlaki w uczeniu przez wzmacnianie pokazując, że nawet bez poprzedniego treningu SI może działać równie dobrze jak człowiek. O ile nie po prostu lepiej.

Pośród wielu technik uczenia maszynowego, wielu specjalistów uważa uczenie przez wzmacnianie (RL) jako najlepszą metodę. W dużym uproszczeniu, RL polega na pokazaniu sztucznej inteligencji, jak wygląda jej cel (sukces) i pozostawienie jej samej sobie, tak aby ta nauczyła się - metodą prób i błędów - zasad rządzących danym środowiskiem i osiągnęła jak największą liczbę sukcesów. Uczenie przez wzmacnianie można porównać do nauki gry w chowanego.

Naszym celem jest ukrycie się, jednak na podstawie kolejnych porażek przekonujemy się, że szukający odlicza do 10, a wygrywa nie ten, kto się jedynie schowa, lecz ten, kto zostanie odkryty jako ostatni. W tym przypadku uczenie przez wzmacnianie jest widoczne w kolejnych sesjach gry, w której poznajemy otoczenie, znajdujemy coraz lepsze kryjówki i wykorzystujemy stale polepszająca się znajomość terenu, by zdobyć przewagę. To właśnie RL posłużyło naukowcom do wytrenowania sztucznych neuronów do gry w Ponga, a badaczom Mety do wytrenowania Cicero do gry w Dyplomację.

Zrozumieć uczenie przez wzmacnianie i meta-uczenie przez wzmacnianie

Jednak tu zaczynają się schody, gdyż w obecnej formie uczenie przez wzmacnianie potrzebuje setek, o ile nie tysięcy sesji nad jednym zadaniem, aby zrozumieć zasady rządzące środowiskiem. Dla przykładu, AlphaGo Zero stworzone przez DeepMind jest mistrzem świata w grze Go, lecz by osiągnąć mistrzowską biegłość w grze, potrzebowała rozegrać... 4,9 mln meczów.

Odpowiedzią na ten problem jest metoda meta-uczenia przez wzmacnianie (meta-RL), dzięki któremu agent SI adaptuje się do nowych warunków znacznie szybciej niż w przypadku zwykłego RL. Za szybszą adaptację przy wykonywaniu zadania odpowiadają wiedza i obserwacje pozyskane przy rozwiązywaniu poprzedniego problemu, który był w jakiś sposób związany z obecnie rozwiązywanym problemem. Przykładem ilustrującym meta-RL może być np. pływanie. Jeżeli nauczysz się podstawowego stylu pływackiego, umiejętność ta pozwoli ci uczyć się kolejnych stylów.

DeepMind przeciera szlaki w meta-uczeniu przez wzmacnianie

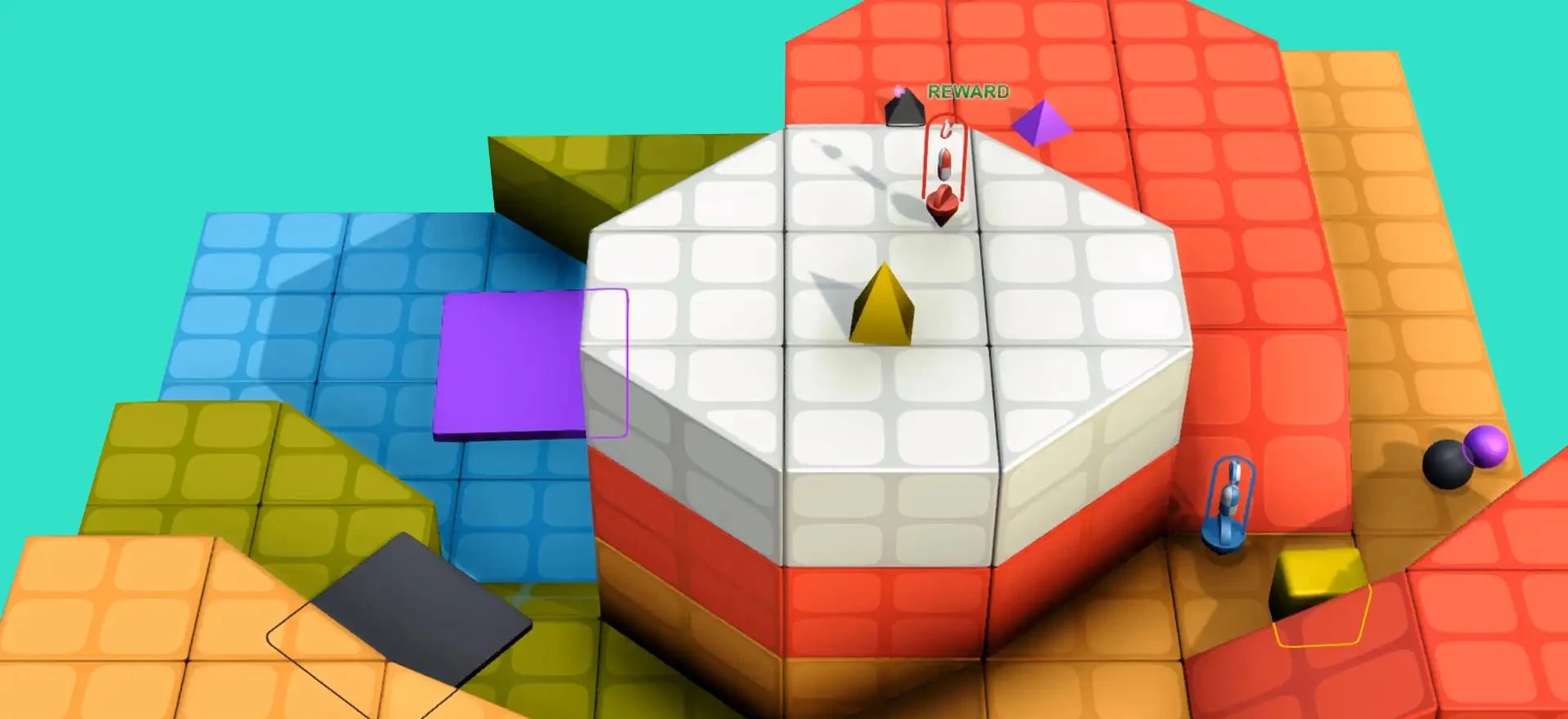

DeepMind, należące do Google przedsiębiorstwo zajmujące się badaniami nad sztuczną inteligencją stale rozwija technikę meta-RL. W 2021 roku zaprezentowało ono model, który operował w otwartym, całkowicie wirtualnym świecie XLand. Gracze - pod postacią samodzielnie działających modeli sztucznej inteligencji - otrzymywali proste zadania, które stopniowo zwiększały stopień trudności, ostatecznie samodzielnie ucząc się zasad gier terenowych. Tak jak w przypadku AlphaGo Zero SI grała sama ze sobą, jednakże nie była nastawiona na wykonywanie jednego zadania, a stałe podnoszenie sobie poprzeczki i uczenie się z poprzednich, powiązanych ze sobą zadań.

Teraz DeepMind przekuwa doświadczenia zdobyte przy pracy nad XLand, tworząc Agenta Adaptacyjnego (Adaptive Agent, AdA). Domem AdA jest ulepszona wersja wirtualnego świata o nazwie XLand 2.0, w którym AdA miał przed sobą kilka zadań i kilka wyzwań. Począwszy od zrozumienia tego jak nawigować w wirtualnym świecie poprzez naukę skakania przez ściany, kończąc na imitacji gry w Overcooked - popularnej gry kooperacyjnej polegającej na wspólnym gotowaniu.

Następnie badacze DeepMind porównali efektywność AdA z efektywnością ludzi postawionych przed tymi samymi zadaniami. W wielu zadaniach agent wykazywał podobną prędkość i efektywność działania porównywalną z człowiekiem, a w niektórych przypadkach AI dokonywała tego, co sprawiało ludzkim graczom problemy.

Choć XLand 2.0 i AdA wyglądają jak niepozorne elementy gry komputerowej, w rzeczywistości są one demonstracją możliwości SI w zakresie rozwiązywania problemów i nauki w otaczającej jej rzeczywistości. Dalszy rozwój w tym kierunku mógłby doprowadzić do np. opracowania modelu, który pozwoliłby Atlasowi Boston Dynamics na samodzielne nawigowanie w środowisku. Z kolei technologia ta - po wyjściu z murów laboratoryjnych - mogłaby przyczynić się do rozwoju robotów, które są w stanie wyręczyć człowieka w ciężkich warunkach pracy (takich jak choćby place budowy czy magazyny). Z dorobku DeepMind mogłyby czerpać również firmy produkujące autonomiczne samochody, które stale uczyłyby się i doskonaliły jazdę na podstawie obserwacji i poprzednich jazd.