Deep Fusion w iPhonie rozczarowuje

Właśnie zadebiutowało Deep Fusion, czyli oczekiwana od dawna nowość mająca znacznie poprawić jakość zdjęć z iPhone’ów. Sprawdziłem, jak nowy tryb działa w praktyce. Niestety rewolucji nie ma.

Podczas premiery iPhone’ów 11 i 11 Pro tryb Deep Fusion był zapowiadany jako rewolucja w aparatach iPhone’a. Apple nie zdążył z przygotowaniem trybu na premierę iPhone’ów, ale obiecano nam, że Deep Fusion trafi do użytkowników jeszcze jesienią. I faktycznie, ten moment właśnie nastał wraz z premierą systemu iOS 13.2.

Dla kogo Deep Fusion?

Nowy tryb Deep Fusion działa wyłącznie na najnowszych iPhone'ach, ale za to na wszystkich: bazowym 11, 11 Pro i 11 Pro Max z systemami w wersji minimum 13.2. Apple argumentuje to faktem, że do działania jest wymagany procesor A13 Bionic, a konkretnie jego system Neural Engine, dzięki któremu można uzyskać lepszą strukturę i szczegółowość zdjęć robionych w słabym świetle. I faktycznie, w trybie Deep Fusion procesor ma mnóstwo danych do przetworzenia.

Jak działa Deep Fusion?

W trybie Deep Fusion aparat (tylko standardowy obiektyw!) iPhone'a rejestruje cały szereg zdjęć: cztery zdjęcia z bardzo krótkim czasem migawki, cztery kolejne ze standardowymi nastawami i na koniec jedno zdjęcie z długą ekspozycją. Następnie całość jest łączona w jedno ujęcie, które ma się charakteryzować dużo większą szczegółowością.

Algorytmy iPhone’a nie łączą zdjęć bezwiednie, bowiem całość jest analizowana pod kątem obiektów wystepujących na zdjęciu. Dzięki temu włosy portretowanej osoby mogą zyskać więcej szczegółów, ale niebo nad głową nie będzie wzbogacane, aby nie pojawił się szum na jednolitej powierzchni.

Deep Fusion ma działać wieczorem oraz w pomieszczeniach, a więc w sytuacjach, w których aparaty smartfonów radzą sobie najgorzej. Tym samym iPhone ma trzy tryby poprawiające jakość zdjęć:

- Smart HDR w zdjęciach robionych za dnia,

- Deep Fusion w zdjęciach wieczornych,

- Tryb nocny po zmroku.

Każdy z tych trybów włącza się automatycznie, bez zaangażowania użytkownika. Każdy działa też niezależnie od innych, a w danej chwili nie może działać więcej niż jeden tryb.

Tyle teorii. Jak Deep Fusion sprawdza się w praktyce?

Apple robi wszystko, by użytkownik nie wiedział, czy Deep Fusion działa. Trybu nie da się w żaden sposób włączyć na stałe. Jeśli aparat uzna, że jest zbyt ciemno na Smart HDR, ale zbyt jasno na tryb nocny, Deep Fusion powinien włączyć się automatycznie. W aplikacji aparatu nie ma żadnej informacji mówiącej o tym, że tryb się aktywował.

Jak zatem poznać, że zrobiliśmy zdjęcie z Deep Fusion? Zdradza to galeria. Jeśli od razu po zrobieniu zdjęcia przejdziemy do podglądu, a dopiero po czasie 1–2 s zobaczymy ostry obrazek, oznacza to, że algorytmy właśnie przetworzyły zdjęcie do Deep Fusion. Jak widać, nawet potężny procesor A13 nie jest w stanie łączyć obrazów natychmiast.

Jeżeli na podglądzie po zrobieniu zdjęcia od razu widzimy ostry obrazek, to iPhone nie skorzystał z Deep Fusion. Moment przeskoku ostrości jest bardzo widoczny.

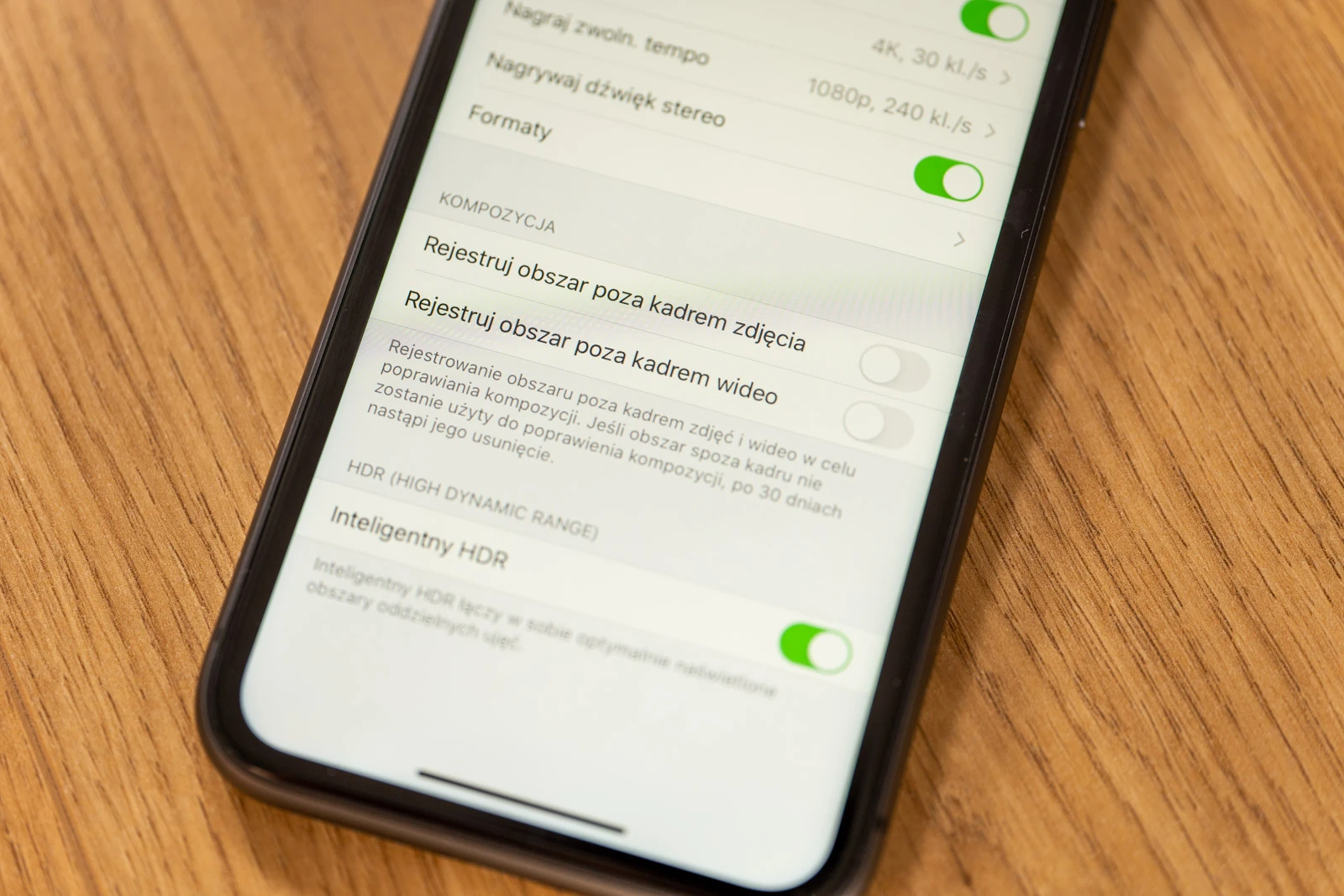

Ważna uwaga: tryb Deep Fusion nie włączy się jeśli korzystamy z funkcji „Rejestruj obszar poza kadrem zdjęcia” dostępnej w ustawieniach aparatu. Jeśli ta funkcja jest włączona, iPhone przechwytuje jednocześnie obraz ze zwykłego i ultraszerokokątnego obiektywu, dzięki czemu można poszerzyć kadr już po zrobieniu zdjęcia. Te dodatkowe informacje w połączeniu z algorytmami Deep Fusion najpewniej zbyt mocno obciążałyby procesor iPhone’a.

Zobaczmy zatem działanie Deep Fusion na przykładach.

Deep Fusion testuję już od tygodnia. Korzystałem w tym czasie z dwóch iPhone’ów 11, które na czas testów wypożyczył nam X-Kom. Pierwszy działał na oficjalnym systemie iOS 13.1, a drugi na becie iOS 13.2, w której Deep Fusion było już dostępne. Trzeba brać poprawkę na to, że Deep Fusion było w fazie beta, ale po aktualizacji systemu i szybkich testach, nie widzę żadnych różnic między betą a finalną wersją.

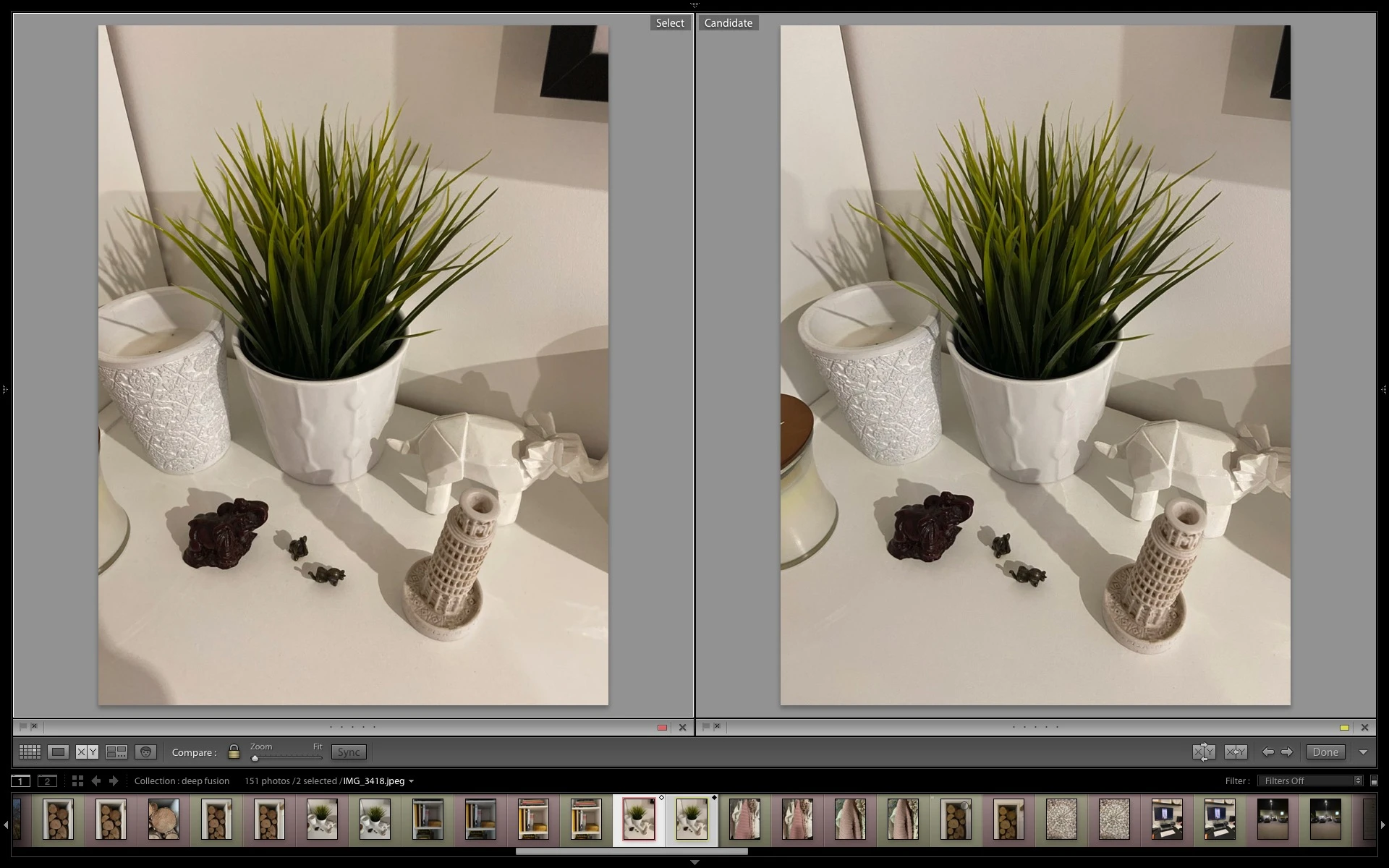

Za każdym razem zdjęcie z Deep Fusion znajduje się po prawej stronie. Polecam oglądanie zdjęć na komputerze, ponieważ na smartfonie różnice będą niezauważalne. Po kliknięciu zdjęcia pojawi się podgląd w dużym rozmiarze.

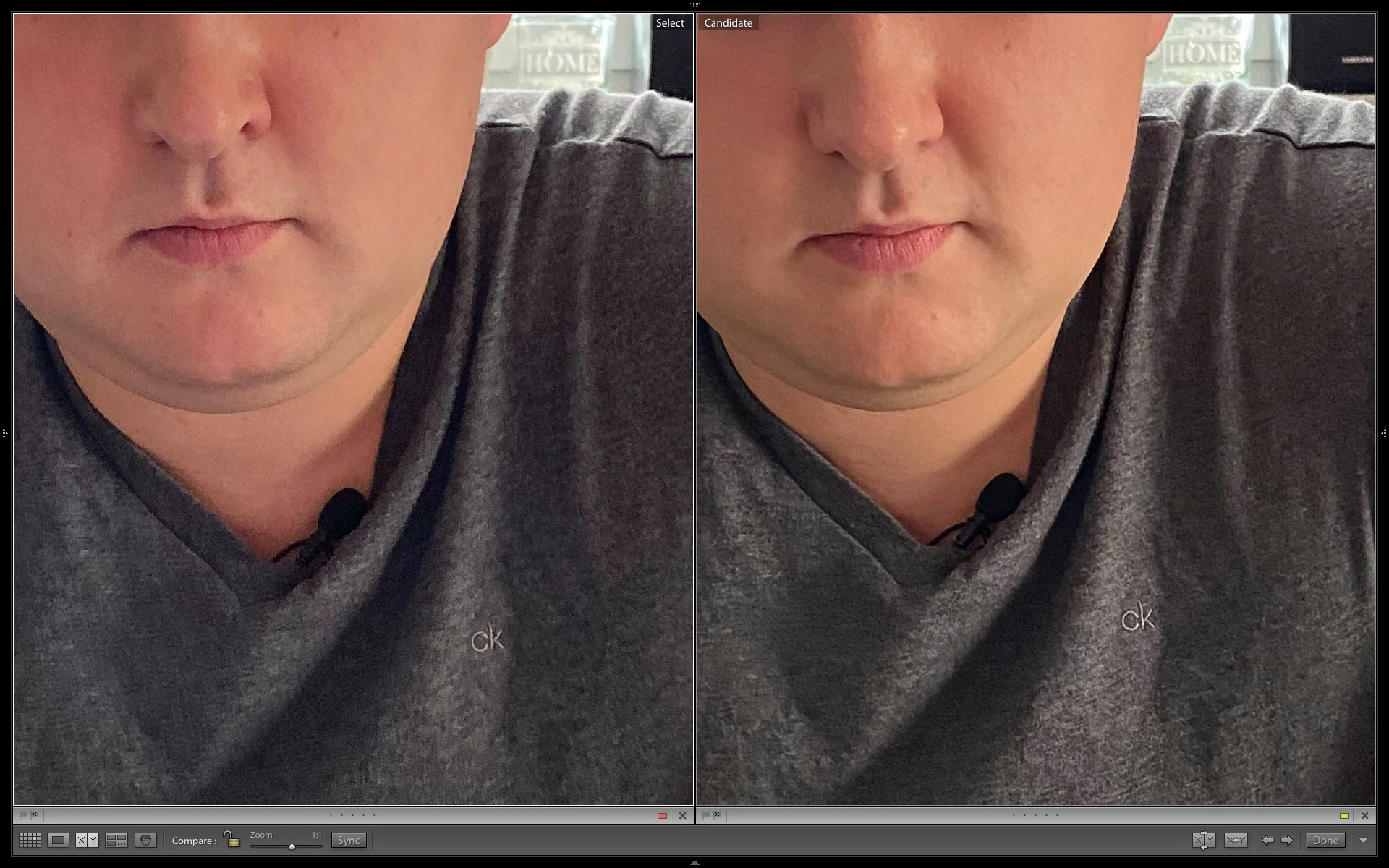

Pierwsze zdjęcie to portret wykonany w pochmurny dzień, przy zasłoniętych roletach. Był to moment, w którym już można włączyć światło, ale jeszcze nie trzeba. Poniżej powiększenia tego kadru.

Widzicie różnicę? Na pierwszy rzut oka trudno ją dostrzec, ale faktycznie zdjęcie z Deep Fusion ma nieco więcej szczegółów. Widać to zwłaszcza na włosach, na ustach i na detalach na koszulce. Trudno mówić o rewolucji, ale w tym zdjęciu Deep Fusion dało odrobinę lepszy rezultat.

Powyższe zdjęcie to najlepszy przykład działania Deep Fusion, jaki udało mi się uzyskać. Na powiększeniu widać, że prążkowany pierścień na obiektywie jest ostrzejszy.

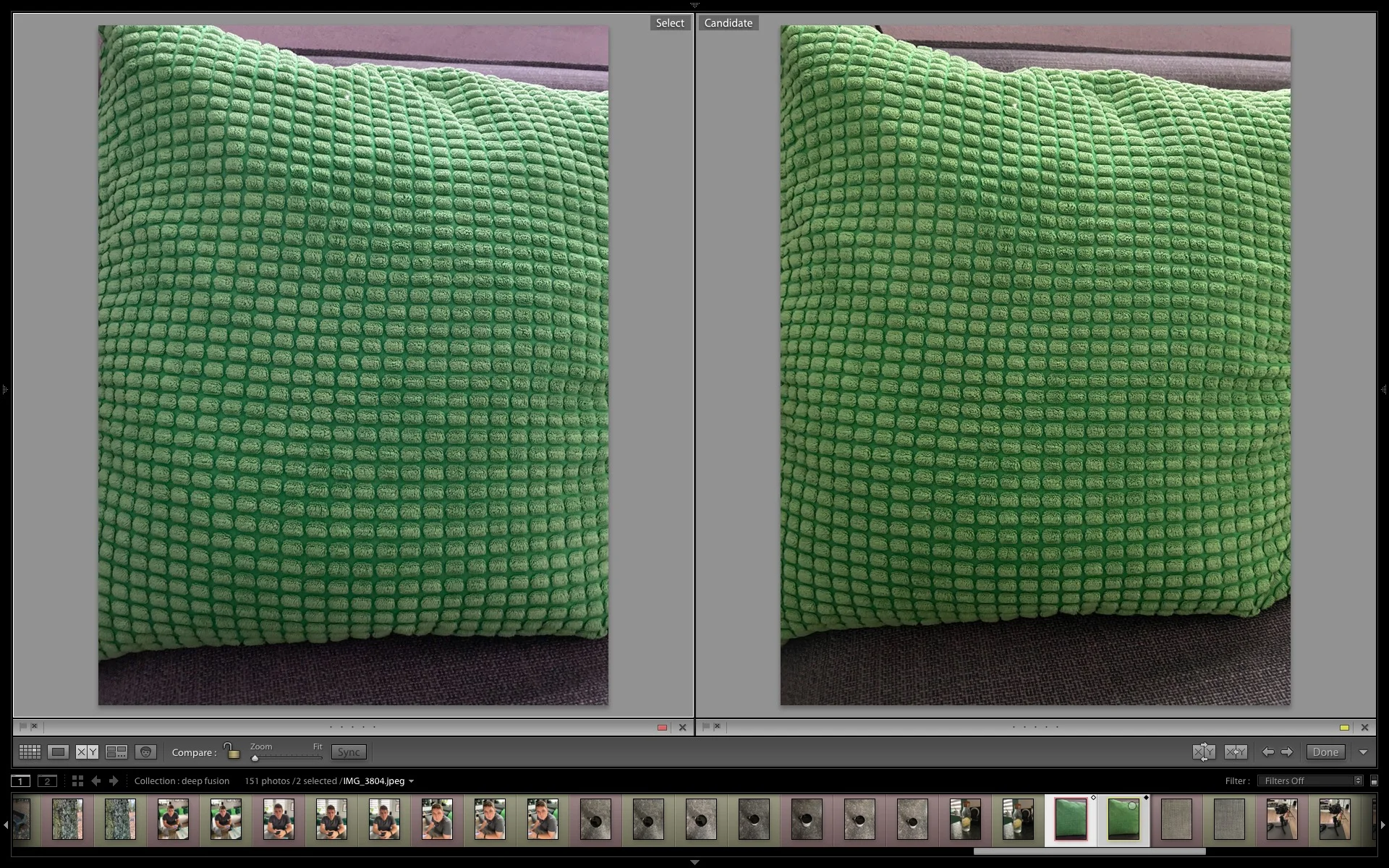

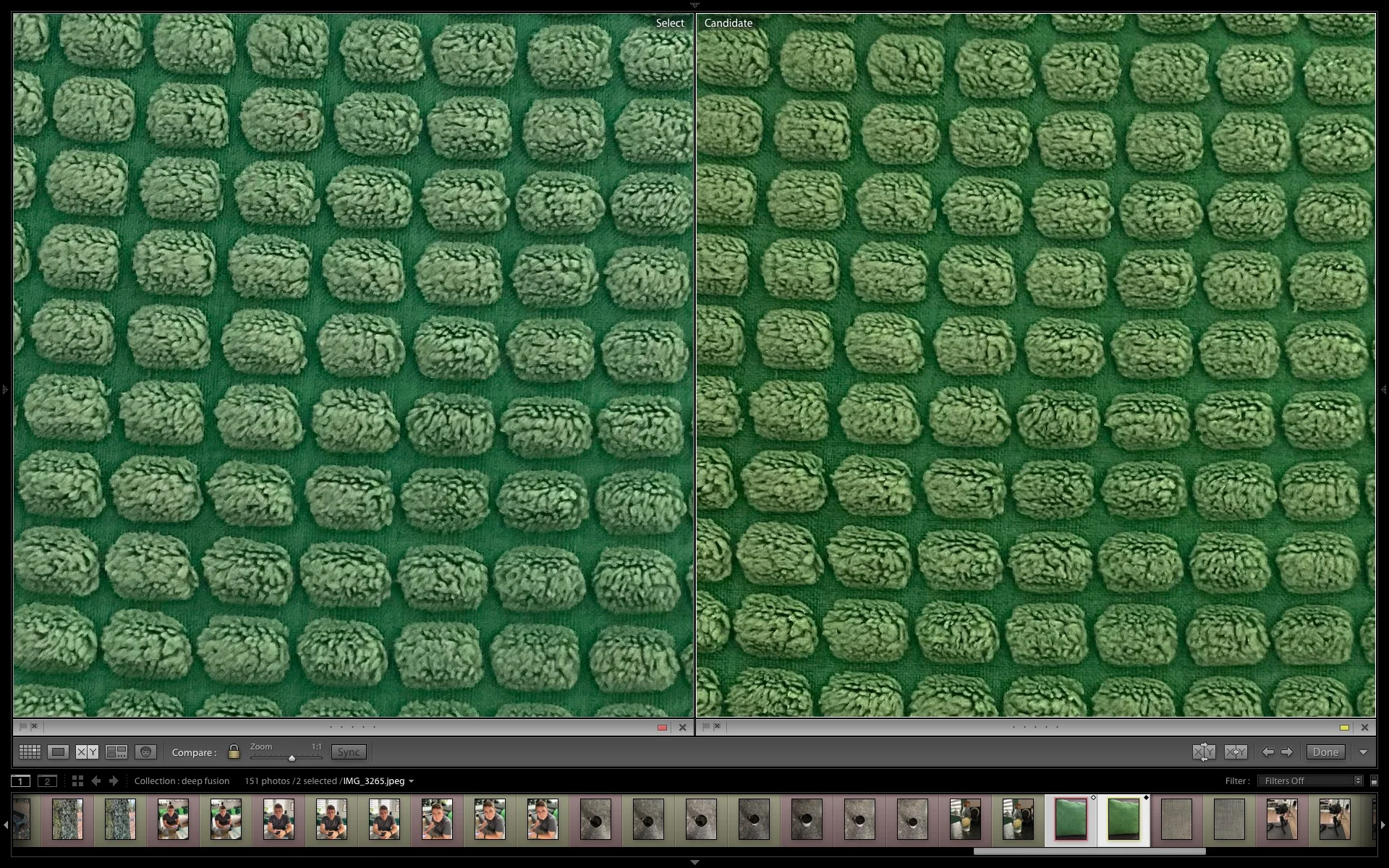

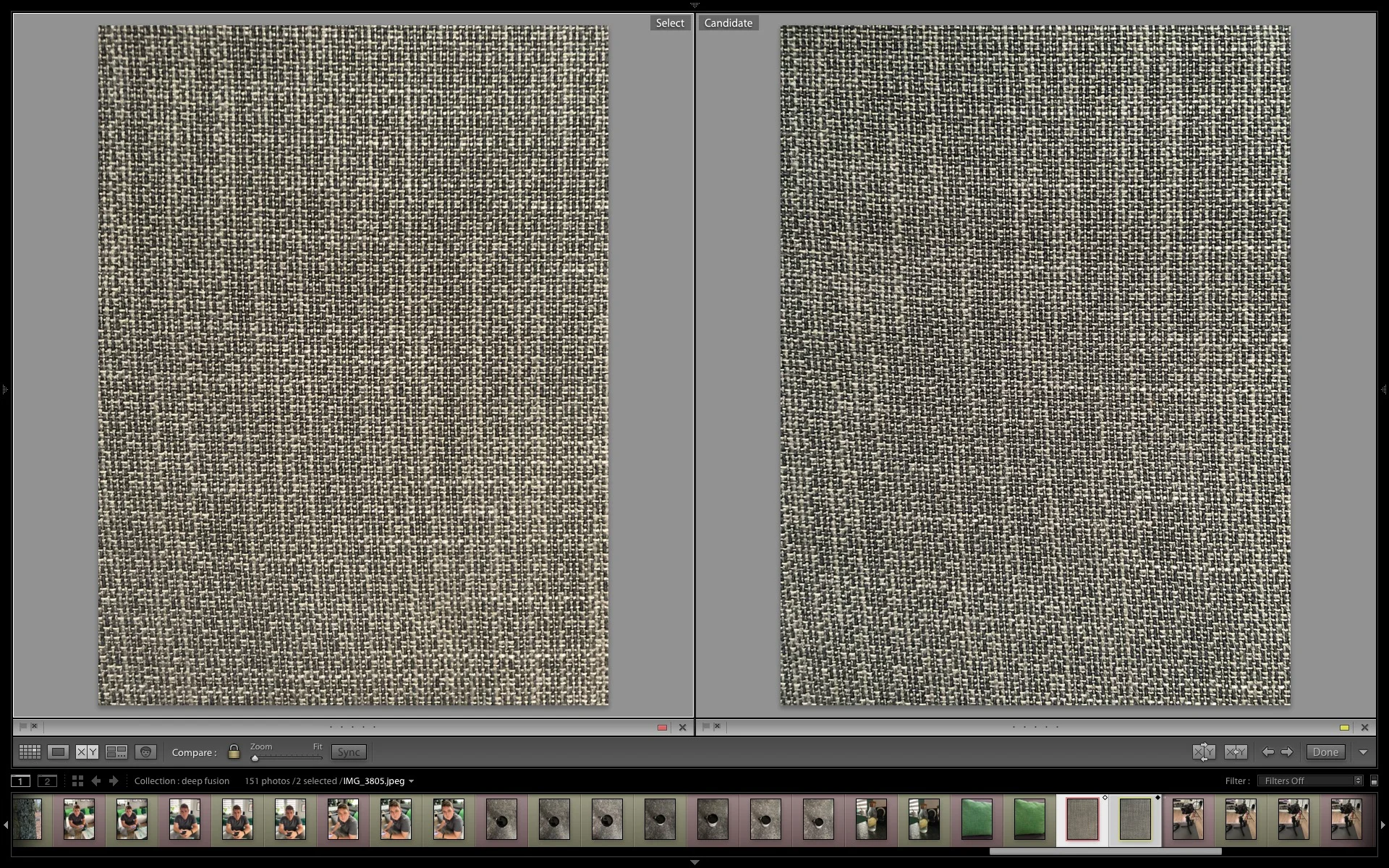

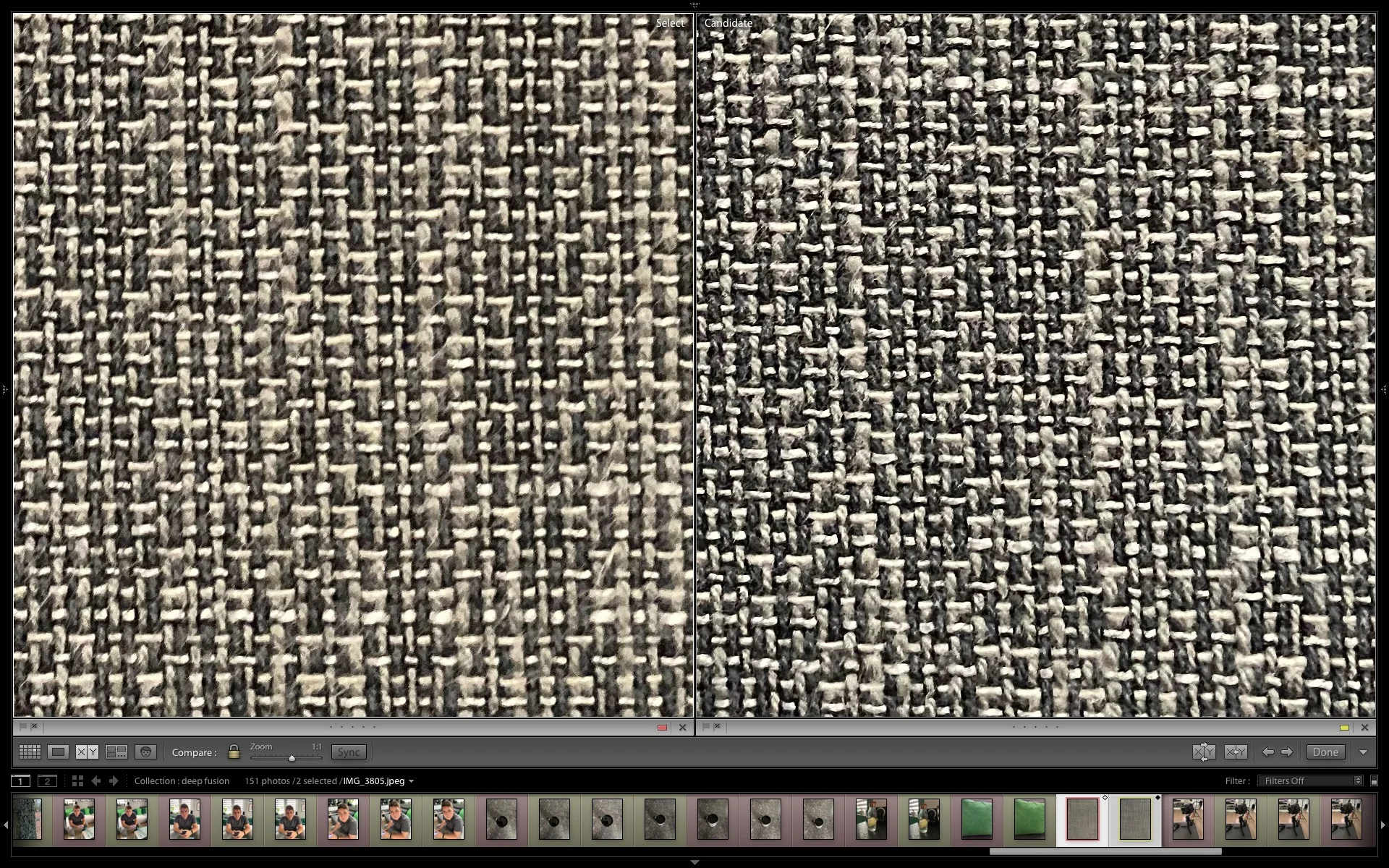

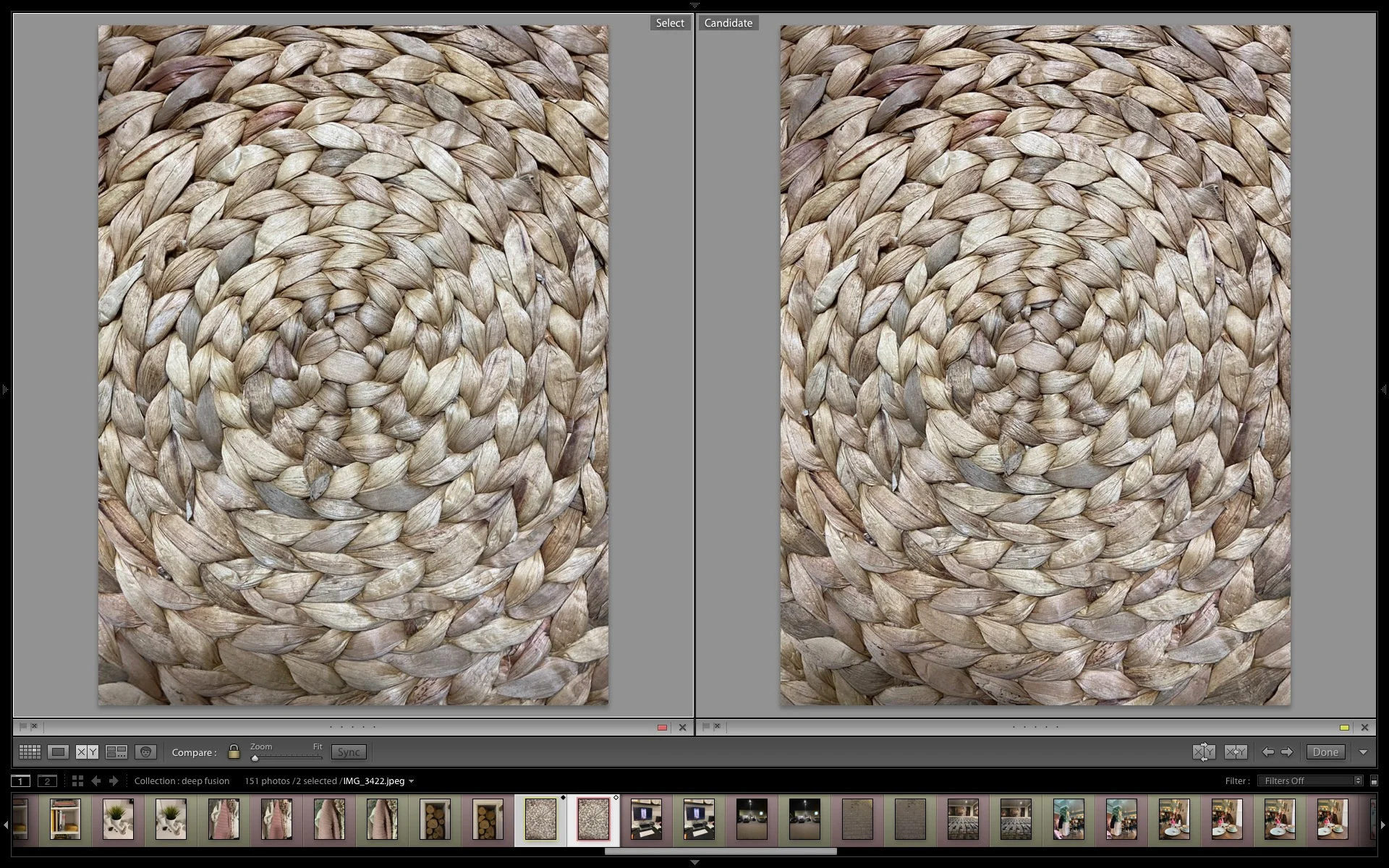

Działanie Deep Fusion najlepiej widać na tkaninach.

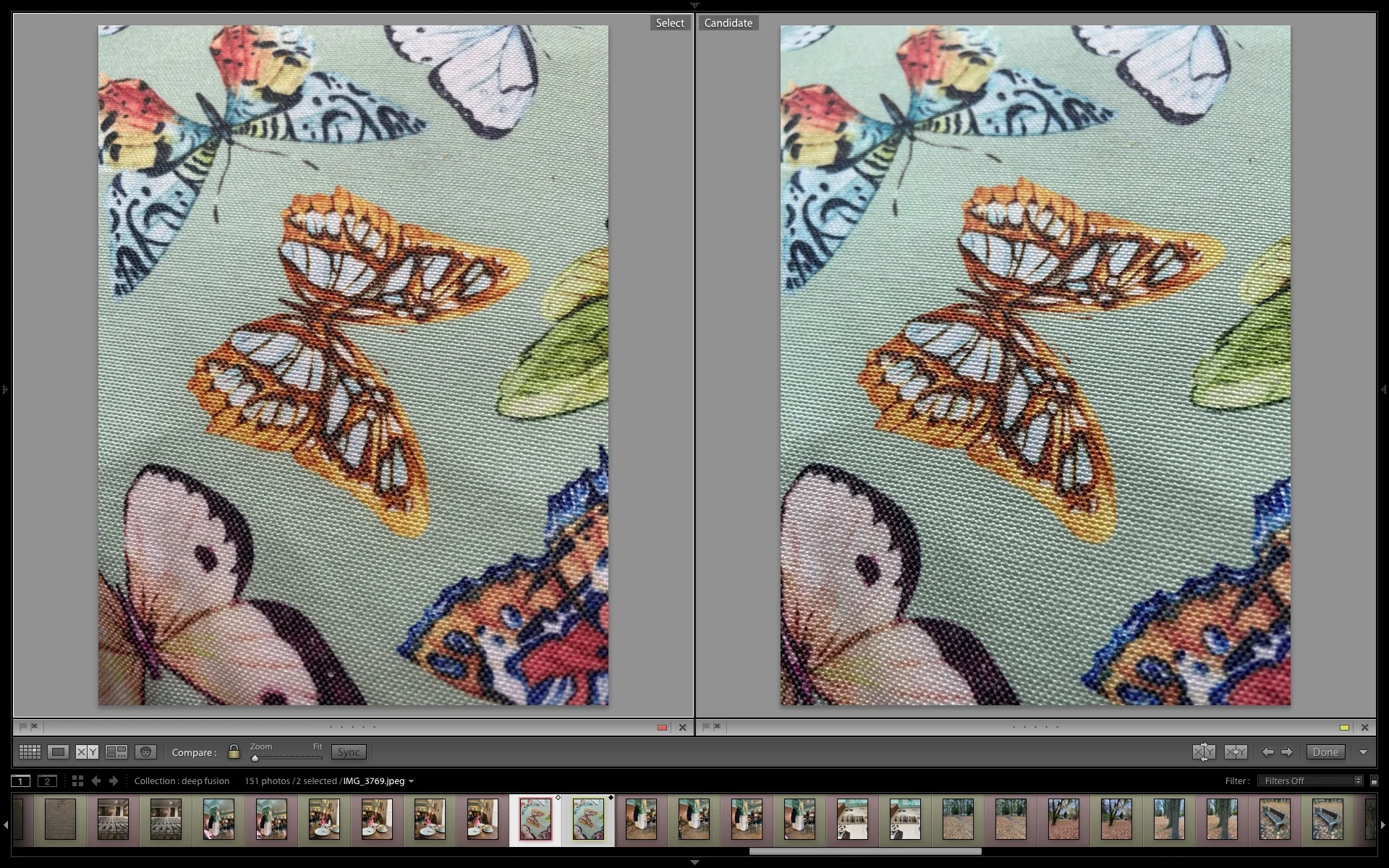

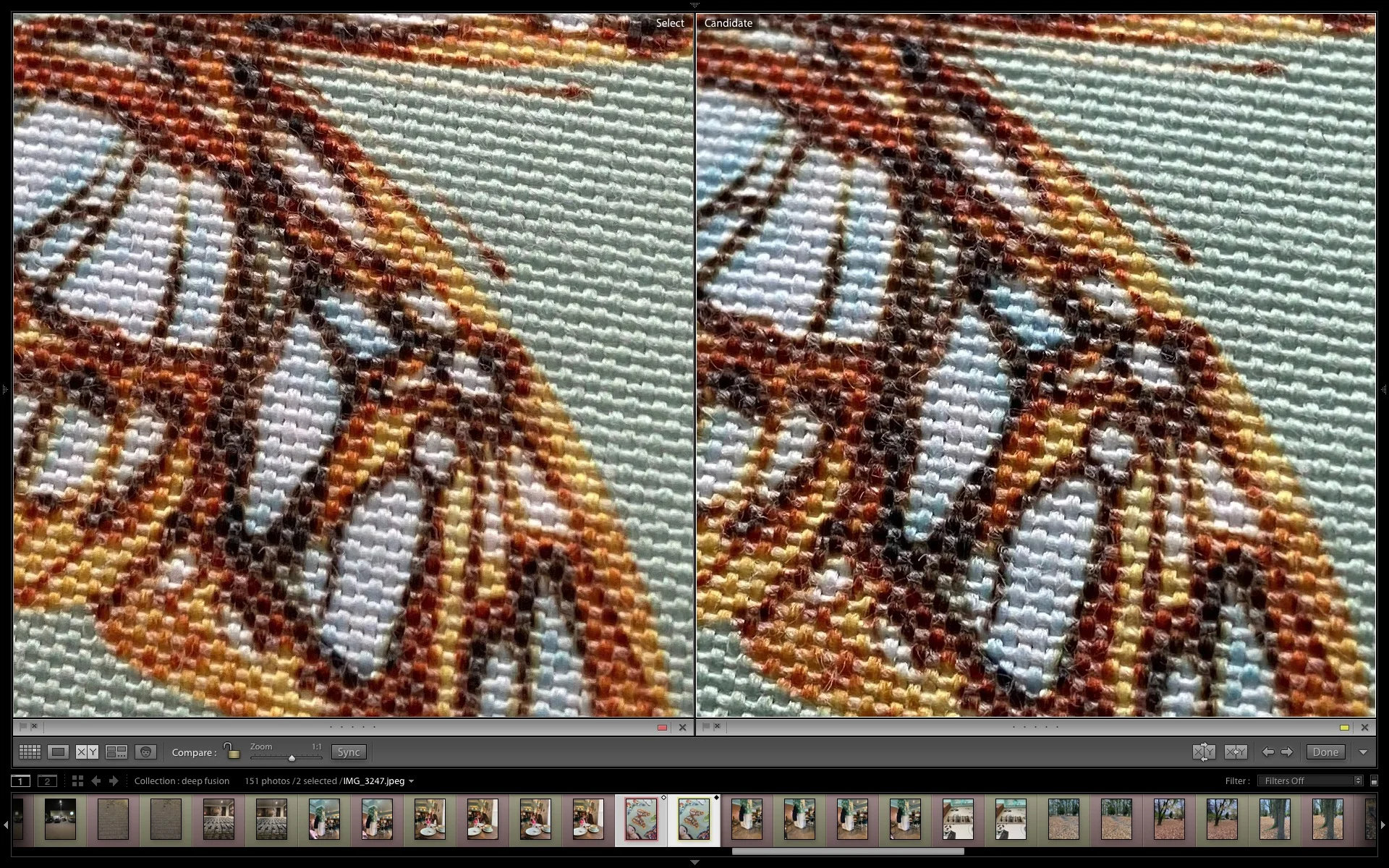

Działanie Deep Fusion dobrze widać też na tkaninach. Nie bez powodu Apple pokazywało działanie tego trybu na zdjęciach osób ubranych w swetry. Drobne detale są widoczne lepiej, a do tego balans bieli wypada naturalniej i jest bardziej zbliżony do faktycznej sceny.

Poniżej jeszcze kilka przykładów zdjęć tkanin i drobnych splotów.

Ponownie widać różnice w ostrości i mikrokontraście na korzyść Deep Fusion.

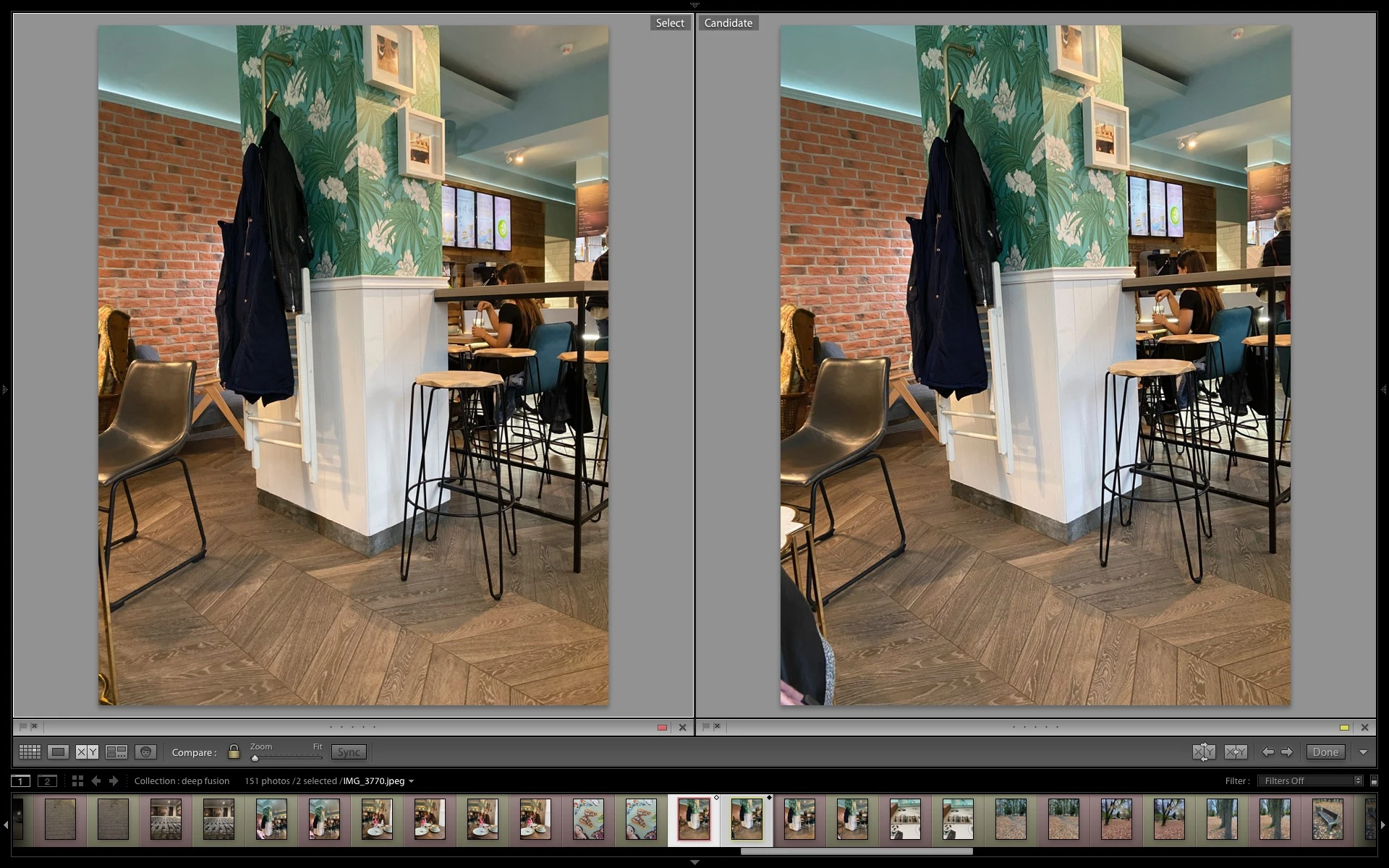

Na ogół działania Deep Fusion trzeba się doszukiwać z lupą.

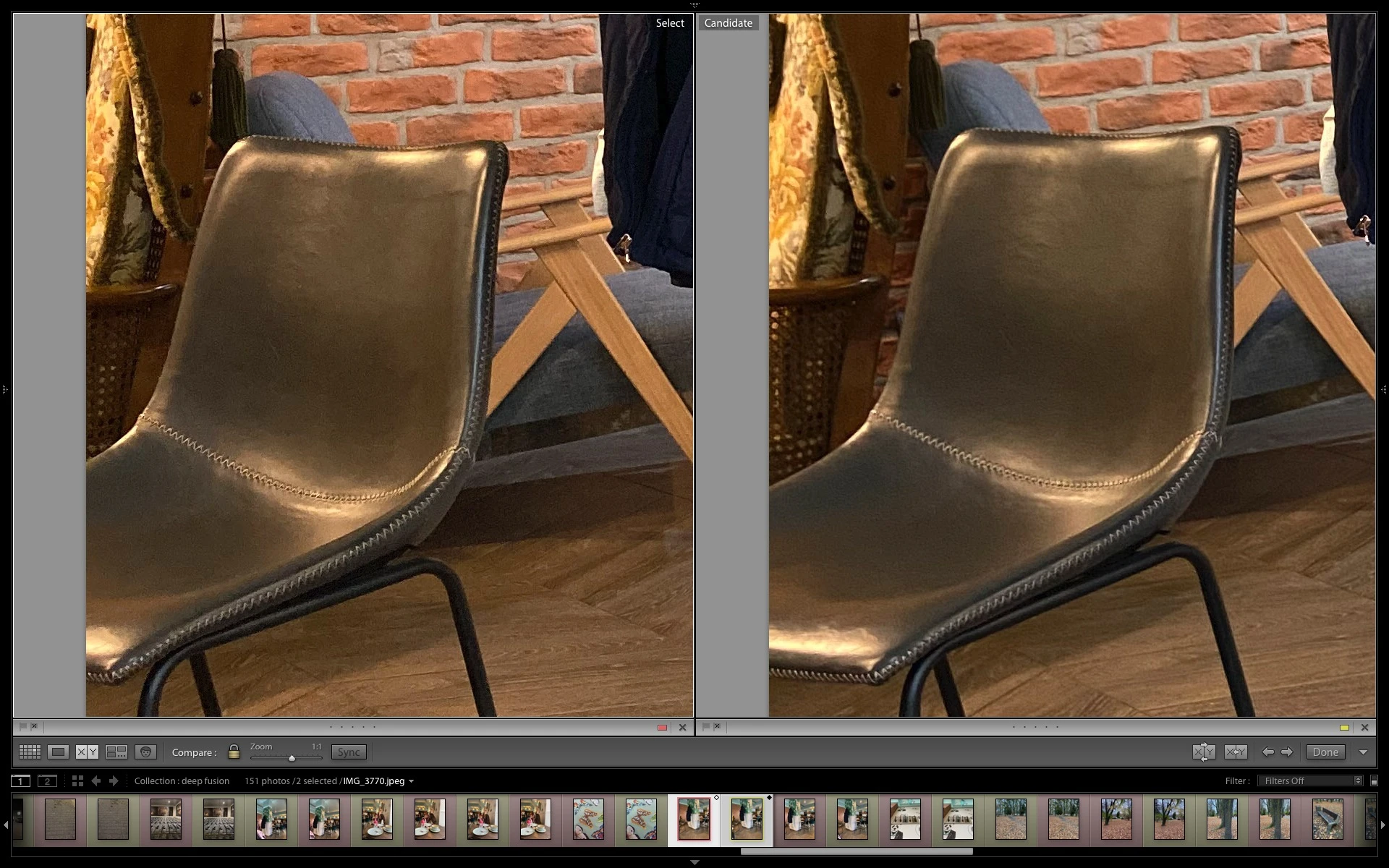

Zdjęcia z kawiarni dokładnie obrazują działanie Deep Fusion w praktyce. Jeśli wytężymy wzrok, zobaczymy pewne drobne różnice między zdjęciami, ale czy to na pewno działanie algorytmu? Czy może to efekt mniej poruszonego zdjęcia? A może jakaś drobna różnica w przetwarzaniu fotografii? Te pytania towarzyszyły mi cały czas przy testowaniu Deep Fusion, co dobitnie pokazuje, że funkcja nie jest żadną rewolucją.

Czy widzicie różnice? Podpowiem: krzesło ma delikatnie mocniej zaznaczoną fakturę, a na białym drewnie na filarze mocniej widać poziome kreski. Wiele osób nawet nie zobaczyłoby tak delikatnych różnic.

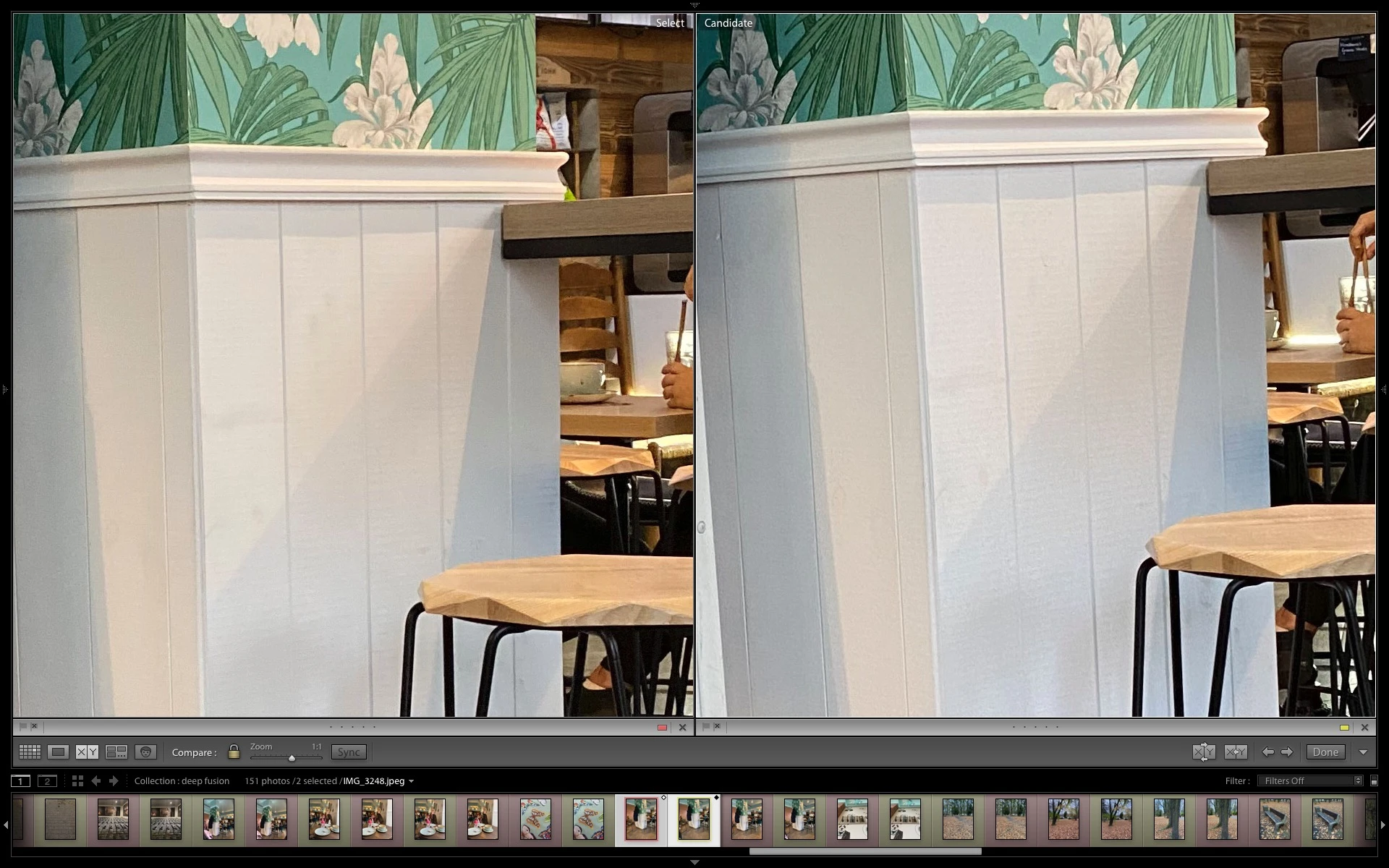

Kolejny wątpliwy przykład to scenka z przedmiotami. W zdjęciu z Deep Fusion lepiej widać delikatną fakturę na ścianie. Tylko czy to efekt działania Deep Fusion? A może nieco inaczej rozłożona ostrość?

Podsumowując: z dużej chmury mały deszcz…

Apple zapowiadał Deep Fusion jako rewolucję. Widząc przykładowe kadry od producenta sam uwierzyłem, że szykuje się rewolucja. Smartfony - nawet te topowe - cały czas bardzo mocno odstają od dedykowanych aparatów właśnie w kwestii detali. Po powiększeniu obrazu od razu widać, które zdjęcie pochodzi z dużego aparatu, a które z iPhone’a.

Deep Fusion nie wprowadza żadnej rewolucji, która mogłaby zmniejszyć dystans do aparatów. Nadal powiększone zdjęcia z iPhone’a przypominają papkę, w której brakuje prawdziwych detali, a widać tylko sztuczne odszumianie przeplatane z równie sztucznym wyostrzaniem.

Jestem zawiedzony trybem Deep Fusion. W wielu przypadkach różnic praktycznie nie ma, a na ogół są one aptekarskie. Aby je wychwycić trzeba dokładnie oglądać kadr na powiększeniu 100, lub nawet 200 proc. Miała być rewolucja, a w praktyce widzimy bardzo delikatną ewolucję. W praktyce większy wpływ na strukturę i mikrokontrasty na zdjęciu ma suwak Texture w nowym Lightroomie.

Mam nadzieję, że to nie jest jeszcze ostatnie słowo, a Deep Fusion będzie rozwijane i ulepszane. Pomijając jednak nowy algorytm, muszę podkreślić, że aparat iPhone'a 11 to klasa sama w sobie. Uwielbiam nim fotografować, a efekty jakie uzyskuję w trybie portretowym (i to bez teleobiektywu!) są najlepsze na całym rynku mobilnym. Nawet bez Deep Fusion aparaty iPhone'ów 11 są rewelacyjne, choć szkoda, że nie stały się jeszcze lepsze, zwłaszcza po tym, jak Apple rozpaliło oczekiwania użytkowników.

W takim razie Deep Fusion czy automatyczne robienie zdjęć dwoma obiektywami?

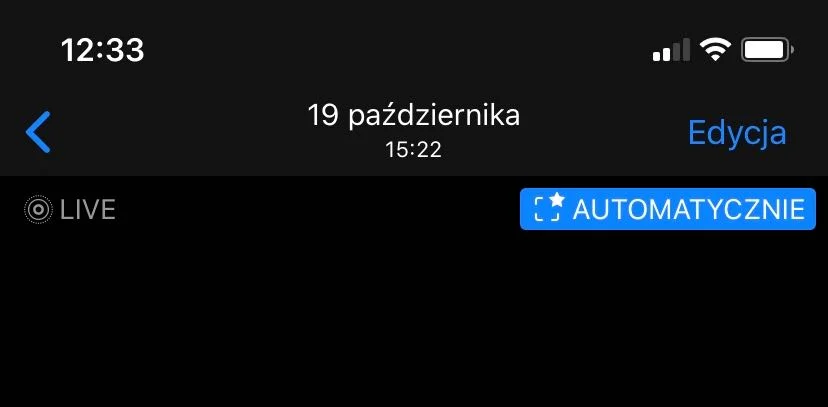

Apple każe wybierać. Włączona funkcja „Rejestruj obszar poza kadrem zdjęcia” dezaktywuje Deep Fusion. Dużym minusem jest fakt, że aplikacja aparatu ani menu ustawień nie informuje o tym fakcie. Moim zdaniem na ten moment lepiej sprawdza się funkcja „Rejestruj obszar poza kadrem zdjęcia”. Podam przykład: niedawno robiłem zdjęcie żony i córki w restauracji. Skorzystałem z bazowego obiektywu, a na zdjęciu żona miała lekko ucięty łokieć. Kiedy otworzyłem galerię, zobaczyłem zdjęcie, na którym łokieć jest cały, a u góry pojawił się niebieski przycisk z symbolem kadru i napisem "Automatycznie".

iPhone zarejestrował naraz dwa ujęcia: z bazowego i z ultraszerokokątnego obiektywu. Oprogramowanie samo wykryło, że łokieć portretowanej osoby jest ucięty, więc poszerzyło kadr bazując na zdjęciu z ultraszerokiego kąta. Wszystko to bez pogorszenia jakości zdjęcia. Po kliknięciu niebieskiego przycisku zdjęcie wróciło do pierwotnego kadru z uciętym łokciem. Aby taka funkcja była możliwa, w ustawieniach aparatu trzeba włączyć opcję „Rejestruj obszar poza kadrem zdjęcia”, a następnie włączyć „Automatyczne stosowanie korekt”.

Takie drobnostki stanowią o sile aparatu iPhone'a 11. Ten mechanizm działa rzadko, ale bardzo skutecznie, dzięki czemu daje dużo więcej korzyści niż dość przeciętne Deep Fusion. Nie trzeba się też obawiać danych z dodatkowego aparatu, bo jeśli z nich nie skorzystamy, są one usuwane po 30 dniach. Szkoda, że Apple nie pozwala na stosowanie Deep Fusion w połączeniu z tym mechanizmem. Jeszcze większa szkoda, że nie informuje o wyłączeniu Deep Fusion, kiedy mamy włączone rejestrowanie obszaru poza kadrem zdjęcia.