Algorytmy na całym świecie działają w służbie dyskryminacji

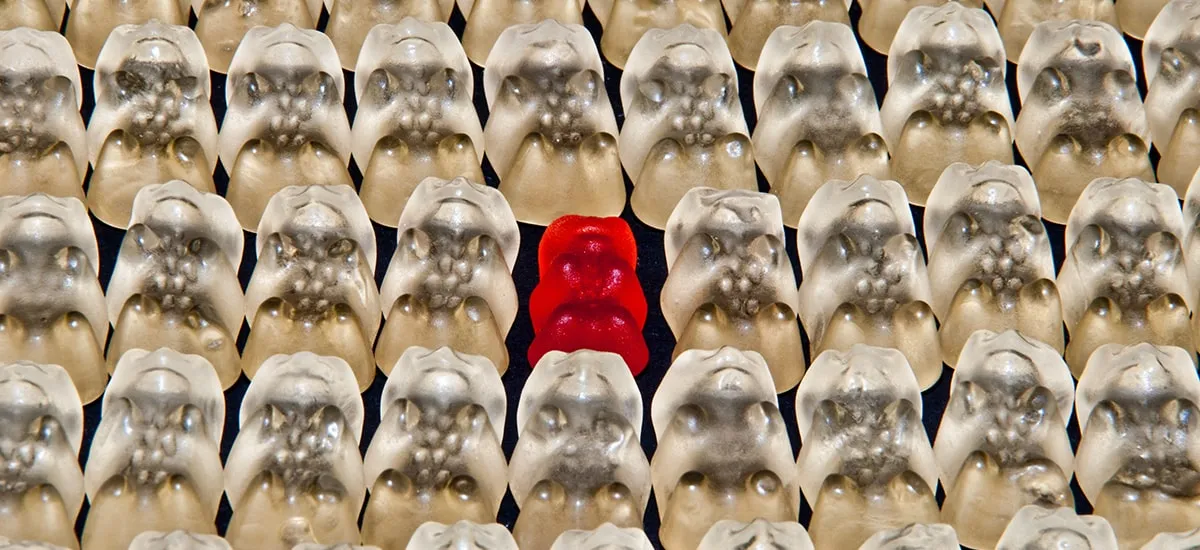

Potencjalne nadużycia są wpisane w technologie. Kusi się nas obietnicą bezpieczeństwa lub większej wygody. Tym łatwiej na nią przystać, że koszt często ponosi kto inny, jakaś grupa, która i tak jest już dyskryminowana. Ujgurowie, muzułmanie, czarni, kobiety. To się dzieje na całym świecie od Chin po Stany Zjednoczone.

Nie musisz się już bać. Nasz system rozpoznawania twarzy zidentyfikuje Ujgura, Tybetańczyka lub innego przedstawiciela podejrzanej grupy. Będzie mu się bacznie przyglądał. Nagra jego poczynania. Sprawdzi, skąd przyszedł i gdzie poszedł. Jeśli okaże się, że w okolicy pojawiło się ich więcej, wyśle sygnał alarmowy do przedstawicieli prawa. Ci przyjadą i opanują sytuację.

Tak reklamuje się na swojej stronie chiński startup CloudWalk. Daje chińskim obywatelom bezpieczeństwo i ochronę przed podejrzanymi grupami. Automatyzuje rasizm.

Ujgurzy na celowniku kamer Chińskiej Republiki Ludowej.

Ujgurzy to mniejszość w większości muzułmańska. Szacuje się, że w Chinach jest ich około 11 milionów. Mieszkają przede wszystkim w Regionie Autonomicznym Sinciang-Ujgur. To tam mieszczą się obozy, w których Ujgurzy są zamykani na tygodnie lub miesiące i poddawani indoktrynacji. Słuchają pogadanek o jedynej słusznej słuszności, jedynej słusznej partii, śpiewają hymny na jej cześć i piszą krytyczne eseje, w których analizują własne winy. W tym tę największą. Wyznawanie islamu. Do obozu można trafić za recytowanie Koranu na pogrzebie.

Chiny zaprzeczają, że są to obozy reedukacyjne. Oficjele mówią raczej o instytucjach korekcyjnych, które mają zapobiegać rozprzestrzenianiu się ekstremizmów i oferować szkolenia zawodowe. Relacje świadków przeczą tym deklaracjom.

Ujgurzy mają nieco inne rysy niż większość chińczyków Han i bliżej im wyglądem do mieszkańców Azji Centralnej, to znacząco ułatwia ich rozpoznanie. Jak donosi The New York Times, władze Państwa Środka stosują zaawansowany system rozpoznawania twarzy, który ma na celu śledzenie Ujgurów. Eksperci biją na alarm. Państwo wykorzystuje na wielką skalę najnowsze zdobycze cywilizacji, żeby namierzać obywateli należących do wybranej mniejszości, monitorować ich zachowanie i sprawować nad nimi ścisłą kontrolę. Część świadków donosi, że kamery są montowane nawet w prywatnych domach.

Raz, dwa, trzy Xi Jinping patrzy.

Chiński rząd nie boi się nadmiernego monitoringu. Sieć kamer oplata coraz ciaśniej kraj. Nigdy niemęczące się oczy soczewek skanują ulice, przejścia dla pieszych, bazary. Poszukują twarzy, których cechy charakterystyczne są w stanie rozpoznać. Szukają Ujgurów. Większa część systemu kamer wyposażonego w system rozpoznawania mniejszości znajduje się w zachodniej Sinciang, ale rząd powoli obejmuje akcją także największe miasta na wschodzie Chin.

Technologia nie jest jeszcze na tyle zaawansowana, by polegać na niej w pełni. Nie wszystkie kamery są dość dobrej jakości, systemy nie działają poprawnie w złych warunkach oświetleniowych. Są omylne, ale to nie przeszkadza w ubieganiu się o nie. NYT dotarł do dokumentów, z których wynika, że na początku 2018 r. ponad dwa tuziny jednostek policyjnych w całych Chinach ubiegało się o dostęp do tej technologii. Chiny wykorzystują system rozpoznawania twarzy jak broń, której optyczne ostrze jest skierowane przeciwko zamieszkującej państwo mniejszości.

Śledzona i znajdująca się na celowniku władz mniejszość, nie może czuć się bezpiecznie. Nie tylko w Chinach.

Czy policjanci śnią o raporcie mniejszości?

Czerwony punkt, gorąca strefa, miejsce zagrożenia. Jak zwał, tak zwał, ważne, że daje jasną informację. Predpol pokazuje miejsca, w których w ciągu 12 godzin prawdopodobnie zostanie popełnione przestępstwo. Wysyła się tam policyjne patrole. Inny program pozwala zrobić listę potencjalnych recydywistów. Osoby oznaczone jako potencjalnie niebezpieczne są uważnie monitorowane. Policja ma je na oku.

Prewencja na podstawie rozwiązań technologicznych staje się coraz popularniejsza. W końcu, kto nie chciałby, żeby przestępstwa były raczej powstrzymywane niż ścigane? To obiecują współczesne aplikacje asystujące policji. Skuteczność służb i bezpieczeństwo dla obywateli. Problem polega na tym, że mało kto sprawdza, w jakim stopniu, i czy w ogóle, tej obietnicy dotrzymują.

Szef LAPD Michel Moore ogłosił w zeszłym tygodniu, że kończy program mający na celu identyfikowanie i monitorowanie przestępców. Inne zostaną, ale ich działanie będzie lepiej monitorowane. To wynik opublikowane w zeszłym miesiącu raportu, który brał pod lupę wykorzystywane przez policję w Los Angeles systemy prewencyjne.

Samospełniająca się przepowiednia ma świetne wyniki.

Z raportu wynika, że wycofany system cierpiał na podstawowe błędy. Kryteria, które miały określać, kto zostaje uznany za potencjalnie niebezpiecznego, były niespójne i przez to dawały trudne do oceny wyniki. W przeprowadzanej przez inspektora generalnego policji ewaluacji programu okazało się, że aż 44 proc. osób oznaczonych jako potencjalni recydywiści albo nigdy nie aresztowano za przestępstwo z użyciem przemocy, albo były aresztowane za nie jeden raz. Do tego wiele osób na liście znalazło się z rekomendacji mundurowego, a nie dzięki wyliczeniom algorytmów. Po prostu policjant czy detektyw uznawał, że ktoś powinien na taką listę trafić i go na nią wciągał, a to już rodzi pole do nadużyć.

Jeśli chodzi o Predpol, to efekty pracy tego programu są według raportu zadowalające. Wykrywalność przestępstw w wyznaczonych przez algorytm miejscach jest większa. I pewnie można by to uznać za sukces, gdyby nie zdrowy rozsądek. Jeśli wysyłasz w jedno miejsce więcej patroli niż gdzie indziej, to szansa na odnotowania tam większej liczby przestępstw rośnie. Gdzie nie ma patroli, tam nie ma kto odnotowywać.

Problematyczne jest to, że w praktyce te programy powielają uprzedzenia rasowe. Punkty zapalne wskazywane są zwykle w uboższych dzielnicach zamieszkanych przez mniejszości czarnoskóre i latynoskie. Pojawia się tam więcej patroli. Więcej patroli wyłapuje więcej potencjalnych przestępców. Koło się zamyka. W ramach Predpol można dodać różnego rodzaju zbrodnie. Palenie zioła, zakłócanie spokoju, szwendanie się po ulicy w stanie dalekim od trzeźwości.

Co gorsza, policjanci jadący do dzielnicy często określanej jako niebezpieczna nawet przez teoretycznie obiektywne i nieuprzedzone algorytmy, utwierdzają w swoich uprzedzeniach. Amerykańska policja znana jest nie tylko z wieloletnich problemów z profilowaniem rasowym, w którym dane uzasadniały zachowania rasistowskie (nadal masz większą szansę zostać zatrzymanym przez patrol drogowy, jeśli jesteś czarny), ale też z nadmiernej skłonności do stosowania przemocy i zbyt szybkiego sięgania po broń.

Utwierdzanie funkcjonariuszy w przekonaniu, że tych czarnych trzeba bardziej kontrolować, utrwala systemowo uprzedzenia.

Dyskryminacja wpisane w dane wejściowe staje się dyskryminacją wpisaną w system. Wiedzą o tym nie tylko państwa i miasta, ale też prywatne firmy.

Algorytmy Amazonu nie chcą kobiet.

Amazon wycofał się w zeszłym roku z korzystania z rozwijanego od 2014 r. programu, który pomagał działowi HR w rekrutacji. Program spełniał swoje zadanie aż za dobrze. Wyeliminowanie z procesu połowy ludzkości niewątpliwie ułatwia pracę i ogranicza problem zbyt dużego stosu CV do przejrzenia.

Idea była prosta. Narzędzie miało wytypować pięć najlepszych zgłoszeń spośród wszystkich nadesłanych na dane stanowisko. Wyboru dokonywało na podstawie danych pracowników Amazonu. W końcu dział HR wiedział, kto w ciągu kilkunastu lat dostał daną pracę i sprawdził się na stanowisku. To, co wygląda na rozsądną taktykę, cementowało istniejące nierówności. Algorytm nauczył się, że najlepsi kandydaci mają udokumentowane doświadczenie w branży, kilka dużych projektów za pasem i penisa.

Jak donosił Reuters, Amazon od 2015 r. wiedział, że algorytm w rekrutacji kieruje się zasadą panowie na prawo, panie do kosza. Firma próbowała najpierw naprawić algorytm i ograniczyć poleganie na nim, ale zrezygnowała z niego dopiero w 2018 r. Do tej pory nie wiadomo, jakiej skomplikowanej metodologii użył dział HR, żeby podważyć wyroki algorytmu i przekonać zwierzchników do porzucenia go. Podejrzewa się, że przeprowadził badania obserwacyjne i zauważył, że większość pracowników do kodowania wykorzystuje jednak palce.

Potrzebujemy regulacji, nie możemy sobie pozwolić na czekanie aż zdarzy się katastrofa.

Na początku kwietnia badacze technologii rozpoznawania twarzy wysłali do Amazonu list otwarty. Chcą, żeby firma Jeffa Bazosa przestała sprzedawać policji swój system rozpoznawania twarzy, bo jest on po prostu podatny na błędy. I to błędy, które utrwalają dyskryminację ze względu na płeć i rasę. Grupa udziałowców Amazonu chce, żeby firma przestała sprzedawać narzędzia rozpoznawania twarzy, dopóki nie zostanie potwierdzone, że nie przyczynia się ona do pogwałcenia praw człowieka. Nad sprawą akcjonariusze będą głosować w przyszłym miesiącu.

To tylko ruch symboliczny. Zarząd zaleca głosowanie przeciwko temu rozporządzeniu, ale nawet jeśli większość udziałowców zdecyduje się zrobić utrudnić życie zarządowi, niewiele się zmieni. Takie rozporządzenie ma moc doradczą i raczej nie zostaną wysłuchane.

Problem polega na tym, że system Amazonu całkiem nieźle radzi sobie z rozpoznawaniem białych mężczyzn, ale gdy idzie o rozpoznawanie kobiet lub osób o ciemniejszych odcieniach skóry, zaczyna się gubić. Algorytm powtarza po prostu istniejące w danych nierówności. Tworzone na zachodzie systemy rozpoznawania twarzy najlepiej radzą sobie z białymi mężczyznami, zaś te tworzone na wschodzie przodują w rozpoznawaniu Azjatów.

Amazon zaczyna przebąkiwać o potrzebie uregulowania wykorzystania z rozwiązań rozpoznawania twarzy. Microsoft wzywa ustawodawców do pochylenia się nad problemem. Google nie sprzedaje takiego oprogramowania, choć je rozwija. Wszyscy są w zawieszeniu i czekają co dalej. Problem polega na tym, że na to pytanie swoją odpowiedź mają już chociażby Chiny.

Jeśli technologia może zostać nadużyta, to nadużyta zostanie.

Wszystko sprowadza się do buchalteryjnego podliczenia zysków, strat, ewentualnych szans i potencjalnych zagrożeń. Trzeba wziąć pod uwagę nieustanny wyścig zbrojeń. Jeśli my czegoś nie zrobimy, to nie znaczy, że nie zrobi tego kto inny. Musimy obserwować, zbierać dane, wyciągać wnioski i aktywnie poszukiwać niebezpieczeństw związanych z rozwojem technologii. Chiny nie mogą pozostawać dla nas opowiastką o złym dystopijnym państwie, na które możemy patrzeć z wydm wyższości moralnej. Musimy się do jego problemów odnieść realnie, bo są nam bliższe, niż mogłoby się wydawać.