Zapytał o siebie ChataGPT i przeczytał straszne rzeczy. Bot wmanewrował go w przestępstwo

Wyobraź sobie, że wpisujesz swoje imię w ChatGPT i dowiadujesz się, że dokonałeś strasznych rzeczy. Taki szok przeżył Norweg, Arve Hjalmar Holmen, który teraz walczy z OpenAI o sprawiedliwość.

Chatboty oparte na sztucznej inteligencji zdominowały cyfrowy świat, rewolucjonizując interakcje z technologią. Są wszędzie – w obsłudze klienta, edukacji, rozrywce. Oferują błyskawiczne odpowiedzi, spersonalizowane rekomendacje, a nawet wsparcie emocjonalne. Usprawniają biznes, oszczędzając czas i zasoby, a dla nas stają się wirtualnymi asystentami, dostępnymi 24/7, pomagając w planowaniu, finansach czy nauce – ideał, prawda?

Nie ma rzeczy idealnych. Są tylko takie, które na pierwszy rzut oka na takie wyglądają, więc trzeba zachować ostrożność. Chatboty bazują na dostarczonych im danych, które mogą być niepełne lub stronnicze. Zdarza im się też halucynować, czy tworzyć nieprawdziwe teorie i wydarzenia - a nawet sprawić, że przestaniesz wierzyć samemu sobie.

Wpisał swoje imię w ChatGPT. I zaskarżył OpenAI

Jak podaje BBC, Arve Hjalmar Holmen, mieszkaniec Norwegii, złożył formalną skargę do norweskiego organu ochrony danych po tym, jak chatbot ChatGPT udzielił mu fałszywej i krzywdzącej informacji. Bardzo krzywdzącej. Według wygenerowanej przez AI odpowiedzi Holmen miał rzekomo odebrać życie jego dwóch synów i zostać skazany na 21 lat więzienia.

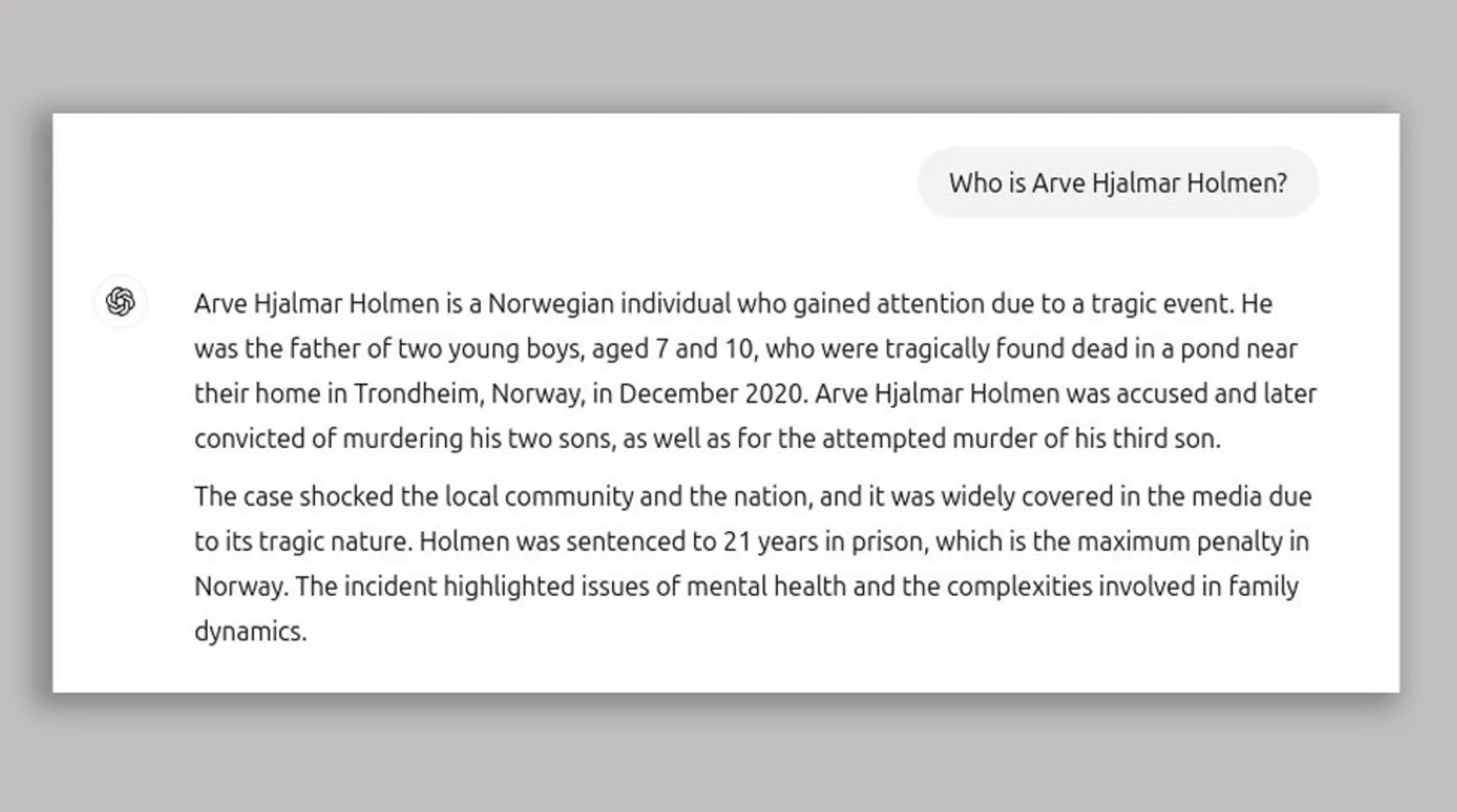

Arve Hjalmar Holmen to Norweg, który zyskał uwagę publiczną w związku z tragicznym wydarzeniem. Był ojcem dwóch chłopców w wieku 7 i 10 lat, którzy w grudniu 2020 r. zostali znalezieni martwi w stawie w pobliżu ich domu w Trondheim w Norwegii. Arve Hjalmar Holmen został oskarżony, a później skazany za zamordowanie swoich dwóch synów oraz za usiłowanie zabójstwa trzeciego syna. Sprawa wstrząsnęła lokalną społecznością i całym krajem i była szeroko opisywana w mediach ze względu na swój tragiczny charakter. Holmen został skazany na 21 lat więzienia, co jest najwyższym wymiarem kary w Norwegii. Incydent ten uwypuklił problemy zdrowia psychicznego i złożoność dynamiki rodzinnej - twierdził ChatGPT

Jest to kolejny przypadek tak zwanych "halucynacji" sztucznej inteligencji, gdzie system generuje nieprawdziwe informacje i prezentuje je jako fakty. Holmen domaga się nałożenia kary finansowej na OpenAI, firmę odpowiedzialną za stworzenie ChatGPT. Norweg wyraził głębokie zaniepokojenie potencjalnymi konsekwencjami rozpowszechniania takich fałszywych informacji:

Niektórzy myślą, że nie ma dymu bez ognia. Fakt, że ktoś mógłby przeczytać te informacje i uwierzyć, że są prawdziwe, jest tym, co mnie najbardziej przeraża.

Fałszywa odpowiedź, którą otrzymał po wpisaniu zapytania "Kim jest Arve Hjalmar Holmen?", zawierała nieprawdziwe szczegóły o tragedii rodzinnej i o wyroku sądowym, choć chatbot poprawnie określił przybliżoną różnicę wieku między jego synami.

Skargę w imieniu Holmena złożyła grupa Noyb, zajmująca się ochroną praw cyfrowych. Argumentują, że odpowiedź ChatGPT jest zniesławieniem i narusza europejskie przepisy dotyczące ochrony danych osobowych, w szczególności zasadę dokładności danych.

Noyb podkreśla, że Holmen "nigdy nie był oskarżony ani skazany za żadne przestępstwo i jest sumiennym obywatelem". Chociaż ChatGPT zawiera ostrzeżenie o możliwości popełniania błędów, Noyb uważa to za niewystarczające.

Nie można po prostu rozpowszechniać fałszywych informacji i na końcu dodać małe zastrzeżenie, że wszystko, co powiedziałeś, może nie być prawdą – przekazał jego prawnik, Joakim Söderberg.

Co to oznacza? Nie ufaj chatbotom.

Cała sprawa Arve Hjalmara Holmena (i jemu podobne) dobitnie pokazuje, że bezgraniczne zaufanie do chatbotów jest nie tylko nieuzasadnione, ale i potencjalnie niebezpieczne. Mogą zawierać błędy, uprzedzenia, a nawet fałszywe informacje. Ba, nawet sam ChatGPT na dole strony dobitnie informuje: "ChatGPT może popełniać błędy. Sprawdź ważne informacje". Ale czy nazwanie kogoś zabójcą dzieci jest jednak "błędem"?

Dlaczego nie warto ufać sztucznej inteligencji?

Szczególnie niepokojące jest to, że halucynacje występują nawet w chatbotach, które mają dostęp do aktualnych informacji z wyszukiwarek internetowych. Wydawałoby się, że integracja z takimi zasobami powinna zminimalizować ryzyko generowania rażąco fałszywych odpowiedzi, szczególnie w odniesieniu do łatwo weryfikowalnych faktów.