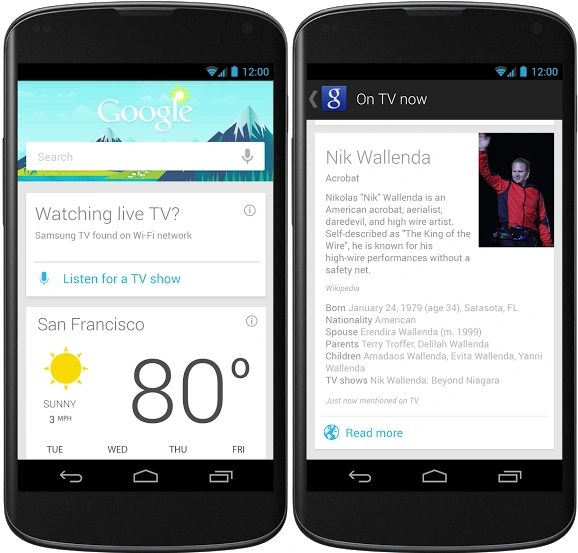

Z Google Now porozmawiasz teraz w różnych językach jednocześnie

Google Now niedługo otrzyma nową funkcję, jaką jest możliwość rozpoznawania dwóch języków jednocześnie. Dziwi mnie, że gigant z Mountain View dopiero teraz zaimplementował taką, wydawałoby się, oczywistą funkcję.

Rozwój asystentów głosowych w smartfonach w ostatnich latach przyspieszył. Kiedyś obsługa głosem telefonów sprowadzała się do reakcji na predefiniowane komendy. Z reguły zresztą, zwłaszcza w przypadku języka polskiego, starsze telefony sprzed rewolucji smartfonowej na pytanie “która godzina” odpowiadały tylko w dwóch na trzech przypadkach, by przy trzeciej próbie wykonać telefon do losowo wybranego kontaktu ze skrzynki adresowej. O tym, że przy próbie wybrania numeru skuteczność rozpoznawania mowy była jeszcze mniejsza, nawet nie wspominam.

Rozpoznawanie mowy to zresztą nadal problem, zwłaszcza przy takich trudnych językach jak polski.

Nie wierzę, by obsługa urządzeń za pomocą głosu przebiła się u nas wcześniej niż za kilka-kilkanaście lat, ale użytkownicy w krajach anglojęzycznych mają większą szansę się do tego przekonać. Siri, Google Now i Cortana działają coraz sprawniej, oferują dostęp do olbrzymich zasobów wiedzy, a niedługo na dobre opuszczą telefony i zaczną życie w chmurze.

Zanim się obejrzymy, oprogramowanie, niczym system operacyjny znany z filmu Her, będzie z użytkownikiem zawsze i wszędzie, niezależnie od wykorzystywanego aktualnie terminala dostępowego do sieci.

Chociaż z perspektywy polskiego rynku wymienione wyżej usługi od Apple, Google i Microsoftu nadal pozostają raczej ciekawostką przyrodniczą, a nie faktycznie użytecznym gadżetem, to przyszłość zapowiada się naprawdę nieźle.Wszyscy trzej giganci pracują w pocie czoła nad tym, aby obsługa bezdotykowa urządzeń mobilnych była możliwie intuicyjna i prosta. Inwestują w rozpoznawanie mowy, przetwarzanie danych big data i łapanie przez oprogramowanie kontekstu. Wyraźny jest też trend dostarczania użytkownikowi danych jeszcze zanim posiadacz smartfona uświadomi sobie, że tych danych potrzebuje.

Może jestem przesadnym tradycjonalistą, ale wolę rozmawiać przez telefon, niż z telefonem.

W przypadku smartfonów nie jestem przekonany, czy faktycznie użytkownicy chcą i potrzebują takiego głosowego asystenta z prawdziwego zdarzenia. Duże ekrany dotykowe, czytelne ikony - obsługa smartfona nie jest dla mnie problematyczna. Zupełnie inaczej podchodzę do kwestii kategorii urządzeń typu wearables. Wszelkie opaski, zegarki i okulary, jeśli mają istnieć chociaż w części autonomicznie i uniezależnić się od telefonu w kieszeni, potrzebują zupełnie nowego mechanizmu interakcji z użytkownikiem.

W urządzeniach noszonych nie ma miejsca na duże ekrany dotykowe, które pozwalałyby na wygodne wprowadzanie tekstu. Nawigacja za pomocą gestów nie jest rozwiązaniem i może pozwolić na wykonanie tylko najbardziej podstawowych i predefiniowanych akcji. Jeśli asystent cyfrowy - niezależnie czy będzie to Siri, Google Now czy Cortana - ma rezydować w przyszłości na moim nadgarstku to kluczowe jest dopracowanie sposobu, w jaki maszyna komunikuje się z człowiekiem.

Obsługa głosem wydaje się najbardziej naturalną drogą rozwoju.

Tak jak współczesne syntezatory mowy radzą sobie już całkiem nieźle, tak rozpoznawanie go to nadal spory problem. Angielski jest jeszcze w miarę prostym językiem, ale np. język polski zaprogramować jest już znacznie trudniej. Gramatyka, wiele odmian tego samego słowa, liczne wyjątki i różnice w pisowni bez różnicy fonetycznej to problemy, które ciężko przeskoczyć, nawet dodając do tego analizę kontekstu wypowiedzi.

Cieszy jednak, że twórcy asystentów myślą globalnie, a Siri, Google Now i Cortana nie są wyłącznie oprogramowaniem dla anglojęzycznej części globu. Dowodem na to jest dodawanie kolejnych języków do bazy. Podoba mi się też ostatni ruch Google, ponieważ inżynierowie z Mountain View pomyśleli o scenariuszach wykorzystania Google Now poza warunkami laboratoryjnymi w prawdziwym świecie.

Od teraz Google Now będzie mogło rozmawiać z użytkownikiem w kilku językach jednocześnie.

Wprowadzanie tekstu na urządzeniach mobilnych bez konieczności ręcznego przełączania się między językami to jedna z funkcji, których naprawdę brakuje mi w systemie iOS. U Apple nadal muszę za każdym razem klikać na klawiaturze konkretny symbol, zanim będę mógł wpisać angielskie słowo - inaczej autokorekta będzie podpowiadać jakieś bzdury. Na Androidzie niektórzy producenci poradzili już sobie z tym problemem, a klawiatury w nakładkach potrafią rozpoznać, jeśli użytkownik zacznie pisać w innym języku w połowie zdania.

Niestety, ograniczenia klawiatur ekranowych, takie jak w iOS lub czystym Androidzie, przeniesione zostały w świat asystentów głosowych. Oprogramowanie to domyślnie komunikuje się tylko w jednym, predefiniowanym języku. To, jak zauważa Google, jest błędne założenie bo ponad połowa ludzi na świecie jest dwujęzyczna. Z tego powodu od teraz Google Now pozwoli użytkownikom na komunikację głosową z urządzeniem za pomocą kilku języków jednocześnie.

Wymaga to tylko jednorazowej zmiany w preferencjach.

Do tej pory w przypadku systemu Google zmiana języka wprowadzania tekstu wymagała grzebania w ustawieniach za każdym razem, co w codziennym użytkowaniu nie ma racji bytu. Od teraz użytkownik będzie mógł zdefiniować do pięciu języków, z których korzysta, a asystent głosowy sam wykryje, w którym z nich aktualnie użytkownik mówi.

Jak podaje Google w przykładzie, użytkownik smartfona może po angielsku wyszukać restauracje w okolicy, by później podyktować do telefonu tekst SMS-a już w swoim ojczystym języku - i to bez żadnego zbędnego klikania i wydawania komend. Jedynym ograniczeniem jest brak możliwości zmiany języka w połowie zdania, ale gigant z Mountain View sugeruje, że już pracuje nad rozwiązaniem tej niedogodności.

Nie pozostaje nam nic innego, jak czekać na to, żeby takie podejście stało się standardem wśród wszystkich firm pracujących nad asystentami głosowymi, a Polska stała się na tyle istotnym i liczącym się rynkiem, by zaprogramować obsługę naszego języka.

Grafika główna pochodzi z serwisu Shutterstock.