Microsoft szczerze: blokuje nas prąd, nie moc obliczeniowa

Microsoft ma dziś wystarczająco dużo chipów AI, by zasilić kolejny przełom w rozwoju sztucznej inteligencji - ale nie ma ich jak uruchomić. Bo koncernowi brakuje prądu.

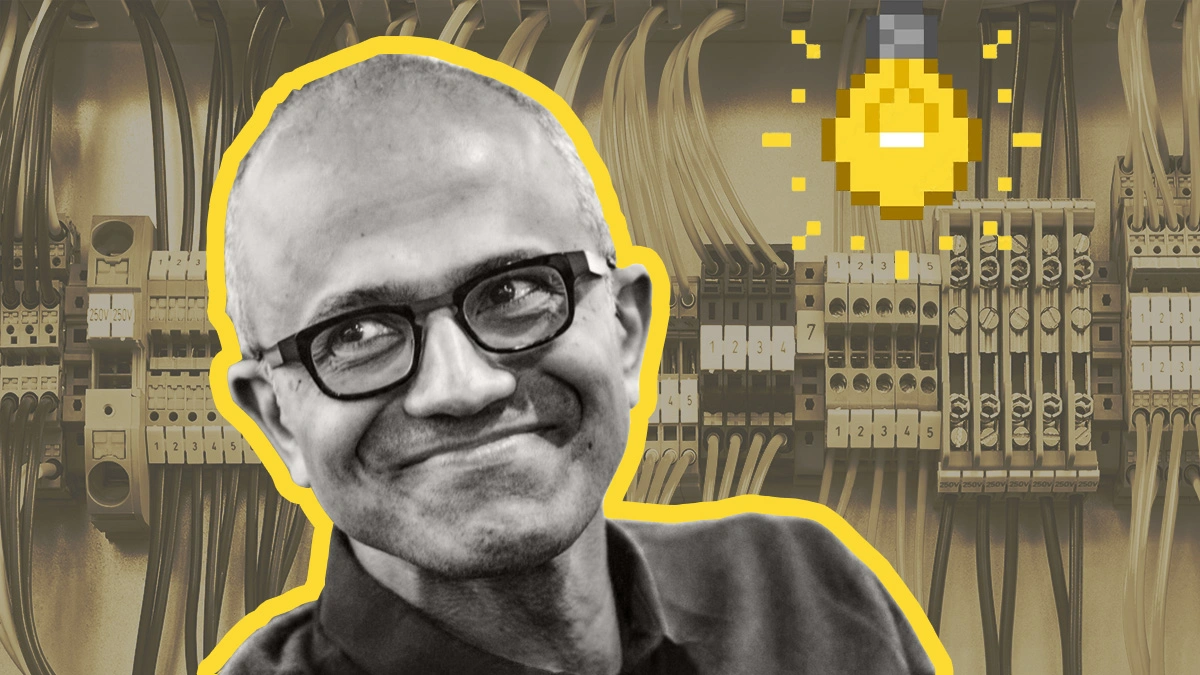

W świecie sztucznej inteligencji jeszcze niedawno sen z powiek spędzał problem dostępu do kart graficznych potrzebnych do treningu i działania systemów sztucznej inteligencji. Dziś - jak mówi Satya Nadella - sytuacja odwróciła się o 180 stopni. Microsoft zgromadził już wystarczającą liczbę układów obliczeniowych, głównie GPU do zastosowań AI, ale nie jest w stanie ich wykorzystać. Powód? Niedobór mocy energetycznej i brak gotowych centrów danych.

Nadella przyznaje, że firma ma więcej kart graficznych niż gniazdek

W najnowszym odcinku podcastu Bg2, Satya Nadella i Sam Altman zgodnie przyznali, że głównym problemem nie jest już dostępność GPU, lecz fizyczne ograniczenia infrastruktury. - Mam chipy, których nie mogę podłączyć - nie mam prądu ani gotowych centrów danych - powiedział wprost szef Microsoftu.

Jaka jest długoterminowa tendencja? Długoterminowa tendencja jest taka, [...] że największym problemem, z jakim obecnie się borykamy, nie jest nadmiar mocy obliczeniowej, ale energia i zdolność do wystarczająco szybkiego wykonania kompilacji w pobliżu źródła zasilania. [...] Nie jest to kwestia podaży chipów. W rzeczywistości chodzi o to, że nie mam gotowej infrastruktury pod centra danych, do której mógłbym je podłączyć [...]

Zdaniem szefa Microsoftu to właśnie obecnie brak mocy i możliwości szybkiej rozbudowy dobrze wyposażonych centrów danych w miejscach, gdzie ta energia jest dostępna. Słowa Nadelli dobrze oddają napięcie, które narasta w branży AI od miesięcy. Firmy technologiczne - od Microsoftu po Google i Amazon - zaczynają mierzyć się z granicami fizyki, a konkretnie z faktem, że energia elektryczna jest zasobem ograniczonym. Przy tak intensywnym rozwoju sztucznej inteligencji brakuje nie tylko chipów, ale też mocy, by je w ogóle podłączyć do infrastruktury.

Altman w rozmowie poszedł jeszcze dalej: ostrzegł, że cała branża może wkrótce przeżyć szok, jeśli postęp w miniaturyzacji modeli pozwoli uruchamiać je lokalnie - na niskim poborze mocy.

Wyobraźmy sobie konsumenckie urządzenie, które potrafi lokalnie uruchomić model GPT‑5 lub GPT‑6. [Ta wizja] przeraża tych, którzy budują wielkie stosy obliczeniowe

Dodał, że jeśli takie urządzenia się pojawią, a infrastruktura chmurowa nie zdąży przynieść zwrotu z inwestycji, wiele firm może zostać "mocno spalonych".

Nadella również odniósł się do tego ryzyka. Mimo miliardowych inwestycji w centra danych, nie ma gwarancji, że to właśnie one będą przyszłością AI. - To nie będzie liniowy proces. Bańki pękają. I pękają wielokrotnie - zauważył. Choć wszyscy stawiają na długoterminowy wzrost zapotrzebowania na obliczenia, historia uczy, że każde takie zakupy obarczone są wysokim ryzykiem technologicznym i infrastrukturalnym.

Ostatecznie jednak Nadella i Altman trzymają się wersji, że koszt "jednostki inteligencji" będzie spadał. A to - jak twierdzą - napędzi globalny wzrost gospodarczy. Warunek? Musimy rozwiązać problem, o którym nikt do niedawna nie myślał: czy mamy wystarczająco dużo prądu, by uruchomić to, co już mamy w magazynach.

Więcej o żarłocznej AI: