To koniec dominacji Nvidii? AMD Instinct to szansa na demokratyzację AI

Układy Nvidia H200 są prawdopodobnie na dziś najbardziej pożądanymi GPU w świecie Big Tech, do tej pory zapewniając wiodącą moc obliczeniową i specjalizację pod GenAI. AMD Instinct jednak od dłuższego czasu zapewniają całkiem niezłą alternatywę. A od dziś to chipy Nvidii mają być tymi drugiego wyboru. Przynajmniej jeśli wierzyć przechwałkom producenta.

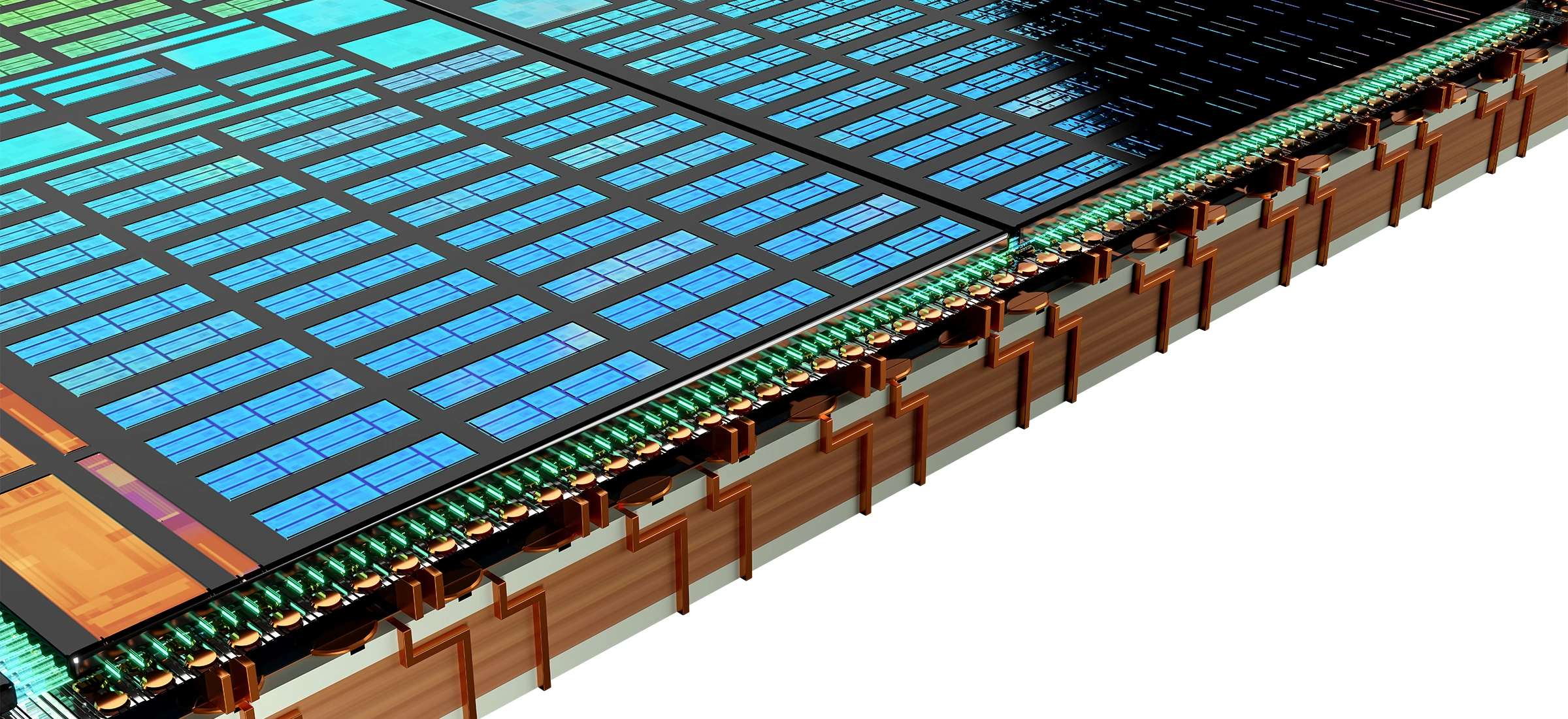

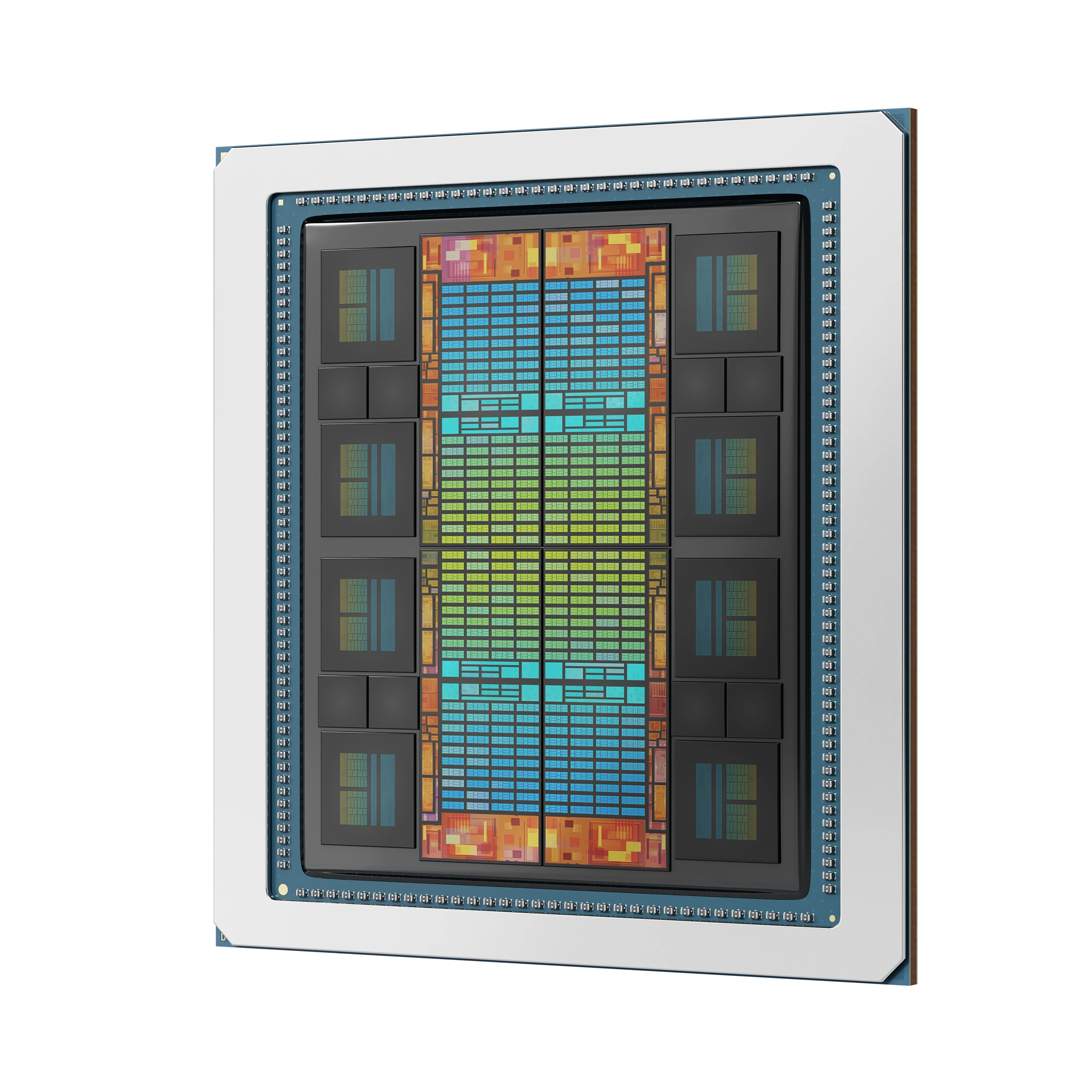

AMD wprowadza na rynek nową generację akceleratorów GPU z serii Instinct, począwszy od modelu MI325X. Ten najnowszy akcelerator został opracowany w oparciu o architekturę GPU AMD CDNA 3. Kluczowe parametry techniczne tego modelu obejmują aż 256 GB pamięci HMB3E oraz imponującą wydajność wynoszącą 2,6 PF w operacjach FP8.

Jednym z wyróżniających się aspektów MI325X jest liczba tranzystorów, która wynosi aż 153 mld. To pokazuje, jak bardzo zaawansowane są te układy i jak wielkie możliwości obliczeniowe oferują. Dodatkowo przepustowość pamięci wynosząca 6 TB/s sprawia, że ten model doskonale radzi sobie z przesyłaniem dużych ilości danych w krótkim czasie.

Kolejnym ważnym elementem jest wydajność w operacjach FP16, która wynosi 1,3 PF. Dzięki temu MI325X znajdzie zastosowanie w zaawansowanych zadaniach obliczeniowych, takich jak uczenie maszynowe czy symulacje naukowe. Wysoka przepustowość pamięci i duża liczba tranzystorów wspierają te procesy, zapewniając jednocześnie wysoką efektywność energetyczną.

Już na poziomie akceleratora MI325X oferuje imponujące wyniki w porównaniu z Nvidia H200

Jednym z kluczowych wskaźników, na które warto zwrócić uwagę, jest zwiększona przepustowość. W przypadku Mixtral 8x7B, MI325X oferuje 1,4-krotnie większą przepustowość niż Nvidia H200, co znacząco wpływa na wydajność w środowiskach obciążonych danymi.

Poprawa opóźnień jest kolejnym istotnym aspektem. W przypadku Mistral 7B, MI325X osiąga 1,3-krotną redukcję opóźnień w porównaniu do H200. Tego typu usprawnienia mają duże znaczenie w kontekście aplikacji wymagających szybkiego przetwarzania, takich jak systemy sztucznej inteligencji czy symulacje naukowe.

Model MI325X przynosi także korzyści w pracy z zaawansowanymi modelami językowymi. W kontekście Meta Llama-3.1 70B, MI325X wykazuje 1,2-krotną poprawę opóźnień w porównaniu do H200. Dzięki temu przetwarzanie dużych zestawów danych tekstowych jest bardziej efektywne, co ma kluczowe znaczenie dla aplikacji opartych na analizie języka naturalnego.

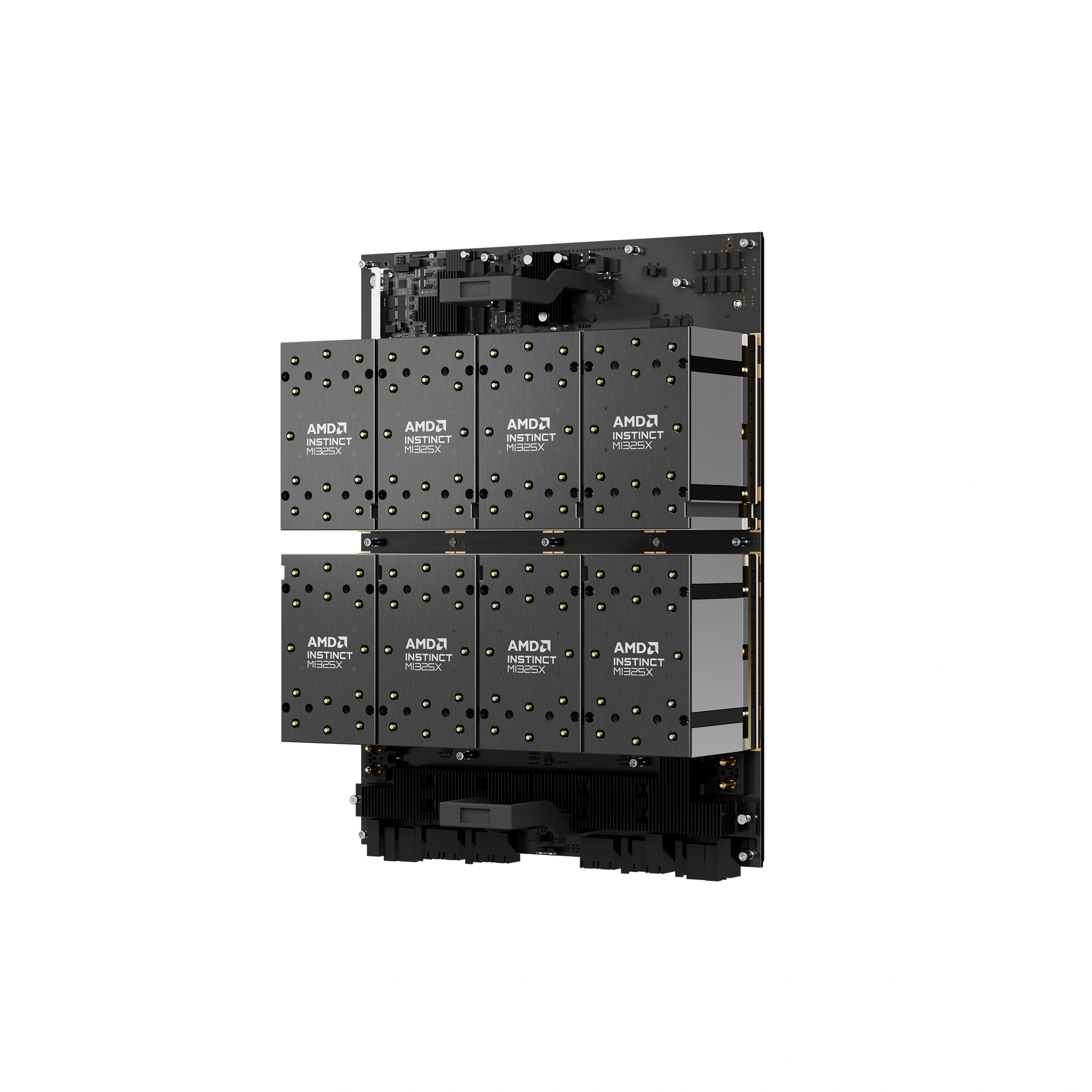

Jeszcze bardziej imponujące wyniki generuje gotowa AMD Instinct Platform oparta o te układy

Różnice między AMD Instinct Accelerator a AMD Instinct Platform polegają głównie na zakresie i zastosowaniach tych rozwiązań. AMD Instinct Accelerator to pojedynczy układ GPU, który jest przeznaczony do wydajnych obliczeń, takich jak sztuczna inteligencja (AI) i obliczenia naukowe wysokiej wydajności (HPC). Instinct Accelerator oferuje wysoką wydajność obliczeniową, dużą gęstość pamięci oraz wsparcie dla specjalistycznych formatów danych.

AMD Instinct Platform natomiast jest bardziej zaawansowanym rozwiązaniem, które obejmuje więcej niż jeden Instinct Accelerator. Platforma ta może składać się z kilku układów GPU, co pozwala na jeszcze większą skalowalność i wydajność w dużych systemach obliczeniowych, takich jak superkomputery. Instinct Platform oferuje również dodatkowe funkcje, takie jak wsparcie dla różnych interfejsów pamięci i architektur, co umożliwia lepszą integrację z istniejącymi systemami.

Również i platforma oparta o MI325X oferuje znaczące udoskonalenia technologiczne, w tym aż 2TB pamięci HBM3E. To pozwala na przetwarzanie ogromnych ilości danych w krótkim czasie, co jest kluczowe w wielu zaawansowanych aplikacjach. Jednym z najważniejszych parametrów technicznych platformy MI325X jest oczywiście jej wydajność obliczeniowa, która osiąga 20,8 PF w operacjach FP8. To stawia ten model w czołówce rozwiązań dostępnych na rynku, umożliwiając realizację najbardziej wymagających zadań obliczeniowych. Ponadto, szeroka przepustowość Infinity Fabric wynosząca 896 GB/s pozwala na sprawne przesyłanie danych między różnymi jednostkami obliczeniowymi.

Przepustowość pamięci w MI325X również jest imponująca, osiągając 48 TB/s. Dzięki temu możliwe jest przetwarzanie dużych ilości danych bez wąskich gardeł, co jest szczególnie istotne w kontekście obliczeń naukowych i systemów sztucznej inteligencji. Wydajność w operacjach FP16, która wynosi 10.4 PF, podkreśla zdolność tego modelu do efektywnego przetwarzania danych liczbowych z wysoką precyzją.

Platforma MI325X oferuje 1,8-krotnie większą pojemność pamięci w porównaniu do NVIDIA H200 HGX, co umożliwia przetwarzanie większych zestawów danych i obsługę bardziej złożonych modeli obliczeniowych. Jest to szczególnie ważne w kontekście zadań wymagających ogromnych zasobów pamięci, takich jak analizy big data czy zaawansowane symulacje naukowe.

Kolejnym aspektem, w którym AMD Instinct MI325X przewyższa Nvidia H200 HGX, jest przepustowość pamięci. MI325X zapewnia 1,3-krotnie większą przepustowość, co przekłada się na szybsze przetwarzanie danych i bardziej efektywne wykonywanie zadań. Wzrost przepustowości jest kluczowy dla aplikacji wymagających szybkiego dostępu do dużych ilości danych, takich jak systemy uczenia maszynowego i sztucznej inteligencji.

Wydajność obliczeniowa to kolejny element, w którym MI325X się wyróżnia. Platforma ta oferuje 1,3-krotną poprawę w operacjach FP16 i FP8 w porównaniu do Nvidia H200 HGX. Dzięki temu, MI325X może efektywniej przetwarzać złożone obliczenia, co jest istotne dla wielu zaawansowanych zastosowań. Wyższa wydajność obliczeniowa przekłada się na krótszy czas wykonywania zadań i lepsze wykorzystanie zasobów obliczeniowych, co jest szczególnie ważne w środowiskach, gdzie liczy się każda sekunda przetwarzania.

W porównaniu do Nvidia H200 HGX, rozwiązanie to oferuje 1,4-krotnie większą przepustowość dla modelu Meta Llama-3.1 405B. Zwiększona przepustowość jest kluczowa dla szybkiego i efektywnego przetwarzania dużych zestawów danych, co ma znaczący wpływ na czas wykonywania zadań i efektywność operacyjną.

Kolejnym istotnym usprawnieniem jest poprawa opóźnień w przypadku Meta Llama-3.1 70B. Platforma AMD Instinct MI325X oferuje 1,2-krotną redukcję opóźnień w porównaniu do Nvidia H200 HGX, co przekłada się na bardziej responsywne i precyzyjne przetwarzanie danych. Zmniejszenie opóźnień jest kluczowe dla aplikacji, które wymagają błyskawicznych odpowiedzi, takich jak systemy sztucznej inteligencji i aplikacje wnioskowania.

Co więcej, platforma AMD Instinct MI325X zapewnia do 1,4-krotnie wyższą wydajność inference w porównaniu do Nvidia H200 HGX. Dzięki temu możliwe jest bardziej efektywne wykonywanie zadań obliczeniowych, co jest istotne w kontekście zaawansowanych zastosowań naukowych i przemysłowych. Wyższa wydajność inference przekłada się na szybsze wyniki i lepsze wykorzystanie zasobów, co czyni platformę AMD Instinct MI325X atrakcyjnym rozwiązaniem dla użytkowników poszukujących wysokiej jakości w zakresie przetwarzania danych.

Będzie jeszcze mocniej. MI355X nie jest jeszcze dostępny, ale AMD już się nim chwali

AMD zapowiedziało też wprowadzenie na rynek MI355X. Ten najnowszy akcelerator został opracowany w oparciu o zaawansowaną architekturę GPU AMD CDNA 4, co stanowi kontynuację innowacji firmy w dziedzinie obliczeń o wysokiej wydajności. Proces technologiczny 3nm, zastosowany w MI355X, pozwala na uzyskanie wyższej gęstości tranzystorów oraz lepszej efektywności energetycznej.

Jednym z kluczowych parametrów MI355X jest możliwość obsługi do 288GB pamięci HBM3E. To znaczące zwiększenie pojemności pamięci umożliwia skuteczne przetwarzanie dużych zestawów danych, co jest kluczowe w zaawansowanych aplikacjach obliczeniowych. Wysoka przepustowość i pojemność pamięci zapewniają płynne działanie nawet najbardziej wymagających zadań.

Model MI355X wspiera również nowe typy danych FP4 i FP6, co pozwala na bardziej elastyczne i wydajne przetwarzanie różnych formatów danych. Ta wszechstronność sprawia, że MI355X jest idealnym wyborem dla szerokiego spektrum zastosowań, od analizy danych po złożone obliczenia numeryczne.

A jak radzi sobie MI355X jako platforma?

Jednym z głównych wyróżników tej platformy jest ogromna pamięć HBM3E, która osiąga pojemność 2,3 TB. To umożliwia skuteczne przetwarzanie dużych zestawów danych, co jest kluczowe dla zaawansowanych aplikacji naukowych i przemysłowych. Kolejnym istotnym elementem MI355X jest przepustowość pamięci, która wynosi aż 64 TB/s. Taka przepustowość zapewnia płynne działanie nawet najbardziej wymagających zadań obliczeniowych, eliminując wąskie gardła związane z transferem danych. Dzięki temu użytkownicy mogą liczyć na wyższą efektywność i krótszy czas przetwarzania złożonych obliczeń, co ma istotne znaczenie w kontekście aplikacji wykorzystujących sztuczną inteligencję oraz analizy big data.

Wydajność obliczeniowa MI355X jest równie imponująca. Platforma ta oferuje 18.5 PF w operacjach FP16, 37 PF w operacjach FP8 oraz 74 PF w operacjach FP6 i FP4. Dzięki tak wysokiej wydajności, MI355X jest w stanie sprostać wymaganiom najbardziej zaawansowanych zadań obliczeniowych, oferując użytkownikom wszechstronne i potężne narzędzie do realizacji różnorodnych zastosowań.

Czy to wszystko pomoże w walce z Nvidią? Kluczowe będą ceny, sprawność energetyczna i dostępność rozwiązań. Jedno z tego wszystkiego warto jednak wyciągnąć: Nvidia nie jest i nie będzie monopolistą na tym rynku. Ma tymczasową dominację - choć za sprawą konkurencji, głównie w formie Instincta, rzeczona dominacja powinna niedługo się zakończyć. Na czym obiektywnie zyskają klienci.