Apple Intelligence jest już w Polsce. Po testach mam ochotę wyrzucić iPhone’a do kosza

Apple Intelligence w końcu trafiło do Polski. Niestety, moja radość szybko zamieniła się w rozczarowanie. Przetestowałem polską betę iOS 18.4 i sprawdziłem, jak działają nowe funkcje AI. Czy warto czekać na pełną wersję?

Apple Intelligence wkracza na polski rynek, obiecując rewolucję w sposobie, w jaki korzystamy z urządzeń Apple'a. Ta platforma sztucznej inteligencji ma na celu uczynienie iPhone'ów, iPadów i Maców bardziej intuicyjnymi i osobistymi.

Od ulepszonych możliwości Siri, przez inteligentne zarządzanie powiadomieniami, po zaawansowane narzędzia do edycji zdjęć i generowania tekstu - AI od Apple'a ma (na papierze) potencjał, by znacząco usprawnić codzienne zadania i otworzyć nowe możliwości.

Niestety, polscy użytkownicy muszą liczyć się z ograniczeniami na starcie. Nie wszystkie funkcje Apple Intelligence będą dostępne w Polsce od razu. Kluczowe elementy, takie jak zaawansowane funkcje językowe, w tym generowanie tekstu i inteligentne tłumaczenia, nie będą działać w dniu premiery.

Apple Intelligence można już sprawdzić. Wystarczy zmienić kilka ustawień, pobrać jedną aktualizację - i można zasmakować nowości od Apple’a.

Apple Intelligence w Polsce. Co działa w tym momencie?

AI dostępna dla Polaków w becie iOS 18.4 jest bardzo okrojona.

Oto dostępne funkcje Apple Intelligence w Polsce (deweloperska wersja beta iOS 18.4):

- Podsumowywanie treści (anglojęzycznych)

- Gumka AI w galerii

- Integracja Siri z ChatGPT (dla poleceń anglojęzycznych)

- Według sieci Visual Intelligence (integracja z Google) - ale na moim iPhone'ie 15 Pro Max nie będzie nigdy dostępna przez brak "narzędzia sterowania aparatem".

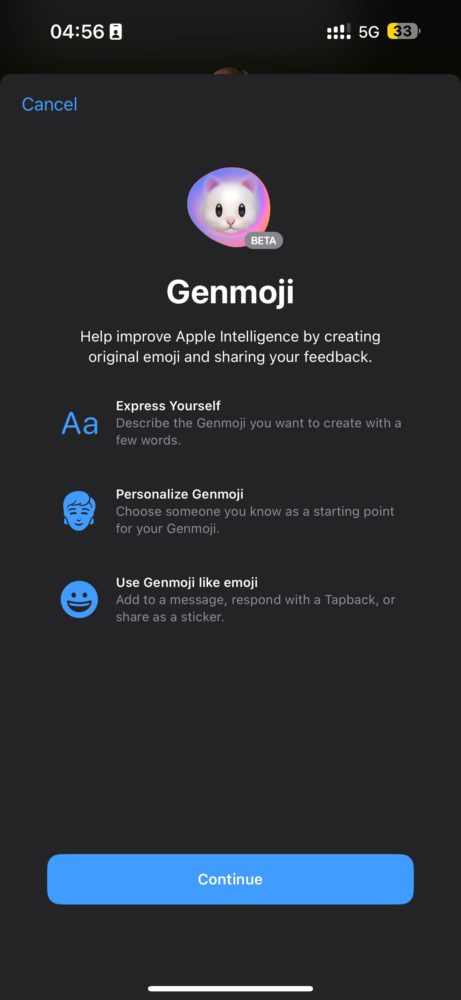

- Genmoji (generator emotikonów)

- Image Playground (generator obrazów)

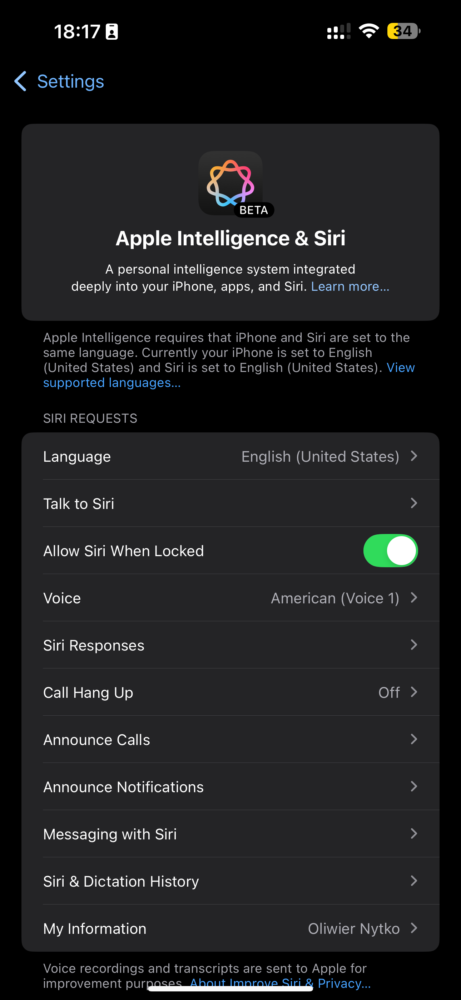

- Siri (w języku angielskim)

Mało? Bardzo mało, bo Siri naturalnie działa tylko w języku Szekspira, a reszta naprawdę przydatnych funkcji jest niedostępna w Unii Europejskiej, ot tak. Zacznijmy jednak od tego, co działa.

Podsumowania artykułów: tak

Najważniejsza obecnie (dla nas - bo działająca) funkcja Apple Intelligence: ma za zadanie streszczać artykuły i inne teksty. W obecnej, testowej wersji w Polsce, działa ona wyłącznie dla treści napisanych w języku angielskim.

Funkcja podsumowywania, na pierwszy rzut oka, działa "mniej więcej OK". Ale nie ufałbym jej, zważywszy na wcześniejsze doniesienia o przeinaczaniu sensu oryginalnych artykułów czy powiadomień w kontekście podsumowań na ekranie blokady. Wtedy to użyteczność tej funkcji była kwestią losową, jak rzut monetą. Dlatego, jeśli to możliwe, polecam czytać całe teksty. Albo przynajmniej skorzystać z czegoś bardziej wiarygodnego, gdy naprawdę potrzebujemy szybkiego streszczenia. Nawet Gemini od Google’a sprawdzi się lepiej.

Gumka AI w galerii - żart i kpina

Funkcja gumki AI, dostępna w aplikacji Galeria, pozwala na usuwanie niechcianych obiektów ze zdjęć. Mimo że jest ona dostępna w polskiej wersji testowej Apple Intelligence, jej działanie mogę ocenić jedynie jako znacznie słabsze w porównaniu do konkurencyjnych rozwiązań. Samsung wykonuje świetną robotę. WŁAŚCIWIE: każdy robi lepszą robotę od tego "produktu" Apple’a.

Nawet nie próbuj usuwać czegokolwiek istotnego za pomocą tego narzędzia, chyba że chodzi o nieistotny fragment tła, który cię irytuje, albo coś, co AI bardzo łatwo zidentyfikuje. Inaczej powstanie kompletny chaos. Obecnie gumkę można wyrzucić do kosza, bo równie dobrze można skorzystać z internetowych rozwiązań, które nie wymagają najnowszego iPhone’a.

Siri jest. I tyle mogę powiedzieć

Apple obiecuje, że Siri w erze Apple Intelligence to skok kwantowy – asystentka, która wreszcie przestanie być tylko wykonawcą prostych poleceń. W teorii Siri ma stać się prawdziwie inteligentna, rozumiejąc kontekst naszych zapytań, przewidując potrzeby i oferując proaktywną pomoc.

Niestety, beta-rzeczywistość brutalnie sprowadza nas na ziemię. Siri "wzbogacona" Apple Intelligence wciąż nie rozumie języka polskiego i wymaga angielskich komend głosowych, co dla większości polskich użytkowników czyni ją mało użyteczną ciekawostką. Siri w polskiej wersji beta Apple Intelligence bardziej przypomina eksperymentalny gadżet, niż rzeczywiście inteligentną asystentkę. Działa odrobinę lepiej, ale tylko odrobinę - nadal nie rozumie prostych poleceń, które nie zostały z góry zaprogramowane przez Apple'a.

Siri z ChatGPT. Czyli po co ci Siri?

Apple Intelligence umożliwia integrację asystentki Siri z modelem językowym ChatGPT. W polskiej wersji testowej ta integracja działa, pod warunkiem używania języka angielskiego do wydawania poleceń głosowych Siri. Po aktywowaniu integracji komendą w języku angielskim, zapytanie jest przekazywane do usługi OpenAI.

Często najzwyklejsze pytanie jest wysyłane od razu do ChatGPT. Wygląda na to, że Apple, widząc rozwiązanie od OpenAI, spojrzał na Siri, przemyślał sprawę - i porzucił wszelkie nadzieje, skupiając się na tworzeniu kolejnego iPhone’a.

W tym kontekście można zadać pytanie: po co Apple trzyma jeszcze Siri przy życiu? Przecież to cyfrowy dinozaur w porównaniu do tego, co potrafi ChatGPT czy nawet Gemini od Google'a. Nawet ta "ulepszona" Siri z Apple Intelligence to wciąż niepełnowartościowe narzędzie – niby ma być mądrzejsza, a w praktyce częściej przekazuje zapytania do ChatGPT, niż sama coś sensownego odpowiada.

To tak, jakby Apple przyznał wprost: "Hej, nasza asystentka jest do kitu, więc przekierujemy twoje pytanie do kogoś mądrzejszego".

Genmoji i Image Playground to dodatki. Ale działają!

Funkcja Genmoji w Apple Intelligence to generator emotikonów, który ma za zadanie tworzyć spersonalizowane emoji na podstawie opisów tekstowych użytkownika. Użytkownik wprowadza tekstowy opis pożądanego emoji, na przykład "emoji uśmiechniętej pandy grającej na gitarze", a AI generuje unikalne emoji odpowiadające temu opisowi. Ja postawiłem na standardową emotkę kupy, która doskonale opisuje moje odczucia względem Apple Intelligence.

Image Playground z kolei, to narzędzie Apple Intelligence służące do generowania obrazów. Podobnie jak Genmoji, wykorzystuje ono generatywne modele AI, ale w tym przypadku do tworzenia bardziej złożonych grafik i ilustracji. Użytkownik może opisać pożądany obraz za pomocą tekstu, określając styl, motyw, postacie i inne elementy kompozycji. Image Playground ma oferować różnorodne style artystyczne, umożliwiając generowanie obrazów w stylu rysunkowym, malarskim, fotorealistycznym i innych. Działa? Tak. Można się pobawić? Owszem. Ale to nic nowego. Apple nadrabia po prostu zaległości względem konkurencji.

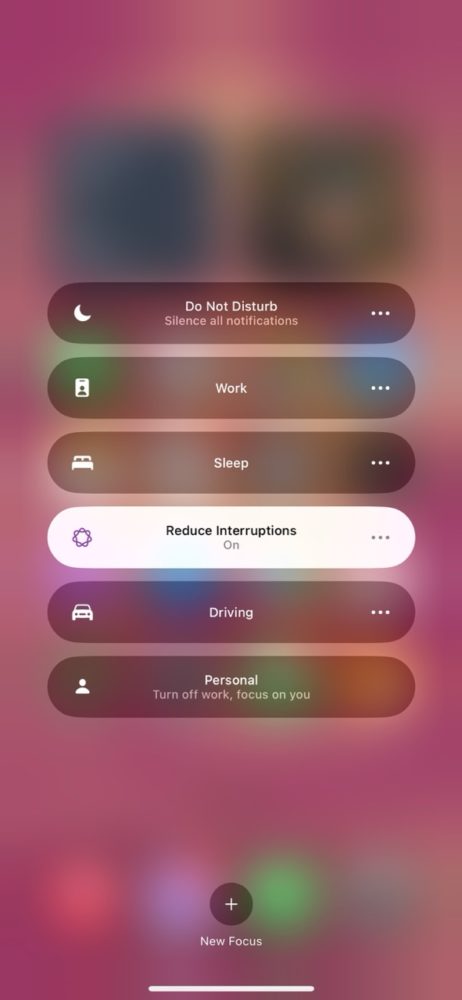

Tryb skupienia "Nie rozpraszaj" w Apple Intelligence

Wśród licznych niedziałających funkcji Apple Intelligence w polskiej becie iOS 18.4 wyróżnia się działający tryb skupienia. "Nie przeszkadzać" to jedyna opcja, która funkcjonuje poprawnie, a przynajmniej zgodnie z opisem.

Choć obiecane streszczanie powiadomień wciąż pozostaje dla mnie niedostępne – prawdopodobnie z powodu braku wsparcia języka polskiego – to inteligentne filtrowanie powiadomień w trybie "Nie przeszkadzać" wydaje się działać zgodnie z zamierzeniami Apple'a.

System analizuje treść powiadomień i przepuszcza jedynie te, które uzna za naprawdę pilne i wymagające natychmiastowej reakcji, takie jak pilne wiadomości czy alarmy. Pozostałe, mniej istotne powiadomienia, są dyskretnie wyciszane, co pozwala skupić się na tym, co naprawdę istotne w danym momencie.

Zobacz, jak AI powinno działać:

Droga przez mękę i frustrację

Uruchomienie Apple Intelligence w deweloperskiej wersji iOS 18.4 w Polsce to prawdziwa droga przez mękę dla każdego, kto liczył na szybki dostęp do obiecanych funkcji. Już sama instalacja bety systemu to zadanie dla cierpliwych, ale prawdziwe wyzwania zaczynają się, gdy chcemy aktywować AI. Jaki język mamy wybrać? Pomódl się o to, aby dobrze trafić. I przy okazji przygotuj się na twarde resetowanie iPhone'a kilka razy.

System informuje nas o konieczności pobrania dodatkowych pakietów, co samo w sobie trwa długie minuty, a w niektórych przypadkach – jak przy generatorze emotikonów Genmoji – proces pobierania zdaje się nie mieć końca. Całość konfiguracji przypomina labirynt bez wyjścia, gdzie na każdym kroku czekają kolejne komunikaty o błędach, niedostępnych funkcjach i konieczności pobierania kolejnych pakietów, nie wiadomo jak długo.

Niestety, ta frustrująca konfiguracja nie jest niczym nowym. Już w styczniu, wraz z Piotrem Grabcem, testowaliśmy Apple Intelligence w Stanach Zjednoczonych i mieliśmy nadzieję, że do momentu udostępnienia bety w Polsce, Apple upora się z problemami.

Nic bardziej mylnego. Beta iOS 18.4 w Polsce serwuje nam dokładnie to samo rozczarowanie – uciążliwą konfigurację, niekompletne funkcje i ogólne wrażenie niedopracowanego produktu. Czas spędzony na zmaganiach z konfiguracją Apple Intelligence w wersji beta to czas stracony, a obiecana rewolucja sztucznej inteligencji w iPhone'ach wciąż pozostaje odległą wizją.

Ostatecznie, po przebrnięciu przez męczącą konfigurację, okazuje się, że Apple Intelligence w wersji beta to w dużej mierze wydmuszka. Dostępne funkcje często działają gorzej niż u konkurencji, a brak wsparcia dla języka polskiego dodatkowo pogłębia wrażenie niedopracowania. Gumka AI w galerii ustępuje rozwiązaniom Samsunga czy Google'a, integracja Siri z ChatGPT wydaje się sztuką dla sztuki, a funkcje, które miały robić największe wrażenie, jak Genmoji i Image Playground, są zbędne i mało użyteczne.