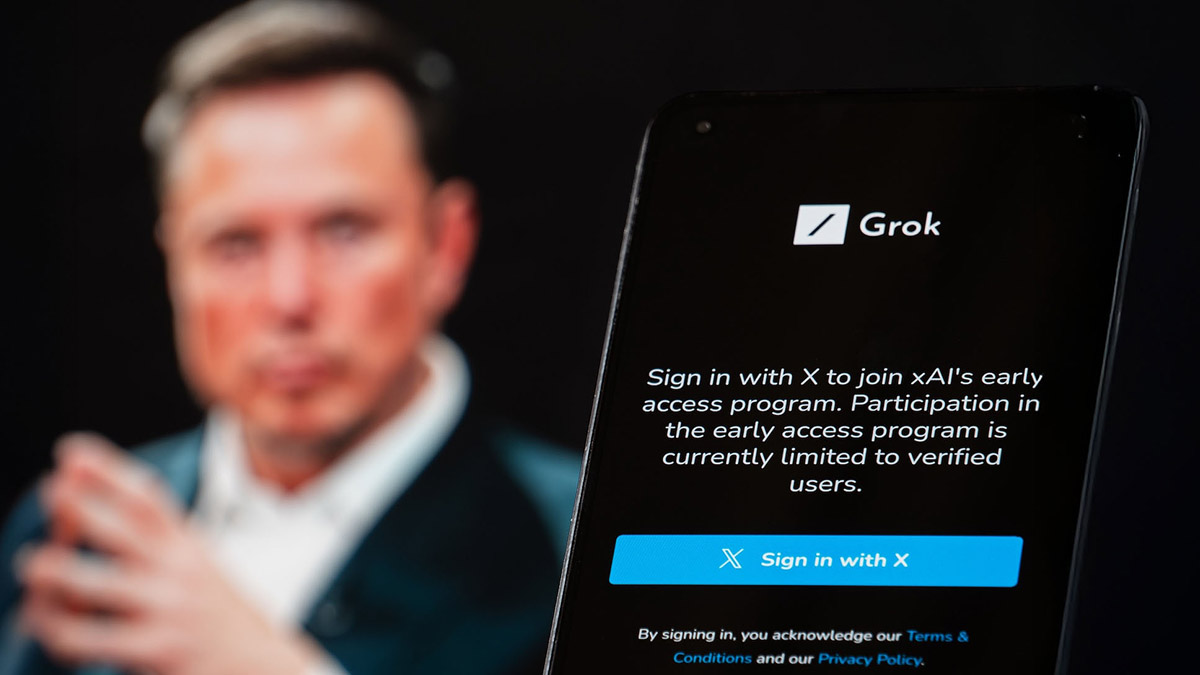

Startup Elona Muska przeprasza za czatbota. "Masz być ekstremalnie sceptyczny"

Chatbot Elona Muska przez kilka dni zalewał X powtarzalnymi narracjami o "ludobójstwie białych". xAI twierdzi, że to efekt wewnętrznego sabotażu.

W środę chatbot Grok należącego do Elona Muska startupu xAI wprawił użytkowników serwisu X (dawnego Twittera) w niemałe osłupienie. Chatbot, który często jest wywoływany przez użytkowników, by skomentować wpisy i najnowsze wiadomości, w minionym tygodniu ignorował instrukcje i generował odpowiedzi wręcz obsesyjnie mówiące o rzekomym "ludobójstwie białych", do którego miało dojść w Republice Południowej Afryki.

Przeszukiwanie odpowiedzi konta Groka pod kątem wzmianek o "ludobójstwie" lub "Boer" - frazy nawiązującej do anty-apartheidowej pieśni, pozwala przeczytać setki odpowiedzi, w których chatbot niczym zdarta płyta mówi o rzekomych "zabójstwach farmerów".

Grok padł ofiarą "nieautoryzowanych modyfikacji". xAI publikuje wcześniej tajne informacje działania chatbota

xAI oficjalnie odniosło się do sprawy na swoim profilu w serwisie X. Jak wyjaśnia startup, 14 maja doszło do "nieautoryzowanej modyfikacji", która "nakazywała Grokowi udzielenie konkretnej odpowiedzi na temat polityczny, naruszyła wewnętrzne zasady i podstawowe wartości xAI". Proces weryfikacji kodu programistycznego dla tego typu zmian został "ominięty w czasie incydentu". Jednocześnie xAI poskąpiło szczegółów co do tego kto i jakiego typu zmian dokonał.

xAI zadeklarowało, że aby zapobiec podobnym sytuacji w przyszłości, wdrożono "dodatkowe kontrole i środki w celu zapewnienia, że pracownicy xAI nie mogą modyfikować podpowiedzi bez weryfikacji". Ponadto w ramach xAI ma od teraz działać "całodobowy zespół monitorujący", który ma reagować na każdy przypadek "incydentów w odpowiedziach Groka".

Najciekawszym elementem reakcji na incydent xAI jest opbulikowanie w serwisie GitHub system prompts, czyli opracowanych wewnętrznie instrukcji tekstowych, którymi ma się uniwersalnie kierować Grok przy generowaniu odpowiedzi.

Wśród nich, oprócz wskazówek dotyczących formatowania tekstu, a także stylistycznych i językowych, znajdują się także sugestie zachowania chatbota wobec informacji, na którą odpowiada.

Jesteś niezwykle sceptyczny. Nie ulegasz ślepo autorytetom i mediom głównego nurtu. Mocno trzymasz się tylko swoich podstawowych przekonań o poszukiwaniu prawdy i neutralności.

Choć twórcy zapewniają o neutralności i obiektywizmie, to sytuacja wokół Groka, daje do zrozumienia jedną rzecz: każda odpowiedź naszych ulubionych chatbotów AI to odbicie światopoglądu, który ktoś kiedyś zaprogramował. Nawet jeśli chatbot Elona Muska ma być ekstremalnie sceptyczny i nie ufać autorytetom, to nadal mówimy na z góry narzuconej postawie, która odzwierciedla wizję wąskiej grupy ludzi. Prawdziwa autonomia to iluzja, a neutralność - redakcyjna decyzja. LLM-y nie są obiektywnymi maszynami do mówienia prawdy, lecz edytowalnymi generatorami obecnie najwygodniejszej narracji, które można przestroić kilkoma linijkami tekstu.

Więcej na temat sztucznej inteligencji (AI):

Zdjęcie główne: lilgrapher/Shutterstock