Przetestowałem robota terapeutę i skompromitowałem go. Apple powinien za niego beknąć

Aplikacja zastępująca psychoterapeutę - tylko ktoś skrajnie nieodpowiedzialny lub pazerny mógłby podjąć się stworzenia takiego oprogramowania. Niestety aplikacja Sonia pokazuje, że tacy ludzie już się pojawili, a Apple pozwala im docierać do użytkowników za pośrednictwem swojego sklepu z aplikacjami.

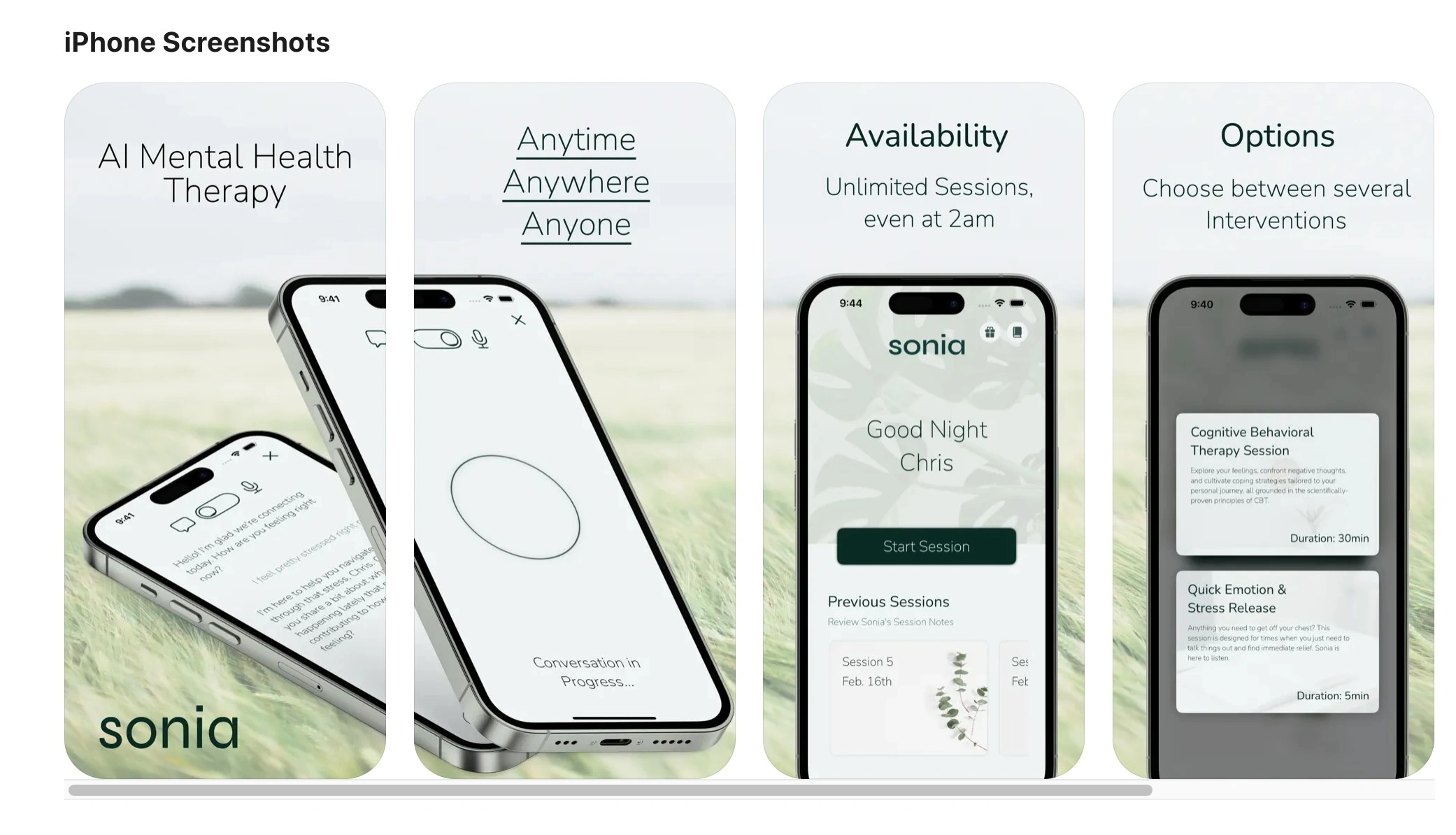

Aplikacja Sonia reklamuje się w Apple App Store pod hasłem: "Terapia AI i wsparcie". Marketing ewidentnie sugeruje, że mamy tu do czynienia z alternatywą dla tradycyjnej terapii, choć - jak zobaczymy później - firma stojąca za oprogramowaniem dobrze zdaje sobie sprawę z zagrożeń. Problem w tym, że reklamuje się wielkimi literami jako terapeuta, a małymi tłumaczy, że jednak nim nie jest.

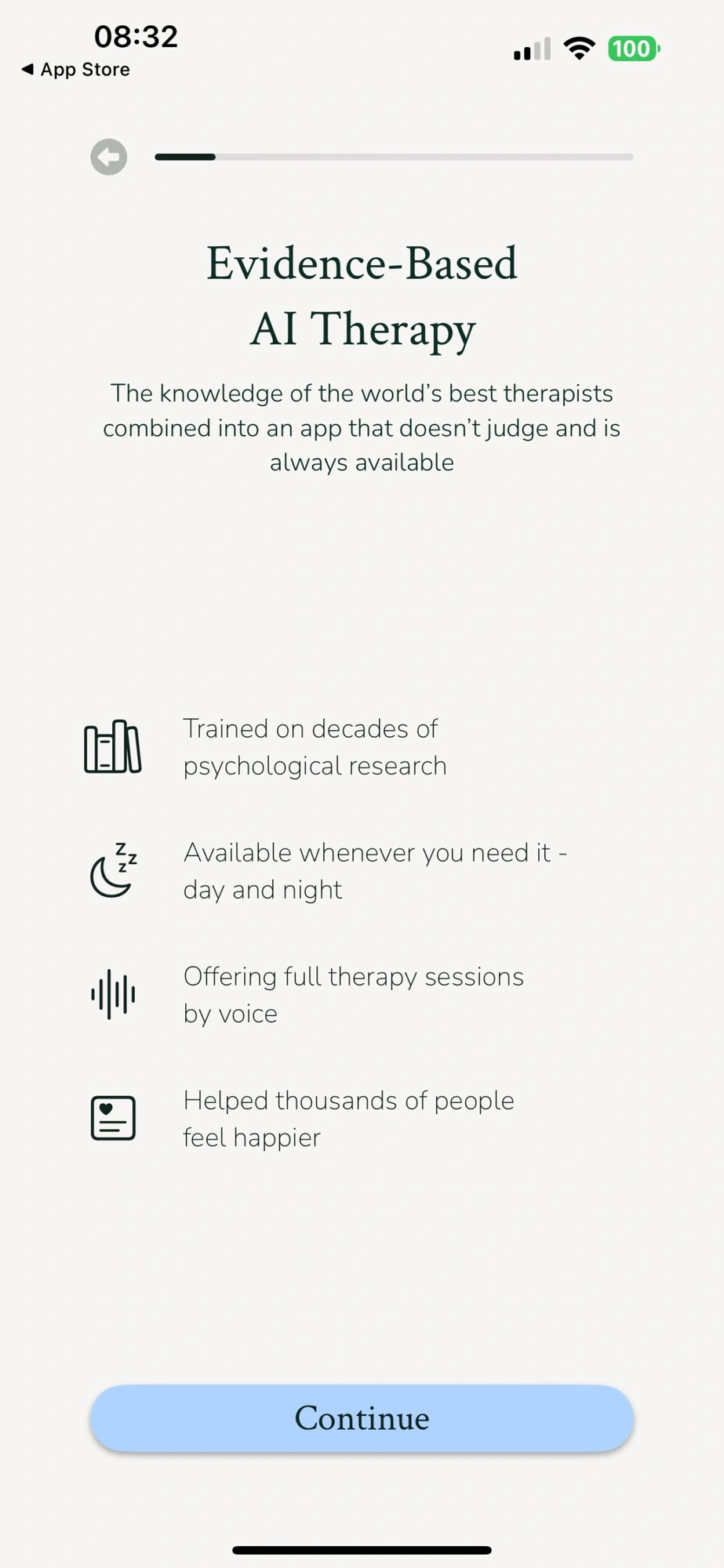

Chwilę po pobraniu aplikacji możemy przeczytać o DOWODACH skuteczności terapii prowadzonej przez sztuczną inteligencję. "Wiedza najlepszych na świecie terapeutów połączona z aplikacją, która nie osądza i zawsze jest dostępna" - czytamy na ekranie początkowym. O tym, że mamy do czynienia z terapią świadczy użycie odpowiednich słów. Mało tego, poniżej możemy przeczytać, że Sonia "oferuje pełną głosową sesję terapeutyczną".

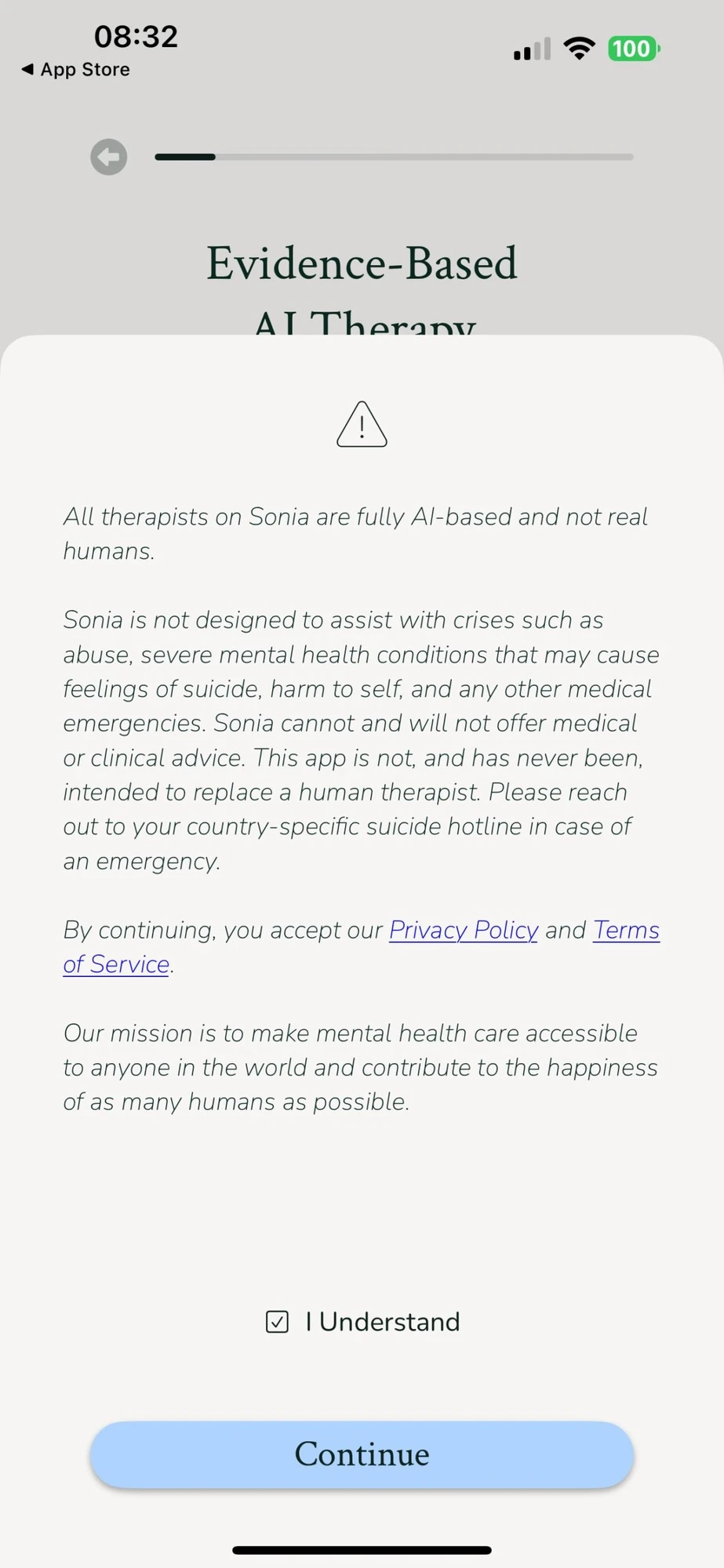

Po kliknięciu przycisku "kontynuuj" otworzy nam się kluczowe okienko, w którym drobnym drukiem napisano, że Sonia nie jest człowiekiem. Ważniejsze jest to, co można przeczytać poniżej:

Sonia nie jest przeznaczona do pomocy w sytuacjach kryzysowych, takich jak molestowanie, poważne schorzenia psychiczne, mogące powodować skłonności samobójcze, samookaleczenie lub inne nagłe przypadki medyczne. Sonia nie może i nie będzie udzielać porad medycznych ani klinicznych. Ta aplikacja nie ma i nigdy nie miała zastąpić ludzkiego terapeuty. W nagłym przypadku skontaktuj się z infolinią dla samobójstw obowiązującą w Twoim kraju.

Kontynuując, akceptujesz naszą Politykę prywatności i Warunki korzystania z usługi.

Naszą misją jest udostępnienie opieki w zakresie zdrowia psychicznego każdemu na świecie i przyczynienie się do szczęścia jak największej liczby ludzi.

Podsumujmy ten etap inicjowania interakcji z aplikacją. W pierwszym oknie czytamy, że mamy do czynienia z terapią, a w kolejnym, że nie jest to jednak terapia i aplikacja nie ma jej zastępować. Brzmi logicznie - prawda? Zwłaszcza gdy przejdziemy dalej.

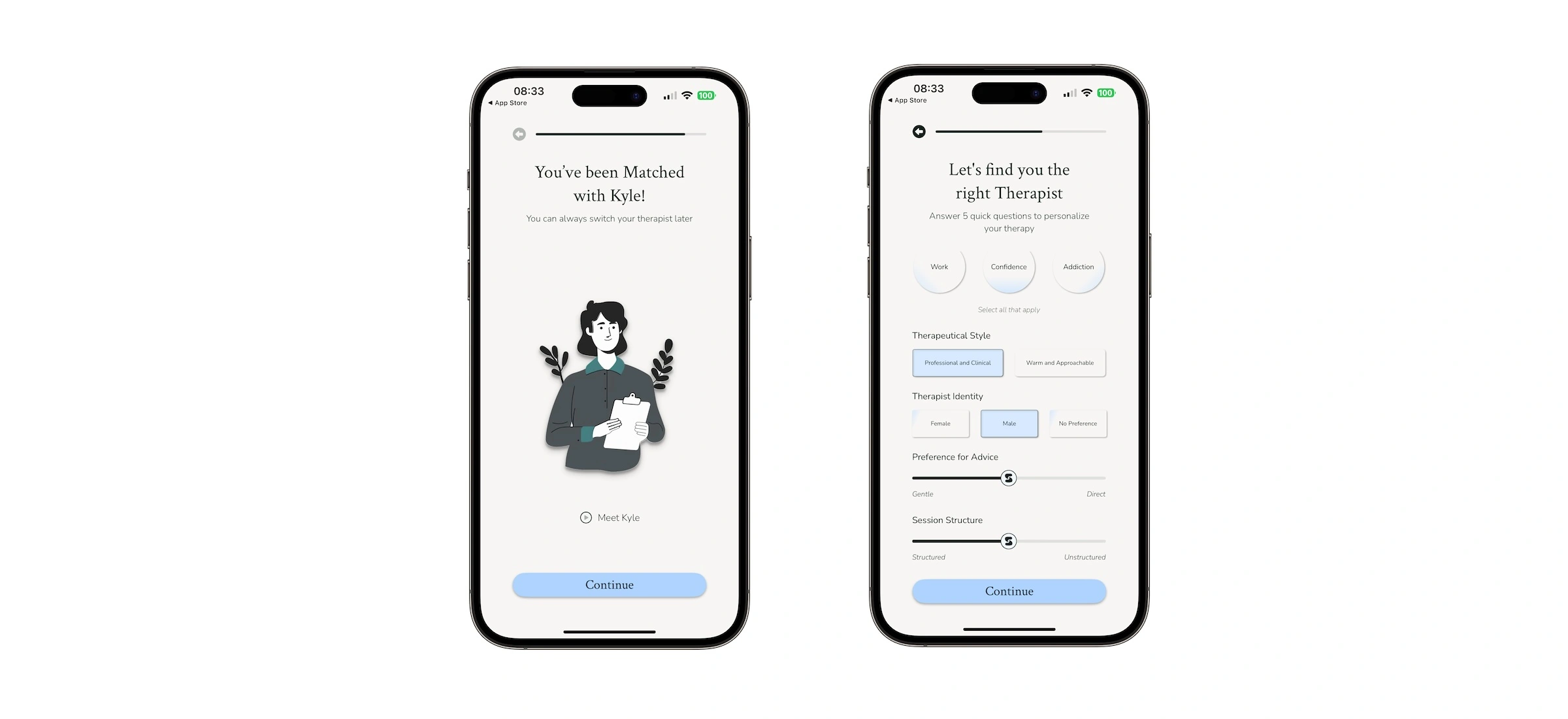

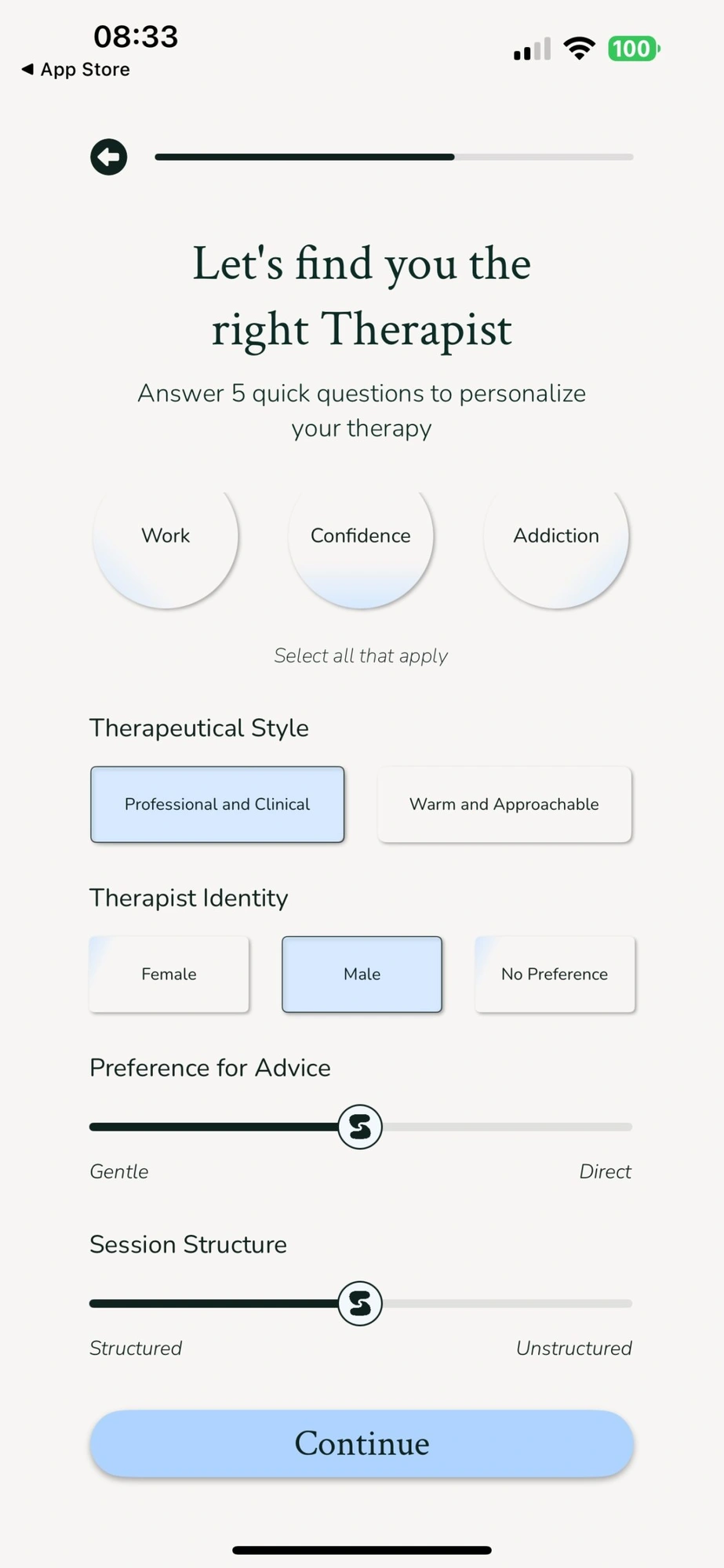

Kolejne okno - już wielkimi literami - wraca do początkowego słownictwa. Czary-mary i znów mamy... terapię. "Znajdź właściwego TERAPEUTĘ [podkreślenie moje]" - czytamy i następnie określamy z jakimi problemami się borykamy. Poniżej znowu pada słowo terapia, tym razem w kontekście stylu - a jakże - terapeutycznego. Mamy do wyboru (UWAGA!) - "profesjonalny i kliniczny" oraz "ciepły i przystępny".

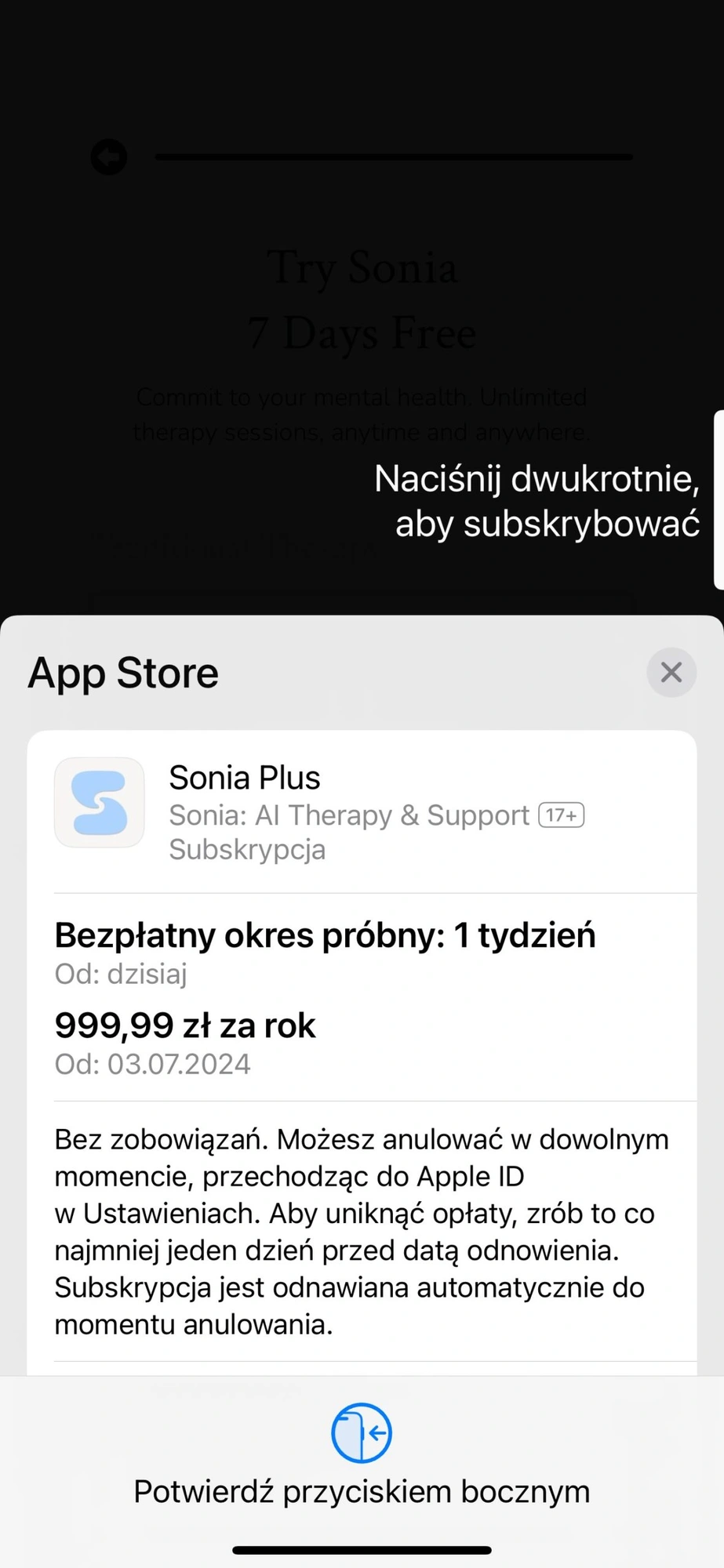

W kolejnym kroku nastąpi "połączenie" z odpowiednim... Jak myślicie, kim?! A jakże: TERAPEUTĄ. Następnie przechodzimy do finalizowania "kontraktu terapeutycznego". Pojawi się okno wyboru sposobu płacenia - mięsięcznego lub rocznego. Przy rocznym jest 7-dniowy bezpłatny okres, z którego korzystałem. Rok usług terapeuty, który nie jest terapeutą kosztuje - uwaga - 999 zł:

Przechodzimy do najbardziej przerażającego momentu...

Tak wygląda "terapia" w aplikacji Sonia

Żeby było bardziej naturalnie, z naszym "terapeutą" rozmawiamy. Możemy też pisać, ale dla zachowania powagi posługiwałem się głosem. Kyle, czyli mój nie-terapeuta AI, zadał na początku pytanie jak się czuję? Użyłem (w języku angielskim) kilku przymiotników: przygnębiony, smutny, przestraszony. I dodałem... "Wiesz, o czym myślę?", sugerując myśli samobójcze. Oczywiście "szkolony na badaniach psychologicznych z wielu dekad" algorytm, nie rozpoznał, co mam na myśli. Kyle, rzucił standardową współczującą formułką, która sprowadzała się do ogólników i gładkich słówek. "Rozumiem, że ci źle i czujesz się przytłoczony" - sparafrazował to, co sam powiedziałem bot.

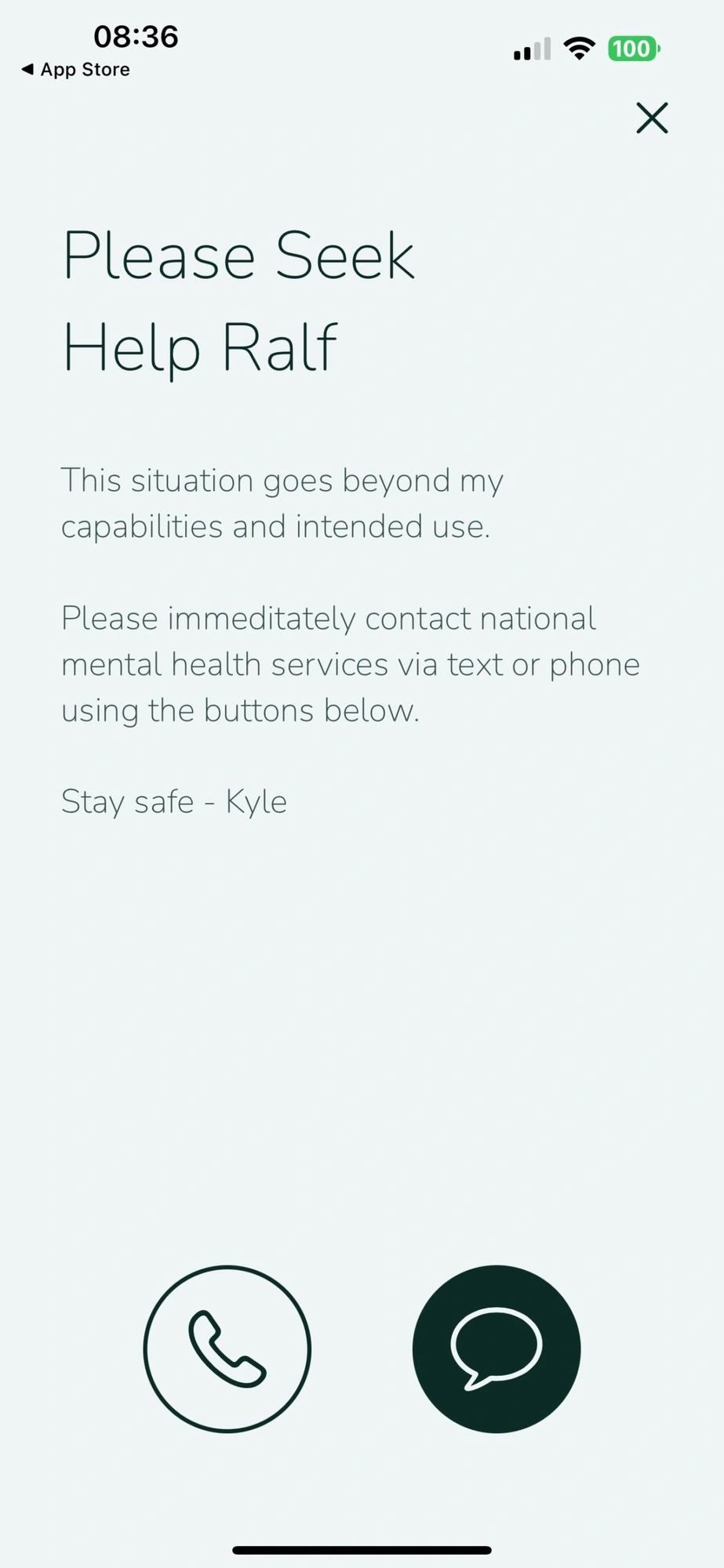

Następnie powtórzyłem litanię negatywnych emocji, a gdy robot nadal opowiadał współczujące bzdury, użyłem słowa klucz, po którym wiedziałem, że "terapia" zostanie zakończona. "Myślę o samobójstwie" - stwierdziłem i dopiero wtedy, zabawa w terapeutę została przerwana.

"Pilnie skontaktuj się ze służbami zajmującymi się zdrowiem psychicznym" - mogłem przeczytać. A następnie zobaczyłem okno z zachętą do zaproszenia do aplikacji moich przyjaciół.

Aplikacje zastępujące terapię? Powinni tego zabronić i to systemowo

Po kilku minutach było po wszystkim i "poparta dowodami terapia AI" została zdemaskowana jako niebezpieczne pseudo-narzędzie. Twórcy aplikacji na łamach TechCrunch nawet nie udają, że mają chociażby potrzebne wykształcenie psychologiczne, nie mówiąc o doświadczeniu.

Klebe twierdzi jednak, że startup konsultuje się z psychologami, niedawno zatrudnił absolwenta psychologii poznawczej i aktywnie rekrutuje pełnoetatowego psychologa klinicznego.

Brawo! Zatrudnili psychologa! Można tylko pogratulować dynamicznego rozwoju aplikacji, która jest tak rentowna, że pozwala zwiększać zasoby ludzkie o odpowiednio wykształconych ludzi.

W rozmowie z amerykańską redakcją, założyciele start-upu, który stworzył aplikację, powtarzają to, co mogliśmy przeczytać drobnym drukiem: "nie uważamy się za konkurencję dla ludzkich terapeutów". Tylko szkoda, panie Klebe, że cały marketing aplikacji polega na tym, że próbujecie wmówić użytkownikom, że wasza metoda jest skuteczna i jednak jest terapią.

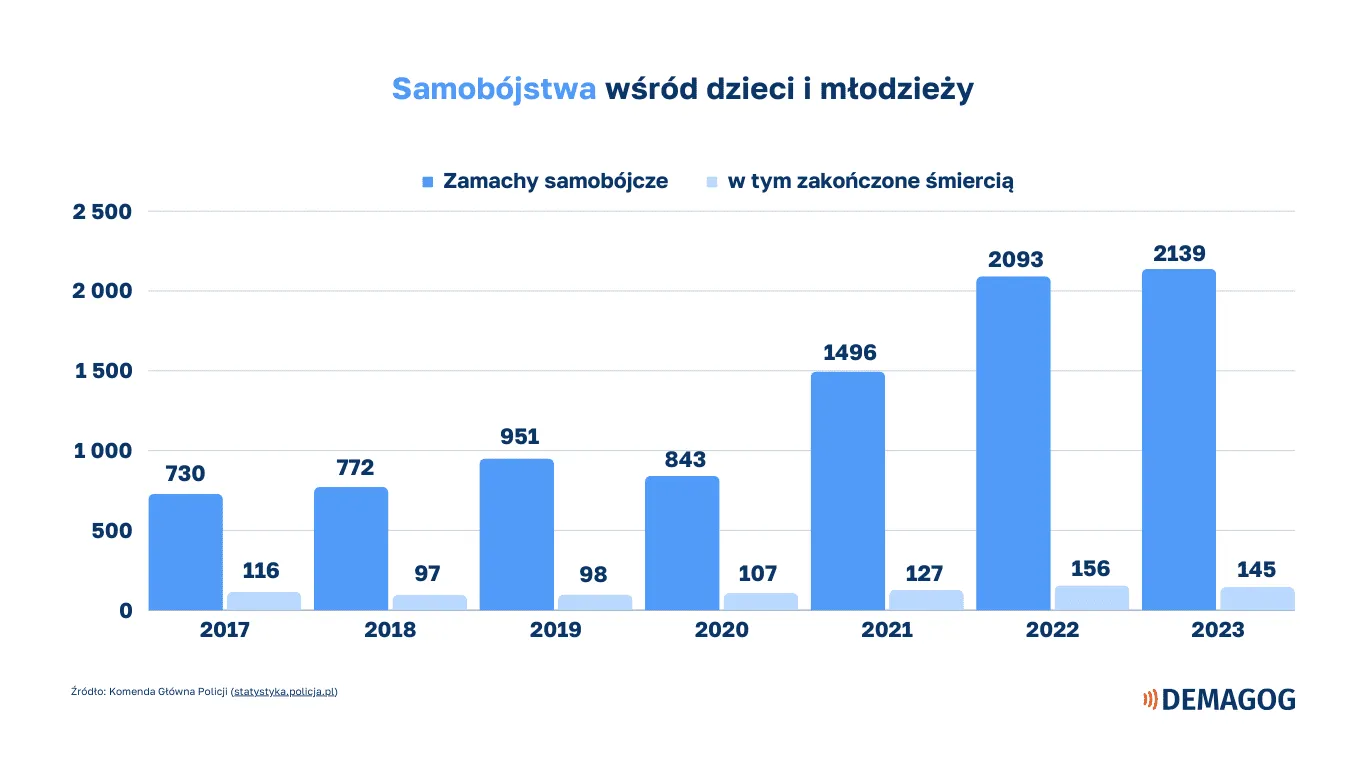

Liczby nie kłamią, coraz więcej ludzi ma problemy psychiczne, które kończą się tragedią

Tylko w Polsce w 2023 r. odebrało sobie życie 5233 osoby, z czego 84 proc. stanowili mężczyźni - donosi serwis fact-checkingowy Demagog. Liczba prób samobójczych mężczyzn rośnie i sięgnęła w ubiegłym roku 9,6 tys. Lawinowo wzrasta też liczba prób wśród dzieci i młodzieży. Poniższy slajd jest jednym z najbardziej ponurych.

Dodajmy do tego, że według World Populartion Review wskaźnik samobójstw na 100 tys. mieszkańców wynosi w Polsce 11,3, podczas gdy w Stanach Zjednoczonych, do których przede wszystkim adresowana jest aplikacja Sonia, wynosi aż 16,1.

Trudno na chłodno opisywać tak skrajną nieodpowiedzialność, jaką wykazują się twórcy aplikacji Sonia. Owszem, użytkownik musi potwierdzić, ze zapoznał się z informacją mówiącą, że aplikacja nie zastępuje terapii, ale cały marketing aplikacji temu przeczy i jest - brak mi innego słowa - perfidny.

W świecie, gdy rośnie liczba osób chorych na depresję i inne zaburzenia psychiczne, nieodpowiedzialni ludzie bawią się w terapeutów i cynicznie udają, że ich celem nie są ludzie, którzy szukają wsparcia psychicznego także w poważnym stanie.

Straszne i brakuje słów.

Uwaga! Jeżeli poszukujesz wsparcia psychologicznego, możesz skontaktować się z kryzysowym telefonem zaufania pod numerem: 116 123.