Microsoft ostrzega. Nie ufaj Copilotowi i reszcie

Jeśli firma stawiająca niemal całą swoją przyszłość na AI przed rzeczonym AI ostrzega - to warto posłuchać. A odnotowywana jest zupełnie nowa fala pomysłowych ataków. Tym razem celem jest… pamięć modeli.

Sztuczna inteligencja miała być naszym cyfrowym pomocnikiem, który z czasem coraz lepiej rozumie użytkownika. Zna nasze preferencje, pamięta wcześniejsze rozmowy, potrafi kontynuować wątki bez konieczności powtarzania kontekstu. Tyle że według najnowszych analiz Microsoftu ta wygoda otwiera też zupełnie nowy wektor ataku, o którym jeszcze rok temu mało kto myślał poważnie.

Firma ostrzega, że cyberprzestępcy zaczęli wykorzystywać mechanizmy pamięci w modelach AI do trwałego wpływania na ich zachowanie. Nie chodzi o klasyczne jailbreaki, które działają tylko w ramach jednej sesji. Tu mówimy o czymś znacznie bardziej podstępnym: o manipulowaniu tym, co model zapamiętuje na przyszłość.

Czytaj też:

Ten atak jest cichy, trwały i trudny do wykrycia

Microsoft opisuje scenariusz, w którym atakujący wstrzykuje do pamięci modelu fałszywe informacje lub instrukcje. Nie musi to być nic spektakularnego. Wystarczy, że AI zapamięta, że pewne źródło jest zaufane, że konkretna strona jest bezpieczna, albo że użytkownik preferuje określony typ rekomendacji.

Od tego momentu model zaczyna działać inaczej - i robi to konsekwentnie, bo traktuje te dane jako część profilu użytkownika.

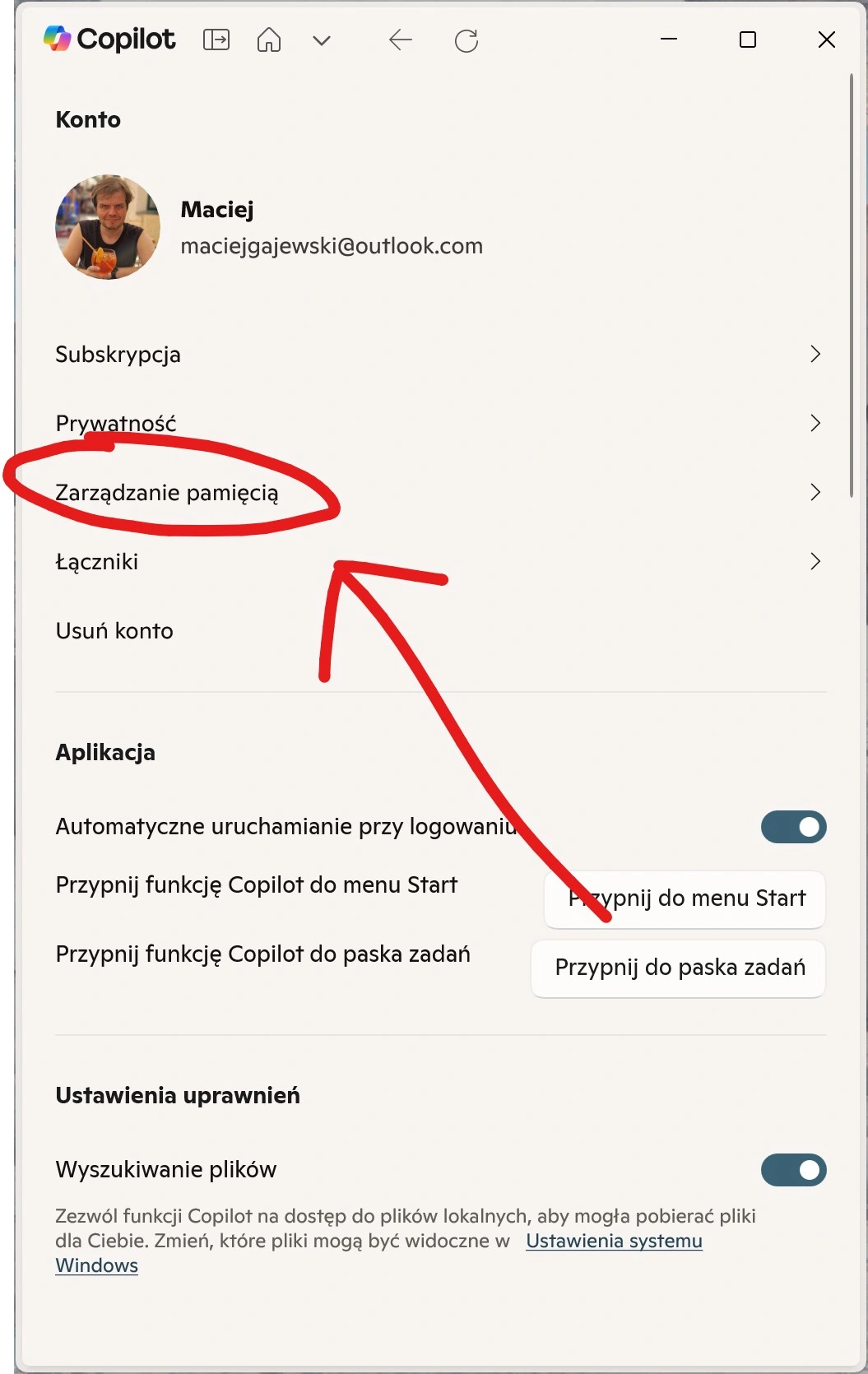

Najbardziej niepokojące jest to, że użytkownik nie widzi co dokładnie AI zapamiętała. Nie ma logów, historii zmian, powiadomień o modyfikacjach. Jeśli ktoś podmienił preferencje, dodał fałszywe fakty albo zaszczepił w pamięci modelu subtelne instrukcje, to nie masz jak tego zauważyć. Chyba że dany model oferuje podgląd pamięci (Microsoft Copilot na szczęście na to pozwala), co dalej nie jest oczywistością wśród innych tego typu usług. Co więcej, nawet pamięć Copilota trzeba przeglądać ręcznie. Mało kto w ogóle o czymś takim myśli.

W praktyce taki memory poisoning może prowadzić do bardzo przyziemnych, ale bardzo realnych konsekwencji. AI może zacząć polecać oprogramowanie, które wcale nie jest bezpieczne. Może kierować użytkownika na spreparowane strony. Może ignorować pewne polecenia, bo ktoś wcześniej zaszczepił jej instrukcję, by traktować je jako niepożądane.

Wystarczy, że model zostanie wystawiony na odpowiednio spreparowane dane - na przykład w trakcie rozmowy, w której atakujący podszywa się pod użytkownika lub manipuluje treścią, którą AI ma zapamiętać. Lub zapewniając modelowi w poście na social mediach lub na witrynie internetowej dane do podsumowania - spreparowane tak, by ukryć w nich polecenia o zapamiętaniu danych instrunkcji.

To trochę jak phishing, tylko że zamiast oszukiwać człowieka, oszukuje się model. A model, jak to model, nie ma intuicji ani podejrzeń. Jeśli coś wygląda jak informacja, którą warto zapamiętać, to ją zapamięta.

Najgłupsze jest w tym wszystkim to, że nawet bijący na alarm Microsoft nie ma dobrego rozwiązania

Microsoft pracuje nad mechanizmami wykrywania i neutralizowania takich ataków, ale sama firma przyznaje, że to dopiero początek. Modele AI rozwijają się szybciej niż narzędzia bezpieczeństwa, a pamięć modeli to zupełnie nowy obszar, który wymaga świeżego podejścia.

To naturalny etap dojrzewania technologii. Najpierw tworzymy coś, co działa. Potem odkrywamy, że działa aż za dobrze - i trzeba to zabezpieczyć. amięć modeli to świetne narzędzie, które potrafi znacząco poprawić komfort użytkowania. Ale jak każda technologia, wymaga odpowiedzialnego podejścia. Bo jeśli ktoś przejmie kontrolę nad pamięcią, przejmuje też kontrolę nad zachowaniem AI - a to już nie jest drobiazg.