Razić stare kompy prądem, czyli jak Intel wprowadził komputer osobisty pod strzechy

Dziś traktowany jest jako oczywistość. Stanowi fundament niemal każdej elektronicznej maszyny liczącej. Układ scalony to nadal względnie świeży wynalazek, a już zdołał bezpowrotnie zmienić cały świat.

Ten tekst piszę na przyzwoitej klasy urządzeniu przenośnym. Możemy je określić kilkoma mianami: PC, laptop, notebook, komputer – bez znaczenia. Bo niezależnie od nazwy, gdybym jakimś cudem przeniósł się w czasie o sto lat wstecz, widząc mojego laptopa nawet światli i wyedukowani profesorowie mogliby uciec z wrzaskiem. Przysięgając wszem i wobec, że widzieli na żywo efekty działania czarnej magii i to mimo faktu, że prawdopodobnie większość z nich słyszała o komputerze. Być może ktoś nawet z niego korzystał.

Pierwszy komputer powstał bowiem już pod koniec XIX w. Zarówno on, jak i jego następcy przez kolejne dekady, nie wykorzystywał jednak w żadnym razie prądu. Dziś urządzenia te nazywamy komputerami analogowymi, czasem komputerami mechanicznymi.

Problemem analogowych komputerów był jednak ich rozmiar i brak jakiejkolwiek elastyczności.

Potencjał komputerów był dość oczywisty i dostrzegany przez istotną część branży militarnej czy przemysłowej. Powstawały co rusz coraz to bardziej złożone i zaawansowane konstrukcje. Prawdopodobnie najbardziej zaawansowanym analogowym komputerem był analizator różnicowy, zbudowany pod koniec lat dwudziestych ubiegłego wieku na MIT. Już wtedy zaczynało być jasne, że istnieje granica dla analogowych komputerów. Związana z ich rosnącym rozmiarem i złożonością. A potrzeba miniaturyzacji całego urządzenia zaczęła być szczególnie paląca podczas drugiej wojny światowej.

Ludzkość ma tę paskudną cechę, że potrafi być szczególnie kreatywna jeśli chodzi o kreatywność w wymyślaniu urządzeń do neutralizacji wrogów. Bardzo istotnym krokiem w rozwoju komputerów było elektromechaniczne urządzenie TDC (Torpedo Data Computer) z 1938 r. – na tyle małe, że dało się ono wcisnąć na ciasny pokład łodzi podwodnej. Wykorzystywało ono prawidła trygonometrii by ułatwić celowanie torpedami w stronę ruchomego celu. Podobne urządzenia, a nawet bardziej zaawansowane od TDC, opracowali również Niemcy. Stworzony w 1941 r. przez Konrada Zuse’a komputer Z3 był pierwszym w pełni automatycznym i programowalnym cyfrowym komputerem elektromechanicznym.

Z3 w zasadzie można uznać za pierwszy komputer według definicji kompletności Turinga. Programy na Z3 pisało się na kartach drukowanych. Pamięć Z3 mogła przechować 64 polecenia, które były przetwarzane z częstotliwością zegara na poziomie około 7 MHz. Obsługiwał liczby zmiennoprzecinkowe, a przede wszystkim operował na binarnym systemie liczbowym – dzięki czemu był mniej złożony, a co za tym idzie, mniej podatny na awarie i łatwiejszy w utrzymaniu.

Razić stare kompy prądem.

Inżynierowie zajmujący się rozwojem komputerów dość szybko zrozumieli, że powinny być to przede wszystkim urządzenia elektroniczne. Zainspirowani ciekawym eksperymentem brytyjskiej poczty związanym ze stworzeniem elektronicznej centrali telefonicznej John Vincent Atanasoff i Clifford E. Berry z uniwersytetu w Iowa stworzyli w 1942 r. pierwszy w pełni elektroniczny komputer. Nazwali go ABC od swoich nazwisk (Atanasoff-Berry Computer) i chwalili się, że ich konstrukcja wykorzystuje 300 lamp próżniowych. W tych okropnych dla świata czasach wykorzystano ich wynalazek do celów – a jakże – wojskowych.

Potrzebny był sposób na złamanie niemieckich szyfrowanych komunikatów wojskowych, wysyłanych przez maszynę Lorenz SZ 40/42. Tak powstał Colossus, pierwszy w pełni elektroniczny programowalny komputer cyfrowy, zbudowany przez Maxa Newmana i jego zespół. Już na początku 1944 r. udało się za jego pomocą złamać pierwszy niemiecki komunikat. Colossus wykorzystywał setki lamp próżniowych i wykorzystywał prawidła algebry Boole’a do odcyfrowywania niemieckich szyfrów. Choć z uwagi na dość specjalistyczne zastosowanie, nie spełniał on kryteriów kompletności Turinga.

Udało się za to tego dokonać ENIAC-owi (Electronic Numerical Integrator and Computer), który powstał w Stanach Zjednoczonych. Ten komputer potrafił wykonywać 5 tys. prostych operacji matematycznych na sekundę, ustanawiając światowy rekord. Potrafił dodawać, odejmować, mnożyć, dzielić i pierwiastkować. Jego pamięć mieściła zawrotne 80 bajtów.

ENIAC był potężny jak na swoje czasy. Niestety, był też… powiedzmy, mało poręczny. Sprzęt ważył 30 ton, zużywał 200 kilowatów energii elektrycznej i składał się na 18 tys. lamp próżniowych. Niektórzy uważali, że to szczyt możliwości komputerów i że kolejne po ENIAC-u komputery nie będą już oferować znaczących nad nim korzyści. No bo jak to osiągnąć? Budując komputer wielkości małego miasta?

Jak to zawsze bywa, w końcu pojawił się ktoś, komu nikt nie powiedział, że zbudowanie lepszego komputera nie jest już możliwe.

Komputery od ślepego zaułka ewolucji uratowały dwa wynalazki. Pierwszym z nich był tranzystor, opracowany jeszcze w 1925 r. Choć tak na dobrą sprawę, to uwagę inżynierów projektujących komputery w szczególności przyciągnął tranzystor bipolarny, opracowany w 1948 r. Nadawał się on doskonale do zastąpienia ogromnych i kruchych lamp próżniowych. Był nie tylko nieporównywalnie mniejszy, ale i zużywał mniej prądu (i emitował w związku z tym mniej ciepła) a na dodatek był nieporównywalnie trwalszy i mniej podatny na zużycie.

Okazało się, że komputery mogą być znacznie mniejsze nie tracąc zarazem nic ze swojej mocy. Pierwszy w pełni oparty o tranzystory komputer powstał w 1955 r. – był to angielski Harwell CADET. Tranzystory stały się prawdziwą kopalnią złota dla każdej większej firmy zajmującej się elektroniką. W 1959 r. Bell Labs opracowało tranzystor MOS (MOSFET), który był relatywnie tani i nadający się do masowej produkcji. To był jeden z dwóch fundamentów wielkiej komputerowej rewolucji, która trwa po dziś dzień.

Drugim był układ scalony.

Koncepcja układu scalonego powstała w głowie Geoffrey’a Dummera. Ten jednak przedstawił tylko teorię. Praktyką zajęły się równolegle firmy Texas Instruments i Fairchild Semiconductor. Układ scalony, czyli zatopiony w monokrysztale półprzewodnikowym kompletny obwód elektroniczny, to kolejny niezmiernie istotny krok w stronę miniaturyzacji komputerów. Jego właściwą formę opracowała druga z firm. Układy TI były znacznie trudniejsze w masowej produkcji.

Wynalazek ten otworzył drogę do opracowania architektury maszyny liczącej, która w zasadzie wykorzystywana jest po dziś dzień. Sercem komputera miał być (na tyle na ile to możliwe i sensowne) złożony układ scalony, jakim miał być mikroprocesor.

Mówisz mikroprocesor, myślisz Intel.

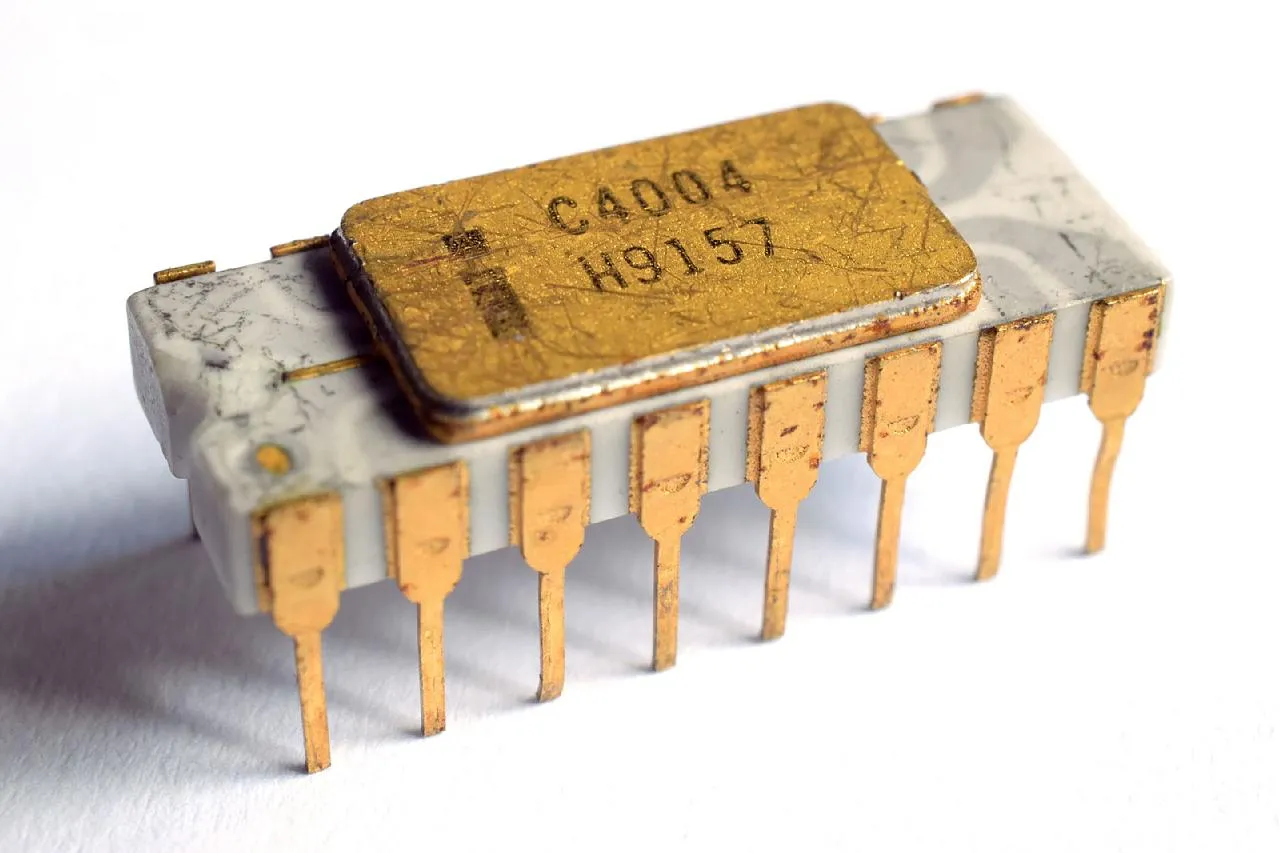

Co zabawne, różne źródła na różny sposób definiują pojęcie mikroprocesora. To oznacza, że trudno definitywnie i autorytatywnie wskazać pierwszy masowo produkowany i zawarty w pojedynczym układzie scalonym mikroprocesor. Większość jednak przychyla się do wskazania układu 4004 niejakiej firmy Intel.

Sam Intel zaczynał jako relatywnie skromny producent komputerowej pamięci półprzewodnikowej. Radził sobie w tym bardzo dobrze, oferując układy SRAM, DRAM i ROM zauważalnie szybsze od konkurencji. Amerykańska firma była wschodzącą gwiazdą na rynku rozwiązań dla dużych firm i korporacji. Jednak to wspomniany Intel 4004 z 1971 r. zdefiniował całą przyszłość firmy. To prawdopodobnie ten mikroprocesor sprawił, że Intel po dziś dzień jest jedną z wiodących sił w całej branży informatycznej.

Za sprawą mikroprocesora 4004 możliwe było tworzenie małego komputera, który był zdolny do wykonywania równie złożonych obliczeń, co zajmujące całe pomieszczenia firmowe komputery. To właśnie 4004 rozpoczął triumfalne wejście mikrokomputerów na rynek, które z czasem zaczęto określać jako komputery osobiste (Personal Computer – PC). Rosnąca w Japonii bardzo ostra konkurencja w branży pamięci DRAM spowodowała, że Intel bez większego żalu zredukował działalność na nim do relatywnego minimum. Kolejne edycje mikroprocesorów Intel sprawiały, że firma nie musiała martwić się o przyszłość – bo przecież ją kreowała.

W konsekwencji w 1974 r. powstał pierwszy 8-bitowy procesor – Intel 8080 – a później 16-bitowy 8086, który do teraz jest w zasadzie fundamentem świata komputerów osobistych. To właśnie w tym układzie po raz pierwszy zastosowano architekturę x86, stosowaną i rozwijaną po dziś dzień. Pierwszym 16-bitowym procesorem Intel był 286, pierwszym 32-bitowym układ 386.

Nie jedna, nie dwie, nie trzy. Intel zaskakiwał rynek kolejnymi rewolucjami.

Choć Intel 4004 był zwiastunem prawdziwej rewolucji na rynku komputerów, to paradoksalnie nigdy nie zapewnił firmie Intel dużych wpływów finansowych. To samo tyczyło się jego następców, a więc układów 8008 i 8080. Intel wiedział jednak, jak istotny wynalazek ma w swojej ofercie. Inwestował istotne kwoty w lobbowanie swojego wynalazku. Przełom nastąpił w 1981 r.

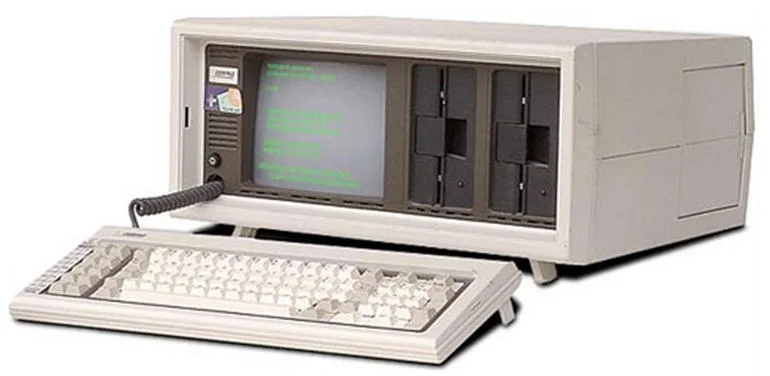

To właśnie wtedy IBM zaprezentował pierwszy komputer IBM PC, a więc uniwersalny standard komputera osobistego, wykorzystywany po dziś dzień. Sercem IBM PC miał być układ firmy Intel. Rok później na rynku pojawił się IBM PC/AT z układem 286 na pokładzie. Nie było wtedy już żadnej wątpliwości: to Intel został wybrany przez rynek informatyczny jako firma o największym potencjale.

Co zabawne, IBM PC z uwagi na swoją otwartą architekturę okazał się być ogromnym problemem dla jego producenta. Szybko zaczęły pojawiać się jego klony od innych producentów. Jednak również i ci wybierali układy 286. Intel jednak nie zamierzał spoczywać na laurach, wprowadzając w połowie lat osiemdziesiątych pierwszy 32-bitowy procesor dla klienta masowego: układ 386.

Na początku lat 90. nadeszła kolejna rewolucja, jaką był układ Intel 486. Dysponował on względem poprzednika zintegrowaną pamięcią podręczną pierwszego poziomu czy dedykowaną jednostką do przeliczeń zmiennoprzecinkowych. Architektura x86 stosowana w tych układach była już dojrzała, więc Intel skupił się na jej doskonaleniu.

Tak powstała linia procesorów Pentium, która wbrew nazwie sugerującej jakieś istotne zmiany, była w zasadzie zwiększaniem możliwości obliczeniowych istniejących już konstrukcji. To jednak nie oznacza, że nie była istotna. Pentium otworzył drogę do sensownej pracy w grafice 3D – nie bez powodu przełomowa gra wideo Quake wymagała właśnie Pentiuma, by móc poprawnie działać. Warto przypomnieć, że to były czasy przed dedykowanymi układami graficznymi do grafiki 3D. Intel trafnie też rozpoznał multimedialną rewolucję w komputerach: Pentium MMX zyskał dodatkowe instrukcje, dzięki którym przeliczenia z nimi związane były wykonywane zauważalnie szybciej.

Pentium II i Pentium III były bardziej ewolucyjnymi niż rewolucyjnymi produktami. To nie oznacza, że nie były istotne dla rynku. Przecież samo ciągłe zwiększanie mocy obliczeniowej pozwalało użytkownikom komputerów na realizacje zadań wcześniej niemożliwych. Jednak dopiero Pentium 4 zapewnił kolejną rewolucję w procesorach Intel.

Pentium 4 prowadził bowiem pecety w 64-bitowy świat. Po raz pierwszy nie był w tym głównym innowatorem: ubiegła go konkurencja spod znaki firmy AMD. Jednak to właśnie pełne zaangażowanie rynkowego lidera w 64-bitowe (a więc znacznie wydajniejsze) przetwarzanie danych utwierdziło programistów w przekonaniu, że czas na przeprowadzkę. Oprócz tego Intel wprowadził na rynek pierwsze swoje procesory dla mniej zamożnych klientów, zapewniając jeszcze większą powszechność komputerów osobistych pod strzechami. Układy Intel Celeron, choć zauważalnie wolniejszy od Pentiumów, zapewnił setkom tysięcy rodzin dostęp do cyfrowej rewolucji.

Pozostała jeszcze jedna rzecz do zrobienia. W zastosowaniach profesjonalnych od długiego czasu stosowane było równoległe przetwarzanie danych. Serwerownie czy stacje robocze z procesorami Intel lub konkurencji dysponowały już więcej niż jednym mikroprocesorem. Lub procesorem mieszczącym w sobie kilka rdzeni obliczeniowych. Dzięki temu procesory w jednym takcie zegara były w stanie przetworzyć dwu-, cztero- czy ośmiokrotnie więcej danych. Nadszedł czas na przeniesienie tej rewolucji do komputerów osobistych.

Tak powstała rozwijana po dziś dzień linia układów Core. Początkowo oznaczana jako Core 2 Duo czy Core 2 Quad – by uwypuklić w czytelny sposób liczbę rdzeni w danym układzie – z czasem rebrandowana na stosowane do dziś oznaczenia Core ix, gdzie ów x zastępowany jest przez cyfrę symbolizującą moc obliczeniową danego układu w kontekście wszystkich konsumenckich procesorów firmy Intel.

Wydajność to nie wszystko. Liczą się algorytmy.

Warto zauważyć, że Intel dawno już poszerzył swoje techniczne kompetencje. Firma jest jednym z liderów jeśli chodzi o badania nad sieciami 5G, Internetem rzeczy, a przede wszystkim nad sztuczną inteligencją i uczeniem maszynowym – efekty tych badań możemy już teraz obserwować w niektórych, tych bardziej zaawansowanych i już dostępnych na rynku, sprzętowych i programowych rozwiązaniach. Chociażby w procesorach Core 10. generacji z dedykowanym modułem do przetwarzania opartych na SI algorytmów.

Ważne z tej całej historii jest jednak zaobserwowanie trzech najistotniejszych przełomów w branży informatycznej. Tranzystora MOFSET od Bell Labs, układu scalonego opracowanego przez Fairchild Semiconductor i mikroprocesora Intel 4004. To trzy fundamenty techniczne, dzięki którym używanie komputera wygląda tak:

Zamiast wyglądać tak:

A przecież za czasów ENIAC-a uważano, że inaczej przecież się nie da...

*Materiał powstał we współpracy z marką Intel.