To tutaj trzymają wszystkie twoje lajki. Byliśmy w polarnym centrum danych Facebooka - relacja Spider's Web

Arktyczny klimat północnej Szwecji stwarza idealna warunki dla serwerów. To właśnie przez nie przepływają facebookowe statusy, zdjęcia i filmy.

Kiedy planowałem przyjazd do centrum Facebook myślałem że wokoło Lulei będą się kilometrami ciągnęły lasy i jeziora, drogę co chwila będą przebiegały renifery, a ludzi będzie tyle co kot napłakał.

W rzeczywistości trafiłem do 76-tysięcznego miasta – stolicy regionu, która na całą Szwecję świeci przykładem transformacji od przemysłu do IT. Kiedyś składano tu SAAB-y, a dziś powstają startupy, które przejmują światowi giganci.

Dla powodzenia centrum danych kluczowe jest odpowiednie chłodzenie, a tego blisko koła podbiegunowego nie brakuje. Z Lulei można do niego dotrzeć samochodem w godzinę.

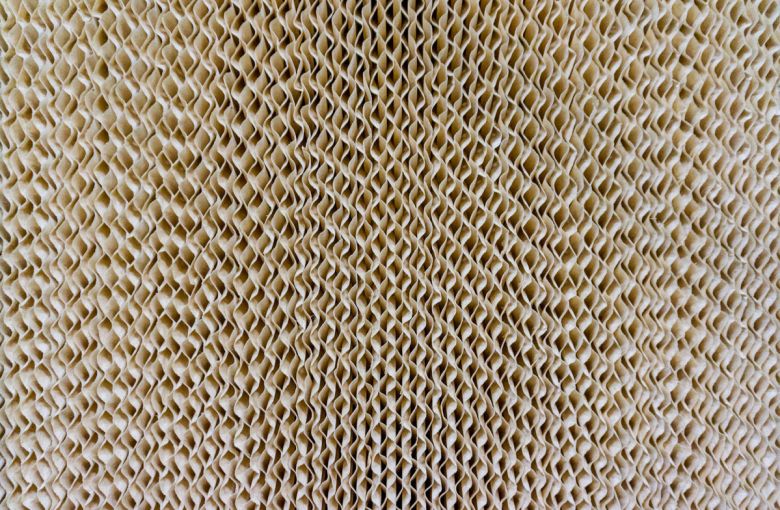

W zimie powietrze może mieć temperaturę nawet minus 40 stopni Celsjusza, więc trzeba je wymieszać z tym cieplejszym – odprowadzonym od serwerów. Służy temu właśnie to pomieszczenie.

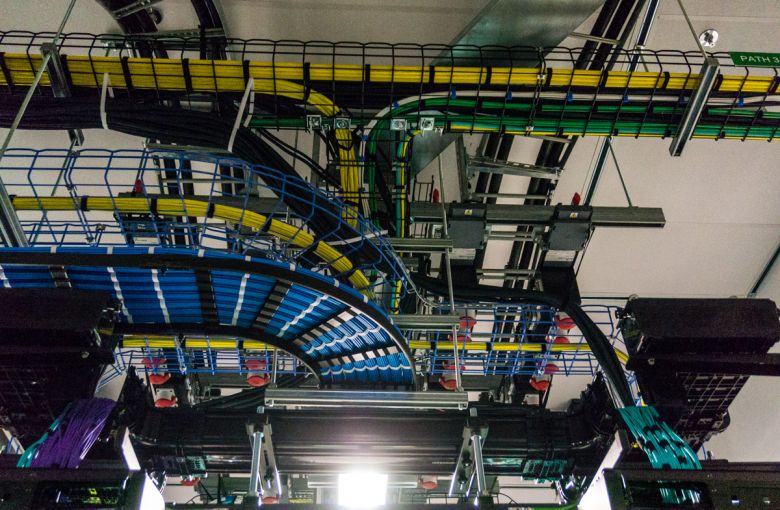

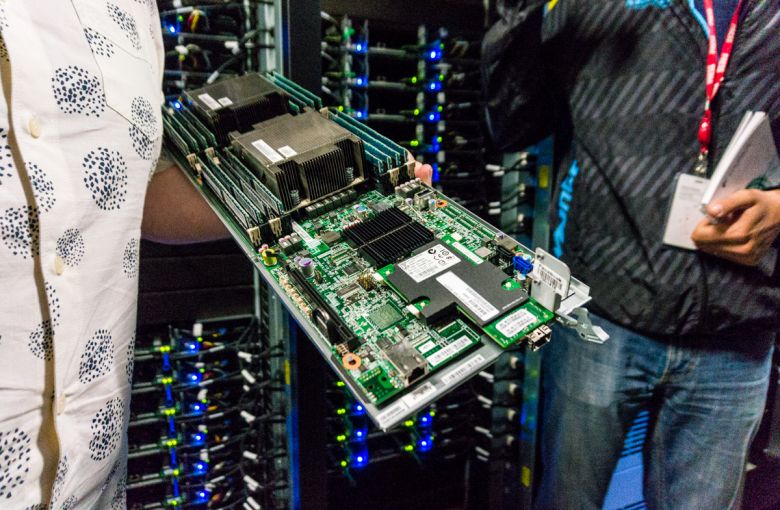

Wróćmy do tego, co w Lulei najważniejsze, do komputerów. Wszystkie serwery, urządzenia do przechowywania danych oraz obsługujące je oprogramowanie są zaprojektowane według standardów Open Compute Project.

„Open” oznacza, że Facebook dzieli się swoimi osiągnięciami w budowie energooszczędnych centrów danych z każdym konkurentem.

A ma czym! Wykorzystanie odnawialnej energii, chłodzenia przy użyciu zewnętrznego powietrza oraz najbardziej zaawansowanych rozwiązań technologicznych sprawia, że wskaźnik efektywności wykorzystania energii (PUE) dla centrum danych Lulea plasuje się w zakresie 1,05 – 1,09. Oznacza to, że niemal każdy watt mocy wykorzystywany w centrum służy do zasilania serwerów i komputerów.

Część danych wciąż przechowywana jest na wirujących dyskach, są to np. starsze filmy, do których dostęp nie musi następować natychmiastowo. Szufladę z nimi można wyciągnąć bez wyłączania dysków, choć po prawdzie nie wszystkie one pracują. System włącza tylko te, z których trzeba coś odczytać.

Taka „tacka” zawiera 2 PB danych.

Centrum jest w 100 proc. zasilane „zieloną energią” z elektrowni wodnej na pobliskiej rzece Lule. Co ciekawe, Facebook bardzo mocno dba o to, aby jego serwerownie jak najmniej wpływały na środowisko.

W 2015 roku firma postawiła sobie za cel cel, aby w ciągu 3 lat zaspokajać energią odnawialną ponad 50 proc. swojego zapotrzebowania, a docelowo korzystać w 100 proc. z czystej energii w możliwie jak najkrótszym czasie.

Zwiedzanie centrum danych kończymy w stołówce dla pracowników, którym każdego dnia serwowane są 3 posiłki, aby mogli się całkowicie skoncentrować na pracy. Przy jednym ze stolików spotykam Polaka, który zajmuje się utrzymaniem serwerów. Kiedy pytam go jak najkrócej określiłby rolę centrum w sieci Facebooka odpowiada mi:

Tu internet staje się prawdziwy.